OpenAI ha annunciato di recente diversi aggiornamenti, tra cui il rilascio del modello GPT-5-Codex-Mini, miglioramenti al limite di velocità per le gerarchie multiutente e ottimizzazioni all'efficienza di elaborazione del modello.

OpenAI di GPT-5-Codex-Mini è una variante di GPT-5-Codex recentemente annunciata e focalizzata sugli sviluppatori: un modello più piccolo, ottimizzato in termini di costi e produttività, progettato per fornire la maggior parte dell'assistenza alla codifica di GPT-5-Codex, ma a costi molto inferiori e con un volume di utilizzo maggiore. La variante "Mini" si posiziona come una scelta pragmatica per lunghe sessioni di codifica, automazione in background e flussi di lavoro di sviluppo ad alta frequenza, in cui la capacità di picco grezza è meno importante rispetto all'ottenimento di più token/richieste per lo stesso piano.

Che cos'è GPT-5-Codex-Mini e quali sono le sue funzionalità?

GPT-5-Codex-Mini è una variante compatta ed economica della famiglia GPT-5-Codex di OpenAI, specificamente progettata per le superfici del prodotto Codex (integrazione con CLI e IDE). Si posiziona come un modello "più piccolo ed economico" che sacrifica una piccola quantità di capacità di picco per un consumo di risorse significativamente inferiore e una quota utilizzabile maggiore per i flussi di lavoro interattivi degli sviluppatori. Il modello mini è progettato per consentire agli sviluppatori di eseguire molti più turni di codifica (OpenAI descrive approssimativamente Utilizzo 4 volte maggiore per lo stesso livello di abbonamento ChatGPT) mantenendo bassi latenza e costi per attività di ingegneria comuni e ben definite.

In termini di funzionalità, GPT-5-Codex-Mini eredita le caratteristiche principali della linea di prodotti Codex: una profonda comprensione della base di codice e l'esecuzione di attività multi-step in modalità "agente". Grazie alle funzionalità della CLI di Codex, gli sviluppatori possono inviare comandi in linguaggio naturale, frammenti di codice, screenshot o diagrammi di progettazione dell'interfaccia a Codex tramite un terminale interattivo. Il modello fornirà innanzitutto un piano, quindi esplorerà automaticamente i file, modificherà il codice, eseguirà comandi e test dopo aver ottenuto l'approvazione dell'utente.

Da una prospettiva modale, i prodotti Codex consentono di allegare immagini (come screenshot dell'interfaccia utente, bozze di progettazione o screenshot di messaggi di errore) alla sessione nel terminale o nell'IDE. Il modello può comprendere sia contenuti testuali che immagini, ma l'output è comunque costituito principalmente da codice testuale e spiegazioni. Pertanto, GPT-5-Codex-Mini può essere considerato un modello proxy di codice che è principalmente "input testo + immagine, output testo" e non esegue attività come la generazione di immagini, audio o video.

In che modo GPT-5-Codex-Mini si confronta con GPT-5-Codex?

Cosa c'è di nuovo nel Codex?

Oltre alla versione GPT-5-Codex-Mini, OpenAI ha aumentato uniformemente del 50% il limite di velocità del Codex per i livelli utente ChatGPT Plus, Business ed Edu, incrementando significativamente il limite di richieste disponibili. Nel frattempo, gli utenti ChatGPT Pro otterranno autorizzazioni di elaborazione prioritarie per migliorare la velocità di risposta e l'esperienza di esecuzione delle attività.

Inoltre, OpenAI ha apportato un piccolo aggiornamento al modello GPT-5-Codex, ottimizzandone le prestazioni in scenari collaborativi. Il modello aggiornato mostra miglioramenti di diversi punti percentuali nelle metriche di valutazione chiave, un aumento di circa il 3% nell'efficienza di utilizzo dei token e una maggiore robustezza nella gestione dei casi limite, riducendo così la necessità di assistenza da parte dell'utente.

| livello utente | Codice GPT-5 | GPT-5-Codex-Mini |

|---|---|---|

| Plus/Biz/Edu | aumenta il volume dei messaggi rispettivamente di 1.5 volte. | aumenta il volume dei messaggi rispettivamente di 6 volte. |

GPT-5-Codex-Mini vs GPT-5-Codex: differenze nei benchmark

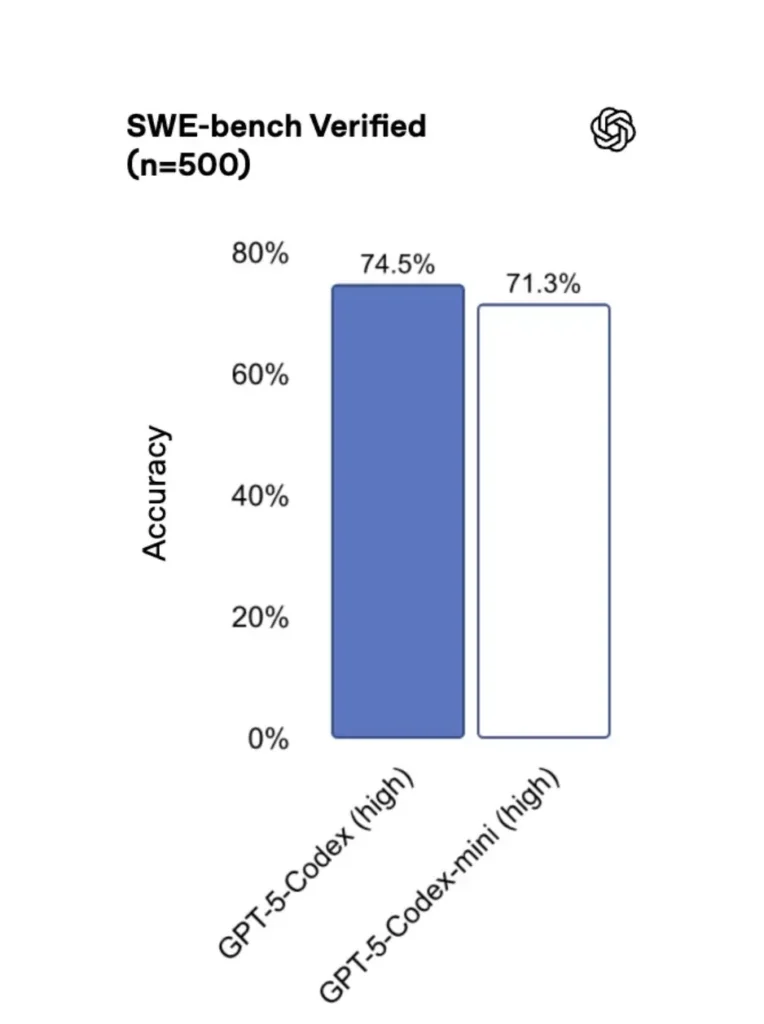

Rispetto alla versione originale, GPT-5-Codex-Mini presenta prestazioni leggermente ridotte, ma gli sviluppatori ricevono circa quattro volte il credito d'uso. Nel test SWE-bench Verified, GPT-5 High ha ottenuto un punteggio del 72.8%, GPT-5-Codex del 74.5% e GPT-5-Codex-Mini del 71.3%.

Il Codex (e la sua mini variante) utilizza un numero notevolmente inferiore di token per interazioni leggere: i materiali di OpenAI dichiarano riduzioni nell'ordine di decine di punti percentuali per semplici prompt (ad esempio, una cifra citata di ≈93.7% di token in meno sulle interazioni leggere per la famiglia Codex rispetto a GPT-5 in alcuni scenari).

GPT-5-Codex-Mini vs GPT-5-Codex: differenze nelle funzionalità

- Dimensioni e costo: Mini è esplicitamente più piccolo e più conveniente; OpenAI lo descrive come un modello che consente un utilizzo circa 4 volte superiore a parità di abbonamento. Si tratta di un'ottimizzazione di quote/efficienza per le attività di routine degli sviluppatori.

- Capacità di elaborazione: GPT-5-Codex rimane l'opzione più performante per attività agentiche lunghe e complesse (grandi refactoring, revisioni approfondite del codice, cicli di test estesi). Mini è ottimizzato per essere più reattivo e meno dispendioso in termini di risorse per interazioni frequenti e brevi.

- Limiti di latenza e velocità: Mini in genere offre una latenza inferiore e consente limiti di velocità più elevati per piano, rendendolo adatto a flussi di lavoro densi e interattivi.

- Superfici predefinite: Mini è disponibile come modello selezionabile in Codex CLI e nell'estensione IDE; GPT-5-Codex è l'impostazione predefinita per le attività cloud e i flussi di revisione approfondita del codice in Codex.

Quando usare Mini vs. Full Codex

- Usa il Mini per: impalcature, generazione di codice ripetitivo, piccoli refactoring, completamenti interattivi durante la modifica e quando si lavora con vincoli di quota o di costo.

- Usa il Codice GPT-5 per: revisioni complete del codice, attività autonome di più ore, refactoring complessi e attività che richiedono il ragionamento più solido del modello e l'esecuzione basata sui test.

Come posso accedere a GPT-5-Codex-Mini (CLI, IDE, API)?

Codex CLI (terminale-prima)

Presentato OpenAI gpt-5-codex-mini come opzione modello all'interno della Codex CLI. I modelli di utilizzo tipici seguono il flusso di lavoro della Codex CLI: avviare una sessione interattiva, specificare il modello, allegare file o screenshot, eseguire "attività Codex Cloud" e altro ancora. La CLI supporta anche l'esecuzione rapida /model passaggio tra pieno gpt-5-codex e al gpt-5-codex-miniAl primo avvio, sarà necessario autenticarsi utilizzando il proprio account ChatGPT/Pro/Enterprise (o fornire una chiave API). La CLI fornisce vari comandi che consentono a Codex di analizzare le basi di codice, eseguire test, aprire REPL o applicare raccomandazioni sulle patch.

Esempio (sessione interattiva Codex CLI):

# Install Codex CLI (npm)

npm i -g @openai/codex

# or Homebrew on macOS

brew install --cask codex

# Launch in a repo

cd myproject

# Open a codex interactive session

codex

# In the session you can switch the model:

# (this is typed in the Codex TUI)

> /model gpt-5-codex-mini

# Ask Codex to generate a unit test

> Write pytest tests for function `calculate_discount` in discounts.py

Questo flusso rispecchia le nuove impostazioni predefinite della CLI del Codex, in cui lo strumento suggerirà Mini in prossimità dei limiti di utilizzo.

Estensione VS Code / IDE

Sì, l'estensione Codex IDE (VS Code) include già gpt-5-codex-mini Come opzione, installa l'estensione Codex in Visual Studio Code per ottenere il completamento del codice in linea, suggerimenti di refactoring e soluzioni rapide basate sull'intelligenza artificiale. L'estensione espone anche azioni rapide (genera codice, spiega il codice selezionato, refactoring) e può eseguire attività di Codex Cloud dall'editor, passaggi di VS Code:

- Installa l'estensione OpenAI Codex / ChatGPT per VS Code.

- Accedi con il tuo account ChatGPT (Plus/Pro/Business).

- Aprire la tavolozza dei comandi:

Cmd/Ctrl+Shift+P → Codex: Set Model→ scegligpt-5-codex-mini. - Utilizzare i comandi in linea (selezionare il codice → fare clic con il tasto destro → "Spiega con Codex" o premere il tasto di scelta rapida configurato).

Esempio: comando in linea di VS Code (pseudo passaggi)

- Seleziona una funzione in

user_service.py. - Stampa

Cmd/Ctrl+Shift+P → Codex: Explain Selectionoppure usa il tasto destro del mouse → “Spiega con il Codex”. - L'estensione apre un pannello laterale con la spiegazione di Mini, i test suggeriti e un pulsante "Crea PR" con un clic che utilizza le attività di Codex Cloud per inviare un ramo per la revisione.

E per quanto riguarda l'API? Posso richiamarla dalla mia app?

Gli annunci di OpenAI indicano Il supporto API sarà disponibile a breve per GPT-5-Codex-Mini; al momento della stesura, il modello è disponibile prima nella toolchain del Codex (CLI/IDE). Ciò significa che i client API di produzione devono prepararsi per il nome del modello. gpt-5-codex-mini nell'API Richieste/Risposte una volta pubblicata. Nel frattempo, puoi creare prototipi con i flussi Codex CLI e IDE.

Quando l'accesso API è abilitato, una chiamata tipica (in stile Risposte) potrebbe apparire così:

# illustrative — check OpenAI docs for final param names

from openai import OpenAI

client = OpenAI(api_key="sk-...")

resp = client.responses.create(

model="gpt-5-codex-mini",

input="Write a Python function that validates an email address and includes unit tests.",

max_tokens=512,

temperature=0.2

)

print(resp.output_text)

Quali sono le migliori pratiche per un'ingegneria rapida con Codex Mini?

Di seguito sono riportate le migliori pratiche e i modelli concreti e testati sul campo per ottenere il massimo valore da Codex Mini nei flussi di lavoro di ingegneria di produzione.

1) Strategia di selezione del modello: mix and match

Utilizza Mini per attività ad alta frequenza e bassa complessità (formattazione, piccoli refactoring, test automatici) e ripiega su Codex completo per progetti complessi, debug approfonditi o grandi trasformazioni a livello di repository. Automatizza il passaggio: la CLI di Codex suggerisce già Mini al 90% di utilizzo e puoi creare script. /model modificando gli strumenti per scegliere un modello in base alla complessità dell'attività.

2) Modelli di ingegneria rapidi

Crea modelli di prompt piccoli e deterministici per attività ripetibili: generazione di test, bozze di changelog, generazione di messaggi di commit e descrizioni di PR. Salvali come snippet riutilizzabili nel tuo repository o come preset di prompt del Codex.

Esempio di modello di prompt per test unitari:

# Template: generate_pytests

System: You are a precise Python developer. Produce pytest tests.

User: Given the function below, produce parametrized pytest functions that cover typical edge cases.

--- file: discounts.py

<insert function>

---

Return only valid Python test code with imports and fixtures.

3) Automatizzare le reti di sicurezza: approvazioni e CI gating

Non consentire mai a un modello di inviare codice direttamente senza l'approvazione umana. Utilizza le modalità di approvazione di Codex e le attività di Codex Cloud per creare differenze e richiedere l'approvazione umana in CI. La CLI di Codex supporta le "modalità di approvazione", quindi le modifiche devono essere approvate prima di essere applicate.

4) Memorizzare nella cache e deduplicare le chiamate al modello

Per richieste ripetitive (ad esempio, la spiegazione di una funzione), memorizza nella cache la risposta con la chiave prompt + hash del file. Questo riduce le chiamate ridondanti e mantiene prevedibile il profilo dei costi.

5) Utilizzare streaming + differenze incrementali

Se possibile, richiedi output in streaming e diff incrementali anziché riscritture dell'intero file. Questo riduce l'utilizzo di token e aiuta i revisori a individuare le modifiche mirate.

6) Flusso del generatore di test unitario prima

Genera test ed eseguili localmente in un ambiente effimero. Se i test falliscono, itera con il modello che fornisce le correzioni per i test falliti. Inquadra ogni iterazione come un prompt discreto con gli output dei test inclusi.

Esempio di frammento di automazione Codex CLI (bash):

# Generate tests

codex --model gpt-5-codex-mini request "Generate pytest tests for discounts.py" > generated_tests.py

# Run tests locally

pytest generated_tests.py -q || {

echo "Tests failed. Opening Codex for debugging..."

codex --model gpt-5-codex-mini request "Tests failed. Here's pytest output: $(tail -n 50 pytest_output.txt). Propose a fix for discounts.py."

}

Conclusione

GPT-5-Codex-Mini è una mossa pragmatica: riconosce che i flussi di lavoro degli sviluppatori sono spesso dominati da numerose interazioni brevi, in cui latenza, costi e flusso ininterrotto sono fattori determinanti. Offrendo un mini livello pensato per l'utilizzo con IDE e CLI, OpenAI offre ai team la possibilità di scalare l'assistenza quotidiana alla codifica senza ricorrere immediatamente al modello più costoso per ogni interazione.

Gli sviluppatori possono accedere API GPT-5-Codex ,API GPT-5 Pro Tramite CometAPI, gli ultimi modelli di cometAPI elencati sono aggiornati alla data di pubblicazione dell'articolo. Prima di accedere, assicurati di aver effettuato l'accesso a CometAPI e di aver ottenuto la chiave API.CometaAPI offrire un prezzo molto più basso rispetto al prezzo ufficiale per aiutarti a integrarti.

Pronti a partire? → Iscriviti oggi a CometAPI !

Se vuoi conoscere altri suggerimenti, guide e novità sull'IA seguici su VK, X e al Discordia!