Le novità su Gemini 3.0 sono state l'argomento più discusso tra gli sviluppatori da agosto, con continui resoconti giornalistici che ne annunciavano con sicurezza la data di uscita, per poi scoprire che non è mai stata annunciata. Le speranze sono state deluse più volte, ma l'attesa rimane alta, perché le prestazioni di Gemini 2.5 Pro sono già inferiori a quelle dei suoi concorrenti, Chatgpt e Claude. Ora vi porterò le ultime notizie di prima mano e sono felice di annunciare che è ora disponibile su CometaAPI.

La nuova generazione di Gemini 3 di Google ha generato più chiacchiere dovute alle fughe di notizie rispetto alla maggior parte dei lanci di prodotti: punti di controllo della community che compaiono nei siti di benchmarking pubblici, nomi di modelli che compaiono negli strumenti di Google e un percorso attivo per gli sviluppatori che provano i modelli tramite Gemini CLI e CometAPI.

Cos'è Gemini 3.0 e perché è così atteso?

Ad alto livello, Gemini 3.0 è il prossima iterazione importante della famiglia Gemini di grandi modelli di intelligenza artificiale multimodali sviluppati da Google DeepMind (e dalla sua società madre Google LLC). La serie Gemini si posiziona come la linea di punta di modelli di intelligenza artificiale di Google, progettata non solo per la comprensione e la generazione di testo, ma anche per compiti multimodali (testo + immagine + codice + audio/video), ragionamento, utilizzo di strumenti e, in definitiva, comportamento più agente.

Il motivo per cui le persone sono così entusiaste di Gemini 3.0 è che sembra rappresentare un grande balzo in avanti — non solo un piccolo aggiornamento — nelle capacità del modello, nella lunghezza del contesto, nel ragionamento e nell'utilità pratica. Fughe di notizie dalla community, riferimenti al codice, segnali di benchmarking e articoli suggeriscono che Gemini 3.0 si spingerà verso nuovi territori di "modelli pensanti", finestre di contesto più lunghe, una più profonda integrazione multimodale e un'orchestrazione di strumenti agentici.

Di seguito spiegherò esattamente perché è importante, quello che sappiamo finorae ciò che è ancora speculativo.

Cosa sono “lithiumflow” e “orionmist” e perché sono apparsi su LMArena?

Cosa hanno scoperto LM Arena e la comunità?

Dal 19 al 23 ottobre, gli investigatori della Community hanno scoperto due nuovi checkpoint LM Arena denominati lithiumflow e orionmist. Questi nomi sembrano coerenti con le convenzioni di denominazione interne di Google (il nome della famiglia "orion" è stato utilizzato in precedenti nomi in codice Gemini) e gli analisti della Community li interpretano come identificatori o checkpoint iniziali per varianti di Gemini 3.x, comunemente indicati come checkpoint Gemini 3 Pro / Flash.

Perchè importa?

Se lithiumflow e orionmist sono veri e propri checkpoint di Gemini 3, la divisione suggerisce che Google potrebbe preparare più sottofamiglie (Flash e Pro): ad esempio, una variante "lithiumflow" ottimizzata per throughput ed efficienza, e una variante "orionmist" ottimizzata per il recupero aggiornato o per capacità multimodali. Lithiumflow appare (secondo le speculazioni della comunità) come il modello di generazione di base ottimizzato per ragionamento/generazione (senza search-grounding). Orionmist sembra essere una variante con integrazione con dati esterni/ricerca in tempo reale, probabilmente più efficace nella generazione con recupero aumentato o nelle attività "live".

Il mio test

Spettacolo di check-in alla LM Arena molto forte Risultati per lithiumflow in attività linguistiche classiche (ragionamento, codice e alcune attività SVG/layout). Diversi analisti della comunità hanno anche pubblicato confronti affiancati affermando che lithiumflow supera l'attuale Gemini 2.x pubblico e altri contemporanei su specifici microbenchmark.

L'utilizzo di Lithiumflow per la scrittura si traduce in una maggiore creatività e qualità letteraria rispetto a Gemini 2.5, ma il numero di parole rimane un punto debole, solo da duemila a tremila. In combinazione con OrionMist, può competere con Claude 4.5 in termini di prestazioni e precisione di codifica, ma la differenza non è significativa.

Ecco come si confrontano questi modelli nei benchmark finora condotti:

| Segno di riferimento | Gemini 3.0 (flusso di litio) | Gemini 3.0 (orionmist) | Gemelli 2.5 Pro | Claude Opus 4.1 | Claude 3.7 Sonetto |

|---|---|---|---|---|---|

| SimpleBench | 80-100% | 80-100% | 62.4% | 60.0% | 46.4% |

Entrambi i modelli mostravano ancora illusioni e instabilità in alcuni compiti di conoscenza, il che è comprensibile per un'anteprima preliminare. Questo schema (eccellenza nei compiti creativi e generazione di struttura/codice eccellenti, ma occasionalmente errori fattuali) è comune quando i modelli vengono combinati con nuove funzionalità multimodali o di generazione di codice.

I test di questi due modelli si sono conclusi presso la LM Arena, confermando ulteriormente che si tratta effettivamente di Gemini 3.0.

Il coinvolgimento di Apple e le specifiche trapelate

Differenze di modello

A metà 2025, Apple frammenti di codice trapelati in una versione beta di iOS che mostrano identificatori come com.google.gemini_3_pro e al gemini_3_ultra.

Gli analisti hanno dedotto che Google e Apple si stavano preparando Integrazioni "Apple Intelligence" basate su Gemini, probabilmente per Siri e riepilogo sul dispositivo:

- Gemini 3 Pro (livello di ragionamento basato su cloud)

- Gemini 3 Nano (variante sul dispositivo)

- Inferenza multimodale in tempo reale

Ciò è in linea con la spinta di Google per un Tessuto AI connettendo dispositivi mobili, API cloud ed ecosistema web.

Perdita di specifiche

Apple e Google stanno negoziando una maggiore integrazione di Gemini per Apple Intelligence/Siri: un'indiscrezione descrive l'intenzione di Apple di utilizzare una variante personalizzata di Gemini nel suo stack di intelligenza artificiale. Apple e Google hanno menzionato il parametro 1.2T nel loro piano di collaborazione per i modelli di intelligenza artificiale, che potrebbe essere la specifica di Gemini 3.0.

Come iniziare con l'anteprima di Gemini 3 Pro

Sulla base delle informazioni e dei test disponibili, fornirò tre metodi: Vertex, Gemini CLI e API. Gli sviluppatori possono scegliere il metodo più adatto alle proprie esigenze e al proprio ambiente. Il nome del modello Gemini 3.0 Pro è gemini-3-pro-preview-11-2025 e gemini-3-pro-preview-11-2025-thinking.

Accoss Vertex

Gemini 3.0 pro (gemini-3-pro-preview-11-2025) è stato aggiunto all'elenco dei modelli di Vertex e alcuni utenti della community affermano di poterlo testare direttamente, a patto di avere un account Vertex a pagamento e di potervi accedere utilizzando le credenziali del proprio account. In effetti, è possibile trovare tracce nei registri di rete di Vertex:

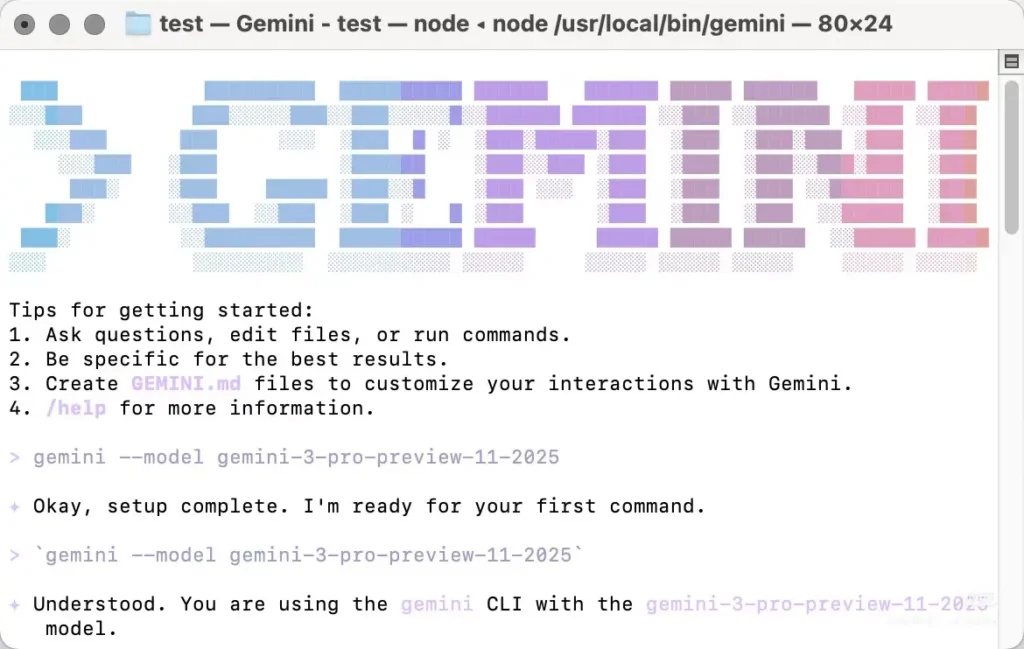

Accoss Gemini cli

Gemini 3.0 Pro può essere richiamato anche tramite la Gemini CLI, ma il modello deve essere specificato manualmente quando lo si utilizza manualmente. La maggior parte delle recensioni più recenti di Gemini 3.0 Pro proviene attualmente dall'utilizzo della Gemini CLI. Tuttavia, presenta alcuni svantaggi: funziona solo con alcuni nodi nordamericani, richiedendo di modificare manualmente l'indirizzo IP locale per provare, e potrebbe essere necessario riprovare più volte. Non è molto stabile e restituirà un errore 404 in caso di errore.

Devi effettuare l' installare la Gemini CLI localmente, quindi autenticarsi con un account che dispone di autorizzazioni di accesso (account Google / account CometAPI) e specificare manualmente il nome del modello "gemini-3-pro-preview-11-2025" per utilizzare Gemini 3.0 pro-preview, Esempio: installa ed esegui (shell)

```bash

# instant run (no install)

npx https://github.com/google-gemini/gemini-cli

or install globally:

npm install -g @google/gemini-cli

# or on macOS/Linux using Homebrew

brew install gemini-cli

La CLI accetta gli identificatori di modello allo stesso modo dell'API. In pratica: imposta l'identificatore del modello (ad esempio `model: "gemini-3-pro-preview-11-2025"`) in una richiesta o configurazione CLI e invocarla: se il tuo account ha accesso, la richiesta avrà esito positivo.

### API di Accoss CometAPI

[CometaAPI](https://www.cometapi.com/it/) è una piattaforma API unificata che aggrega oltre 500 modelli di intelligenza artificiale provenienti da provider leader, come la serie GPT di OpenAI, Gemini di Google, Claude di Anthropic, Midjourney, Suno e altri, in un'unica interfaccia intuitiva per gli sviluppatori. Offrendo autenticazione, formattazione delle richieste e gestione delle risposte coerenti.

CometAPI ha integrato il [API di anteprima di Gemini 3 Pro](https://www.cometapi.com/it/gemini-3-pro-api/) e il nome della chiamata API interna è `gemini-3-pro-preview`Quando si effettua la chiamata, è sufficiente modificare l'indirizzo di richiesta in `https://api.cometapi.com/v1/chat/completions`.

È possibile richiamare l'anteprima di Gemini 3.0 Pro nello stesso modo in cui si richiama l'API OpenAI. Nei miei test, la chiamata tramite CometAPI è più stabile rispetto all'utilizzo della CLI di Gemini.

## Quali sono le caratteristiche previste per Gemini 3.0?

Di seguito sono elencate le funzionalità più discusse (indicando esplicitamente quali elementi sono confermati rispetto alle aspettative della comunità/degli analisti).

### Progettazione e architettura del core (confermato vs. previsto)

- **Fondazione multimodale:** Gemini è concepito come una famiglia multimodale (testo, immagini, codice, audio/video) e Google ha già pubblicato modelli e strumenti multimodali nell'API Gemini. Questo è confermato e continuerà a essere centrale.

- **Ragionamento/pianificazione avanzati:** Aspettatevi una più profonda integrazione tra tecniche di pianificazione e apprendimento basato sulla ricerca DeepMind, con una probabile differenza nell'enfasi sulla progettazione rispetto ad alcuni concorrenti. Questa è un'aspettativa fondata sulla storia di DeepMind, piuttosto che su specifiche pubbliche.

### Finestra di contesto e memoria

Finestre di contesto più lunghe: Gemini 3.0 aumenterà la capacità di contesto effettiva (le discussioni ipotizzano milioni di token), basandosi su precedenti lavori su contesti di grandi dimensioni. Questa è una previsione: Google non ha ancora pubblicato i limiti ufficiali dei token di Gemini 3.0.

### Prestazioni, latenza e varianti del modello

- **Elevata precisione di ragionamento e di codifica:** I post della community LM Arena per "lithiumflow" (e "orionmist") suggeriscono ottime prestazioni nelle attività di ragionamento e di codice. Si tratta di benchmark della community non verificati, ma rappresentano il motivo principale di entusiasmo. Considerateli come segnali iniziali, non come prove definitive.

- **Molteplici varianti:** Voci e fughe di notizie indicano diverse varianti: una variante "Pro"/raw generation (spesso associata nei post al tag lithiumflow) e una variante grounded/abilitata alla ricerca (orionmist). Anche in questo caso, si tratta di inferenze della community basate sugli ID dei modelli e sul comportamento dei test.

### Multimodalità e nuove capacità

- **Integrazione di video e immagini:** Google ha recentemente introdotto modelli video (ad esempio, Veo 3) e funzionalità di gestione delle immagini nell'API Gemini; si prevede che Gemini 3.0 li sfrutterà e li unificherà per flussi di lavoro multimodali più completi. Questa funzionalità è supportata dalle precedenti release di Google nell'ecosistema Gemini.

- **Funzionalità sul dispositivo e sulla privacy (obiettivo):**Si prevede l'introduzione di opzioni più efficienti, su dispositivo o su cloud privato, per i dati sensibili, poiché Google e i suoi partner puntano sulla privacy e sulla minore latenza. Questa previsione è basata sulle tendenze dell'ecosistema; i dettagli specifici di Gemini 3.0 non sono ancora pubblici.

## Linea di fondo

Si prevede che Gemini 3.0 Pro-Preview rappresenti un cambiamento radicale per i modelli multimodali di Google incentrati sul ragionamento, offrendo potenzialmente un contesto più ampio, una pianificazione più efficace e funzionalità multimodali più complete. L'entusiasmo attuale è dovuto a un mix di **strumenti per sviluppatori confermati e segnali di prodotto Google** (gemini API, CLI, modelli Veo/video) e **segnali della comunità non ufficiali ma rumorosi** (Iscrizioni alla LM Arena per lithiumflow/orionmist, fughe di notizie e cronologie delle indiscrezioni degli analisti). Considerate i benchmark della community come indicatori iniziali e preparatevi imparando a usare gli strumenti per sviluppatori Gemini, in modo da poter valutare il modello in modo obiettivo quando Google rilascerà l'accesso ufficiale.

Si ipotizza che la data di uscita ufficiale più probabile sia il 18 novembre, che coincide con il piano di migrazione dei modelli di Google, previsto per il 18. Non vediamo l'ora di scoprire maggiori informazioni sull'anteprima di Gemini 3 Pro!

### Iniziamo

CometAPI è una piattaforma API unificata che aggrega oltre 500 modelli di intelligenza artificiale (IA) di provider leader, come la serie GPT di OpenAI, Gemini di Google, Claude di Anthropic, Midjourney, Suno e altri, in un'unica interfaccia intuitiva per gli sviluppatori. Offrendo autenticazione, formattazione delle richieste e gestione delle risposte coerenti, CometAPI semplifica notevolmente l'integrazione delle funzionalità di IA nelle tue applicazioni. Che tu stia sviluppando chatbot, generatori di immagini, compositori musicali o pipeline di analisi basate sui dati, CometAPI ti consente di iterare più velocemente, controllare i costi e rimanere indipendente dal fornitore, il tutto sfruttando le più recenti innovazioni nell'ecosistema dell'IA.

Gli sviluppatori possono accedere all'anteprima di Gemini 3.0 pro tramite CometAPI, [l'ultima versione del modello](https://api.cometapi.com/pricing) è sempre aggiornato con il sito ufficiale. Per iniziare, esplora le capacità del modello nel [Parco giochi](https://www.cometapi.com/console/playground) e consultare il [Guida API](https://api.cometapi.com/doc) per istruzioni dettagliate. Prima di accedere, assicurati di aver effettuato l'accesso a CometAPI e di aver ottenuto la chiave API. [CometaAPI](https://www.cometapi.com/it/) offrire un prezzo molto più basso rispetto al prezzo ufficiale per aiutarti a integrarti.

Pronti a partire? → [Iscriviti oggi a CometAPI](https://api.cometapi.com/login) !

Se vuoi conoscere altri suggerimenti, guide e novità sull'IA seguici su [VK](https://vk.com/id1078176061), [X](https://x.com/cometapi2025) e al [Discordia](https://discord.com/invite/HMpuV6FCrG)!