L'intelligenza artificiale si sta evolvendo rapidamente: nuovi modelli multimodali e API in tempo reale migliorate stanno semplificando l'integrazione di un'intelligenza artificiale potente nelle piattaforme di automazione, mentre dibattiti paralleli su sicurezza e osservabilità stanno rimodellando il modo in cui i team gestiscono i sistemi di produzione. Per chi sviluppa automazioni locali, sta emergendo un modello pratico: utilizzare un gateway di modelli unificato (come CometaAPI) per accedere a molti modelli e unire quelle chiamate di modello in un runner di automazione auto-ospitato (come n8n) in modo da mantenere il controllo su dati, latenza e costi. Questa guida ti mostra, passo dopo passo, come iniziare con CometAPI + n8n (locale), a cosa fare attenzione e come risolvere i problemi quando le cose vanno male.

Cos'è n8n e perché è importante per l'automazione dell'intelligenza artificiale?

n8n è uno strumento open source per l'automazione dei flussi di lavoro con un editor visuale e un ampio ecosistema di nodi (connettori). È progettato per consentire di concatenare trigger, trasformazioni e chiamate API esterne in flussi di lavoro ripetibili (webhook, processi pianificati, elaborazione di file, chatbot, ecc.). L'hosting autonomo di n8n in locale offre il controllo completo sulla residenza e l'esecuzione dei dati, il che è particolarmente utile quando si richiamano modelli di intelligenza artificiale di terze parti che gestiscono input sensibili.

Come funziona n8n in pratica?

- Canvas visivo con trigger (Webhook, Cron) e nodi di azione (Richiesta HTTP, nodi di database, e-mail).

- I nodi della community estendono le capacità: puoi installare pacchetti della community e trattarli come nodi nativi.

L'auto-hosting di n8n ti offre:

- Controllo completo dei dati — i flussi di lavoro e i dati di esecuzione rimangono nell'infrastruttura che gestisci.

- Personalizzazione — aggiungi nodi privati o integrazioni locali senza attendere le funzionalità cloud.

- Prevedibilità dei costi — nessuna sorpresa nella fatturazione cloud per attività per un'automazione interna elevata.

- Sicurezza e conformità — più facile soddisfare le esigenze normative e di politica interna.

Che cos'è CometAPI e perché utilizzarlo come gateway modello?

CometaAPI è un gateway API unificato che espone centinaia di modelli di intelligenza artificiale di terze parti (testo, incorporamenti, generazione di immagini, ecc.) dietro un'unica interfaccia e un unico modello di fatturazione compatibili con OpenAI. Ciò significa che, invece di aggiungere integrazioni personalizzate per ogni LLM o motore di immagini che si desidera provare, è possibile richiamare un'API e scegliere il modello desiderato nella richiesta. Questo semplifica la sperimentazione, il controllo dei costi e l'integrazione operativa.

benefici:

- Scelta del modello: Provare molti fornitori/modelli con lo stesso percorso di codice.

- Token pooling / quote gratuite: Molti gateway unificati offrono crediti/livelli per sperimentare.

- Infrastruttura più semplice: Un sistema di autenticazione e un URL di base da gestire.

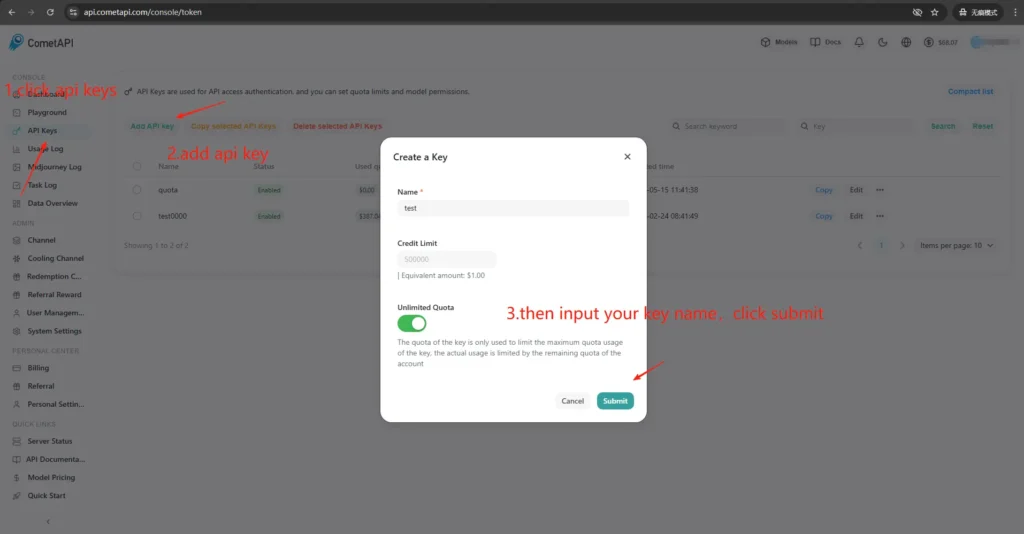

Come posso ottenere l'accesso e le chiavi CometAPI?

- Registrati sul sito CometAPI (o nella dashboard del fornitore). La maggior parte dei gateway offre un livello gratuito per testare.

- Ottieni una chiave API dalla dashboard di CometAPI: una lunga stringa segreta. Nota dove la documentazione ti dice di posizionarla (CometAPI utilizza l'autorizzazione Bearer contro

https://api.cometapi.com/v1). - Leggi la documentazione API per l'endpoint che intendi utilizzare (completamenti di chat, immagini, incorporamenti). CometAPI documenta endpoint come

/v1/chat/completionse al/v1/images/generations.

Perché è importante il legame (integrazione) tra n8n e CometAPI?

In questo caso, "bonding" si riferisce a un percorso di integrazione affidabile e sicuro tra il tuo runner di automazione (n8n) e il tuo gateway di modello. Un bonding adeguato è importante perché:

- Conserva contesto nelle chiamate (cronologia delle conversazioni, incorporamenti).

- Si centralizza Credenziali e segreti in un unico posto per una rotazione più sicura.

- Riduce la latenza e la superficie di errore utilizzando endpoint prevedibili e formati di richiesta standard.

- Permette di osservabilità e risoluzione dei problemi: sapere quale modello, richiesta e risposta hanno portato a un risultato.

In breve: una buona adesione riduce il rischio operativo e velocizza l'iterazione.

Come posso distribuire n8n localmente (guida pratica rapida)?

Puoi eseguire n8n localmente con npm o con Docker; Docker Compose è l'approccio consigliato per la maggior parte degli scenari self-hosted (è riproducibile e isola le dipendenze). Di seguito è riportato un esempio minimo di Docker Compose e note essenziali.

Come posso ospitare autonomamente n8n con Docker?

Docker (e Docker Compose) è il modo più affidabile e ripetibile per eseguire n8n in produzione. Isola l'app, semplifica gli aggiornamenti e si integra bene con reverse proxy e orchestratori (Docker Swarm, Kubernetes). La documentazione ufficiale di n8n include un riferimento a Docker Compose che seguirò e adatterò qui.

Per la produzione, in genere verrà eseguito uno stack composto da:

- servizio n8n (immagine ufficiale:

docker.n8n.io/n8nio/n8norn8nio/n8na seconda del tag). - PostgreSQL (o un altro DB supportato).

- Redis (se si prevede di utilizzare la modalità coda).

- Un proxy inverso (Traefik, Caddy o nginx) per TLS, routing host e regole di limite di velocità.

Questa architettura separa nettamente le problematiche (persistenza del DB, code, proxy web) e semplifica scalabilità e backup. La documentazione ufficiale di n8n fornisce modelli Docker Compose e riferimenti alle variabili d'ambiente.

Questa è una guida passo passo:

- Crea una cartella e una

docker-compose.ymlcon il servizio canonico n8n. Di seguito è riportato un esempio pratico di docker-compose che copre le tipiche esigenze di produzione: PostgreSQL esterno, Redis (per la modalità coda/esecuzione), volumi persistenti e un proxy inverso Nginx che gestisce TLS:

```yaml

version: "3.8"

services:

n8n:

image: n8nio/n8n:latest

restart: unless-stopped

environment:

- DB_TYPE=postgresdb

- DB_POSTGRESDB_HOST=postgres

- DB_POSTGRESDB_PORT=5432

- DB_POSTGRESDB_DATABASE=n8n

- DB_POSTGRESDB_USER=n8n

- DB_POSTGRESDB_PASSWORD=supersecretpassword

- N8N_BASIC_AUTH_ACTIVE=true

- N8N_BASIC_AUTH_USER=admin

- N8N_BASIC_AUTH_PASSWORD=anothersecret

- WEBHOOK_TUNNEL_URL=https://n8n.example.com

- EXECUTIONS_MODE=queue

- QUEUE_BULL_REDIS_HOST=redis

ports:

- "5678:5678"

volumes:

- n8n_data:/home/node/.n8n

depends_on:

- postgres

- redis

postgres:

image: postgres:15

environment:

POSTGRES_DB: n8n

POSTGRES_USER: n8n

POSTGRES_PASSWORD: supersecretpassword

volumes:

- pgdata:/var/lib/postgresql/data

redis:

image: redis:7

volumes:

- redisdata:/data

volumes:

n8n_data:

pgdata:

redisdata:

2. Inizio:

docker compose up -d

3. Visita `http://localhost:5678` e crea il tuo utente amministratore. Per la produzione, avrai bisogno di PostgreSQL, SSL e variabili d'ambiente appropriate: consulta la documentazione ufficiale di Docker Compose.

**Note e indurimento:**

- Do **non è un** memorizzare i segreti in testo normale in `docker-compose.yml`; utilizzare file di ambiente, segreti Docker o gestori di segreti esterni in produzione.

- sostituire `WEBHOOK_URL` con il tuo vero URL pubblico e configura il proxy inverso per instradare `n8n.example.com` al contenitore n8n.

- Usa il `EXECUTIONS_MODE=queue` per un'elaborazione in background robusta; richiede queue worker e Redis.

## Come posso ospitare autonomamente n8n con npm / Node.js?

L'installazione tramite npm (o pnpm) esegue n8n direttamente sull'host. Questa soluzione è più leggera (nessun livello di container) e può essere utile per installazioni monoutente a bassa complessità o per macchine di sviluppo. Tuttavia, conferisce maggiore responsabilità all'amministratore per la gestione delle dipendenze, l'isolamento e la supervisione dei servizi. La documentazione ufficiale di n8n include una guida all'installazione di npm e alcune avvertenze.

### I pacchetti del sistema operativo richiesti e la versione di Node:

- Utilizzare una LTS stabile Node.js (Node 18 o Node 20+, che soddisfi i requisiti di rilascio n8n).

- Installazione `build-essential`, `git`e un gestore di processi (si consiglia systemd).

- Per la produzione, continua a utilizzare PostgreSQL e Redis come servizi esterni (stesso ragionamento di Docker).

### Come faccio a installare ed eseguire n8n tramite npm (procedura passo dopo passo)?

1. Installa Node.js (consigliato: nvm)

Install nvm

curl -o- https://raw.githubusercontent.com/nvm-sh/nvm/v0.39.7/install.sh | bash

Reload your shell (adjust to your shell startup file if needed)

source ~/.bashrc # or ~/.zshrc

Install and use the latest LTS (usually 18 or 20)

nvm install --lts

nvm use --lts

Verify

node -v

npm -v

Se in seguito vedi "n8n: comando non trovato", riavvia il terminale o assicurati che il percorso bin globale npm gestito da nvm sia sul tuo PATH.

---

2. Installa e avvia n8n (locale)

npm install -g n8n

n8n -v # verify version

3. Inizia in primo piano:

n8n start

URL predefinito: <http://localhost:5678/> Se la porta è in uso:

export N8N_PORT=5679

n8n start

Facoltativo: mantenerlo in esecuzione in background (sempre in locale):

npm install -g pm2

pm2 start "n8n" --name n8n

pm2 save

pm2 status

4. Primo accesso e registrazione:

- Apri http://localhost:5678/ nel tuo browser.

- Al primo avvio, segui la procedura guidata per creare l'account Proprietario (e-mail + password) ed effettua l'accesso.

## Come posso installare o configurare un nodo della community CometAPI in n8n?

n8n supporta sia i nodi community verificati (installazione tramite GUI) sia l'installazione manuale da npm quando si effettua l'auto-hosting. Esistono due modi per integrare CometAPI in n8n:

### Opzione A: utilizzare il nodo della community CometAPI (se disponibile nel pannello Nodi)

1. In n8n apri il pannello dei nodi (premi `+` or `Tab`).

2. CometAPI è un nodo comunitario verificato, appare in "Altro dalla comunità". Clicca e installa.

3. Dopo l'installazione, riavviare n8n se richiesto. Creare un nuovo **Credenziali** in Impostazioni → Credenziali (scegli il tipo di credenziale CometAPI se il nodo lo fornisce) e incolla il tuo token CometAPI.

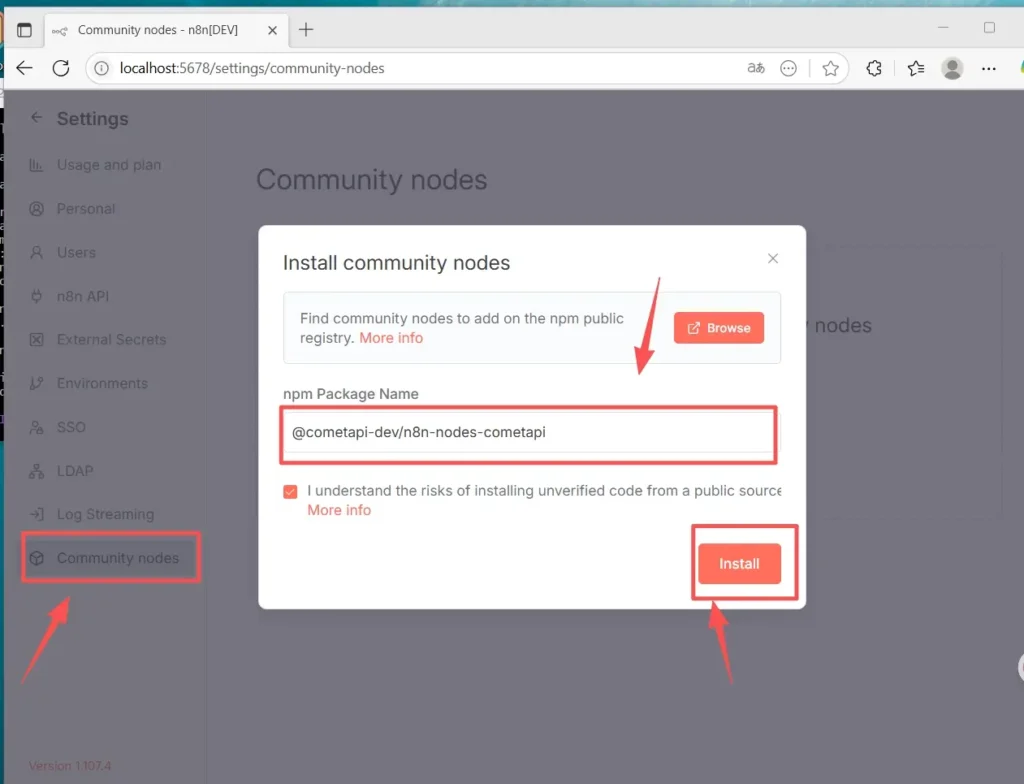

### Opzione B — Installazione manuale (quando l'installazione GUI non è disponibile)

1. Accedi tramite SSH al tuo host/contenitore n8n.

2. Installare il pacchetto nel globale n8n `node_modules` o la tua cartella personalizzata:

- Vai su Impostazioni (in basso a sinistra) > Nodi della community Fai clic su "

- Installa un nodo comunitario”

- In "Nome pacchetto npm", immettere: `@cometapi-dev/n8n-nodes-cometapi`Seleziona la casella di riconoscimento del rischio. Fai clic su "

- Installa”Dopo l’installazione, puoi cercare “CometAPI” nel pannello del nodo.

3. Riavvia n8n. Se l'istanza viene eseguita in modalità coda, è necessario seguire il percorso di installazione manuale descritto nella documentazione.

### Come verificare che il nodo sia installato

- Dopo il riavvio, apri il pannello dei nodi e cerca "CometAPI" o "Comet". Il nodo verrà contrassegnato come pacchetto della community.

- Se non riesci a vedere il nodo: verifica che sia in uso l'account del proprietario dell'istanza (solo i proprietari dell'istanza possono effettuare l'installazione) o che il pacchetto del nodo sia stato installato senza errori nei log del contenitore/immagine.

## Come creare un flusso di lavoro e configurare l'API

### 1. Crea un nuovo flusso di lavoro

- Accedi alla tua istanza n8n (auto-ospitata).

- Clicchi **“Aggiungi flusso di lavoro”** per avviare una nuova tela di automazione.

### 2.Aggiungi nodo

- Aggiungi un nodo trigger: cerca "Trigger manuale" o "Quando si fa clic su 'Esegui flusso di lavoro'".

- Fare clic sul simbolo “+” sul lato destro della tela e cercare “CometAPI” per aggiungere il nodo.

- Puoi anche cercare “CometAPI” dall’elenco dei nodi a sinistra e trascinarlo sulla tela.

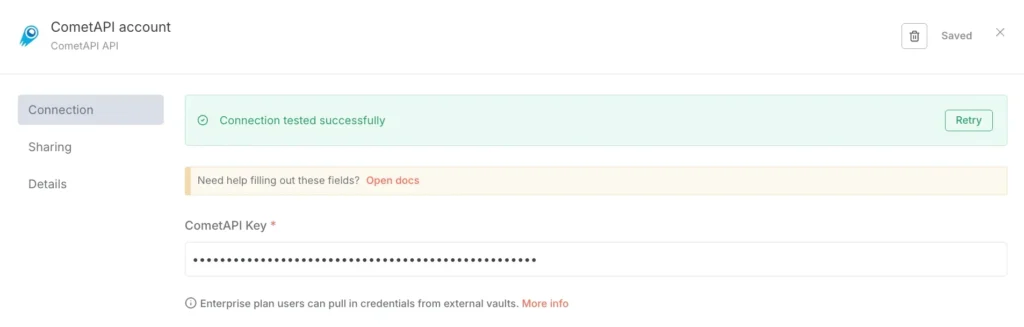

### 3.Configurare le credenziali (solo la prima volta):

- Nel nodo CometAPI, in "Credenziali per la connessione", seleziona "Crea nuovo".

- Incolla il token creato nella console CometAPI in "CometAPI Key".

- Salva. L'URL di base predefinito è https://www.cometapi.com/console/ e in genere non necessita di modifiche.

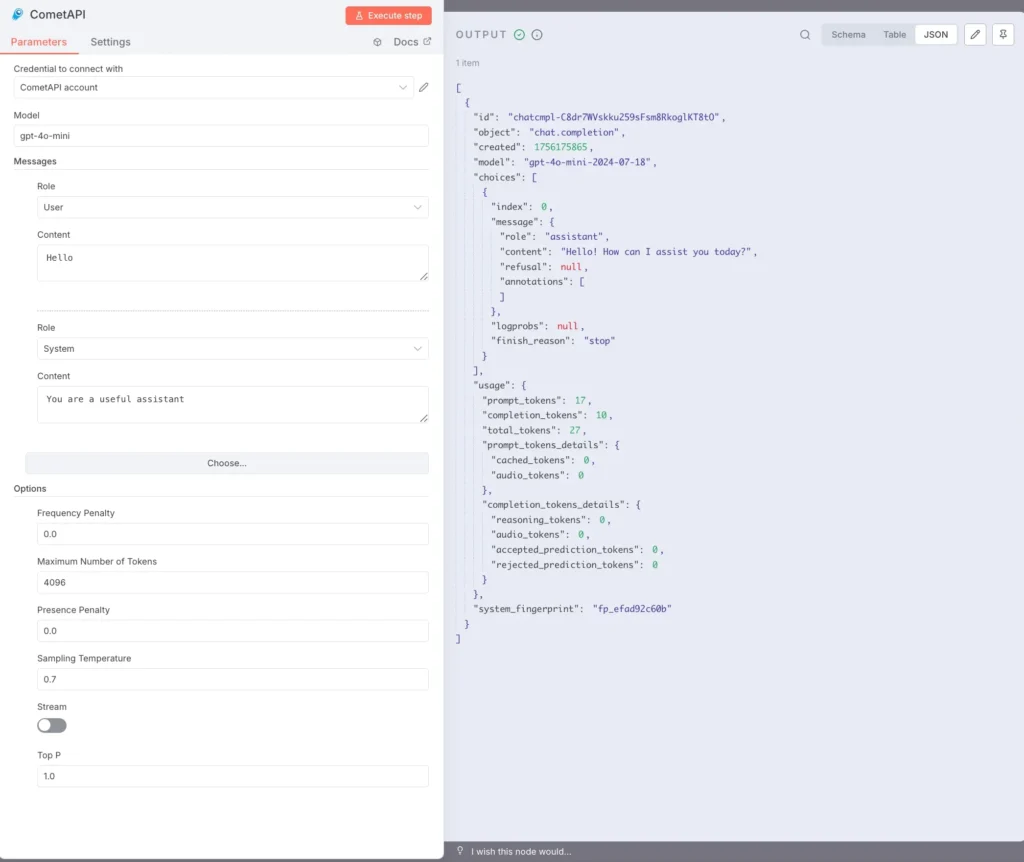

### 4. Configurare il modello e i messaggi:

Modello: inserisci un modello supportato, ad esempio, `gpt-4o` or `gpt-4o-mini`.

Messaggi: è necessario compilare il ruolo e il contesto e puoi scegliere l'utente o il sistema per il ruolo

I parametri opzionali (se necessario) hanno: Numero massimo di token (ad esempio, 4096); Temperatura di campionamento (ad esempio, 0.7); PenaltyStream (abilita/disabilita lo streaming). Per la documentazione e le spiegazioni specifiche dei parametri, fare riferimento a [Documentazione CometAPI](https://api.cometapi.com/doc).

### 5. Esecuzione del testo:

Selezionare il nodo CometAPI e fare clic su "Esegui passaggio" oppure fare clic su "Esegui flusso di lavoro" in basso.

Il pannello OUTPUT sulla destra dovrebbe mostrare una risposta JSON (incluse scelte, utilizzo, ecc.).

Ora hai installato n8n(Recommend) localmente su Linux tramite npm, installato e configurato il nodo della community CometAPI e puoi eseguire flussi di lavoro che chiamano modelli come gpt-4o per ricevere risposte.

## Quali sono i problemi più comuni e come posso risolverli?

### 1) “401 Non autorizzato” o “Chiave API non valida”

- Conferma la stringa esatta del token nella dashboard CometAPI (potrebbero esserci token con nomi simili). Copia → incolla nelle credenziali n8n e riavvia il nodo se necessario.

- Assicurarsi che il formato dell'intestazione dell'autorizzazione sia `Bearer sk-xxxxx`.

### 2) Il nodo della comunità non si installa / "modalità coda"

- Se il tuo n8n funziona in **modalità coda**, l'installazione tramite GUI può essere disabilitata; segui la documentazione di installazione manuale per installare i nodi della community tramite npm o crea un'immagine personalizzata che includa il nodo. Riavvia n8n dopo l'installazione.

### 3) Nodo non trovato nella tavolozza dopo l'installazione

- Riavvia n8n.

- Assicurati di aver installato il pacchetto nel contesto corretto (all'interno dell'immagine del contenitore o nel `.n8n/custom` percorso se si utilizza quel modello).

- Controllare i log dei contenitori per individuare eventuali errori di risoluzione dei moduli.

### 4) Limiti di velocità o problemi di quote

- Controlla la dashboard di CometAPI per informazioni sull'utilizzo e sulla quota.

- Implementare il backoff esponenziale e ricorrere a modelli più economici quando si rilevano avvisi di limite o errori HTTP 429.

## Esistono alternative se il nodo della comunità non è disponibile o se si desidera maggiore flessibilità?

Sì, puoi sempre usare il **Richiesta HTTP** nodo direttamente (controllo completo) o un [Nodo OpenAI con URL di base](https://apidoc.cometapi.com/n8n-965890m0) reindirizzamento (scorciatoia pratica). L'utilizzo di HTTP raw semplifica anche l'adozione di nuovi endpoint CometAPI non appena vengono rilasciati (ad esempio, endpoint immagine/video). Fare riferimento a [alle taglie](https://apidoc.cometapi.com/n8n-965890m0).

**Vedere anche** [Come usare n8n con CometAPI](https://www.cometapi.com/it/how-to-use-n8n-with-cometapi/?utm_source=chatgpt.com)

## Conclusione:

CometAPI offre la possibilità di scelta del modello e semplicità operativa; n8n offre orchestrazione visiva ed estensibilità. Utilizza il trucco delle credenziali OpenAI per una rapida integrazione tramite chat/completamento e i nodi della community dove esistono e sono affidabili. Strumenta ogni flusso di lavoro per costi, latenza e sicurezza; preferisci fallback umani per le decisioni importanti; e mantieni dinamica la selezione del modello in modo da poterti adattare ai rapidi cambiamenti nel panorama dei fornitori di intelligenza artificiale. La combinazione di n8n e CometAPI è potente, ma come tutti gli strumenti potenti, necessita di alcune precauzioni: osservare, testare e iterare.