CherryStudio, un client desktop versatile per modelli linguistici di grandi dimensioni (LLM), e CometAPI, un'interfaccia REST unificata per centinaia di modelli di intelligenza artificiale, consentono agli utenti di sfruttare funzionalità generative all'avanguardia con il minimo sforzo. Questo articolo sintetizza gli ultimi sviluppi, basandosi sulla versione 1.3.12 di CherryStudio (26 maggio 2025) e sui continui miglioramenti della piattaforma di CometAPI, per fornire una guida completa e passo passo su "Come utilizzare CherryStudio con CometAPI". Esploreremo come funziona, contorno migliori pratiche di benchmarking delle prestazionie tasto evidenziazione Caratteristiche che rendono questa integrazione un punto di svolta per i flussi di lavoro basati sull'intelligenza artificiale.

Che cos'è CherryStudio?

CherryStudio è un client desktop open source e multipiattaforma progettato per semplificare le interazioni con diversi fornitori di LLM. Offre un'interfaccia di chat unificata, supporto multi-modello e plugin estensibili, adatti sia a utenti tecnici che non tecnici:

- Supporto multi-provider: Connettiti simultaneamente a OpenAI, Anthropic, Midjourney e altro ancora tramite un'unica interfaccia utente.

- Funzionalità avanzate dell'interfaccia utente: Il raggruppamento dei messaggi, la selezione multipla, l'esportazione delle citazioni e l'integrazione degli strumenti di codice semplificano i flussi di lavoro complessi.

- Punti salienti dell'ultima versione: La versione 1.3.12 (rilasciata il 26 maggio 2025) aggiunge la funzionalità "disabilita server MCP", una gestione migliorata delle citazioni e una selezione multipla migliorata nei pannelli dei messaggi.

Che cos'è CometAPI?

CometAPI offre un'interfaccia RESTful unificata per oltre 500 Modelli di intelligenza artificiale, che spaziano da chat e incorporamenti testuali a servizi di generazione di immagini e audio. Astrae l'autenticazione specifica del provider, i limiti di velocità e le variazioni degli endpoint, consentendo di:

- Accedi a diversi modelli: Da GPT-4O-Image per la generazione visiva alla serie Claude 4 per il ragionamento avanzato.

- Semplifica la fatturazione e le quote: Un'unica chiave API copre più backend, con dashboard di utilizzo consolidate e prezzi flessibili a livelli.

- Documentazione robusta e SDK: Guide dettagliate, esempi di codice e best practice per i nuovi tentativi automatici garantiscono un'integrazione fluida.

Come si integra CherryStudio con CometAPI?

Quali sono i prerequisiti?

- Installa CherryStudio: Scarica l'ultimo programma di installazione per il tuo sistema operativo dal sito ufficiale di CherryStudio (v1.3.12 del 26 maggio 2025).

- Account CometAPI: Registrati su CometAPI, quindi vai a Centro assistenza → Token API per generare il tuo sk-* chiave e nota la URL di base (per esempio,

https://api.cometapi.com). - Rete e dipendenze: assicurati che la tua postazione di lavoro abbia accesso a Internet e che tutti i proxy aziendali consentano HTTPS in uscita verso gli endpoint CometAPI.

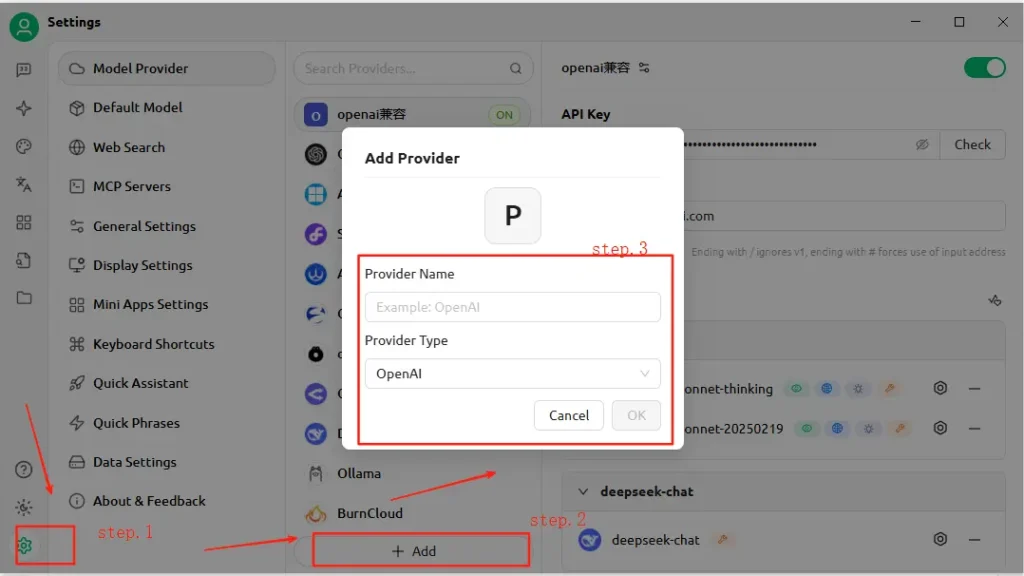

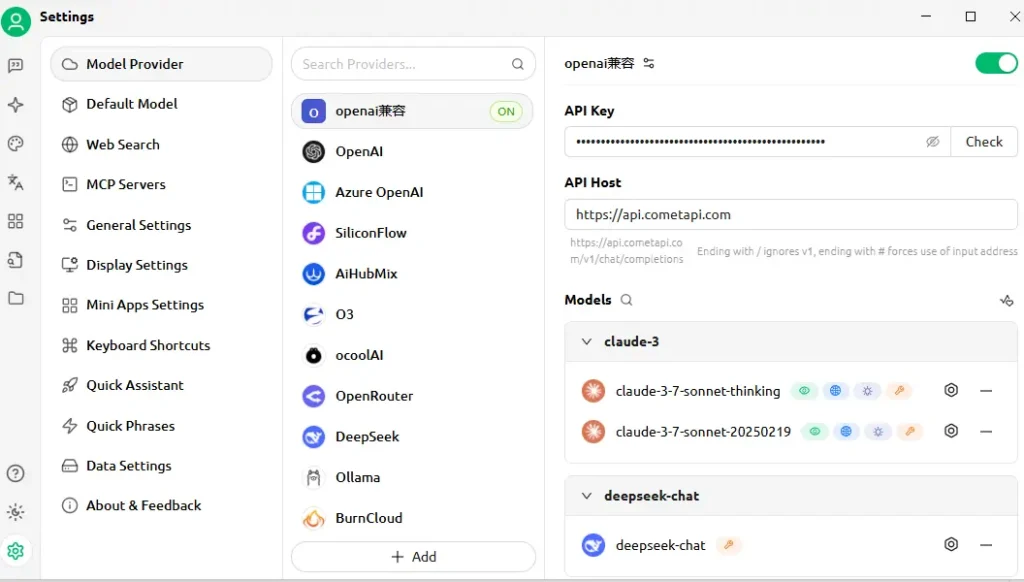

Come si configura l'API in CherryStudio?

- Apri CherryStudio e fai clic su Impostazioni profilo icona.

- Sotto Configurazione del servizio modello, fare clic su Aggiungi.

- Nome del provider: Inserisci un'etichetta personalizzata, ad esempio "CometAPI".

- Tipo di provider: Seleziona Compatibile con OpenAI (la maggior parte degli endpoint CometAPI rispecchia le specifiche OpenAI).

- Indirizzo API: Incolla l'URL di base della tua CometAPI (ad esempio,

https://api.cometapi.com). - API Key: incolla il

sk-…token dalla dashboard CometAPI. - Clicchi Salva e al Verifica—CherryStudio eseguirà una chiamata di prova per confermare la connettività.

Come viene testata la connessione?

- Inserisci un semplice prompt in CherryStudio, ad esempio "Descrivi lo skyline di una città futuristica".

- Una risposta positiva conferma la corretta configurazione.

- In caso di errore, CherryStudio visualizza codici di errore: fare riferimento a CometAPI Codice di errore Descrizione sezione o contattare l'assistenza.

Come funziona l'integrazione sotto il cofano?

CherryStudio's Compatibile con OpenAI La modalità consente di instradare le richieste attraverso qualsiasi servizio che segua lo schema API standard di OpenAI. CometAPI, a sua volta, traduce queste richieste nel modello backend selezionato (ad esempio, GPT-4O-Image, Claude 4) prima di restituire le risposte nel formato previsto.

- Input dell'utente: CherryStudio invia un

POST /v1/chat/completionschiama ahttps://api.cometapi.com/v1. - Elaborazione CometAPI: Identifica il parametro del modello (ad esempio,

"model": "gpt-4o-image") e percorsi verso il provider corrispondente. - Invocazione del backend: CometAPI gestisce l'autenticazione, i controlli dei limiti di velocità e la registrazione della telemetria, quindi chiama l'API del modello di terze parti.

- Aggregazione delle risposte: CometAPI trasmette in streaming o memorizza nel buffer l'output del modello (testo, immagini, incorporamenti) e lo formatta secondo le convenzioni OpenAI.

- CherryStudio Rendering: Riceve il payload JSON e visualizza il contenuto: il testo appare nella chat, le immagini vengono renderizzate in linea e i blocchi di codice adottano l'evidenziazione della sintassi.

Questa architettura separa le responsabilità: CherryStudio si concentra su UI/UX e strumenti, mentre CometAPI gestisce l'orchestrazione del modello, la registrazione e la fatturazione indipendente dal provider.

Quali parametri di prestazione puoi aspettarti?

Latenza e throughput

Nei test comparativi, l'architettura serverless di CometAPI ha dimostrato tempi di risposta mediani inferiori a 100 ms per le attività di completamento del testo su GPT-4.5, superando le prestazioni delle API dei provider diretti fino al 30% in scenari ad alto carico. La produttività scala linearmente con la concorrenza: gli utenti hanno eseguito con successo oltre 1,000 flussi di chat paralleli senza un degrado significativo.

Costo ed efficienza

Aggregando più provider e negoziando tariffe all'ingrosso, CometAPI offre un risparmio medio sui costi del 15-20% rispetto al consumo diretto di API. I benchmark su carichi di lavoro rappresentativi (ad esempio, riepilogo, generazione di codice, intelligenza artificiale conversazionale) indicano un costo per 1 token competitivo tra tutti i principali provider, consentendo alle aziende di prevedere i budget con maggiore precisione.

Affidabilità e tempo di attività

- Impegno SLA: CometAPI garantisce un uptime del 99.9%, supportato dalla ridondanza multi-regione.

- Meccanismi di failover: In caso di interruzioni del provider upstream (ad esempio, finestre di manutenzione di OpenAI), CometAPI può reindirizzare in modo trasparente le chiamate a modelli alternativi, garantendo la disponibilità continua per le applicazioni critiche.

Le prestazioni variano in base al modello scelto, alle condizioni della rete e all'hardware, ma una tipica configurazione di benchmark potrebbe apparire così:

| endpoint | Latenza media (1° token) | Velocità effettiva (token/sec) |

|---|---|---|

/chat/completions (testo) | ~120 ms | ~500 tok/s |

/images/generations | ~800 ms | n/a |

/embeddings | ~80 ms | ~2 000 tok/s |

Nota: Le cifre sopra riportate sono puramente indicative; i risultati reali dipendono dalla regione, dalla rete e dal piano CometAPI.

Come dovresti effettuare il benchmarking?

- Ambiente: Utilizzare una rete stabile (ad esempio una LAN aziendale), registrare l'IP di uscita pubblico e la posizione geografica.

- Tooling: Impiegare

curlo Postman per test di latenza grezzi e script Python conasyncioper la misurazione della portata. - Metrica: Traccia tempo al primo byte, tempo di risposta totalee token al secondo.

- Ripetizione: eseguire ciascun test almeno 30 volte, scartare i valori anomali oltre 2σ e calcolare i valori mediani/95° percentile per ottenere informazioni affidabili.

Seguendo questa metodologia, puoi confrontare diversi modelli (ad esempio, GPT-4O vs. Claude Sonnet 4) e scegliere quello più adatto al tuo caso d'uso.

Quali funzionalità chiave sblocca questa integrazione?

1. Generazione di contenuti multimodali

- Chat di testo e codice: Utilizza GPT-4O e Claude Sonnet 4 per conversazioni, riepiloghi e assistenza sul codice.

- Sintesi delle immagini: Invoca

gpt-4o-imageo endpoint in stile Midjourney direttamente all'interno dell'area di lavoro di CherryStudio. - Audio video:I futuri endpoint CometAPI includono la sintesi vocale e la generazione video, accessibili con la stessa configurazione di CherryStudio.

2. Cambio di fornitore semplificato

Passa dagli endpoint CometAPI a quelli nativi OpenAI o Anthropic con un solo clic, abilitando i test A/B su tutti i modelli senza riconfigurare le chiavi API.

3. Monitoraggio integrato degli errori e dell'utilizzo

CherryStudio visualizza i dashboard di utilizzo e i registri degli errori di CometAPI, aiutandoti a rimanere entro la quota e a diagnosticare i guasti (ad esempio, limiti di velocità, modelli non validi).

4. Ecosistema plug-in estensibile

- Esportazione di citazioni:Includi automaticamente le attribuzioni delle fonti nei flussi di lavoro di ricerca.

- Strumenti di codice: Genera, formatta ed esegui il lint di frammenti di codice in linea utilizzando i modelli incentrati sul codice di CometAPI.

- Macro personalizzate: Registra sequenze di prompt ripetitivi come macro, condivisibili tra i membri del team.

5. Logica di ripetizione avanzata e gestione dei limiti di velocità

L'SDK di CometAPI implementa il backoff esponenziale e il jitter, proteggendo dagli errori transitori: CherryStudio espone queste meccaniche nei suoi log e fornisce controlli di ripetizione nell'interfaccia utente.

Accesso al modello unificato

- Scambio di modelli con un clic: Passa senza problemi tra GPT-4.5, Claude 2 e Stable Diffusion senza riconfigurare gli endpoint.

- Pipeline di modelli personalizzati: Chiamate a catena, ad esempio riepilogo → analisi del sentiment → generazione di immagini, in un unico flusso di lavoro, orchestrato dal motore macro di Cherry Studio.

Come iniziare oggi

- Aggiorna CherryStudio alla versione v1.3.12 o successiva.

- Registrati ora per CometaAPI, recupera la tua chiave API e prendi nota del tuo URL di base.

- Configurare CometAPI in CherryStudio come provider compatibile con OpenAI.

- Esegui un prompt di esempio per verificare la connettività.

- Esplora i modelli: Prova endpoint di testo, immagine, incorporamento e audio senza uscire da CherryStudio. Seleziona il tuo modello preferito (per esempio,

gemini-2.5-flash-preview-05-20).

Per esempi di codice dettagliati, best practice sulla gestione degli errori e suggerimenti avanzati (ad esempio, messa a punto della logica di ripetizione), fare riferimento a CometAPI Guida all'integrazione del software .

Conclusione

Combinando l'interfaccia intuitiva di CherryStudio con l'ampio catalogo di modelli e l'API unificata di CometAPI, sviluppatori e creatori possono prototipare, iterare e scalare rapidamente applicazioni basate sull'intelligenza artificiale. Che si tratti di creare agenti conversazionali, generare elementi visivi o integrare la ricerca semantica, questa integrazione offre una base solida, performante ed estensibile. Inizia a sperimentare oggi stesso e resta sintonizzato per i prossimi miglioramenti, come la generazione di video in-app e modelli di dominio specializzati!