Anthropic ha rilasciato Claude Opus 4.5 a fine novembre 2025 come un modello di classe Opus più efficiente e performante, pensato per l'ingegneria del software professionale, i flussi di lavoro agentici e le attività a lungo termine. È disponibile tramite la piattaforma di sviluppo di Anthropic e tramite CometAPI e introduce nuovi controlli API (in particolare il parametro effort), strumenti di utilizzo del computer migliorati, un approccio di pensiero esteso e miglioramenti dell'efficienza dei token, fondamentali in produzione.

Di seguito è riportata una guida pratica e professionale: cosa è cambiato, come ottenere l'accesso, come utilizzare i nuovi controlli (sforzo, pensiero esteso, utilizzo degli strumenti, utilizzo di file/computer), indicazioni su costi e ottimizzazione, considerazioni su sicurezza/governance e modelli di integrazione nel mondo reale.

Cos'è esattamente Claude Opus 4.5 e perché è importante?

Claude Opus 4.5 è il nuovo membro della famiglia di modelli di classe Opus di Anthropic (rilasciato il 24-25 novembre 2025) che si concentra sulla massima capacità di ragionamento e codifica, migliorando al contempo l'efficienza dei token e offrendo nuovi controlli API per bilanciare costi e completezza. Anthropic posiziona Opus 4.5 come il "modello più intelligente" mai rilasciato, puntando a compiti complessi di ingegneria del software, agenti di lunga durata, automazione di fogli di calcolo/Excel e attività che richiedono un ragionamento multi-step sostenuto.

Quali sono i principali aggiornamenti di Opus 4.5?

Anthropic ha progettato Opus 4.5 per migliorare profondità di ragionamento e agentico comportamento, offrendo agli sviluppatori un maggiore controllo sui compromessi tra costi e latenza. I punti salienti della versione sono:

- Parametro di sforzo (beta): una manopola API di prima classe che controlla quanto "budget di pensiero" Claude spende per una richiesta (comunemente

low,medium,high). Influenza il ragionamento, le chiamate degli strumenti e i token di "pensiero" interni, consentendo di ottimizzare la velocità rispetto alla completezza per ogni chiamata, anziché cambiare modello. Questa è una funzionalità distintiva di Opus 4.5. - Migliore orchestrazione di agenti e strumenti: Maggiore precisione nella scelta degli strumenti, chiamate degli strumenti meglio strutturate e un flusso di lavoro più robusto per la creazione di agenti e pipeline multi-step. Anthropic fornisce documentazione e linee guida SDK per il flusso di "utilizzo degli strumenti".

- Efficienza dei costi/token — Anthropic segnala riduzioni fino al 50% circa nell'utilizzo dei token per alcuni flussi di lavoro rispetto a Sonnet 4.5, oltre a un minor numero di errori di chiamata degli strumenti e di iterazioni per attività di ingegneria complesse.

- Capacità multimodali migliorate: Miglioramenti complessivi nelle prestazioni visive, di ragionamento e matematiche.

- La finestra di contesto è stata ampliata a 200 token, supportando conversazioni lunghe e approfondite e analisi complesse di documenti.

Quali capacità pratiche sono migliorate?

Aggiornamento delle prestazioni

- Migliore orchestrazione di agenti e strumenti: maggiore precisione nella scelta degli strumenti, chiamate degli strumenti meglio strutturate e un flusso di lavoro strumento-risultato più robusto per la creazione di agenti e pipeline multi-step. Anthropic fornisce documentazione e linee guida SDK per il flusso di "utilizzo degli strumenti". Una migliore gestione del contesto, helper di compattazione per lunghe esecuzioni degli agenti e SDK di strumenti di prima classe per la registrazione e la convalida degli strumenti rendono Opus 4.5 più adatto alla creazione di agenti che vengono eseguiti senza supervisione per molti passaggi.

- Capacità multimodali migliorate: miglioramenti complessivi nelle prestazioni visive, di ragionamento e matematiche.

- La finestra di contesto è stata ampliata a 200 token, supportando conversazioni lunghe e approfondite e analisi complesse di documenti.

Coding e lavoro a lungo termine

Opus 4.5 continua a essere basato sui benchmark per le attività di codifica; riduce il numero di iterazioni e gli errori di chiamata degli strumenti durante i lavori lunghi (migrazione del codice, refactoring, debug multi-step). I primi report e la scheda di sistema di Anthropic evidenziano un miglioramento delle prestazioni durature nei benchmark di ingegneria e notevoli miglioramenti in termini di efficienza nelle pipeline basate sugli strumenti.

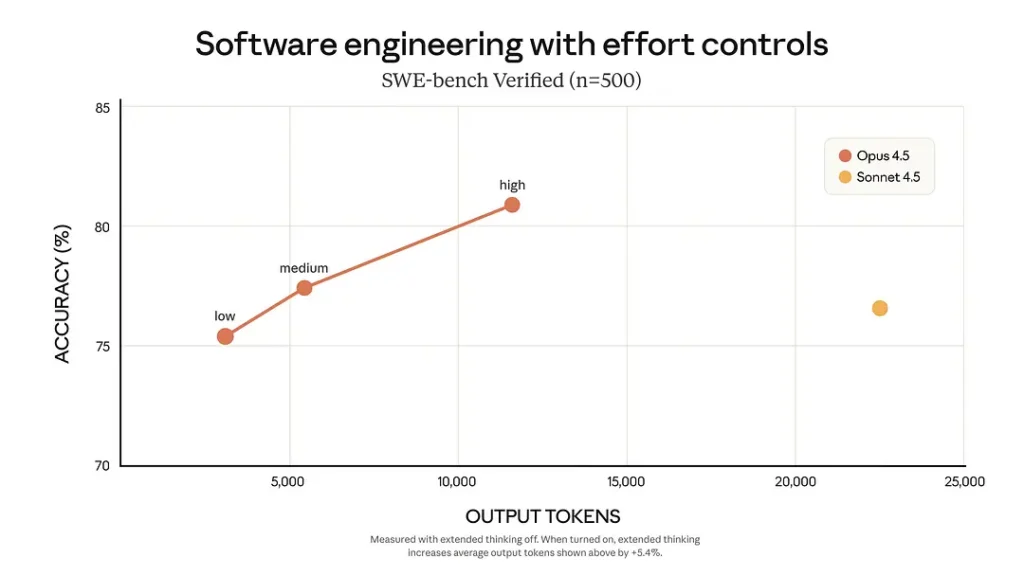

In Panchina SWE, Opus 4.5 registra punteggi elevati nei benchmark di ingegneria del software (Anthropic elenca un 80.9% su SWE-bench Verified nel materiale di lancio) e i clienti segnalano miglioramenti nel debug, nelle modifiche multi-file e nelle attività di codice a lungo termine.

Costo ed efficienza

Anthropic ha progettato Opus 4.5 per migliorare profondità di ragionamento e agentico comportamento, offrendo al contempo agli sviluppatori un maggiore controllo sui compromessi tra costi e latenza:

- Riduzione del prezzo rispetto a opus 4.1: $ 5 (input) / $ 25 (output) per milione di token.

- Miglioramento dell'utilizzo dei token: riduzione media del 50-75% dei consumi mantenendo inalterate le prestazioni.

- una manopola API di prima classe che controlla quanto "budget di pensiero" Claude spende per una richiesta (comunemente

low,medium,high). Influenza il ragionamento, le chiamate degli strumenti e i token di "pensiero" interni, consentendo di ottimizzare la velocità rispetto alla completezza per chiamata, anziché cambiare modello. Questa è una funzionalità distintiva di Opus 4.5 (rispetto a Sonnet 4.5: Sforzo Medio → 76% di token in meno, prestazioni comparabili; Sforzo Alto → miglioramento delle prestazioni del 4.3%, riduzione del 48% nell'utilizzo dei token).

Come posso accedere e utilizzare l'API di Claude Opus 4.5?

Come posso ottenere l'accesso e le chiavi?

- Crea un account sviluppatore Anthropic / Claude. Registrati al portale per sviluppatori Claude/Anthropic e crea una chiave API tramite la Console (per i team sono disponibili flussi organizzativi/amministrativi). L'API Messaggi è l'endpoint principale per le interazioni in stile chat/assistente.

- Partner cloud: Opus 4.5 è disponibile anche tramite i principali marketplace cloud Google Vertex AI, CometaAPI(Una piattaforma di aggregazione API AI, è necessario utilizzare la sua autenticazione)), In CometAPI, puoi accedere all'API Claude opus 4.5 tramite il formato Anthropic Messages e il formato Chat.

Come dovrei autenticare le mie richieste?

Utilizzare token standard bearer: includere un Authorization: Bearer $_API_KEY header con ogni chiamata API. Le richieste sono in formato JSON su HTTPS; l'API Messages accetta un elenco di messaggi strutturati (sistema + utente + assistente).

Avvio rapido — Python (SDK ufficiale)

Installa l'SDK:

pip install anthropic

Esempio minimo (sincrono):

import os

from anthropic import Anthropic

# expects ANTHROPIC_API_KEY in env

client = Anthropic(api_key=os.environ)

resp = client.messages.create(

model="claude-opus-4-5-20251101",

messages=,

max_tokens=512,

)

print(resp.content.text) # SDK returns structured content blocks

Questa chiamata utilizza l'identificatore del modello canonico Opus 4.5. Per gli endpoint gestiti dal provider (Vertex, CometAPI, Foundry), seguire la documentazione del provider per costruire il client e fornire l'URL e la chiave del provider (ad esempio, https://api.cometapi.com/v1/messages per CometAPI).

Avvio rapido — Python (CometAPI)

È necessario accedere a CometAPI e ottenere una chiave.

curl

--location

--request POST 'https://api.cometapi.com/v1/messages' \

--header 'Authorization: Bearer ' \

--header 'Content-Type: application/json' \

--data-raw '{ "model": "claude-opus-4-5-20251101", "max_tokens": 1000, "thinking": { "type": "enabled", "budget_tokens": 1000 }, "messages": }'

Come si usa il nuovo sforzo parametro e pensiero esteso?

Qual è la sforzo parametro e come lo imposto?

. sforzo Il parametro è un controllo API di prima classe introdotto con Opus 4.5 che regola la quantità di elaborazione interna e il budget di token che il modello impiega per produrre il suo output. I valori tipici sono low, mediume highUtilizzalo per bilanciare latenza e costo dei token rispetto alla completezza:

low— risposte rapide ed efficienti in termini di token per l'automazione di grandi volumi e attività di routine.medium— rapporto qualità/costo equilibrato per l'uso produttivo.high— analisi approfondite, ragionamento in più fasi o quando la precisione è più importante.

Antropico introdotto effort per Opus 4.5 (beta). È necessario includere un'intestazione beta (ad esempio, effort-2025-11-24) e specificare output_config: { "effort": "low|medium|high" } (esempio mostrato di seguito). high è il comportamento predefinito. Ridurre lo sforzo riduce l'utilizzo dei token e la latenza, ma può ridurre leggermente la completezza. Utilizzalo per attività ad alta produttività o sensibili alla latenza.

Esempio:

# Example using the beta messages API shown in Anthropic docs

from anthropic import Anthropic

import os

client = Anthropic(api_key=os.getenv("ANTHROPIC_API_KEY"))

response = client.beta.messages.create(

model="claude-opus-4-5-20251101",

betas=, # required beta header

messages=,

max_tokens=1500,

output_config={"effort": "medium"} # low | medium | high

)

print(response)

Quando usare which: uso low per pipeline automatizzate (ad esempio, categorizzazione delle e-mail), medium per gli assistenti standard e high per la generazione di codice, la ricerca approfondita o attività che richiedono un livello di rischio elevato. Anthropic evidenzia questo parametro come un controllo chiave per Opus 4.5.

Nel test SWE-bench:

- In modalità Medium Effort: le prestazioni sono paragonabili a Sonnet 4.5, ma i token di output sono ridotti del 76%;

- In modalità High Effort: le prestazioni superano Sonnet 4.5 di circa 4.3 punti percentuali e i token vengono ridotti del 48%.

Che cos'è il Pensiero Esteso e come posso invocarlo?

Il Pensiero Esteso (chiamato anche "pensiero esteso" o "blocchi di pensiero") consente al modello di eseguire catene di pensiero intermedie o ragionamenti graduali, preservando o riassumendo opzionalmente i blocchi di pensiero interni. L'API Messaggi supporta questo comportamento e Anthropic ha aggiunto controlli per preservare i blocchi di pensiero precedenti, in modo che gli agenti multi-turn possano riutilizzare il ragionamento precedente senza dover ripetere costosi ricalcoli. Utilizzate il pensiero esteso quando l'attività richiede una pianificazione in più fasi, la risoluzione di problemi a lungo termine o l'orchestrazione di strumenti.

Come posso integrare gli strumenti e creare agenti con Opus 4.5?

Uno dei maggiori punti di forza di Opus 4.5 è il miglioramento uso dello strumento: definisci gli strumenti nel tuo client, lascia che Claude decida quando chiamarli, esegui lo strumento e restituisci il tool_result — Claude utilizzerà questi risultati nella sua risposta finale. Anthropic fornisce Agent SDK che consentono di registrare funzioni di strumenti tipizzati (ad esempio, run_shell, call_api, search_docs) che Claude può scoprire e richiamare durante la riflessione estesa. La piattaforma converte le definizioni degli strumenti in funzioni richiamabili che il modello può richiamare e da cui ricevere risultati. In questo modo si creano flussi di lavoro agentici in modo sicuro (con input/output controllati).

Di seguito è riportato un modello pratico e un esempio Python end-to-end.

Modello di utilizzo degli strumenti (concettuale)

- Forniture del cliente

toolsmetadati con nome, descrizione e schema JSON (input_schema). - Il modello restituisce un

tool_usebloccare (l'istruzione strutturata del modello per chiamare uno strumento particolare con input specifici). La risposta APIstop_reasonpuò esseretool_use. - Il client esegue lo strumento (il tuo codice richiama l'API esterna o la funzione locale).

- Il cliente invia un messaggio di follow-up con

role:"user"etool_resultblocco di contenuto contenente gli output dello strumento. - Il modello consuma il risultato dello strumento e restituisce la risposta finale o ulteriori chiamate allo strumento.

Questo flusso consente un controllo sicuro lato client su ciò che il modello esegue (il modello propone chiamate degli strumenti; controlli l'esecuzione).

Esempio end-to-end: Python (semplice strumento meteorologico)

# 1) Define tools metadata and send initial request

from anthropic import Anthropic

import os, json

client = Anthropic(api_key=os.environ)

tools = [

{

"name": "get_weather",

"description": "Return the current weather for a given city.",

"input_schema": {"type":"object","properties":{"city":{"type":"string"}},"required":}

}

]

resp = client.messages.create(

model="claude-opus-4-5-20251101",

messages=,

tools=tools,

max_tokens=800,

)

# 2) Check if Claude wants a tool call

stop_reason = resp.stop_reason # SDK field

if stop_reason == "tool_use":

# Extract the tool call (format varies by SDK; this is schematic)

tool_call = resp.tool_calls # e.g., {"name":"get_weather", "input":{"city":"Tokyo"}}

tool_name = tool_call

tool_input = tool_call

# 3) Execute the tool client-side (here: stub)

def get_weather(city):

# Replace this stub with a real weather API call

return {"temp_c": 12, "condition": "Partly cloudy"}

tool_result = get_weather(tool_input)

# 4) Send tool_result back to Claude

follow_up = client.messages.create(

model="claude-opus-4-5-20251101",

messages=[

{"role":"user", "content":[{"type":"tool_result",

"tool_use_id": resp.tool_use_id,

"content": json.dumps(tool_result)}]}

],

max_tokens=512,

)

print(follow_up.content.text)

else:

print(resp.content.text)

Come si dovrebbero strutturare gli agenti per renderli affidabili?

- Disinfettare gli input degli strumenti (evitare l'iniezione tramite prompt).

- Convalidare gli output dello strumento prima di reimmetterli nel modello (controlli dello schema).

- Limita la portata dello strumento (principio del minimo privilegio).

- Utilizzare strumenti di compattazione (dagli SDK di Anthropic) per mantenere il contesto gestibile anche su lunghe tirature.

Come dovrei progettare i prompt e strutturare i messaggi per Opus 4.5?

Quali ruoli dei messaggi e strategie di precompilazione funzionano meglio?

Utilizzare uno schema in tre parti:

- Sistema (ruolo: sistema): istruzioni globali — tono, guardrail, ruolo.

- Assistant (facoltativo): esempi predefiniti o contenuti di innesco.

- Utente (ruolo: utente): la richiesta immediata.

Precompilare il messaggio di sistema con vincoli (formato, lunghezza, policy di sicurezza, schema JSON se si desidera un output strutturato). Per gli agenti, includere specifiche degli strumenti ed esempi di utilizzo in modo che Opus 4.5 possa richiamare correttamente tali strumenti.

Come posso utilizzare la compattazione del contesto e la memorizzazione nella cache dei prompt per salvare i token?

- Compattazione del contesto: Comprime le parti più vecchie di una conversazione in riassunti concisi che il modello può ancora utilizzare. Opus 4.5 supporta l'automazione per compattare il contesto senza perdere blocchi di ragionamento critici.

- Memorizzazione nella cache dei prompt: risposte del modello di cache per prompt ripetuti (Anthropic fornisce modelli di memorizzazione nella cache dei prompt per ridurre latenza/costi).

Entrambe le funzionalità riducono l'ingombro dei token delle interazioni lunghe e sono consigliate per i flussi di lavoro degli agenti e gli assistenti di produzione di lunga durata.

Gestione degli errori e best practice

Di seguito sono riportati consigli pratici su affidabilità e sicurezza per l'integrazione della produzione con Opus 4.5.

Affidabilità e nuovi tentativi

- Gestire i limiti di velocità (HTTP 429) con backoff esponenziale e jitter (inizia a 500–1000 ms).

- Idempotenza: per le chiamate LLM non mutanti puoi riprovare in sicurezza, ma fai attenzione nei flussi di lavoro in cui il modello attiva effetti collaterali esterni (chiamate di strumenti): deduplica tramite tracciamento

tool_use_ido i tuoi ID di richiesta. - Stabilità dello streaming: gestire flussi parziali e riconnettersi in modo corretto; se si verifica un'interruzione, è preferibile riprovare l'intera richiesta o riprendere a utilizzare lo stato a livello di applicazione per evitare interazioni incoerenti con gli strumenti.

Sicurezza e protezione

- Iniezione rapida e sicurezza degli utensili: mai Consentire al modello di eseguire direttamente comandi shell arbitrari o codice senza convalida. Convalidare sempre gli input degli strumenti e sanificare gli output. Il modello propone chiamate agli strumenti; il codice decide se eseguirle o meno. La scheda di sistema e la documentazione di Anthropic descrivono i vincoli di allineamento e i livelli di sicurezza: seguirli per i domini ad alto rischio.

- Gestione e conformità dei dati: Gestisci i prompt e gli input/output degli strumenti contenenti PII o dati regolamentati in base alle tue policy legali/di conformità. Utilizza i controlli VPC/aziendali del provider se hai requisiti rigorosi di residenza dei dati o di audit (Bedrock/Vertex/Foundry offrono opzioni aziendali).

Osservabilità e controllo dei costi

- Metadati di richiesta/risposta del registro (non contenuto sensibile grezzo a meno che non sia consentito) — conteggi dei token,

effortlivello, latenza, ID modello e provider. Queste metriche sono essenziali per l'attribuzione dei costi e il debug. - Sforzati di controllare il costo per chiamata: prefer

lowsforzo per la sintesi di routine o endpoint QPS elevati; utilizzarehighSforzo per debug o indagini approfondite. Monitora la qualità rispetto al consumo di token per scegliere valori predefiniti per diversi endpoint.

Conclusione: quando (e come) dovresti scegliere Opus 4.5?

Claude Opus 4.5 è la scelta naturale quando il tuo prodotto ha bisogno di:

- ragionamento profondo a più fasi (lunghe catene di logica, ricerca o debug),

- orchestrazione robusta di agenti/strumenti (flussi di lavoro complessi che richiamano API esterne) o

- assistenza al codice di livello produttivo su basi di codice di grandi dimensioni.

Operativamente, utilizzare sforzo Per ottimizzare i budget per chiamata, affidatevi al modello di utilizzo degli strumenti per mantenere la sicurezza di esecuzione e scegliete un partner cloud (o direttamente tramite API di Anthropic) in base alle vostre esigenze di conformità. Eseguite un benchmark con il vostro corpus: i numeri dei fornitori (SWE-bench ecc.) sono indicatori utili, ma il vostro compito reale e i dati determinano il ROI. Per sicurezza, seguite la scheda di sistema Opus 4.5 e ponete delle barriere di sicurezza attorno all'esecuzione degli strumenti e alla gestione dei dati personali identificativi.

Gli sviluppatori possono accedere API di Claude Opus 4.5 tramite CometAPI. Per iniziare, esplora le capacità del modello diCometaAPI nella Parco giochi e consulta la guida API per istruzioni dettagliate. Prima di accedere, assicurati di aver effettuato l'accesso a CometAPI e di aver ottenuto la chiave API. ConeAPI t offrire un prezzo molto più basso rispetto al prezzo ufficiale per aiutarti a integrarti.

Pronti a partire? → Iscriviti oggi a CometAPI !

Se vuoi conoscere altri suggerimenti, guide e novità sull'IA seguici su VK, X e al Discordia!