DeepSeek rilasciato DeepSeek V3.2 e una variante ad alta potenza di calcolo DeepSeek-V3.2-Speciale, con un nuovo motore di attenzione sparsa (DSA), un comportamento migliorato di agenti/strumenti e una modalità "pensante" (catena di pensiero) che fa emergere il ragionamento interno. Entrambi i modelli sono disponibili tramite l'API di DeepSeek (endpoint compatibili con OpenAI) e gli artefatti del modello/report tecnici sono pubblicati pubblicamente.

Che cos'è DeepSeek V3.2?

DeepSeek V3.2 è il successore di produzione della famiglia DeepSeek V3, una grande famiglia di modelli generativi a lungo contesto, progettata esplicitamente per ragionamento prima flussi di lavoro e utilizzo degli agenti. La versione V3.2 consolida i precedenti miglioramenti sperimentali (V3.2-Exp) in una linea di modelli mainstream esposta tramite l'app, l'interfaccia utente web e l'API di DeepSeek. Supporta sia output rapidi e conversazionali sia un'interfaccia dedicata pensiero Modalità (catena di pensiero) adatta per attività di ragionamento in più fasi, come matematica, debug e pianificazione.

Perché la versione V3.2 è importante (breve contesto)

DeepSeek V3.2 è degno di nota per tre motivi pratici:

- Contesto lungo: Fino a 128k finestre di contesto token, il che lo rende adatto per documenti lunghi, contratti legali o ricerche multi-documento.

- Progettazione basata sul ragionamento: Il modello integra la catena di pensiero ("pensiero") nei flussi di lavoro e nell'utilizzo degli strumenti, un passaggio verso app agentiche che necessitano di passaggi di ragionamento intermedi.

- Costi ed efficienza: L'introduzione di DSA (attenzione sparsa) riduce il calcolo per sequenze lunghe, consentendo un'inferenza molto più economica per contesti di grandi dimensioni.

Che cos'è DeepSeek-V3.2-Speciale e in cosa differisce dalla versione base v3.2?

Cosa rende speciale la variante “Speciale”?

DeepSeek V3.2-Speciale è un alta computazione, alto ragionamento Variante della famiglia v3.2. Rispetto alla variante v3.2 bilanciata, Speciale è ottimizzato (e post-addestrato) specificamente per il ragionamento multi-step, la matematica e le attività agentive; utilizza l'apprendimento per rinforzo aggiuntivo tramite feedback umano (RLHF) e una catena di pensiero interna ampliata durante l'addestramento. Tale endpoint temporaneo e l'accesso all'API di Speciale sono stati annunciati come limitati nel tempo (si veda la scadenza dell'endpoint del percorso Speciale, il 15 dicembre 2025).

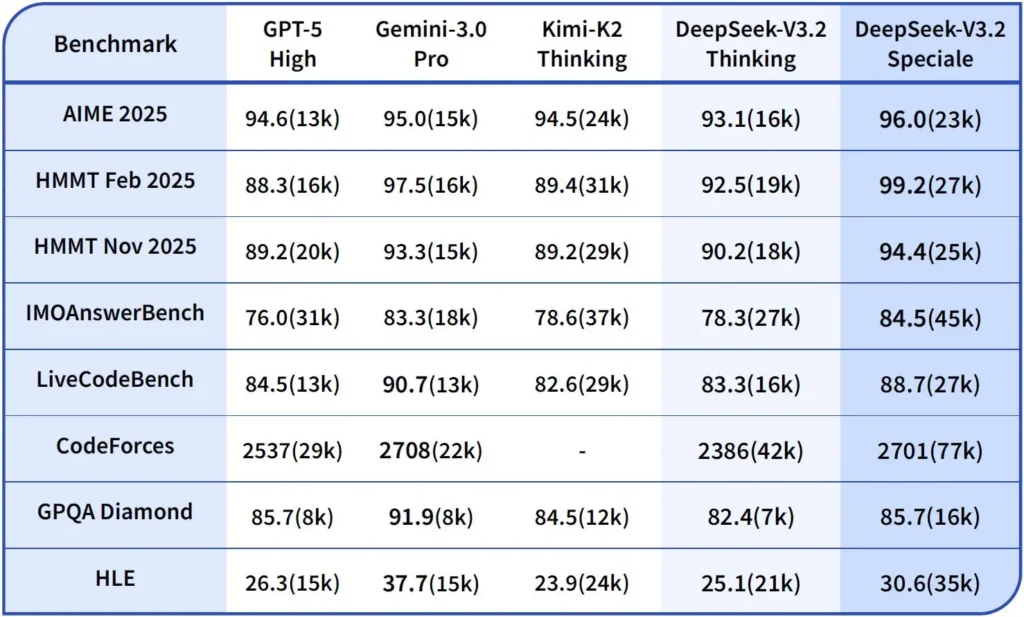

Prestazioni e benchmark

DeepSeek-V3.2-Speciale è la variante ad alta potenza di calcolo e ottimizzata per il ragionamento della V3.2. La versione Speciale integra il precedente modello matematico DeepSeek-Math-V2. Si posiziona come il modello da utilizzare quando il carico di lavoro richiede la più profonda catena di pensiero possibile, risoluzione di problemi in più fasi, ragionamento competitivo (ad esempio, stile olimpico matematico) e orchestrazione agentica complessa.

Può dimostrare teoremi matematici e verificare ragionamenti logici in modo autonomo; ha ottenuto risultati notevoli in numerose competizioni di livello mondiale:

- Medaglia d'oro IMO (Olimpiade Internazionale della Matematica)

- Medaglia d'oro CMO (Olimpiade matematica cinese)

- ICPC (International Computer Programming Contest) 2° posto (concorso umano)

- IOI (Olimpiade Internazionale di Informatica) 10° Posto (Concorso Umano)

Cos'è la modalità ragionamento in DeepSeek v3.2?

DeepSeek espone un esplicito modalità di pensiero/ragionamento che fa sì che il modello produca un Catena di pensiero (CoT) come parte discreta dell'output prima la risposta finale. L'API rende disponibile questo CoT in modo che le applicazioni client possano ispezionarlo, visualizzarlo o distillarlo.

Meccanica: cosa fornisce l'API

reasoning_contentcampo: quando la modalità di pensiero è abilitata la struttura di risposta include unreasoning_contentcampo (il CoT) allo stesso livello della finalecontentCiò consente ai client di accedere programmaticamente ai passaggi interni.- Chiamate di strumenti durante il pensiero: La versione V3.2 dichiara di supportare le chiamate degli strumenti entro il percorso di pensiero: il modello può alternare fasi di ragionamento e invocazioni di strumenti, il che migliora le prestazioni di attività complesse.

Come l'API DeepSeek v3.2 implementa il ragionamento

La versione 3.2 introduce un meccanismo API di catena di ragionamento standardizzato per mantenere una logica di ragionamento coerente nelle conversazioni multi-turn:

- Ogni richiesta di ragionamento contiene un

reasoning_contentcampo all'interno del modello; - Se l'utente desidera che il modello continui a ragionare, questo campo deve essere passato al turno successivo;

- Quando inizia una nuova domanda, la vecchia

reasoning_contentdevono essere ripuliti per evitare contaminazioni logiche; - Il modello può eseguire il ciclo "ragionamento → chiamata strumento → ri-ragionamento" più volte in modalità ragionamento.

Come posso accedere e utilizzare l'API DeepSeek v3.2?

Breve: CometAPI è un gateway in stile OpenAI che espone molti modelli (incluse le famiglie DeepSeek) tramite https://api.cometapi.com/v1 così puoi scambiare i modelli cambiando il model stringa nelle richieste. Registrati su CometAPI e ottieni subito la tua chiave API.

Perché usare CometAPI invece di DeepSeek diretto?

- CometAPI centralizza la fatturazione, i limiti di tariffazione e la selezione del modello (utile se si prevede di cambiare fornitore senza modificare il codice).

- Endpoint diretti di DeepSeek (ad esempio,

https://api.deepseek.com/v1) esistono ancora e talvolta espongono funzionalità specifiche del provider; scegli CometAPI per praticità o l'endpoint diretto del fornitore per i controlli nativi del provider. Verifica quali funzionalità (ad esempio, Speciale, endpoint sperimentali) sono disponibili tramite CometAPI prima di affidarti a esse.

Passaggio A: crea un account CometAPI e ottieni una chiave API

- Vai su CometAPI (registrazione/console) e genera una chiave API (la dashboard in genere mostra

sk-...). Mantienilo segreto. CometaAPI

Passaggio B: conferma il nome esatto del modello disponibile

- Interroga l'elenco dei modelli per confermare l'esatta stringa del modello esposta da CometAPI (i nomi dei modelli possono includere suffissi varianti). Utilizza l'endpoint dei modelli prima di codificare i nomi in modo rigido:

curl -s -H "Authorization: Bearer $COMET_KEY" \

https://api.cometapi.com/v1/models | jq .

Cerca la voce DeepSeek (ad esempio deepseek-v3.2 or deepseek-v3.2-exp) e annotare l'ID esatto. CometAPI espone un /v1/models annuncio.

Passaggio C: effettuare una chiamata chat di base (curl)

sostituire <COMET_KEY> e al deepseek-v3.2 con l'ID modello che hai confermato:

curl https://api.cometapi.com/v1/chat/completions \

-H "Content-Type: application/json" \

-H "Authorization: Bearer <COMET_KEY>" \

-d '{

"model": "deepseek-v3.2",

"messages": [

{"role":"system","content":"You are a helpful assistant."},

{"role":"user","content":"Summarize DeepSeek v3.2 in two sentences."}

],

"max_tokens":300

}'

Si tratta dello stesso schema di chiamata in stile OpenAI: CometAPI inoltra al provider selezionato.

Compatibilità e precauzioni

- Supporta l'abilitazione della modalità Think nell'ambiente Claude Code;

- Nella riga di comando (CLI), inserisci semplicemente il nome del modello deepseek-reasoner;

- Tuttavia, per il momento potrebbe non essere compatibile con strumenti non standard come Cline e RooCode;

- Si consiglia di utilizzare la modalità non-Think per le attività ordinarie e la modalità Think per il ragionamento logico complesso.

Modelli di adozione pratici: alcuni esempi di architetture

1 — Agente di assistenza per i flussi di lavoro degli sviluppatori

- Modalità: Modalità speciale (modalità di pensiero) richiamata per la generazione di codice complesso e la creazione di test; modalità chat veloce per l'assistente in linea.

- Sicurezza: Utilizzare controlli della pipeline CI ed esecuzione di test sandbox per il codice generato.

- hosting: API o self-hosted su vLLM + cluster multi-GPU per contesti di grandi dimensioni.

2 — Analisi dei documenti per i team legali/finanziari

- Modalità: V3.2 con ottimizzazioni DSA a contesto lungo per elaborare contratti lunghi e produrre riepiloghi strutturati ed elenchi di azioni.

- Sicurezza: Approvazione da parte di un avvocato umano per le decisioni a valle; redazione dei dati personali identificativi prima dell'invio agli endpoint ospitati.

3 — Orchestratore autonomo di pipeline di dati

- Modalità: Modalità di pensiero per pianificare attività ETL in più fasi, chiamare strumenti per interrogare database e chiamare test di convalida.

- Sicurezza: Implementare la conferma dell'azione e controlli verificabili prima di qualsiasi operazione irreversibile (ad esempio, scrittura distruttiva nel DB).

Ciascuno dei modelli sopra descritti è oggi realizzabile con i modelli della famiglia V3.2, ma è necessario abbinare il modello a strumenti di verifica e a una governance conservativa.

Come posso ottimizzare costi e prestazioni con la versione 3.2?

Utilizzare deliberatamente le modalità doppie

- Modalità rapida per microinterazioni: utilizzare la modalità strumento non pensante per recuperi brevi, conversioni di formato o chiamate API dirette in cui la latenza è importante.

- Modalità di pensiero per pianificazione e verifica: indirizza attività complesse, agenti multi-azione o decisioni sensibili alla sicurezza alla modalità di pensiero. Cattura i passaggi intermedi ed esegui una verifica (automatica o umana) prima di eseguire azioni critiche.

Quale variante di modello dovrei scegliere?

- deepseek-v3.2 — modello di produzione bilanciato per attività agentive generali.

- deepseek-v3.2-Speciale — variante specializzata per il ragionamento pesante; inizialmente potrebbe essere solo API e utilizzata quando si necessita delle migliori prestazioni possibili di ragionamento/benchmark (e si accettano costi potenzialmente più elevati).

Controlli pratici dei costi e suggerimenti

- Ingegneria dei prompt: mantieni le istruzioni di sistema concise, evita di inviare contesto ridondante. Istruzioni di sistema esplicite: usa prompt di sistema che dichiarano l'intento della modalità: ad esempio, "Sei in modalità PENSIERO: elenca il tuo piano prima di chiamare gli strumenti". Per la modalità strumento, aggiungi vincoli come "Quando interagisci con l'API della calcolatrice, emetti solo JSON con i seguenti campi".

- Chunking + aumento del recupero: utilizza un retriever esterno per inviare solo i segmenti più rilevanti per ogni domanda dell'utente.

- Temperatura e campionamento: abbassare la temperatura nelle interazioni tra strumenti per aumentare il determinismo; aumentarla nelle attività esplorative o di ideazione.

Punto di riferimento e misura

- Trattare gli output come non attendibili finché non vengono verificati: anche gli output di ragionamento possono essere errati. Aggiungere controlli deterministici (test unitari, controlli di tipo) prima di intraprendere azioni irreversibili.

- Eseguire test A/B su un carico di lavoro campione (latenza, utilizzo dei token, correttezza) prima di impegnarsi in una variante. La versione v3.2 ha riportato grandi miglioramenti nei benchmark di ragionamento, ma il comportamento reale dell'app dipende dalla progettazione dei prompt e dalla distribuzione degli input.

Domande frequenti

D: Qual è il metodo consigliato per ottenere CoT dal modello?

A: Usa il deepseek-reasoner modello o set thinking/thinking.type = enabled nella tua richiesta. La risposta include reasoning_content (CoT) e la finale content.

D: Il modello può richiamare strumenti esterni mentre è in modalità di pensiero?

R: Sì, la versione 3.2 ha introdotto la possibilità di utilizzare gli strumenti sia in modalità di pensiero che non di pensiero; il modello può emettere chiamate di strumenti strutturate durante il ragionamento interno. Utilizzo strict modalità e cancellare gli schemi JSON per evitare chiamate non valide.

D: L'utilizzo della modalità di pensiero aumenta i costi?

R: Sì, la modalità di pensiero genera token CoT intermedi, il che aumenta l'utilizzo dei token e quindi i costi. Progetta il tuo sistema in modo che il pensiero venga attivato solo quando necessario.

D:Quali endpoint e URL di base dovrei usare?

A: CometAPI fornisce endpoint compatibili con OpenAI. L'URL di base predefinito è https://api.cometapi.com e l'endpoint primario della chat è /v1/chat/completions (o /chat/completions a seconda dell'URL di base scelto).

D: Per utilizzare la funzione di chiamata degli utensili sono necessari utensili speciali?

R: No, l'API supporta dichiarazioni di funzioni strutturate in JSON. È necessario fornire tools parametro, gli schemi degli strumenti e gestisce il ciclo di vita della funzione JSON nella tua applicazione: ricevi il JSON della chiamata di funzione, esegui la funzione, quindi restituisci i risultati al modello per la continuazione o la chiusura. La modalità di pensiero aggiunge un requisito per passare indietro reasoning_content insieme ai risultati degli strumenti.

Conclusione

DeepSeek V3.2 e DeepSeek-V3.2-Speciale rappresentano una chiara spinta verso aperto, incentrato sul ragionamento LLM che rendono esplicita la catena di pensiero e supportano i flussi di lavoro degli strumenti agentici. Offrono nuove e potenti primitive (DSA, modalità di pensiero, addestramento all'uso degli strumenti) che possono semplificare la creazione di agenti affidabili, a condizione che si tenga conto dei costi dei token, di un'attenta gestione dello stato e dei controlli operativi.

Gli sviluppatori possono accedere API Deepseek v3.2 ecc. tramite CometAPI, l'ultima versione del modello è sempre aggiornato con il sito ufficiale. Per iniziare, esplora le capacità del modello nel Parco giochi e consultare il Guida API per istruzioni dettagliate. Prima di accedere, assicurati di aver effettuato l'accesso a CometAPI e di aver ottenuto la chiave API. CometaAPI offrire un prezzo molto più basso rispetto al prezzo ufficiale per aiutarti a integrarti.

Pronti a partire? → Prova gratuita di deepseek v3.2 !

Se vuoi conoscere altri suggerimenti, guide e novità sull'IA seguici su VK, X e al Discordia!