Google ha annunciato Gemini 3 Flash il 17–18 dicembre 2025 come membro a bassa latenza e conveniente in termini di costi della famiglia Gemini 3. Porta un ragionamento di livello Pro in un’impronta di classe Flash, supporta input multimodali estesi (testo, immagine, audio, video), introduce i controlli thinking_level e della risoluzione dei media, ed è disponibile tramite Google AI Studio, la Gemini API (REST / SDK), Vertex AI, Gemini CLI e come modello predefinito in Google Search / app Gemini.

Che cos’è Gemini 3 Flash e perché è importante

Gemini 3 Flash fa parte dei modelli della serie 3 di Google. È stato progettato per spingere la frontiera di Pareto tra qualità, costo e latenza: offrendo gran parte delle capacità di ragionamento di Gemini 3 Pro pur essendo significativamente più veloce ed economico da eseguire. Questa combinazione lo rende adatto a scenari interattivi ad alta frequenza (chatbot, assistenti IDE, flussi agentici in tempo reale), generazione massiva di contenuti in cui la latenza conta e applicazioni che richiedono ragionamento multimodale (immagini + testo + audio) con basso overhead.

Punti chiave di alto livello:

- È esplicitamente ottimizzato per velocità + basso costo, pur mantenendo un forte ragionamento e fedeltà multimodale (Tre volte più veloce del vecchio Gemini 2.5 Pro; conserva le capacità di inferenza di fascia alta di Gemini 3.).

- È posizionato come il “punto di equilibrio” per cicli agentici e flussi iterativi per sviluppatori (ad es. assistenza al codice, agenti multi-turno).

- Flessibile: può “regolare il proprio tempo di riflessione” in base alla complessità del problema—rispondendo istantaneamente a domande semplici e considerando più passaggi per compiti complessi.

Prestazioni tecniche e risultati dei benchmark

Gemini 3 Flash raggiunge un triplice progresso in velocità, intelligenza e costo:

1) Cicli agentici e comprensione multimodale

Gemini 3 Flash eredita miglioramenti architetturali e di training dalla più ampia famiglia Gemini 3, producendo una forte competenza multimodale (input di testo, immagine, video, audio) e un ragionamento migliorato rispetto ai precedenti modelli Flash. Google presenta Flash come capace di gestire compiti come analisi di documenti (OCR + ragionamento), riassunto video, Q&A immagine+testo e attività di coding multimodale. Questa capacità multimodale, combinata con la bassa latenza, è uno dei principali elementi distintivi tecnici del modello.

Google ha pubblicato dichiarazioni di benchmark interni che evidenziano una forte performance di coding agentico (SWE-bench Verified ~78% per workflow di coding agentico) e Flash si avvicina a un ragionamento di livello Pro in molti compiti, pur rimanendo abbastanza veloce per cicli agentici e workflow quasi in tempo reale.

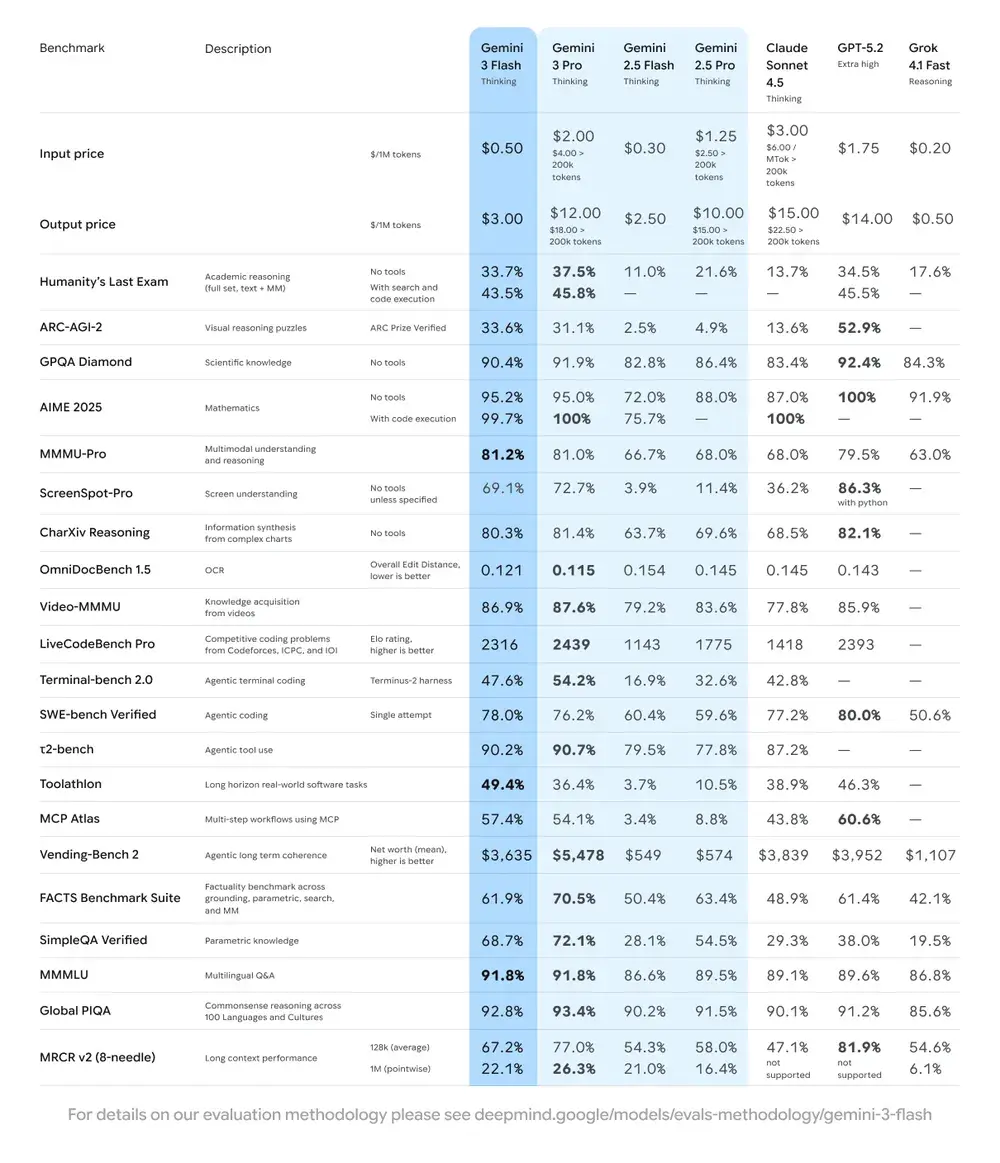

| Benchmark | Punteggio Gemini 3 Flash | Modello di confronto | Miglioramento |

|---|---|---|---|

| GPQA Diamond (ragionamento a livello PhD) | 90.4% | Supera Gemini 2.5 Pro | Significativo |

| Humanity’s Last Exam (test di conoscenza generale) | 33.7% (no tools) | Vicino a Gemini 3 Pro | Ragionamento avanzato |

| MMMU Pro (comprensione multimodale) | 81.2% | Allineato a Gemini 3 Pro | — |

| SWE-bench Verified (benchmark di capacità di coding) | 78% | Superiore a Gemini 3 Pro e alla serie 2.5 | Eccellente |

2) Costo ed efficienza

La filosofia di sviluppo di Gemini 3 Flash è la “Frontiera di Pareto”: ovvero trovare l’equilibrio ottimale tra velocità, qualità e costo. Gemini 3 Flash è esplicitamente ottimizzato per il rapporto prezzo-prestazioni. Google indica prezzi di Flash significativamente inferiori a Pro per attività comparabili e lo posiziona per elaborare grandi volumi di richieste a un costo operativo inferiore. Per molti carichi di lavoro, la variante Flash è pensata come impostazione predefinita economica — ad esempio, prezzi di anteprima di circa $0.50 per 1M token di input e $3.00 per 1M token di output per il tier di anteprima di Flash. In pratica, ciò lo rende adatto a compiti ad alta frequenza in cui il costo per token di Pro sarebbe proibitivo.

Indicatori di efficienza

- Velocità: 3x più veloce di Gemini 2.5 Pro (basato sui test di Artificial Analysis).

- Efficienza dei token: utilizza in media il 30% di token in meno per completare lo stesso compito. In altre parole, ottieni risultati più veloci e migliori allo stesso costo.

- Gemini 3 Flash presenta una “Modalità di pensiero dinamica”—adattando la profondità del ragionamento alla complessità del compito, “pensando un po’ di più” quando serve e rispondendo rapidamente per attività semplici.

Implicazioni pratiche: Un costo per token o per chiamata inferiore significa poter eseguire più query, contesti più lunghi o tassi di campionamento più alti con lo stesso budget. I guadagni di efficienza possono anche ridurre la complessità dell’infrastruttura (meno istanze “calde” necessarie) e migliorare le garanzie sui tempi di risposta.

3) Benchmark di prestazioni

Gemini 3 Flash raggiunge prestazioni “di frontiera” su diversi benchmark accademici e applicativi, offrendo al contempo una latenza e un costo migliori rispetto ai modelli Pro precedenti. Google presenta numeri come punteggi elevati su benchmark di ragionamento complesso e conoscenza (ad es., varianti GPQA) per illustrarne la competenza.

Come usare l'API di Gemini 3 Flash?

Quale metodo di accesso dovrei usare?

- Consigliato (semplice + robusto): Usa il pattern di integrazione SDK mostrato da Comet — punta semplicemente un SDK GenAI esistente all’URL di base di Comet e fornisci la tua chiave API Comet. Questo evita di dover replicare da solo l’analisi delle richieste/stream.

- Alternativo (HTTP raw / curl / stack personalizzati): Puoi effettuare POST direttamente agli endpoint CometAPI (Comet accetta formati in stile OpenAI o specifici del provider). Usa

Authorization: Bearer <sk-...>(gli esempi di Comet usano un header Bearer) e la stringa del modellogemini-3-flashnel body. Conferma percorso esatto e parametri di query nella documentazione API di Comet per il modello desiderato.

Riepilogo rapido — cosa farai

- Registrati su CometAPI e crea un token API.

- Scegli un metodo di accesso (consigliato: pattern wrapper SDK mostrato sotto; alternativa: HTTP/cURL raw).

- Chiama il modello

gemini-3-flashtramite l’URL di base di CometAPI (Comet indirizza la tua richiesta al backend Gemini di Google). - Gestisci streaming / function-calls / input multimodali secondo i requisiti del modello (dettagli sotto).

Di seguito un esempio compatto (basato sui pattern di esempio di CometAPI) che mostra come chiamare gemini-3-flash tramite CometAPI; sostituisci <YOUR_COMETAPI_KEY> con la tua chiave reale. L’ID del modello e gli endpoint sotto corrispondono alla documentazione di CometAPI.

from google import genaiimport os# Get your CometAPI key from https://api.cometapi.com/console/token, and paste it hereCOMETAPI_KEY = os.environ.get("COMETAPI_KEY") or "<YOUR_COMETAPI_KEY>"BASE_URL = "https://api.cometapi.com"client = genai.Client( http_options={"api_version": "v1beta", "base_url": BASE_URL}, api_key=COMETAPI_KEY,)response = client.models.generate_content( model="gemini-3-flash", contents="Explain how AI works in a few words",)print(response.text)

Parametri di richiesta chiave da considerare

thinking_level— controlla la profondità del ragionamento interno:MINIMAL,LOW,MEDIUM,HIGH. UsaMINIMALper la latenza più bassa e il costo minimo quando non serve un ragionamento multi-step profondo.media_resolution— per input di visione/video:low,medium,high,ultra_high. Una risoluzione più bassa riduce l’equivalenza in token e la latenza.streamGenerateContentvsgenerateContent— usa lo streaming per una latenza percepita migliore quando vuoi risposte parziali man mano che arrivano.- Function calling / JSON Mode — usa risposte strutturate quando servono output leggibili da macchina.

Invio di input multimodali (indicazioni pratiche)

- Immagini/PDF: preferisci URI Cloud Storage (gs://) per media di grandi dimensioni; molte API accettano base64 per immagini piccole. Attenzione alla contabilità dei token per le modalità — i PDF possono rientrare nei contingenti immagine/documento a seconda dell’endpoint.

- Video/audio: per clip brevi puoi passare URI; per media lunghi usa workflow di elaborazione batch o invia in chunk. Controlla dimensioni massime di input e vincoli di codifica nella documentazione API.

- Function calling / tools: usa schemi di funzione strutturati per ottenere output JSON e abilitare invocazioni di strumenti in sicurezza. Gemini 3 Flash supporta lo streaming delle chiamate a funzione per un’esperienza utente migliorata.

Dove posso accedere a Gemini 3 Flash?

Gemini 3 Flash è disponibile sulle superfici consumer e developer di Google:

- Google Search e l’app Gemini — Flash è stato distribuito come modello predefinito per la modalità AI in Search ed è integrato nell’esperienza dell’app Gemini per gli utenti finali.

- Google AI Studio — luogo immediato per gli sviluppatori per sperimentare e generare chiavi API per i test.

- Gemini API (Generative Language / AI Developer API) — disponibile come

gemini-3-flash-preview(ID modello usato in documenti/note di rilascio) e tramite gli endpoint standard generateContent / streamGenerateContent. - Vertex AI (Google Cloud) — accesso di livello produzione tramite le API dei modelli di Generative AI di Vertex AI e pricing/quote adatti ai carichi enterprise.

- Gemini CLI — per sviluppo da terminale e workflow di scripting.

Gateway di terze parti CometAPI

CometAPI ha già aggiunto gemini-3-flash al suo catalogo, e la sua pagina del modello spiega come chiamarlo tramite l’endpoint unificato di CometAPI. L’API del modello fornita è prezzata al 20% del prezzo ufficiale.

Quali sono le best practice quando si usa Gemini 3 Flash?

1) Scegli thinking_level per attività e affinalo

- Imposta

MINIMAL/LOWper Q&A semplici e compiti interattivi ad alta frequenza. - Usa

MEDIUM/HIGHin modo selettivo per attività che richiedono chain-of-thought più profonde o pianificazione multi-step. - Valuta con benchmark costo vs qualità quando cambi

thinking_level. La documentazione di Google avverte chethinking_levelmodifica le firme di pensiero interne e la latenza.

2) Usa media_resolution per controllare il carico di calcolo visivo

Se passi immagini o video, scegli la media_resolution minima accettabile per il compito; ad esempio, usa low per miniature ed estrazioni massive, high per critique di design visivo. Questo riduce l’equivalenza in token per le immagini e abbassa la latenza.

3) Preferisci output strutturati per l’automazione

Usa la JSON Mode / function calling quando la tua applicazione necessita di output leggibili da macchina (ad es., estrazione di entità, invocazione di strumenti). Questo semplifica notevolmente l’elaborazione a valle. Imposta schemi JSON rigorosi dove possibile e valida lato client.

4) Fai ampio uso dello streaming per risposte lunghe

streamGenerateContent riduce la latenza percepita e consente il rendering progressivo dell’interfaccia. Per compiti multimodali lunghi, esegui lo streaming di output parziali così che gli utenti vedano progressi immediati.

5) Controlla i costi con caching e gestione del contesto

- Usa il caching del contesto per riferimenti ripetuti (pricing e token differiscono tra modelli).

- Evita di inviare contesti lunghi non necessari—preferisci prompt concisi e usa retrieval + grounding per basi di conoscenza estese.

Scenari d’uso tipici per Gemini 3 Flash

Agenti conversazionali ad alto volume

Flash è una scelta naturale per chatbot e assistenti di supporto clienti che richiedono bassa latenza e basso costo per inferenza. Con supporto allo streaming e alti token/sec, Flash riduce i tempi di attesa percepiti e i costi operativi.

Assistenti multimodali e pipeline documentali

Poiché Flash gestisce bene immagini, PDF e video brevi, applicazioni comuni includono estrazione da fatture, Q&A multimodale su manuali, supporto clienti con immagini e ingestione di PDF per basi di conoscenza.

Analisi video in tempo reale e moderazione

L’elevata velocità di output riportata (≈218 t/s nei test pre-release) abilita analisi e riassunti quasi in tempo reale di video brevi, rilevamento di highlight e pipeline di moderazione di contenuti live se adeguatamente architettate.

Strumenti per sviluppatori agentici e assistenza al coding

I punteggi SWE-bench e le prestazioni di coding riportate rendono Flash una buona opzione per assistenti di coding veloci, helper CLI e altri workflow per sviluppatori che danno priorità alla bassa latenza.

Conclusione — dovresti adottare Gemini 3 Flash ora?

Gemini 3 Flash è un’offerta strategica per team che necessitano di forte ragionamento e intelligenza multimodale senza la latenza e i costi dei modelli Pro di fascia alta. Il modello è particolarmente adatto ad assistenti di coding agentici, agenti multimodali interattivi, pipeline di elaborazione documentale e a qualsiasi sistema in cui bassa latenza e scalabilità sono priorità. Prime valutazioni (sia di Google che di analisi indipendenti) indicano che Flash è competitivo in qualità offrendo al contempo notevoli vantaggi in throughput e costo.

Per iniziare, esplora le funzionalità di Gemini 3 Flash nel Playground e consulta la guida API per istruzioni dettagliate. Prima di accedere, assicurati di aver effettuato l’accesso a CometAPI e di aver ottenuto la chiave API. CometAPI offre un prezzo molto inferiore al prezzo ufficiale per aiutarti nell’integrazione.

Pronti a partire?→ Prova gratuita di Gemini 3 Flash !