L'API Llama 4 è una potente interfaccia che consente agli sviluppatori di integrare Metagli ultimi modelli linguistici multimodali di grandi dimensioni, che consentono funzionalità avanzate di elaborazione di testo, immagini e video in varie applicazioni.

Panoramica della serie Llama 4

La serie Llama 4 di Meta introduce modelli di intelligenza artificiale all'avanguardia progettati per elaborare e tradurre vari formati di dati, tra cui testo, video, immagini e audio, migliorando così la versatilità nelle applicazioni. La serie include:

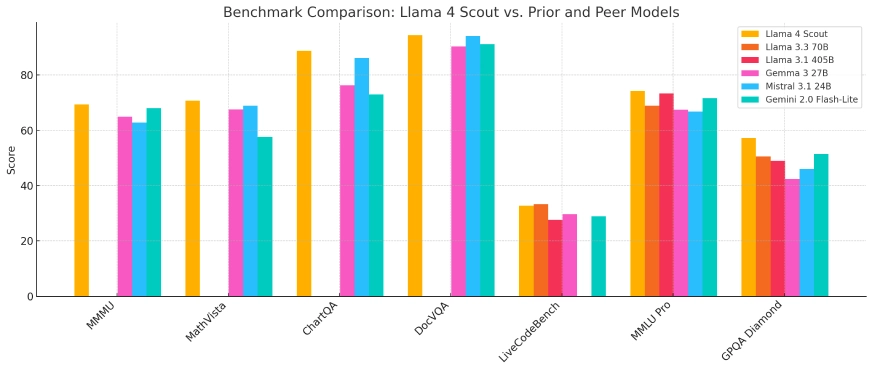

- Lama 4 Esploratore: Un modello compatto ottimizzato per l'implementazione su una singola GPU Nvidia H100, con una finestra di contesto da 10 milioni di token. Supera i concorrenti come Gemma 3 e Mistral 3.1 di Google in vari benchmark.

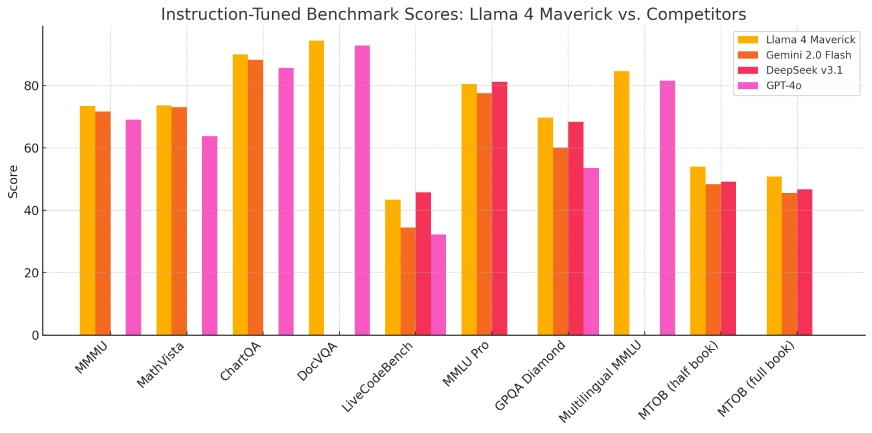

- Lama 4 Maverick: Un modello più grande, paragonabile nelle prestazioni a GPT-4o e DeepSeek-V3 di OpenAI nelle attività di codifica e ragionamento, ma che utilizza meno parametri attivi.

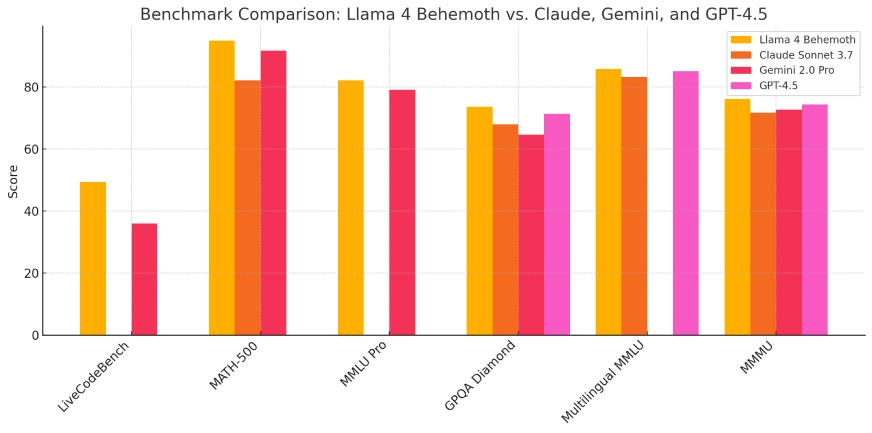

- Lama 4 Behemoth:Attualmente in fase di sviluppo, questo modello vanta 288 miliardi di parametri attivi e un totale di 2 trilioni, con l'obiettivo di superare modelli come GPT-4.5 e Claude Sonnet 3.7 nei benchmark STEM.

Questi modelli sono integrati nell'assistente AI di Meta su piattaforme come WhatsApp, Messenger, Instagram e il web, migliorando le interazioni degli utenti con funzionalità AI avanzate.

| Modello | Parametri totali | Parametri attivi | Esperti | Lunghezza del contesto | Gira su | Accesso pubblico | Ideale per |

|---|---|---|---|---|---|---|---|

| esploratore | 109B | 17B | 16 | 10 milioni di token | Singolo Nvidia H100 | ✅ Sì | Attività di intelligenza artificiale leggere, app a contesto lungo |

| Maverick | 400B | 17B | 128 | Non specificato | Singola o Multi-GPU | ✅ Sì | Ricerca, applicazioni aziendali, codifica |

| Behemoth | ~ 2T | 288B | 16 | Non specificato | Meta infrastruttura interna | No | Formazione e benchmarking del modello interno |

Architettura tecnica e innovazioni

La serie Llama 4 impiega un'architettura "mixture of experts" (MoE), un approccio innovativo che ottimizza l'utilizzo delle risorse attivando solo sottoinsiemi rilevanti dei parametri del modello durante attività specifiche. Questa progettazione migliora l'efficienza computazionale e le prestazioni, consentendo ai modelli di gestire attività complesse in modo più efficace.

L'addestramento di questi modelli ha richiesto notevoli risorse computazionali. Meta ha utilizzato un cluster GPU composto da oltre 100,000 chip Nvidia H100, che rappresenta una delle più grandi infrastrutture di addestramento AI fino ad oggi. Questa ampia potenza computazionale ha facilitato lo sviluppo di modelli con capacità e metriche di prestazioni migliorate.

Evoluzione rispetto ai modelli precedenti

Basandosi sulle fondamenta gettate dalle iterazioni precedenti, la serie Llama 4 rappresenta un'evoluzione significativa nello sviluppo del modello AI di Meta. L'integrazione delle capacità di elaborazione multimodale e l'adozione dell'architettura MoE affrontano le limitazioni osservate nei modelli precedenti, come le sfide nel ragionamento e nei compiti matematici. Questi progressi posizionano Llama 4 come un formidabile concorrente nel panorama dell'AI.

Indicatori di performance e tecnici di riferimento

Nelle valutazioni di benchmark, Llama 4 Scout ha dimostrato prestazioni superiori rispetto a modelli come Gemma 3 e Mistral 3.1 di Google, in particolare in attività che richiedono un'elaborazione di contesto estesa. Llama 4 Maverick ha mostrato capacità alla pari con modelli leader come GPT-4o di OpenAI, in particolare in attività di codifica e ragionamento, mantenendo al contempo un utilizzo dei parametri più efficiente. Questi risultati sottolineano l'efficacia dell'architettura MoE e l'ampio regime di addestramento impiegato.

Lama 4 Esploratore

Lama 4 Maverick

Lama 4 Behemoth:

Scenari di applicazione

La versatilità della serie Llama 4 consente la sua applicazione in diversi ambiti:

- Social Media Integration: Migliorare le interazioni degli utenti su piattaforme come WhatsApp, Messenger e Instagram attraverso funzionalità avanzate basate sull'intelligenza artificiale, tra cui consigli sui contenuti migliorati e agenti conversazionali.

- Creazione di contenuti: Assistere i creatori nella generazione di contenuti multimodali di alta qualità elaborando e sintetizzando testo, immagini e video, semplificando così il processo creativo.

- Strumenti educativi: Facilitare lo sviluppo di sistemi di tutoraggio intelligenti in grado di interpretare e rispondere a vari formati di dati, offrendo un'esperienza di apprendimento più coinvolgente.

- business Analytics: Consentire alle aziende di analizzare e interpretare set di dati complessi, tra cui informazioni testuali e visive, per ricavare informazioni fruibili e informare i processi decisionali.

L'integrazione dei modelli Llama 4 nelle piattaforme Meta esemplifica la loro utilità pratica e il potenziale per migliorare l'esperienza utente in diverse applicazioni.

Considerazioni etiche e strategia open source

Mentre Meta promuove la serie Llama 4 come open source, i termini di licenza includono restrizioni per le entità commerciali con oltre 700 milioni di utenti. Questo approccio ha suscitato critiche da parte dell'Open Source Initiative, evidenziando il dibattito in corso riguardo all'equilibrio tra accesso aperto e interessi commerciali nello sviluppo dell'IA.

L'ingente investimento di Meta, che si dice possa arrivare fino a 65 miliardi di dollari in infrastrutture di intelligenza artificiale, sottolinea l'impegno dell'azienda nel migliorare le capacità di intelligenza artificiale e nel mantenere un vantaggio competitivo nel panorama in rapida evoluzione dell'intelligenza artificiale.

Conclusione

L'introduzione della serie Llama 4 di Meta segna un progresso fondamentale nell'intelligenza artificiale, mostrando miglioramenti significativi nell'elaborazione multimodale, nell'efficienza e nelle prestazioni. Attraverso progetti architettonici innovativi e investimenti computazionali sostanziali, questi modelli stabiliscono nuovi parametri di riferimento nelle capacità dell'IA. Mentre Meta continua a integrare questi modelli nelle sue piattaforme ed esplorare ulteriori sviluppi, la serie Llama 4 è pronta a svolgere un ruolo cruciale nel plasmare la futura traiettoria delle applicazioni e dei servizi di IA.

Come chiamare Llama 4 API da CometAPI

1.Accesso a cometapi.comSe non sei ancora un nostro utente, registrati prima

2.Ottieni la chiave API delle credenziali di accesso dell'interfaccia. Fai clic su "Aggiungi token" nel token API nel centro personale, ottieni la chiave del token: sk-xxxxx e invia.

-

Ottieni l'URL di questo sito: https://api.cometapi.com/

-

Selezionare Llama 4 (Nome modello: lama-4-non conformista; lama-4-scout) endpoint per inviare la richiesta API e impostare il corpo della richiesta. Il metodo di richiesta e il corpo della richiesta sono ottenuti da il nostro documento API del sito webPer vostra comodità, il nostro sito web fornisce anche il test Apifox.

- Per informazioni sul modello lanciato in Comet API, vedere https://api.cometapi.com/new-model.

- Per informazioni sul prezzo del modello in Comet API, vedere https://api.cometapi.com/pricing

| Categoria | lama-4-non conformista | lama-4-scout |

| Prezzi dell'API | Input token: $0.48/M token | Input token: $0.216/M token |

| Token di output: $ 1.44/M di token | Token di output: $ 1.152/M di token |

- Elabora la risposta API per ottenere la risposta generata. Dopo aver inviato la richiesta API, riceverai un oggetto JSON contenente il completamento generato.