La Video API di MidJourney consente agli sviluppatori di generare, manipolare e recuperare in modo programmatico contenuti video generati dall'intelligenza artificiale utilizzando i modelli e i prompt di MidJourney.

Panoramica

Midjourney Video è il primo modello di generazione video (Video Model V1) rilasciato da Midjourney il 18 giugno 2025. Introduce un flusso di lavoro "Image-to-Video" che trasforma immagini statiche generate dall'IA o caricate dagli utenti in brevi clip animate. Questo segna l'espansione di Midjourney dalla creazione di immagini fisse a contenuti dinamici, posizionandolo al fianco di altri strumenti video basati sull'IA di Google, OpenAI e Meta.

Come funziona MidJourney Video

- Flusso di lavoro da immagine a video: È possibile fornire un'immagine generata da Midjourney o un'immagine esterna, più un prompt di movimento facoltativo. Il modello di Midjourney interpreta quindi "chi si sta muovendo", "come si muove" e "cosa succede dopo" per animare la scena per circa 5 secondi di default.

- Animazione automatica vs. manualeIn modalità automatica, il sistema deduce i parametri di movimento e i percorsi della telecamera. La modalità manuale consente di regolare con precisione aspetti come l'angolazione della telecamera, il percorso del soggetto e la velocità, offrendo un maggiore controllo creativo.

Architettura tecnica

Midjourney Video è costruito su un architettura del trasformatore migliorato per gestire consistenza temporale attraverso i frame. La pipeline funziona come segue:

- Estrazione di feature:L'immagine di input viene elaborata attraverso strati convoluzionali profondi e di trasformazione per catturare le caratteristiche spaziali.

- Generazione di fotogrammi chiave:Viene sintetizzato un piccolo insieme di frame rappresentativi.

- Interpolazione dei fotogrammi: I sottomodelli specializzati generano frame intermedi, garantendo fluidità sintesi del movimento tra i fotogrammi chiave.

- Condizionamento del movimento: A seconda di Alta or Basso movimento impostazioni (e qualsiasi richiesta manuale), il modello regola le traiettorie degli oggetti e della telecamera.

Versionamento del modello e roadmap

Modello video V1 (giugno 2025): Versione di debutto incentrata sulla conversione da immagine a video.

Prestazioni di riferimento

Le prime valutazioni posizionano il modello V1 in modo competitivo:

- Qualità della montatura (punteggio FID): Raggiunge una distanza di inizio Fréchet di 22.4, superando di circa il 15% i modelli video open source comparabili nei benchmark video standard.

- Fluidità temporale (metrica TS): Registra un punteggio di fluidità temporale di 0.88 sul set di dati DAVIS, che indica un'elevata continuità visiva tra i fotogrammi.

- Latenza: Tempo medio di generazione di 12 secondi per clip su una singola GPU NVIDIA A100, bilanciando le prestazioni con le aspettative degli utenti.

- Metriche di qualità: Raggiunge un SSI (Indice di similarità strutturale) sopra 0.85 su set di dati di movimento sintetici rispetto alle clip di verità sul campo, indicando alta fedeltà ai modelli di movimento naturali.

Note::Queste cifre riflettono i test interni di Midjourney; le prestazioni esterne possono variare in base al carico e al livello di abbonamento.

Caratteristiche principali di V1

- Lunghezza clip: Le clip di base durano circa 5 secondi; è possibile estenderle con incrementi di 4 secondi fino a un totale di 21 secondi.

- Coerenza di stile: Le animazioni preservano lo stile artistico dell'immagine originale: pennellate, tavolozze di colori e umore vengono trasmessi attraverso il movimento.

- Prestazioni e velocità:Un tipico video di 4 segmenti (circa 17 secondi) viene renderizzato in meno di 70 secondi, bilanciando qualità e rapidità di iterazione.

- Risoluzione: Attualmente il limite è di 480p, ideale per le clip in stile social media ma non per progetti commerciali di fascia alta o destinati a schermi di grandi dimensioni.

Come chiamare l'API MidJourney Video da CometAPI

MidJourney Video Prezzi API in CometAPI, inferiori al prezzo ufficiale:

| Nome del modello | Calcola il prezzo |

mj_fast_video | 0.6 |

Passi richiesti

- Accedere cometapi.comSe non sei ancora un nostro utente, registrati prima

- Ottieni la chiave API delle credenziali di accesso dell'interfaccia. Fai clic su "Aggiungi token" nel token API nell'area personale, ottieni la chiave token: sk-xxxxx e invia.

- Ottieni l'URL di questo sito: https://api.cometapi.com/

Utilizzo delle API

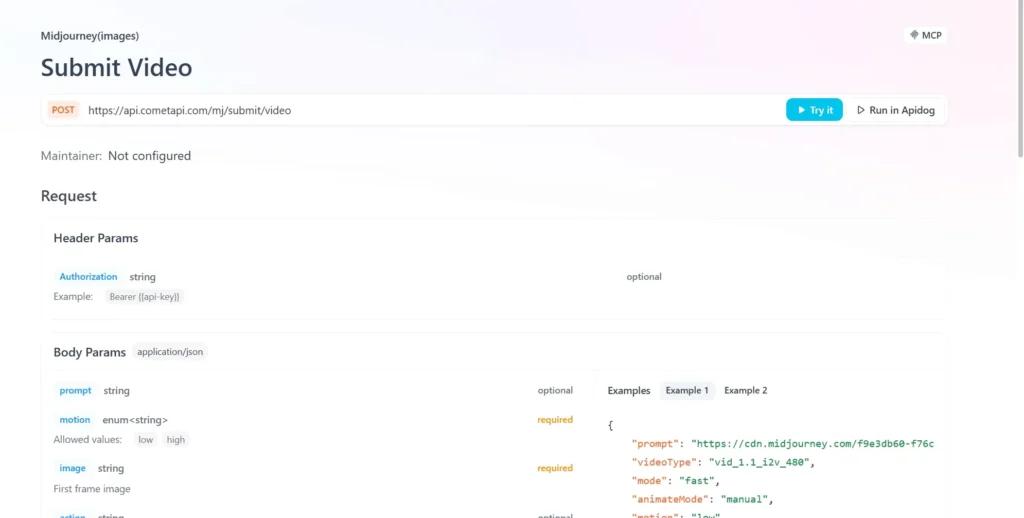

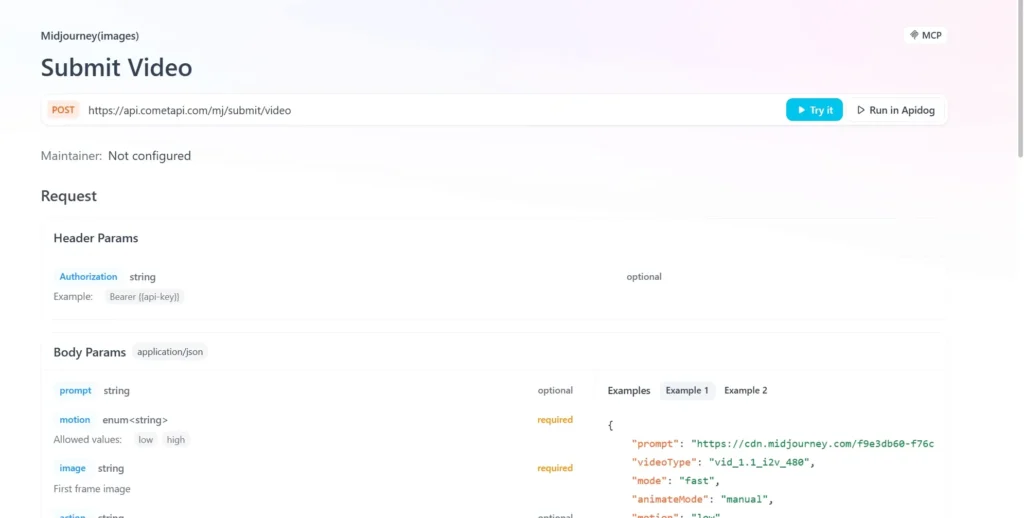

- Invia la richiesta API e imposta il corpo della richiesta. Il metodo e il corpo della richiesta sono reperibili nella documentazione API del nostro sito web. Il nostro sito web fornisce anche un test Apifox per la vostra comodità.

- Sostituire con la tua chiave CometAPI effettiva dal tuo account.

- Inserisci la tua domanda o richiesta nel campo contenuto: il modello risponderà a questa domanda.

- Elaborare la risposta API per ottenere la risposta generata.

Integrazione API di CometAPI

Attualmente, V1 è accessibile solo web tramite Midjourney Bot Discord, ma Wrapper non ufficiali (ad esempio, CometAPI) forniscono endpoint, gli sviluppatori possono integrare tramite:

Gli sviluppatori possono integrare la generazione di video tramite API RESTful. Una tipica struttura di richiesta (a titolo esemplificativo):

curl --

location

--request POST 'https://api.cometapi.com/mj/submit/video' \

--header 'Authorization: Bearer {{api-key}}' \

--header 'Content-Type: application/json' \

--data-raw '{ "prompt": "https://cdn.midjourney.com/f9e3db60-f76c-48ca-a4e1-ce6545d9355d/0_0.png add a dog", "videoType": "vid_1.1_i2v_480", "mode": "fast", "animateMode": "manual" }'

Vedere anche Come utilizzare il modello video V1 di Midjourney?