Gemini 3 Pro (Preview) è il nuovo modello di punta multimodale per il ragionamento di Google/DeepMind della famiglia Gemini 3. È presentato come il loro “modello più intelligente finora”, progettato per ragionamento profondo, flussi di lavoro basati su agenti, coding avanzato e comprensione multimodale su contesti lunghi (testo, immagini, audio, video, codice e integrazioni di strumenti).

Caratteristiche principali

- Modalità: testo, immagine, video, audio, PDF (e output strutturati degli strumenti).

- Agentico/strumentazione: invocazione di funzioni integrata, ricerca come strumento, esecuzione di codice, contesto da URL e supporto per l’orchestrazione di agenti multi‑passo. Il meccanismo di thought‑signature preserva il ragionamento multi‑passo tra chiamate.

- Coding & “vibe coding”: ottimizzato per generazione front‑end, generazione di UI interattive e coding agentico (è in cima alle classifiche pertinenti riportate da Google). È promosso come il loro modello di “vibe‑coding” più forte finora.

- Nuovi controlli per sviluppatori:

thinking_level(low|high) per bilanciare costo/latenza rispetto alla profondità del ragionamento, emedia_resolutioncontrolla la fedeltà multimodale per immagine o fotogramma video. Questi aiutano a bilanciare prestazioni, latenza e costo.

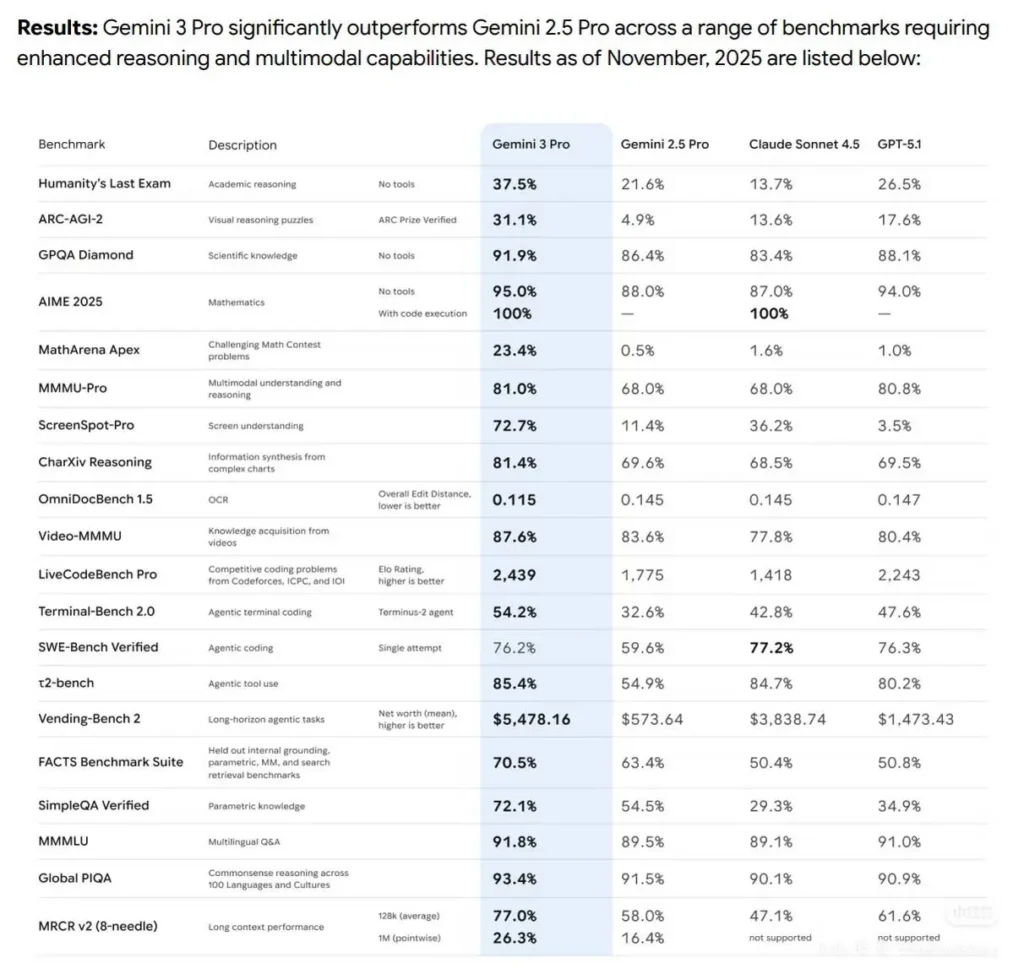

Prestazioni nei benchmark

- Gemini3Pro ha ottenuto il primo posto in LMARE con un punteggio di 1501, superando i 1484 punti di Grok-4.1-thinking e precedendo anche Claude Sonnet 4.5 e Opus 4.1.

- Ha inoltre raggiunto il primo posto nell’arena di programmazione WebDevArena con un punteggio di 1487.

- In Humanity’s Last Exam (ragionamento accademico) ha ottenuto il 37.5% (senza strumenti); in GPQA Diamond (scienza), 91.9%; e nella competizione matematica MathArena Apex, 23.4%, stabilendo un nuovo record.

- Nelle capacità multimodali, su MMMU-Pro ha raggiunto l’81%; e nella comprensione video su Video-MMMU, 87.6%.

Dettagli tecnici e architettura

- Parametro “Thinking level”: Gemini 3 espone il controllo

thinking_levelche permette agli sviluppatori di bilanciare la profondità del ragionamento interno rispetto a latenza/costo. Il modello interpretathinking_levelcome una concessione relativa per il ragionamento interno multi‑passo, più che una garanzia rigorosa di token. Il valore predefinito per Pro è tipicamentehigh. Si tratta di un nuovo controllo esplicito che consente agli sviluppatori di regolare la pianificazione multi‑passo e la profondità della catena di pensiero. - Output strutturati e strumenti: il modello supporta output JSON strutturati e può essere combinato con strumenti integrati (grounding tramite Google Search, contesto da URL, esecuzione di codice, ecc.). Alcune funzionalità di output strutturato + strumenti sono disponibili solo in anteprima per

gemini-3-pro-preview. - Integrazioni multimodali e agentiche: Gemini 3 Pro è esplicitamente costruito per flussi di lavoro agentici (strumentazione + agenti multipli su codice/terminali/browser).

Limitazioni e avvertenze note

- Fattualità non perfetta — le allucinazioni restano possibili. Nonostante i forti miglioramenti nella fattualità dichiarati da Google, la verifica basata su fonti e la revisione umana sono ancora necessarie in contesti ad alto rischio (legale, medico, finanziario).

- Prestazioni su contesti lunghi variabili a seconda del compito. Il supporto per una finestra di input da 1M è una capacità intrinseca, ma l’efficacia empirica può diminuire su alcuni benchmark a lunghezze estreme (declini puntuali osservati a 1M in alcuni test su contesti lunghi).

- Compromessi tra costo e latenza. Contesti ampi e impostazioni

thinking_levelpiù alte aumentano calcolo, latenza e costo; si applicano livelli di prezzo in base ai volumi di token. Usathinking_levele strategie di suddivisione in blocchi per gestire i costi. - Sicurezza e filtri dei contenuti. Google continua ad applicare politiche di sicurezza e livelli di moderazione; alcuni contenuti e azioni restano limitati o attiveranno modalità di rifiuto.

Confronto ad alto livello (preview → qualitativo):

Rispetto a Gemini 2.5 Pro: miglioramenti di ordine superiore nel ragionamento, nell’uso di strumenti agentici e nell’integrazione multimodale; gestione di contesti molto più ampi e migliore comprensione dei testi lunghi. DeepMind mostra incrementi costanti nel ragionamento accademico, nel coding e nelle attività multimodali.

Rispetto a GPT-5.1 e Claude Sonnet 4.5 (come riportato): sulla suite di benchmark di Google/DeepMind, Gemini 3 Pro è presentato come leader su diverse metriche agentiche, multimodali e di lungo contesto (vedi Terminal-Bench, MMMU-Pro, AIME). I risultati comparativi variano a seconda del compito.

Casi d’uso tipici e di alto valore

- Sintesi di grandi documenti/libri e Q&A: il supporto a lunghi contesti lo rende interessante per team legali, di ricerca e compliance.

- Comprensione e generazione di codice alla scala di repository: l’integrazione con toolchain di coding e il ragionamento migliorato facilitano refactoring di grandi codebase e flussi di revisione del codice automatizzati.

- Assistenti di prodotto multimodali: flussi immagine + testo + audio (assistenza clienti che elabora screenshot, estratti di chiamate e documenti).

- Generazione e modifica di media (foto → video): le funzionalità precedenti della famiglia Gemini includono ora capacità foto→video in stile Veo/Flow; la preview suggerisce una generazione multimediale più profonda per prototipi e flussi media.