Che cos'è l'API GPT-5.2

L'API GPT-5.2 è la stessa di GPT-5.2 Thinking in ChatGPT. GPT-5.2 Thinking è la variante di fascia media della famiglia GPT-5.2 di OpenAI progettata per il lavoro più approfondito: ragionamento multi-step, sintesi di documenti lunghi, generazione di codice di qualità e lavoro di conoscenza professionale dove accuratezza e struttura utilizzabile contano più della pura velocità. Nell'API è esposta come modello gpt-5.2 (Responses API / Chat Completions) e si colloca tra la variante Instant a bassa latenza e la variante Pro, di qualità superiore ma più costosa.

Caratteristiche principali

- Contesto molto lungo e compattazione: finestra effettiva di 400K e strumenti di compattazione per gestire la rilevanza in conversazioni e documenti molto estesi.

- Sforzo di ragionamento configurabile:

none | medium | high | xhigh(xhigh abilita il massimo calcolo interno per ragionamenti difficili).xhighè disponibile nelle varianti Thinking/Pro. - Supporto più solido per strumenti e funzioni: chiamata di strumenti di prima classe, grammatiche (CFG/Lark) per vincolare gli output strutturati e comportamenti agentici migliorati che semplificano automazioni complesse a più passaggi.

- Comprensione multimodale: comprensione più ricca di immagini + testo e integrazione in attività a più passaggi.

- Sicurezza migliorata / gestione dei contenuti sensibili: interventi mirati per ridurre risposte indesiderate in aree come l'autolesionismo e altri contesti sensibili.

Capacità tecniche e specifiche (vista sviluppatore)

- Endpoint API e ID modello:

gpt-5.2per Thinking (Responses API),gpt-5.2-chat-latestper flussi chat/instant egpt-5.2-proper il tier Pro; disponibili tramite Responses API e Chat Completions dove indicato. - Token di ragionamento e gestione dello sforzo: l'API supporta parametri espliciti per allocare il compute (reasoning effort) per richiesta; uno sforzo più elevato aumenta la latenza e il costo ma migliora la qualità dell'output per attività complesse.

- Strumenti per output strutturati: supporto per grammatiche (Lark / CFG) per vincolare l'output del modello a una DSL o a una sintassi esatta (utile per SQL, JSON, generazione di DSL).

- Chiamata di strumenti in parallelo e coordinamento agentico: parallelismo migliorato e orchestrazione degli strumenti più pulita riducono la necessità di prompt di sistema elaborati e impalcature multi-agente.

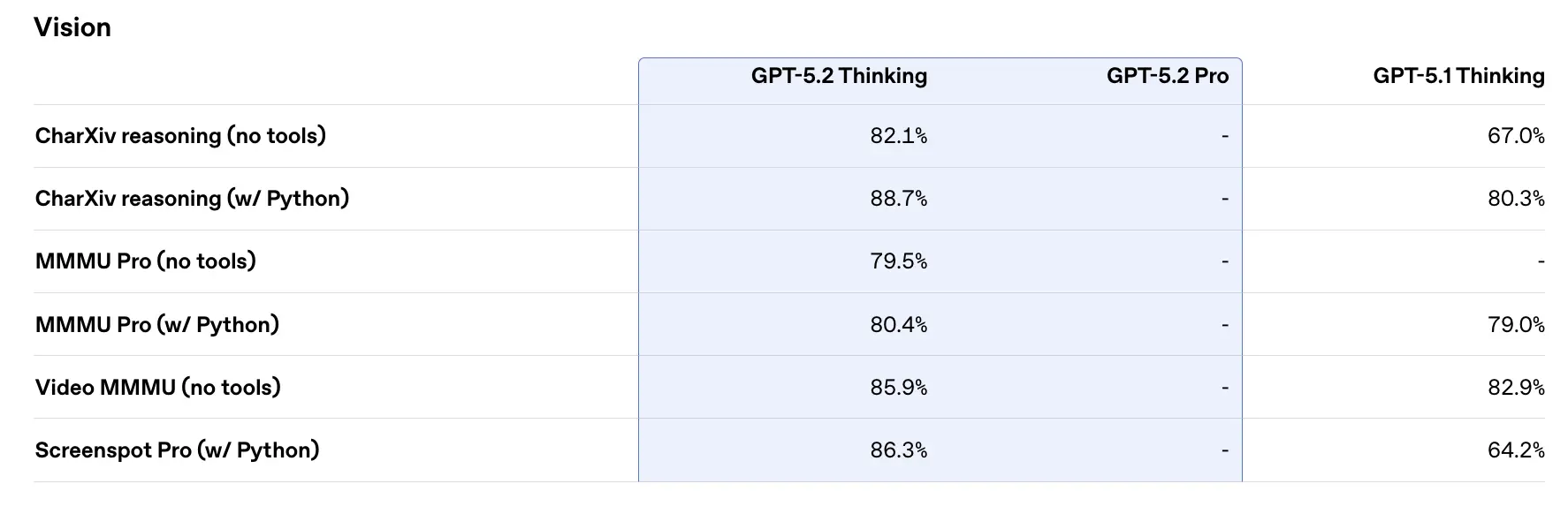

Prestazioni nei benchmark e dati di supporto

OpenAI ha pubblicato una varietà di risultati di benchmark interni ed esterni per GPT-5.2. Evidenze selezionate (numeri riportati da OpenAI):

- GDPval (44 professioni, lavoro di conoscenza) — GPT-5.2 Thinking “supera o eguaglia i migliori professionisti del settore nel 70.9% dei confronti”; OpenAI riporta che gli output sono stati prodotti a >11× la velocità e <1% del costo dei professionisti esperti nei loro task GDPval (stime di velocità e costo basate su dati storici). Questi task includono modelli di fogli di calcolo, presentazioni e brevi video.

- SWE-Bench Pro (coding) — GPT-5.2 Thinking raggiunge ≈55.6% su SWE-Bench Pro e ~80% su SWE-Bench Verified (solo Python) secondo OpenAI, stabilendo un nuovo stato dell'arte per la generazione di codice / valutazione ingegneristica nei loro test. Questo si traduce in debug più affidabile e correzioni end-to-end nella pratica, secondo gli esempi di OpenAI.

- GPQA Diamond (Q&A di scienza a livello graduate) — GPT-5.2 Pro: 93.2%, GPT-5.2 Thinking: 92.4% su GPQA Diamond (nessun tool, massimo ragionamento).

- Serie ARC-AGI — Su ARC-AGI-2 (un benchmark di ragionamento fluido più difficile), GPT-5.2 Thinking ha ottenuto 52.9% e GPT-5.2 Pro 54.2% (OpenAI afferma che questi sono nuovi state-of-the-art per modelli in stile chain-of-thought).

- Contesto lungo (OpenAI MRCRv2) — GPT-5.2 Thinking mostra una precisione quasi del 100% sulla variante MRCR a 4 aghi fino a 256k token e punteggi sostanzialmente migliorati rispetto a GPT-5.1 in scenari di contesto lungo. (OpenAI ha pubblicato grafici e tabelle MRCRv2.)

Confronto con i contemporanei

- vs Google Gemini 3 (Gemini 3 Pro / Deep Think): Gemini 3 Pro è stato pubblicizzato con una ~1,048,576 (≈1M) token finestra di contesto e ampi input multimodali (testo, immagini, audio, video, PDF) e forti integrazioni agentiche tramite Vertex AI / AI Studio. Sulla carta, la finestra di contesto più grande di Gemini 3 è un elemento differenziante per carichi di lavoro a singola sessione estremamente grandi; i compromessi includono la superficie degli strumenti e l'adattamento all'ecosistema.

- vs Anthropic Claude Opus 4.5: Opus 4.5 enfatizza flussi di lavoro di codifica/agent enterprise e riporta forti risultati SWE-bench e robustezza per lunghe sessioni agentiche; Anthropic posiziona Opus per automazione e generazione di codice con una finestra di contesto da 200k e integrazioni specializzate agent/Excel. Opus 4.5 è un forte concorrente nell'automazione enterprise e nei task di codice.

Conclusione pratica: GPT-5.2 punta su un set bilanciato di miglioramenti (contesto da 400k, elevati output di token, ragionamento/codifica migliorati). Gemini 3 punta ai contesti a singola sessione assolutamente più grandi (≈1M), mentre Claude Opus si concentra su ingegneria enterprise e robustezza agentica. Scegli in base a dimensione del contesto, esigenze di modalità, aderenza a funzionalità/strumenti e compromessi costo/latenza.

Come accedere e usare l'API GPT-5.2

Passo 1: Registrati per ottenere la chiave API

Accedi a cometapi.com. Se non sei ancora nostro utente, registrati prima. Accedi alla tua CometAPI console. Ottieni la chiave API delle credenziali di accesso dell'interfaccia. Fai clic su “Add Token” nel token API nel centro personale, ottieni la chiave del token: sk-xxxxx e invia.

Passo 2: Invia richieste all'API GPT-5.2

Seleziona l'endpoint “gpt-5.2” per inviare la richiesta API e imposta il body della richiesta. Il metodo e il body della richiesta sono ottenuti dalla documentazione API sul nostro sito web. Il nostro sito fornisce anche test Apifox per la tua comodità. Sostituisci <YOUR_API_KEY> con la tua chiave CometAPI effettiva dal tuo account. Gli sviluppatori invocano questi tramite la Responses API / gli endpoint Chat.

Inserisci la tua domanda o richiesta nel campo content—è a questo che il modello risponderà . Elabora la risposta dell'API per ottenere l'output generato.

Passo 3: Recupera e verifica i risultati

Elabora la risposta dell'API per ottenere l'output generato. Dopo l'elaborazione, l'API risponde con lo stato dell'attività e i dati di output.

Vedi anche Gemini 3 Pro Preview API