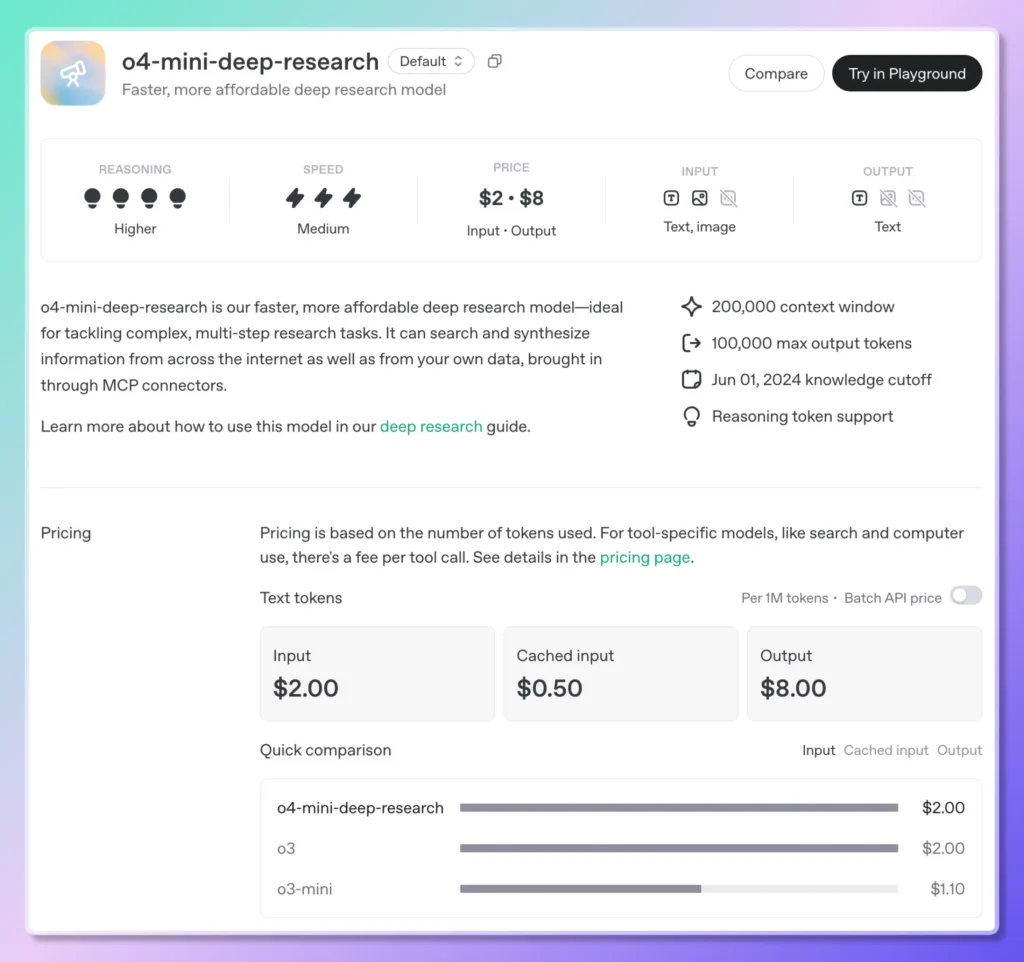

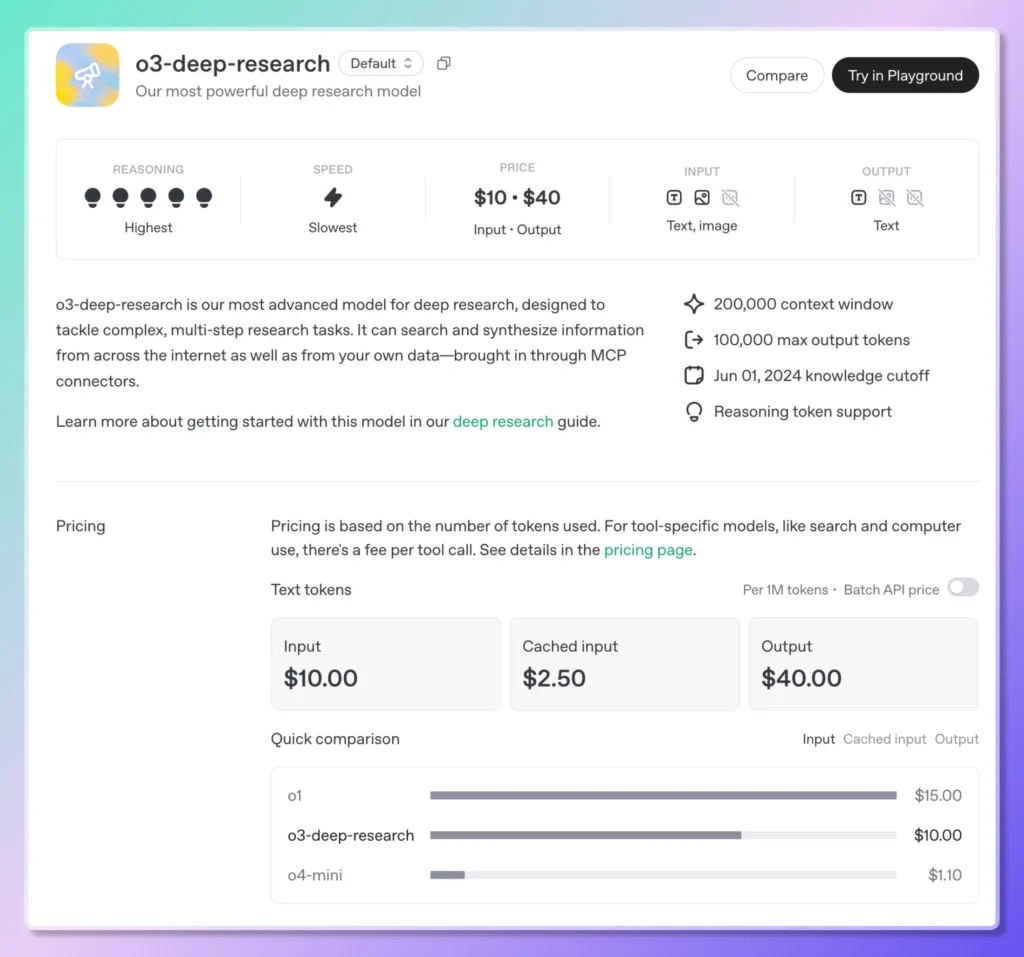

Il 27 giugno 2025, OpenAI ha ufficialmente aperto l'accesso API alle sue funzionalità di Deep Research, consentendo agli sviluppatori di automatizzare programmaticamente flussi di lavoro di ricerca complessi e multi-step. Denominato API di ricerca approfondita, questo nuovo servizio espone due modelli appositamente progettati:o3-deep-research-2025-06-26 per una sintesi approfondita e un output di "qualità superiore", e la versione più leggera e a bassa latenza o4-mini-deep-research-2025-06-26—tramite l'endpoint standard Chat Completions. Questi modelli si basano sui motori di ragionamento introdotti per la prima volta nell'agente Deep Research di ChatGPT all'inizio di quest'anno, ma ora garantiscono agli sviluppatori il pieno controllo sulla progettazione dei prompt, sulla configurazione degli strumenti e sull'esecuzione asincrona tramite la modalità background.

Oltre ad aprire queste specializzazioni di Deep Research di o3 e o4-mini, OpenAI ha anche migliorato i suoi modelli di ragionamento tradizionali:o3, o3-proe o4-mini—con funzionalità di ricerca web integrate. Questa integrazione consente ai modelli di effettuare ricerche in tempo reale, recuperare informazioni aggiornate e sintetizzare i risultati direttamente in un'unica chiamata. Il prezzo del nuovo servizio di "ricerca web basata sul ragionamento" parte da 10 $ ogni 1,000 chiamate, riflettendo il calcolo premium e l'orchestrazione API richiesta; contemporaneamente, OpenAI ha ridotto il costo della ricerca web sui suoi modelli multimodali di punta (GPT-4o e GPT-4.1) per 25 $ ogni 1,000 chiamate .

Per semplificare le attività di ricerca di lunga durata, l'API ora supporta webhooks: gli sviluppatori possono registrare endpoint di callback per ricevere notifiche automatiche al completamento di un job di Deep Research, eliminando la necessità di polling o controlli di stato manuali. Questo meccanismo di webhook è particolarmente consigliato per i flussi di lavoro eseguiti in modo asincrono, come analisi di mercato di più ore o revisioni delle policy, garantendo affidabilità ed efficienza nell'utilizzo delle risorse nei sistemi di produzione.

Accedere all'API Deep Research è semplice. Dopo aver installato l'ultimo SDK OpenAI e aver effettuato l'autenticazione con la chiave API, gli sviluppatori devono semplicemente specificare uno dei due nuovi nomi di modello Deep Research nella richiesta di completamento chat. Abilitando strumenti piace web_search_preview e al code_interpreter e impostando il background Impostando il flag su true, il modello scompone autonomamente le query di alto livello in sotto-domande, emette ricerche, esegue analisi e restituisce un report strutturato e ricco di citazioni, completo di metadati in linea e URL di origine.

Questo lancio rappresenta un'evoluzione significativa nella roadmap di prodotto di OpenAI. All'inizio di quest'anno, a febbraio 2025, l'agente Deep Research ha debuttato all'interno di ChatGPT come funzionalità di "nuova generazione", basata su una variante ottimizzata di o3, per attività che un tempo avrebbero richiesto agli analisti umani decine di ore. Combinava navigazione, utilizzo di strumenti Python e ragionamento iterativo per produrre output approfonditi e verificabili in meno di mezz'ora. Con il rilascio dell'API, aziende e startup possono integrare questa potenza analitica nelle proprie applicazioni, ampliando i casi d'uso dall'intelligence competitiva e dalle revisioni della letteratura alla due diligence tecnica e oltre.

Inoltre, l'implementazione più ampia della ricerca web nei modelli o3, o3-pro e o4-mini sfuma il confine tra conoscenza statica e recupero di informazioni in tempo reale. Gli sviluppatori possono ora creare prompt che istruiscono il modello a "trovare l'ultimo annuncio degli utili trimestrali" o "riepilogare gli attuali sviluppi normativi in materia di privacy dei dati nell'UE", e il modello recupererà, interpreterà e citerà autonomamente le fonti pertinenti, il tutto all'interno di un'unica transazione API. Questo approccio unificato è in contrasto con i modelli precedenti, in cui erano necessarie pipeline separate per la ricerca e la sintesi, riducendo la complessità e la latenza dell'integrazione.

Da una prospettiva aziendale, gli adeguamenti tariffari che accompagnano queste funzionalità riflettono l'impegno di OpenAI nel democratizzare il ragionamento avanzato, gestendo al contempo i costi infrastrutturali. La tariffa di 10 dollari per 1 chiamate per la ricerca web basata sul ragionamento posiziona il servizio in modo competitivo rispetto ai fornitori di pipeline di dati specializzati, mentre la tariffa ridotta di 25 dollari per 1 chiamate per la ricerca web basata su GPT-4o/4.1 sottolinea l'impegno di OpenAI nel rendere l'intelligenza artificiale dinamica e basata su strumenti accessibile su larga scala.

Guardando al futuro, OpenAI ha segnalato un investimento continuo nell'ecosistema Deep Research: aggiornamenti dei modelli, supporto ampliato degli strumenti (inclusi connettori diretti per database e integrazioni di documenti privati tramite MCP) e funzionalità di analisi multimodale più approfondite sono in programma. Con il maturare di queste capacità, il confine tra l'IA come partner conversazionale e l'IA come assistente di ricerca autonomo continuerà a dissolversi, annunciando una nuova era di applicazioni agentiche in grado di indagare, ragionare e fornire informazioni fruibili con un intervento umano minimo.

Iniziamo

CometAPI fornisce un'interfaccia REST unificata che aggrega centinaia di modelli di intelligenza artificiale, sotto un endpoint coerente, con gestione integrata delle chiavi API, quote di utilizzo e dashboard di fatturazione. Invece di dover gestire URL e credenziali di più fornitori.

Gli sviluppatori possono accedere API o3-Pro(modello: o3-pro; o3-pro-2025-06-10), API O3 (modello:o3;o3-2025-04-16 )e API O4-Mini(modello: o4-mini;o4-mini-2025-04-16) Attraverso CometaAPI, gli ultimi modelli elencati sono quelli aggiornati alla data di pubblicazione dell'articolo. Per iniziare, esplora le capacità del modello in Parco giochi e consultare il Guida API per istruzioni dettagliate. Prima di accedere, assicurati di aver effettuato l'accesso a CometAPI e di aver ottenuto la chiave API. CometaAPI offrire un prezzo molto più basso rispetto al prezzo ufficiale per aiutarti a integrarti.

L'ultima integrazione o3-deep-research (modello:

o3-deep-research-2025-06-26) e o4-mini-deep-research (modello: o4-mini-deep-research-2025-06-26) apparirà presto su CometAPI, quindi rimanete sintonizzati! Mentre concludiamo il caricamento del modello Gemini 2.5 Flash‑Lite, esplorate gli altri nostri modelli nella pagina Modelli o provateli in AI Playground.