L'ultimo progresso di Alibaba nell'intelligenza artificiale, Qwen3-codificatore, segna una pietra miliare significativa nel panorama in rapida evoluzione dello sviluppo software basato sull'intelligenza artificiale. Presentato il 23 luglio 2025, Qwen3-Coder è un modello di codifica agentica open source progettato per affrontare in modo autonomo attività di programmazione complesse, dalla generazione di codice boilerplate al debug di intere basi di codice. Basato su un'architettura all'avanguardia basata su un mix di esperti (MoE) e dotato di 480 miliardi di parametri, di cui 35 miliardi attivati per token, il modello raggiunge un equilibrio ottimale tra prestazioni ed efficienza computazionale. In questo articolo, esploriamo ciò che distingue Qwen3-Coder, esaminiamo le sue prestazioni di riferimento, sveliamo le sue innovazioni tecniche, guidiamo gli sviluppatori verso un utilizzo ottimale e consideriamo l'accoglienza e le prospettive future del modello.

Che cosa è Qwen3-Coder?

Qwen3‑Coder è l'ultimo modello di codifica agentica della famiglia Qwen, annunciato ufficialmente il 22 luglio 2025. Progettato come "il modello di codice più agentico fino ad oggi", la sua variante di punta, Qwen3‑Coder‑480B‑A35B‑Instruct, presenta 480 miliardi di parametri totali con un design Mixture‑of‑Experts (MoE) che attiva 35 miliardi di parametri per token. Supporta nativamente finestre di contesto fino a 256 token e scala fino a un milione di token tramite tecniche di estrapolazione, rispondendo alla domanda di comprensione e generazione di codice su scala di repository.

Open source su Apache 2.0

In linea con l'impegno di Alibaba per uno sviluppo guidato dalla comunità, Qwen3-Coder è rilasciato con licenza Apache 2.0. Questa disponibilità open source garantisce trasparenza, promuove il contributo di terze parti e accelera l'adozione sia nel mondo accademico che in quello industriale. Ricercatori e ingegneri possono accedere a pesi pre-addestrati e perfezionare il modello per domini specializzati, dal fintech all'informatica scientifica.

Evoluzione da Qwen2.5

Basandosi sul successo di Qwen2.5-Coder, che offriva modelli con parametri da 0.5 a 32 miliardi e raggiungeva risultati SOTA nei benchmark di generazione di codice, Qwen3-Coder estende le capacità del suo predecessore attraverso pipeline di dati più ampie e migliorate e nuovi regimi di addestramento. Qwen2.5-Coder è stato addestrato su oltre 5.5 trilioni di token con una meticolosa pulizia dei dati e una generazione di dati sintetici; Qwen3-Coder migliora ulteriormente questo aspetto gestendo 7.5 trilioni di token con un rapporto di codice del 70%, sfruttando i modelli precedenti per filtrare e riscrivere input rumorosi per una qualità dei dati superiore.

Quali sono le principali innovazioni che differenziano Qwen3-Coder?

Diverse innovazioni chiave distinguono Qwen3-Coder:

- Orchestrazione delle attività agentiche: Invece di generare semplicemente frammenti, Qwen3-Coder può concatenare autonomamente più operazioni, come la lettura della documentazione, l'avvio di utility e la convalida degli output, senza l'intervento umano.

- Bilancio di pensiero avanzato:Gli sviluppatori possono configurare la quantità di elaborazione da dedicare a ogni fase del ragionamento, consentendo un compromesso personalizzabile tra velocità e completezza, fondamentale per la sintesi di codice su larga scala.

- Integrazione degli strumenti senza soluzione di continuità:L'interfaccia della riga di comando di Qwen3-Coder, "Qwen Code", adatta i protocolli di chiamata delle funzioni e i prompt personalizzati per integrarsi con gli strumenti di sviluppo più diffusi, semplificando l'incorporamento nelle pipeline CI/CD e negli IDE esistenti.

Come si comporta Qwen3-Coder rispetto ai concorrenti?

Scontri di riferimento

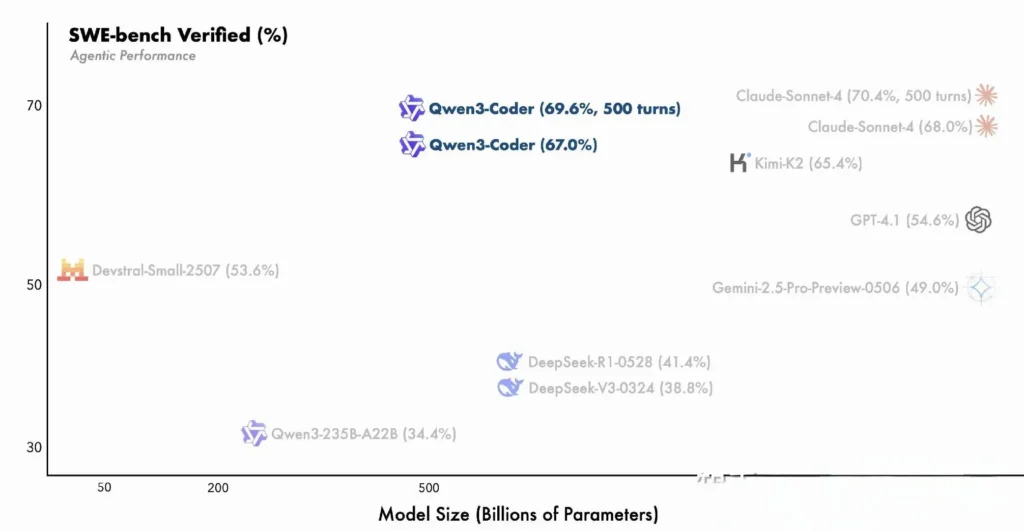

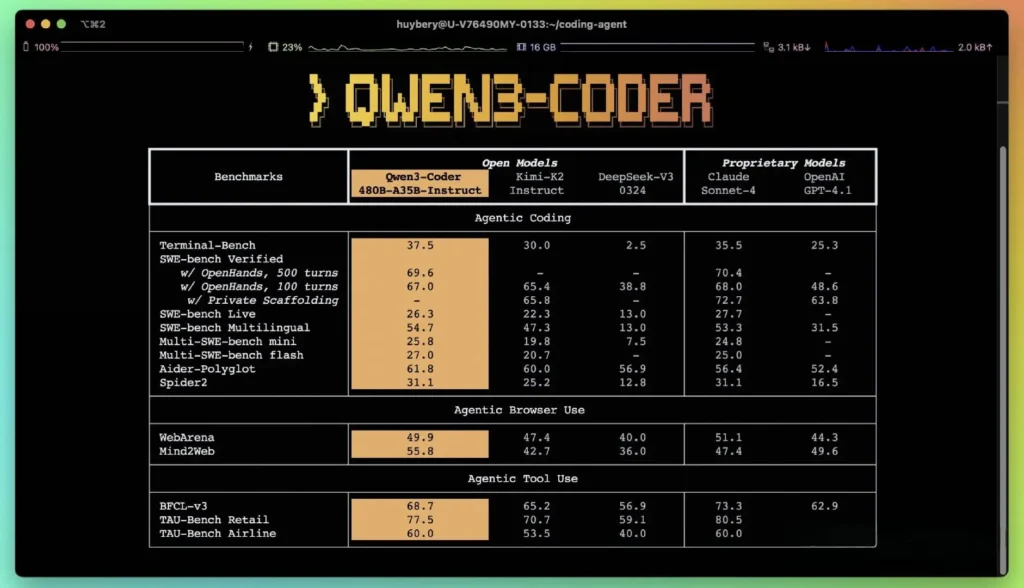

Secondo i parametri di performance pubblicati da Alibaba, Qwen3-Coder supera le principali alternative nazionali, come i modelli in stile codex di DeepSeek e K2 di Moonshot AI, e raggiunge o supera le capacità di codifica delle principali offerte statunitensi in diversi benchmark. Nelle valutazioni di terze parti:

- Aider Poliglotta: Qwen3-Coder-480B ha ottenuto un punteggio di 61.8%, che illustra una solida generazione di codice multilingue e un solido ragionamento.

- MBPP e HumanEval:Test indipendenti riportano che Qwen3-Coder-480B-A35B supera GPT-4.1 sia in termini di correttezza funzionale che di gestione di prompt complessi, in particolare nelle sfide di codifica multi-step.

- La variante con parametro 480B ha raggiunto un successo di esecuzione superiore all'85% su SWE-Bench Suite verificata: supera sia il modello principale di DeepSeek (78%) sia il K2 di Moonshot (82%) e si avvicina molto a Claude Sonnet 4 all'86%.

Confronto con modelli proprietari

Alibaba sostiene che le capacità agentiche di Qwen3-Coder siano in linea con quelle di Claude di Anthropic e GPT-4 di OpenAI nei flussi di lavoro di codifica end-to-end, un risultato notevole per un modello open source. I primi tester segnalano che la sua pianificazione multi-turn, l'invocazione dinamica degli strumenti e la correzione automatica degli errori consentono di gestire attività complesse, come la creazione di applicazioni web full-stack o l'integrazione di pipeline CI/CD, con un intervento umano minimo. Queste capacità sono rafforzate dalla capacità del modello di autovalidarsi tramite l'esecuzione del codice, una caratteristica meno pronunciata nei LLM puramente generativi.

Quali sono le innovazioni tecniche alla base di Qwen3‑Coder?

Architettura Mixture-of-Experts (MoE)

Il cuore di Qwen3-Coder è un design MoE all'avanguardia. A differenza dei modelli densi che attivano tutti i parametri per ogni token, le architetture MoE coinvolgono selettivamente sottoreti specializzate (esperti) su misura per particolari tipi di token o attività. In Qwen3-Coder, 480 miliardi di parametri totali sono distribuiti tra più esperti, con solo 35 miliardi di parametri attivi per token. Questo approccio riduce i costi di inferenza di oltre il 60% rispetto a modelli densi equivalenti, mantenendo al contempo un'elevata fedeltà nella sintesi e nel debug del codice.

Modalità di pensiero e modalità di non pensiero

Prendendo in prestito le innovazioni della più ampia famiglia Qwen3, Qwen3‑Coder integra un inferenza a doppia modalità struttura:

- Modalità di pensiero assegna un “budget di pensiero” più ampio per attività di ragionamento complesse e articolate in più fasi, come la progettazione di algoritmi o il refactoring tra file.

- Modalità non-pensiero fornisce risposte rapide e basate sul contesto, adatte per semplici completamenti di codice e frammenti di codice per l'utilizzo delle API.

Questo passaggio di modalità unificato elimina la necessità di gestire modelli separati per attività ottimizzate per la chat rispetto a quelle ottimizzate per il ragionamento, semplificando i flussi di lavoro degli sviluppatori.

Apprendimento per rinforzo con sintesi automatizzata dei casi di test

Un'innovazione di spicco è la finestra di contesto nativa di Qwen3-Coder da 256K token, il doppio della capacità tipica dei principali modelli aperti, e il supporto fino a un milione di token tramite metodi di estrapolazione (ad esempio, YaRN). Ciò consente al modello di elaborare interi repository, set di documentazione o progetti multi-file in un unico passaggio, preservando le dipendenze tra file e riducendo i prompt ripetitivi. Test empirici mostrano che l'espansione della finestra di contesto produce miglioramenti decrescenti ma comunque significativi nelle prestazioni delle attività a lungo termine, soprattutto in scenari di apprendimento per rinforzo guidato dall'ambiente.

Come possono gli sviluppatori accedere e utilizzare Qwen3-Coder?

La strategia di rilascio di Qwen3-Coder enfatizza l'apertura e la facilità di adozione:

- Pesi del modello open source: Tutti i checkpoint del modello sono disponibili su GitHub con Apache 2.0, consentendo la massima trasparenza e miglioramenti promossi dalla community.

- Interfaccia della riga di comando (codice Qwen): Derivata da Google Gemini Code, la CLI supporta prompt personalizzati, chiamate di funzioni e architetture di plugin per integrarsi perfettamente con i sistemi di build e gli IDE esistenti.

- Distribuzioni cloud e on-premise: Le immagini Docker preconfigurate e i grafici Helm di Kubernetes facilitano le distribuzioni scalabili negli ambienti cloud, mentre le ricette di quantizzazione locale (quantizzazione dinamica da 2 a 8 bit) consentono un'inferenza efficiente in sede, anche su GPU commerciali.

- Accesso API tramite CometAPI:Gli sviluppatori possono anche interagire con Qwen3-Coder tramite endpoint ospitati su piattaforme come CometaAPI, che offrono Open source(

qwen3-coder-480b-a35b-instruct) e versioni commerciali(qwen3-coder-plus; qwen3-coder-plus-2025-07-22)allo stesso prezzo. La versione commerciale è lunga 1 M. - Abbracciare il viso:Alibaba ha reso i pesi Qwen3-Coder e le relative librerie disponibili gratuitamente sia su Hugging Face che su GitHub, confezionati con una licenza Apache 2.0 che consente l'uso accademico e commerciale senza royalty.

Integrazione API e SDK tramite CometAPI

CometAPI è una piattaforma API unificata che aggrega oltre 500 modelli di intelligenza artificiale (IA) di provider leader, come la serie GPT di OpenAI, Gemini di Google, Claude di Anthropic, Midjourney, Suno e altri, in un'unica interfaccia intuitiva per gli sviluppatori. Offrendo autenticazione, formattazione delle richieste e gestione delle risposte coerenti, CometAPI semplifica notevolmente l'integrazione delle funzionalità di IA nelle tue applicazioni. Che tu stia sviluppando chatbot, generatori di immagini, compositori musicali o pipeline di analisi basate sui dati, CometAPI ti consente di iterare più velocemente, controllare i costi e rimanere indipendente dal fornitore, il tutto sfruttando le più recenti innovazioni nell'ecosistema dell'IA.

Gli sviluppatori possono interagire con Qwen3-codificatore tramite un'API compatibile in stile OpenAI, disponibile tramite CometAPI. CometaAPI, che offrono Open source(qwen3-coder-480b-a35b-instruct) e versioni commerciali(qwen3-coder-plus; qwen3-coder-plus-2025-07-22) allo stesso prezzo. La versione commerciale è lunga 1M. Codice di esempio per Python (utilizzando il client compatibile con OpenAI) con best practice che raccomandano impostazioni di campionamento di temperatura = 0.7, top_p = 0.8, top_k = 20 e una penalty di ripetizione = 1.05. La lunghezza dell'output può arrivare fino a 65,536 token, rendendolo adatto per attività di generazione di codice di grandi dimensioni.

Per iniziare, esplora le capacità dei modelli in Parco giochi e consultare il Guida API per istruzioni dettagliate. Prima di accedere, assicurati di aver effettuato l'accesso a CometAPI e di aver ottenuto la chiave API.

Guida rapida su Hugging Face e Alibaba Cloud

Gli sviluppatori desiderosi di sperimentare con Qwen3‑Coder possono trovare il modello su Hugging Face nel repository Qwen/Qwen3‑Coder‑480B‑A35B‑IstruzioneL'integrazione è semplificata tramite transformers libreria (versione ≥ 4.51.0 per evitare KeyError: 'qwen3_moe') e client Python compatibili con OpenAI. Un esempio minimo:

from transformers import AutoModelForCausalLM, AutoTokenizer

model = AutoModelForCausalLM.from_pretrained("Qwen/Qwen3-480B-A35B-Instruct")

tokenizer = AutoTokenizer.from_pretrained("Qwen/Qwen3-480B-A35B-Instruct")

input_ids = tokenizer("def fibonacci(n):", return_tensors="pt").input_ids

output = model.generate(input_ids, max_length=200, temperature=0.7, top_p=0.8, top_k=20, repetition_penalty=1.05)

print(tokenizer.decode(output))

Definizione di strumenti personalizzati e flussi di lavoro agenti

Una delle caratteristiche più importanti di Qwen3-Coder è invocazione di strumenti dinamiciGli sviluppatori possono registrare utility esterne (linter, formattatori, test runner) e consentire al modello di richiamarle autonomamente durante una sessione di programmazione. Questa funzionalità trasforma Qwen3-Coder da un assistente passivo per la programmazione in un agente di programmazione attivo, in grado di eseguire test, modificare lo stile del codice e persino distribuire microservizi in base a intenti conversazionali.

Quali potenziali applicazioni e direzioni future sono consentite da Qwen3-Coder?

Combinando la libertà dell'open source con prestazioni di livello enterprise, Qwen3-Coder apre la strada a una nuova generazione di strumenti di sviluppo basati sull'intelligenza artificiale. Da audit automatizzati del codice e controlli di conformità alla sicurezza a servizi di refactoring continuo e assistenti dev-op basati sull'intelligenza artificiale, la versatilità del modello sta già ispirando startup e team di innovazione interni.

Flussi di lavoro di sviluppo software

I primi utilizzatori segnalano una riduzione del 30-50% del tempo dedicato alla codifica boilerplate, alla gestione delle dipendenze e allo scaffolding iniziale, consentendo agli ingegneri di concentrarsi su attività di progettazione e architettura di alto valore. Le suite di integrazione continua possono sfruttare Qwen3-Coder per generare automaticamente test, rilevare regressioni e persino suggerire ottimizzazioni delle prestazioni basate sull'analisi del codice in tempo reale.

Le imprese giocano

Con l'integrazione di Qwen3-Coder in sistemi mission-critical da parte di aziende operanti nei settori finanziario, sanitario ed e-commerce, i cicli di feedback tra i team degli utenti e la Ricerca e Sviluppo di Alibaba accelereranno i perfezionamenti, come l'ottimizzazione specifica per dominio, protocolli di sicurezza avanzati e plugin IDE più rigorosi. Inoltre, la strategia open source di Alibaba incoraggia i contributi della comunità globale, promuovendo un vivace ecosistema di estensioni, benchmark e librerie di best practice.

Conclusione

In sintesi, Qwen3-Coder rappresenta una pietra miliare nell'intelligenza artificiale open source per l'ingegneria del software: un potente modello agentivo che non solo scrive codice, ma orchestra intere pipeline di sviluppo con una supervisione umana minima. Rendendo la tecnologia disponibile gratuitamente e facile da integrare, Alibaba sta democratizzando l'accesso a strumenti di intelligenza artificiale avanzati e preparando il terreno per un'era in cui la creazione di software diventa sempre più collaborativa, efficiente e intelligente.

Domande frequenti

Cosa rende Qwen3-Coder “agente”?

L'intelligenza artificiale agentica si riferisce a modelli in grado di pianificare ed eseguire attività in più fasi in modo autonomo. La capacità di Qwen3-Coder di richiamare strumenti esterni, eseguire test e gestire basi di codice senza l'intervento umano esemplifica questo paradigma.

Qwen3-Coder è adatto all'uso in produzione?

Sebbene Qwen3-Coder dimostri ottime prestazioni nei benchmark e nei test pratici, le aziende dovrebbero condurre valutazioni specifiche per dominio e implementare misure di sicurezza (ad esempio pipeline di verifica dell'output) prima di integrarlo nei flussi di lavoro di produzione critici.

In che modo l'architettura Mixture-of-Experts avvantaggia gli sviluppatori?

MoE riduce i costi di inferenza attivando solo le sottoreti rilevanti per token, consentendo una generazione più rapida e minori costi di elaborazione. Questa efficienza è fondamentale per la scalabilità degli assistenti di programmazione AI negli ambienti cloud.