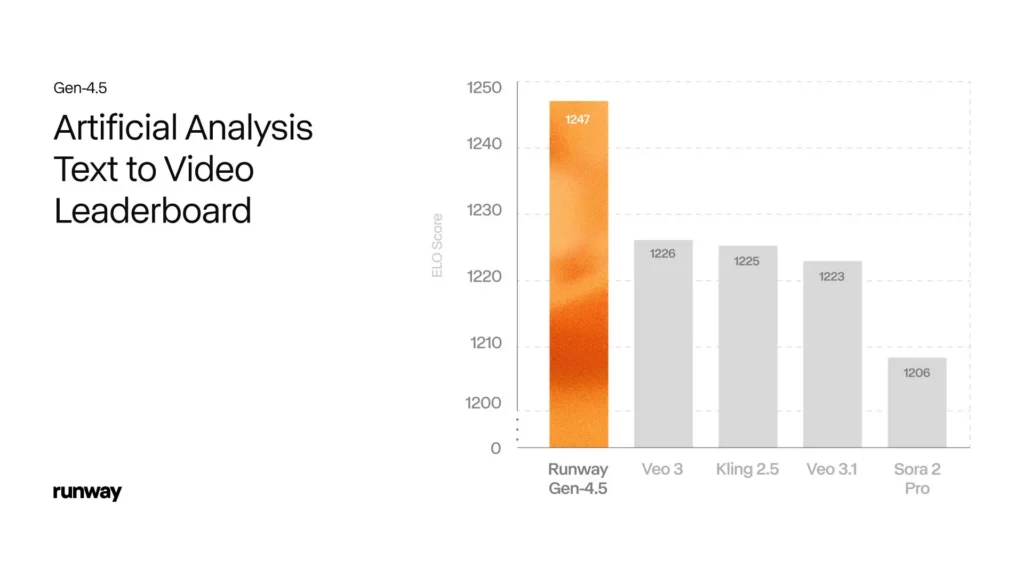

Runway Gen-4.5 è l'ultimo modello di punta text-to-video dell'azienda, annunciato il 1° dicembre 2025. Si posiziona come un'evoluzione incrementale ma significativa rispetto alla famiglia Gen-4, con miglioramenti mirati nella qualità del movimento, nell'aderenza immediata e nel realismo temporale/fisico, esattamente gli aspetti che storicamente separavano un video AI "buono" da un video AI "credibile". Runway Gen-4.5 è in testa alla classifica attuale text-to-video di Artificial Analysis (1,247 punti Elo) ed è ottimizzato per output cinematografici e controllabili, pur presentando ancora le tipiche limitazioni dell'IA generativa, come artefatti di piccoli dettagli ed errori causali occasionali.

Di seguito è riportato uno sguardo approfondito, pratico e (ove possibile) basato su prove concrete su cosa sia Gen-4.5, quali sono le novità rispetto a Gen-4, come si confronta con concorrenti come Veo (3.1) di Google e Sora 2 di OpenAI, segnali di prestazioni reali e affermazioni di benchmark, e una discussione sincera su limiti, rischi e best practice.

Che cos'è Runway Gen-4.5?

Runway Gen-4.5 è l'ultimo modello di generazione text-to-video di Runway, rilasciato come un aggiornamento iterativo ma sostanziale della linea Gen-4 dell'azienda. Runway posiziona Gen-4.5 come una "nuova frontiera" per la generazione video, enfatizzando tre miglioramenti principali rispetto alle versioni precedenti: accuratezza fisica notevolmente migliorata (oggetti con peso e slancio realistici), maggiore aderenza ai prompt (ciò che si chiede è più affidabile e ciò che si ottiene) e maggiore fedeltà visiva nel movimento e nel tempo (dettagli come capelli, trama del tessuto e specularità della superficie rimangono coerenti tra i fotogrammi). Gen-4.5 si colloca attualmente in cima alle classifiche indipendenti, valutate da esperti umani, utilizzate per il benchmarking text-to-video.

Da dove nasce Runway Gen-4.5 e perché è importante?

I modelli video di Runway si sono evoluti rapidamente dalla Gen-1 alla Gen-3/Alpha fino alla Gen-4; la Gen-4.5 si presenta come un consolidamento e un'ottimizzazione di aggiornamenti architetturali, strategie di dati pre-training e tecniche post-training volte a massimizzare la dinamica, la coerenza temporale e la controllabilità. Per i creatori e i team di produzione, questi miglioramenti mirano a rendere le clip generate dall'IA funzionalmente utili nella previsualizzazione, nei contenuti pubblicitari/di marketing e nella produzione di narrazioni brevi, riducendo l'aspetto di "bozza" che spesso caratterizzava i precedenti modelli text-to-video.

4 caratteristiche principali di Runway Gen-4.5

1) Miglioramento del realismo fisico e della dinamica del movimento

Runway Gen-4.5 enfatizza movimenti più fluidi e fisicamente più plausibili. Gen-4.5 si concentra sul movimento realistico degli oggetti – peso, inerzia, liquidi, tessuti e collisioni fisicamente plausibili – producendo sequenze in cui le interazioni appaiono meno "fluttuanti" e più concrete. Nelle demo e nei miei test, il modello dimostra traiettorie degli oggetti migliorate, realismo del movimento della telecamera e meno artefatti "fluttuanti" che affliggevano i precedenti modelli video. Questo è uno degli aggiornamenti principali rispetto a Gen-4.

2) Fedeltà visiva e controlli di stile

Runway Gen-4.5 estende le modalità di controllo di Runway (testo-video, immagine-video, video-video, fotogrammi chiave) e migliora il rendering fotorealistico, la stilizzazione e la composizione cinematografica. Runway afferma che Gen-4.5 può generare clip fotorealistiche difficili da distinguere dai filmati reali in sequenze brevi, soprattutto se combinate con una buona immagine di riferimento o fotogrammi chiave.

3) Migliore tempestività nell'aderenza e consapevolezza compositiva.

Il modello dimostra una fedeltà migliorata quando i prompt includono più attori, indicazioni della telecamera o vincoli di continuità tra scene; aderisce alle istruzioni in modo più affidabile rispetto alle generazioni precedenti. Maggiore precisione nel seguire i prompt descrittivi, con conseguente riduzione degli elementi allucinati o irrilevanti in una clip.

4) Maggiore dettaglio visivo e stabilità temporale.

La texture della superficie, la continuità di capelli/filamenti e l'illuminazione uniforme tra i fotogrammi risultano notevolmente migliorate. È meno probabile che personaggi e oggetti cambino aspetto a metà clip. Runway afferma che questi miglioramenti sono stati ottenuti preservando il profilo di latenza di Gen-4. Uno dei progressi più orientati alla produzione è la migliore gestione da parte del modello delle espressioni facciali dei personaggi e delle emozioni implicite nelle inquadrature. Sebbene Runway Gen-4.5 non sostituisca attori esperti, preserva meglio la continuità emotiva (l'espressione di un personaggio persiste durante un movimento di telecamera, ad esempio) e può generare indizi di performance plausibili da direttive compatte come "sorriso ansioso, distogliere lo sguardo, respirare bruscamente".

Come si comporta Runway Gen-4.5 nei benchmark e nei test reali?

La pista riporta un punteggio Elo di 1,247 nella classifica text-to-video di Artificial Analysis (al momento dell'annuncio), posizionando Gen-4.5 al vertice di quel particolare benchmark al momento della pubblicazione. Benchmark come questi utilizzano giudizi di preferenza umani o automatizzati a coppie su molti output del modello;

Prestazioni pratiche (cosa possono aspettarsi gli utenti)

- Durata e risoluzione delle clip: La Gen-4.5 è attualmente ottimizzata per brevi clip cinematografiche (output a ripresa singola solitamente di 4-20 secondi in HD/1080p). Runway ha sottolineato l'importanza di offrire una maggiore fedeltà senza aumentare la latenza rispetto alla Gen-4.

- Tempi e costi di rendering: Il messaggio di Runway è che i costi/latenza sono paragonabili a quelli di Gen-4 per tutti i livelli di abbonamento; i tempi reali variano in base alla risoluzione scelta, all'impostazione della qualità e al carico della coda.

In che cosa differisce Runway Gen-4.5 da Gen-4?

La Gen-4 ha stabilito le intenzioni produttive di Runway: personaggi coerenti, modalità di controllo immagine-video (immagine→video, keyframing, video→video) e un'enfasi sui flussi di lavoro degli utenti. La Gen-4.5 mantiene queste basi ma spinge modellazione del mondo (fisica, movimento) e tempestiva aderenza senza sacrificare la produttività. In pratica, la Gen-4 potrebbe essere ancora eccellente per attività veloci, orientate allo stile e con budget più contenuti; la Gen-4.5 è la soluzione di aggiornamento quando si necessitano dinamiche più credibili e un controllo più preciso.

Cosa è cambiato tecnicamente (alto livello)

Runway Gen-4.5 è descritto come un'evoluzione piuttosto che una completa riscrittura dell'architettura. I materiali di Runway affermano che il modello beneficia di una migliore efficienza dei dati pre-addestramento e di tecniche post-addestramento (ad esempio, messa a punto mirata e regolarizzazione temporale). In pratica, ciò si traduce in una migliore modellazione di peso/movimento, scene multielemento più coerenti e una migliore conservazione dei dettagli ad alta frequenza (capelli, trama del tessuto) nei fotogrammi.

Le differenze pratiche che i creatori noteranno

- Miglior comportamento fisico: gli oggetti obbediscono alla massa percepita e i liquidi/fluidi si comportano in modo più plausibile.

- Meno rotture di identità: è meno probabile che personaggi e oggetti cambino aspetto a metà clip.

- Stessa velocità, qualità superiore: Runway afferma che le prestazioni (latenza) sono paragonabili a quelle della Gen-4, mentre la qualità è superiore. Questo rende la Gen-4.5 interessante per i team di produzione che non possono accettare ritardi di rendering elevati.

Quando scegliere Gen-4 vs Gen-4.5

- Usa il gen-4 quando è necessaria una prova di concetto più economica e veloce o quando le pipeline/i controlli esistenti sono già sintonizzati su quel motore.

- Usa il gen-4.5 quando hai bisogno di un realismo migliorato, interazioni complesse tra più oggetti o output di livello produttivo in cui la fisica del movimento e la precisione immediata sono importanti (ad esempio, visualizzazioni di prodotti, previsualizzazione di effetti visivi, cortometraggi basati sui personaggi).

Compatibilità con i controlli Gen-4. Tutte le modalità di editor supportate da Runway (immagine→video, fotogrammi chiave, video→video, riferimenti agli attori) sono state integrate nella Gen-4.5, in modo che i creatori possano riutilizzare i controlli familiari con risultati migliori.

Come si confronta Gen-4.5 con Veo 3.1 e Sora 2?

Come si confronta con Veo 3.1 di Google?

Veo 3.1 è la famiglia text-to-video ad alta fedeltà di Google (aggiornamenti da Veo 3 a 3.1). Il modello è apprezzato per la texture cinematografica, il rendering di stile efficace e il controllo rigoroso di colori e illuminazione. Confronti indipendenti indicano che Veo 3.1 eccelle nelle scene con atmosfera e stilizzate ed è ampiamente disponibile tramite le API di Google, ma può avere difficoltà nella fisica multi-oggetto e nella coerenza temporale a lungo raggio rispetto ai migliori concorrenti specializzati. I primi test ciechi e le descrizioni degli utenti suggeriscono che Runway Gen-4.5 sia migliore in termini di plausibilità del movimento e aderenza immediata per prompt con fisica intensa, mentre Veo spesso vince nei test stilizzati, pittorici o cinematografici su singole scene.

Dove Veo tende a portare: fedeltà audio e funzionalità narrative strutturate (Flow/Veo Studio) e stretta integrazione nell'ecosistema di Google (Gemini API/Vertex AI).

Dove Gen-4.5 tende a portare: test di preferenza umana in cieco per realismo visivo, aderenza immediata e comportamento di movimento complesso (secondo le classifiche di Video Arena citate da Runway). In diversi confronti pubblici in cieco, Gen-4.5 ha un leggero vantaggio nel punteggio Elo rispetto alle varianti Veo, sebbene il margine e il significato varino a seconda del tipo di contenuto.

Come si confronta con Sora 2 di OpenAI?

Sora 2 (OpenAI) Si concentra sulla precisione fisica, sulla sincronizzazione dell'audio (inclusi dialoghi ed effetti sonori) e sulla controllabilità. Sora 2 riesce spesso a realizzare scene animate coerenti con spunti narrativi di alto livello e in flussi di lavoro in cui audio e dialoghi sono parti importanti della pipeline di generazione.

Dove tende a portare Sora 2: generazione audio integrata e sincronizzazione multimodale in determinate impostazioni; tende a produrre clip fortemente atmosferiche e orientate alla narrazione.

Dove Gen-4.5 tende a portare: secondo i confronti ciechi indipendenti citati da Runway, realismo visivo percepito, fedeltà dei prompt e coerenza del movimento. Anche in questo caso, la scelta pratica dipende dai vostri valori: se la generazione audio nativa + strumenti integrati sono essenziali, Sora 2 o Veo potrebbero essere preferibili; se la fedeltà visiva pura per scene complesse è la priorità, il vantaggio dei test ciechi di Gen-4.5 è significativo.

Tabella di confronto pratico (riepilogo)

| Zona | Pista Gen-4.5 | Pista Gen-4 (precedente) | Google Veo 3.1 | OpenAI Sora 2 |

|---|---|---|---|---|

| Rilascio / Posizionamento | Dicembre 2025 — “Gen-4.5”: aumento di qualità e fedeltà; punteggio benchmark più alto (1,247 Elo) | Gen-4 precedente: passo importante per coerenza e controllabilità | Veo 3.1: il generatore video di Google; audio nativo e opzioni di qualità veloce/veloce | Sora 2: il modello video+audio di punta di OpenAI; enfatizza la precisione fisica e l'audio sincronizzato |

| Punti di forza principali | Qualità del movimento, fedeltà immediata, immagini cinematografiche, integrazione API | Continuità del personaggio, coerenza multi-shot, controllabilità | Uscite Fast 8s, generazione nativa di audio/dialoghi, ottimizzata per velocità/UX | Fisica e realismo, suono/dialogo sincronizzato, controllabilità |

| Lunghezza / formati di output | Brevi clip cinematografiche; supporta immagine→video, testo→video, fotogrammi chiave, ecc. | Brevi clip; modalità di controllo simili | Video di alta qualità da 8 secondi, opzione Veo 3.1 Fast | Uscite 720p/1080p con audio, enfasi sulla fedeltà |

| Audio nativo | Non è il titolo principale (l'attenzione è rivolta alla fedeltà visiva), ma Runway supporta flussi di lavoro audio tramite strumenti | Generazione audio nativa limitata | Generazione audio nativa (effetti sonori, dialoghi). Attenzione alla qualità audio. | L'audio sincronizzato e gli effetti sonori sono caratteristiche esplicite. |

| Limitazioni tipiche | Artefatti di piccoli dettagli (volti/folle), occasionali errori causali/temporali | Artefatti precedenti, più incoerenza di 4.5 nei movimenti | La breve durata è un compromesso di progettazione: qualità contro lunghezza | Modalità di guasto ristrette su scene complesse; ancora in evoluzione |

- Realismo visivo e movimento: Gen-4.5 > Veo 3.1 ≈ Sora 2 (varia a seconda della scena).

- Audio e suono nativo: Veo 3.1 ≥ Sora 2 > Runway (Runway ha strumenti audio per il flusso di lavoro, ma Veo e Sora incorporano una generazione audio nativa più approfondita nella produzione).

- Controlli e modifica: Runway (fotogrammi chiave, immagine→video, continuità di riferimento) e Veo (Flow Studio) offrono entrambi un controllo elevato; Sora si concentra sui controlli multimodali sincronizzati.

- In breve: Sora 2 è forte nella continuità narrativa; Veo 3.1 è forte nella trama cinematografica; Gen-4.5 è forte nel realismo del movimento e nella controllabilità.

Quali sono i limiti e i rischi concreti che restano con Gen-4.5?

Nessun modello è perfetto e la Gen-4.5 presenta limiti noti e rischi concreti da considerare prima dell'adozione.

Limitazioni tecniche

- Fisica dei casi limite ed errori causali: Sebbene notevolmente migliorato, il modello continua a generare occasionali errori di sequenza causale (ad esempio, un effetto che precede la sua causa) e sottili errori di permanenza degli oggetti quando le scene diventano molto complesse. Questi sono meno frequenti, ma comunque presenti.

- Coerenza di lunga durata: Come la maggior parte degli attuali modelli text-to-video, la Gen-4.5 è ottimizzata per clip brevi (della durata di pochi secondi). La generazione di scene estese o sequenze complete richiede ancora l'unione di più scene, interventi editoriali o flussi di lavoro ibridi.

- Identità e coerenza su larga scala: Produrre centinaia di riprese con lo stesso identico personaggio che recita in modo coerente continua a richiedere un flusso di lavoro intenso; la Gen-4.5 aiuta ma non elimina i sistemi di progettazione di riferimento o le pipeline di risorse centralizzate.

Sicurezza, uso improprio e rischi etici

- Rischio di deepfake/impersonificazione: Qualsiasi generatore video ad alta fedeltà aumenta il rischio di contenuti multimediali realistici ma ingannevoli. Le organizzazioni dovrebbero implementare misure di sicurezza (watermarking, policy sui contenuti, flussi di verifica dell'identità) e monitorare il rischio di uso improprio.

- Copyright e provenienza del set di dati: La provenienza dei dati di formazione rimane una preoccupazione più ampia per il settore. Creatori e titolari dei diritti devono essere consapevoli che i risultati potrebbero riflettere modelli appresi da materiale protetto da copyright, il che solleva questioni legali ed etiche in merito al riutilizzo in contesti commerciali.

- Pregiudizi e danni rappresentativi: I modelli generativi possono riprodurre i bias presenti nei dati di training (ad esempio, sovra/sottorappresentazione, rappresentazioni stereotipate). Sono comunque necessari test rigorosi e strategie di mitigazione in fase di sviluppo.

Conclusione: dove si colloca la Gen-4.5 nel panorama video in evoluzione dell'intelligenza artificiale

Runway Gen-4.5 rappresenta un significativo passo avanti nel realismo e nella controllabilità del text-to-video. Attualmente occupa un posto di rilievo nelle classifiche indipendenti di preferenza cieca, e la messaggistica di prodotto e i primi report di Runway lo posizionano come un aggiornamento pratico per i creatori che necessitano di movimenti più convincenti, una migliore fedeltà dei prompt e una maggiore coerenza temporale senza compromettere la velocità di generazione. Allo stesso tempo, i sistemi concorrenti di Google (Veo 3.1) e OpenAI (Sora 2) continuano a promuovere punti di forza complementari come l'audio integrato, strumenti di produzione per storie/narrazioni e integrazioni più profonde con l'ecosistema. La scelta della piattaforma giusta dipende ancora dal progetto: se si dà priorità al realismo visivo, all'audio nativo, all'integrazione della piattaforma o ai controlli di governance.

La versione Gen-4.5 verrà distribuita su piani con prezzi comparabili a quelli della Gen-4.

Gli sviluppatori possono accedere Versione 3.1 , Sora 2 e al Pista/gen4_aleph ecc. tramite CometAPI, l'ultima versione del modello è sempre aggiornato con il sito ufficiale. Per iniziare, esplora le capacità del modello nel Parco giochi e consultare il Guida API per istruzioni dettagliate. Prima di accedere, assicurati di aver effettuato l'accesso a CometAPI e di aver ottenuto la chiave API. CometaAPI offrire un prezzo molto più basso rispetto al prezzo ufficiale per aiutarti a integrarti.

Pronti a partire? → Prova gratuita della gen-4.5 !

Se vuoi conoscere altri suggerimenti, guide e novità sull'IA seguici su VK, X e al Discordia!