CometaAPI Si propone come piattaforma unificante quando sviluppatori e aziende si trovano ad affrontare la crescente complessità nell'integrazione e nella gestione di diversi modelli di intelligenza artificiale, offrendo un unico punto di accesso a oltre 500 modelli di intelligenza artificiale in tutto il mondo. Aggregando servizi leader, da modelli linguistici di grandi dimensioni a sistemi multimodali all'avanguardia, CometAPI semplifica i flussi di lavoro di sviluppo, riduce i costi e accelera il time-to-market. Questo articolo approfondisce i fondamenti di CometAPI, ne esplora il funzionamento interno, guida l'utente attraverso le fasi di utilizzo e mette in evidenza gli ultimi aggiornamenti dei modelli che alimentano il suo ecosistema.

Che cos'è CometAPI?

Una piattaforma unificata di aggregazione di modelli di intelligenza artificiale

CometAPI è una piattaforma di aggregazione API incentrata sugli sviluppatori che unifica l'accesso a oltre 500 modelli di intelligenza artificiale in un'unica interfaccia coerente. Invece di integrarsi separatamente con la serie GPT di OpenAI, Claude di Anthropic, Midjourney, Suno, Gemini di Google e altri, gli sviluppatori inviano le richieste all'endpoint di CometAPI e specificano il modello desiderato per nome. Questo consolidamento semplifica notevolmente gli sforzi di integrazione, riducendo il sovraccarico dovuto alla gestione di più chiavi API, endpoint e sistemi di fatturazione.

Vantaggi chiave per sviluppatori e aziende

Centralizzando i modelli su un'unica piattaforma, CometAPI fornisce:

- Fatturazione semplificata: Un'unica fattura che copre l'utilizzo di tutti i modelli, evitando fatture frammentate dei fornitori.

- Indipendenza del fornitore: Passaggio agevole da un modello all'altro senza vincoli, per una flessibilità a lungo termine.

- Alta concorrenza e bassa latenza: Un backbone senza server offre una capacità illimitata di transazioni al minuto e tempi di risposta inferiori a 200 ms per la maggior parte delle chiamate basate su testo.

- Ottimizzazione dei costi: Sconti sul volume fino al 20% sui modelli più diffusi aiutano i team a controllare le spese per l'intelligenza artificiale.

Come funziona CometAPI?

Architettura e componenti chiave

Il core di CometAPI è un'infrastruttura serverless ad alte prestazioni che si scala automaticamente per soddisfare la domanda. Le richieste in arrivo passano attraverso un bilanciatore di carico globale e vengono indirizzate all'endpoint del provider modello più appropriato (OpenAI, Anthropic, Google Cloud e altri) in base a fattori come latenza e costi. Dietro le quinte, CometAPI gestisce:

- Gestione delle chiavi API: Archiviazione sicura delle chiavi utente e supporto alla rotazione automatica.

- Motore moltiplicatore di velocità: Moltiplicatori di prezzo trasparenti allineati ai listini prezzi ufficiali, garantendo la coerenza dei costi.

- Monitoraggio dell'utilizzo e fatturazione: Dashboard di misurazione in tempo reale che mostrano il consumo di token, l'utilizzo del modello e gli avvisi di spesa.

Come utilizzare CometAPI?

1. Ottieni una chiave API

Registrati per una CometAPI gratuita account per ricevere un token (formattato come sk-XXXXX) nella tua dashboard. Questo token garantisce l'accesso a tutti i modelli integrati e viene utilizzato in Authorization intestazione delle richieste API.

2. Configurare l'URL di base

Nel tuo codice base, imposta l'URL di base su:

https://www.cometapi.com/console/

Tutte le chiamate successive, siano esse completamento di testo, generazione di immagini o ricerca di file, vengono instradate tramite questo singolo endpoint.

Potrebbe essere necessario che diversi client provino i seguenti indirizzi:

- https://www.cometapi.com/console/

- https://api.cometapi.com/v1

- https://api.cometapi.com/v1/chat/completions

3. Effettua chiamate API in formato OpenAI

CometAPI accetta richieste che seguono lo schema API OpenAI. Ad esempio, per generare testo con GPT-4.1:

curl https://api.cometapi.com/v1/chat/completions \

-H "Authorization: Bearer sk-XXXXX" \

-H "Content-Type: application/json" \

-d '{

"model": "gpt-4.1",

"messages":

}'

Le risposte e i codici di errore rispecchiano quelli dei fornitori del modello originale, consentendo una migrazione senza interruzioni delle integrazioni esistenti basate su OpenAI.

sostituire

YOUR_API_KEYcon la chiave API ottenuta durante la registrazione.

Esempio di codice:

import os

from openai import OpenAI

client = OpenAI(

base_url="https://api.cometapi.com/v1/chat/completions",

api_key=os.getenv("COMETAPI_KEY"),

)

response = client.chat.completions.create(

model="claude-opus-4-20250514",

messages=[

{"role": "system", "content": "You are a coding assistant."},

{"role": "user", "content": "Refactor this function to improve performance."},

],

)

print(response.choices.message.content)

Questo frammento inizializza il client Anthropic tramite CometAPI, invia una richiesta di completamento della chat alla modalità istantanea di Claude Opus 4 e stampa la risposta dell'assistente.

4. Guida all'integrazione del software

L'integrazione di CometAPI con piattaforme di terze parti (come n8n, Cherry Studio, Zapier, Cursor, ecc.) può migliorare significativamente l'efficienza dello sviluppo, ridurre i costi e rafforzare le capacità di governance. I suoi vantaggi:

- Gli strumenti di terze parti solitamente supportano la chiamata di interfacce compatibili con OpenAI tramite HTTP/REST o nodi dedicati. Con CometAPI come provider "dietro le quinte", è possibile riutilizzare flussi di lavoro o impostazioni dell'assistente esistenti senza alcuna modifica, semplicemente puntando l'URL di base a https://www.cometapi.com/console/

- Dopo essersi connessi a CometAPI, non è necessario passare da un fornitore all'altro. È possibile provare diversi modelli (come GPT-4o, Claude 3.7, Midjourney, ecc.) nello stesso ambiente con un solo clic, accelerando notevolmente il passaggio dal concept al prototipo verificabile.

- Rispetto alla fatturazione separata con ciascun fornitore di modelli, CometAPI aggrega le fatture di ciascun fornitore e offre sconti a livelli diversi in base all'utilizzo, con un risparmio medio del 10-20%.

È possibile fare riferimento ai tutorial delle applicazioni software più diffuse:

- Una guida per impostare il cursore con CometAPI

- Come utilizzare Cherrystudio con CometAPI

- Come usare n8n con CometAPI

Scenari applicativi tipici:

- Processi automatizzati in n8n: utilizzare prima il nodo Richiesta HTTP per generare le immagini (Midjourney), quindi chiamare GPT-4.1 per scrivere le didascalie, per ottenere un output multimodale con un clic.

- Assistente desktop in Cherry Studio: registra CometAPI come provider OpenAI personalizzato e gli amministratori potranno abilitare/disabilitare con precisione i modelli richiesti nell'interfaccia utente grafica, consentendo agli utenti finali di passare liberamente da un modello all'altro nella stessa finestra di dialogo. Cherry Studio estrae automaticamente l'elenco dei modelli più recenti da /v1/models e tutti i nuovi modelli CometAPI connessi verranno visualizzati in tempo reale, eliminando la necessità di aggiornamenti manuali.

Quali modelli supporta CometAPI?

Grazie al collegamento tra i provider, CometAPI offre una libreria ampia e in continua crescita di funzionalità di intelligenza artificiale.

Categorie di modelli

- Grandi modelli linguistici: GPT (o4mini, o3, GPT-4o, GPT-4.1 ecc.), Claude (Claude 4 Sonnet, Opus ecc.). Google Gemini Lineup (Gemini 2.5). Qwen (Qwen 3, qwq), modelli basati su Mistral e LLaMA (mistral-large .llama 4 series), modelli Deepseek ecc.

- Visione e multimodalità: Modelli Midjourney (Fast Imagine, Custom Zoom), Luma, GPT-image-1, stable-diffusion (sdxl ecc.)

- Audio e musica: Suno (Musica, Testi), Udio.

- Ingegneria specializzata e inversa: Grok, FLUX, Kling.text-embedding-ada-002 ecc.

Ultime uscite di modelli

Anteprima di Gemini 2.5 Pro (2025-06-06): Introduce una finestra di contesto da 1 milione di token e funzionalità multimodali native per attività di ragionamento avanzate. Gemini 2.5, ultima versione ufficiale. API di anteprima di Gemini 2.5 Pro (modello: gemini-2.5-pro-preview-06-05) in CometAPI può accedere.

DeepSeek R1 (2025/05/28): Offre prestazioni di ragionamento su larga scala per query complesse, ora disponibili tramite l'endpoint di chat standard. Ultima versione ufficiale di DeepSeek R1 ——API di DeepSeek R1 (modello: deepseek-r1-0528) in CometAPI può accedere.

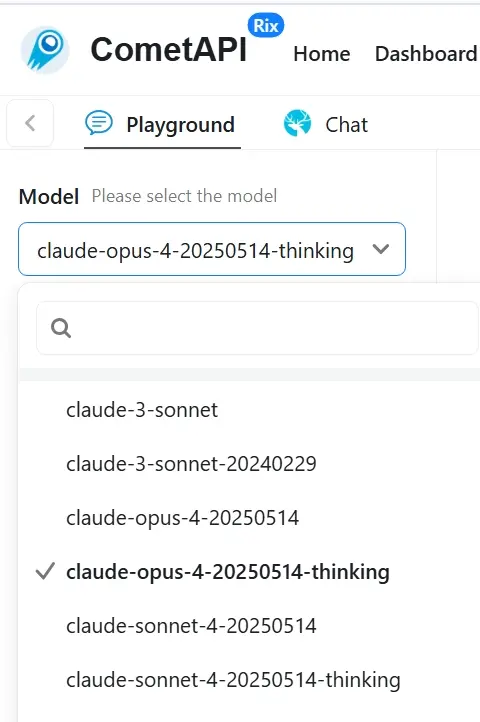

Claudio 4 (2025/05/23): Migliora la codifica e il ragionamento logico all'interno della serie Claude di Anthropic, ottimizzato per un utilizzo aziendale conveniente. Claude 4, ultima versione ufficiale ——API di Claude Opus 4 (modello: claud; claude-opus-4-20250514-thinking)e Claude Sonetto 4 API (modello: claude-sonnet-4-20250514 ;claude-sonnet-4-20250514-thinking) in CometAPI può accedere. Abbiamo anche aggiunto cometapi-sonnet-4-20250514-thinking specificatamente per l'uso in Cursor.

Immagine GPT-1 (2025/04/27): Porta la capacità di generazione di immagini di GPT-4o direttamente agli sviluppatori, supportando output ad alta fedeltà e rendering stilistici diversi. API GPT-image-1 è il terzo modello principale per le visite al sito web

Serie GPT-4.1 (2025/04/15): Include varianti mini e nano che bilanciano prestazioni con latenza e costi ridotti, stabilendo nuovi standard per le attività a lungo termine. GPT 4.1, ultima versione ufficiale ——API GPT-4.1 (modello: gpt-4.1;gpt-4.1-nano;gpt-4.1-mini) in CometAPI può accedere.

Accesso unificato ai modelli emergenti

CometAPI ha annunciato il supporto per modelli avanzati di reverse engineering e l'accesso esteso a Midjourney e Suno per applicazioni di arte e musica generativa. Gli utenti possono ora richiamare questi modelli direttamente tramite l'API unificata di CometAPI, usufruendo di sconti fino al 20% sulle offerte più popolari.

Attualmente cometAPI sta seguendo il ritmo ufficiale. API musicale Suno è stato aggiornato alla versione v4.5 e API di metà viaggio è stato aggiornato alla versione v7. Per dettagli e chiamate API specifiche, fare riferimento alla documentazione API scritta specificamente per metà viaggio e al sunoSe si desidera richiamare altri modelli visivi per generare immagini o video, come sora, runway, ecc., fare riferimento ai documenti di riferimento dedicati sul sito web.

Nota: Questo elenco è a titolo esemplificativo, non esaustivo. CometAPI aggiunge continuamente nuovi provider e release di modelli non appena vengono resi pubblici, spesso entro pochi giorni dal lancio ufficiale, così avrai sempre accesso immediato alle ultime innovazioni senza dover modificare il codice.

Per vedere l'elenco completo e aggiornato di tutti i 500+ modelli, accedi Pagina del modello

Domande frequenti

1. Quale modello di prezzo utilizza CometAPI?

CometAPI applica moltiplicatori trasparenti ai prezzi ufficiali dei modelli, uniformi tra i diversi provider. La fatturazione è a consumo con misurazione dettagliata basata su token e sconti opzionali sul volume per gli account ad alto utilizzo.

2. Posso monitorare l'utilizzo in tempo reale?

Sì. La dashboard di CometAPI mostra metriche in tempo reale su chiamate API, utilizzo dei token e spesa. Puoi impostare avvisi personalizzati per avvisare il tuo team al raggiungimento delle soglie.

3. Come gestire le finestre di contesto di grandi dimensioni?

CometAPI supporta modelli con finestre di contesto fino a 1 milione di token (ad esempio, Gemini 2.5 Pro, GPT-4.1-nano), consentendo attività complesse e di lunga durata. È sufficiente specificare il nome del modello nella chiamata API e CometAPI instrada la richiesta di conseguenza.

4. Quali misure di sicurezza sono in atto?

Tutto il traffico API è crittografato tramite TLS 1.3. Le chiavi API sono archiviate in modo sicuro in archivi di chiavi hardware. Per i clienti aziendali, gli elementi di ragionamento crittografati e i controlli di conservazione dei dati soddisfano gli standard di conformità a zero conservazione.

5. Come posso ottenere supporto o segnalare problemi?

CometAPI fornisce documentazione dettagliata, una comunità Discord attiva e supporto via e-mail a . I clienti aziendali beneficiano inoltre di una gestione dedicata dell'account e di SLA per tempi di attività e prestazioni.

Conclusione

Consolidando centinaia di modelli di intelligenza artificiale in un'unica API, CometAPI consente agli sviluppatori di iterare più velocemente, controllare i costi e rimanere indipendenti dai fornitori, il tutto beneficiando delle più recenti innovazioni. Che tu stia sviluppando la prossima generazione di chatbot, generatori di contenuti multimediali o pipeline di analisi basate sui dati, CometAPI fornisce la base unificata necessaria per accelerare le tue ambizioni di intelligenza artificiale.