GPT-5.2 è la release di dicembre 2025 di OpenAI nella famiglia GPT-5: una famiglia di modelli multimodali di punta (testo + visione + strumenti) ottimizzata per il lavoro professionale basato sulla conoscenza, il ragionamento su contesti lunghi, l’uso agentico di strumenti e l’ingegneria del software. OpenAI presenta GPT-5.2 come il modello più capace della serie GPT-5 fino ad oggi e afferma che è stato sviluppato con enfasi su un ragionamento affidabile in più passaggi, la gestione di documenti molto grandi e una sicurezza/conformità alle policy migliorata; la release include tre varianti rivolte agli utenti — Instant, Thinking e Pro — e viene distribuita inizialmente agli abbonati a pagamento di ChatGPT e ai clienti API.

Che cos’è GPT-5.2 e perché è importante?

GPT-5.2 è l’ultimo membro della famiglia GPT-5 — una nuova serie di modelli “di frontiera” progettata specificamente per colmare il divario tra assistenti conversazionali a singola interazione e sistemi che devono ragionare su documenti lunghi, chiamare strumenti, interpretare immagini ed eseguire workflow multi‑passo in modo affidabile. OpenAI presenta 5.2 come la sua release più capace per il lavoro professionale basato sulla conoscenza: stabilisce nuovi risultati all’avanguardia su benchmark interni (in particolare un nuovo benchmark GDPval per il knowledge work), dimostra prestazioni di coding più solide su benchmark di ingegneria del software e offre capacità significativamente migliorate su contesti lunghi e visione.

In termini pratici, GPT-5.2 è più di un semplice “modello di chat più grande”. È una famiglia di tre varianti ottimizzate (Instant, Thinking, Pro) che bilanciano latenza, profondità di ragionamento e costo — e che, insieme all’API di OpenAI e al routing di ChatGPT, possono essere utilizzate per eseguire lunghi lavori di ricerca, creare agenti che chiamano strumenti esterni, interpretare immagini e grafici complessi e generare codice di produzione con una fedeltà superiore rispetto alle release precedenti. Il modello supporta finestre di contesto molto grandi (i documenti OpenAI indicano una finestra di contesto da 400.000 token e un limite di output massimo di 128.000 per i modelli di punta), nuove funzionalità API per livelli espliciti di sforzo di ragionamento e comportamenti di invocazione di strumenti “agentici”.

5 capacità principali migliorate in GPT-5.2

1) GPT-5.2 è migliore nella logica multi‑passo e nella matematica?

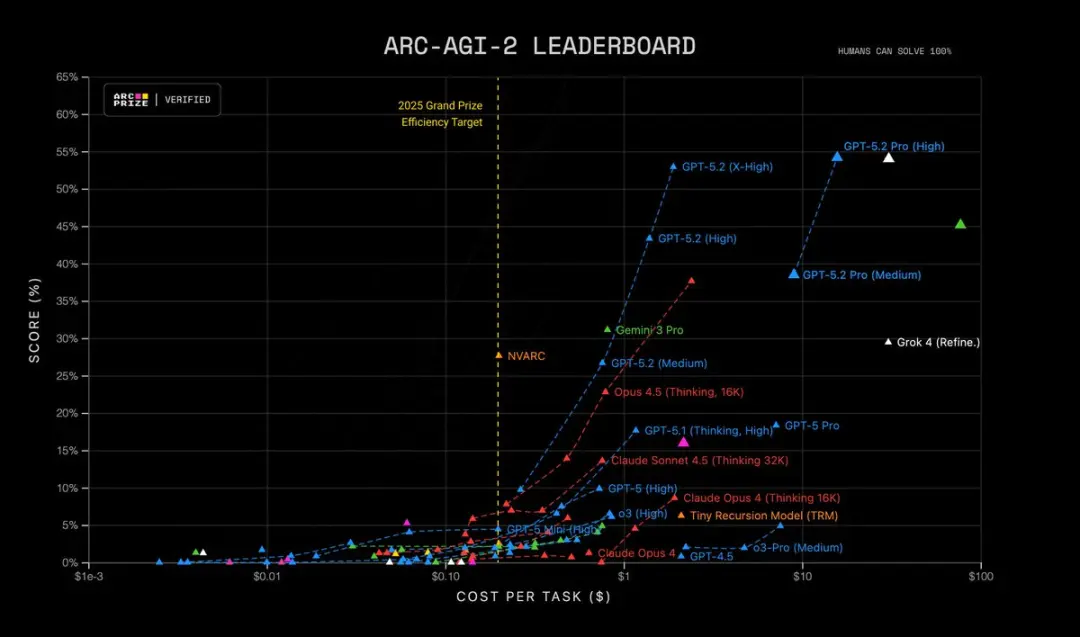

GPT-5.2 porta un ragionamento multi‑passo più acuto e prestazioni sensibilmente più forti in matematica e problem solving strutturato. OpenAI afferma di aver aggiunto un controllo più granulare dello sforzo di ragionamento (nuovi livelli come xhigh), di aver progettato il supporto per “token di ragionamento” e di aver ottimizzato il modello per mantenere la catena del pensiero su tracce di ragionamento interne più lunghe. Benchmark come FrontierMath e test in stile ARC-AGI mostrano guadagni sostanziali rispetto a GPT-5.1; margini più ampi su benchmark specifici di dominio utilizzati in workflow scientifici e finanziari. In breve: GPT-5.2 “pensa più a lungo” quando gli viene chiesto e può affrontare lavoro simbolico/matematico più complicato con maggiore coerenza.

| RC-AGI-1 (Verificato) Ragionamento astratto | 86.2% | 72.8% |

|---|---|---|

| ARC-AGI-2 (Verificato) Ragionamento astratto | 52.9% | 17.6% |

GPT-5.2 Thinking stabilisce record in molteplici test avanzati di scienza e ragionamento matematico:

- GPQA Diamond Science Quiz: 92.4% (versione Pro 93.2%)

- ARC-AGI-1 Ragionamento astratto: 86.2% (primo modello a superare la soglia del 90%)

- ARC-AGI-2 Ragionamento di ordine superiore: 52.9%, stabilendo un nuovo record per il modello Thinking Chain

- FrontierMath Test di matematica avanzata: 40.3%, superando di gran lunga il suo predecessore;

- HMMT Problemi di competizione matematica: 99.4%

- AIME Test di matematica: 100% Soluzione completa

Inoltre, GPT-5.2 Pro (High) è all’avanguardia su ARC-AGI-2, ottenendo un punteggio di 54.2% a un costo di $15.72 per attività! Superando tutti gli altri modelli.

Perché è importante: molte attività del mondo reale — modellazione finanziaria, progettazione di esperimenti, sintesi di programmi che richiedono ragionamento formale — sono limitate dalla capacità di un modello di concatenare molti passaggi corretti. GPT-5.2 riduce i “passaggi allucinati” e produce tracce di ragionamento intermedie più stabili quando gli si chiede di mostrare il lavoro svolto.

2) In che modo sono migliorate la comprensione di testi lunghi e il ragionamento tra documenti?

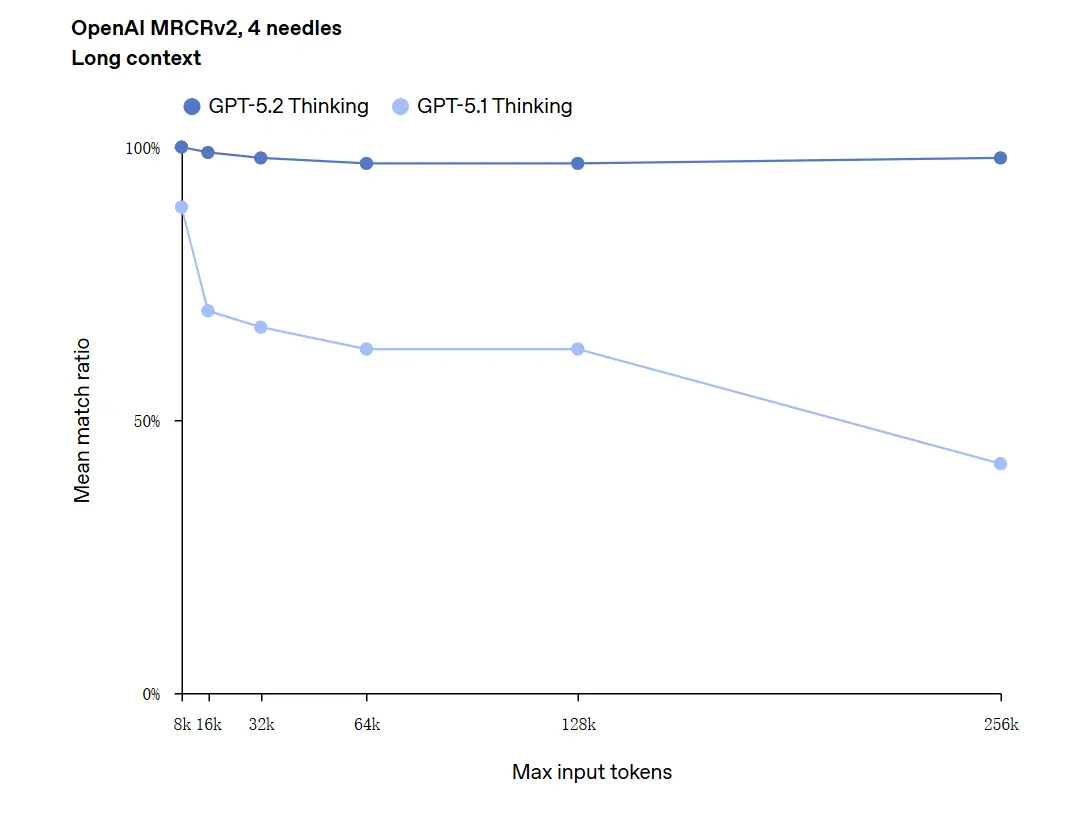

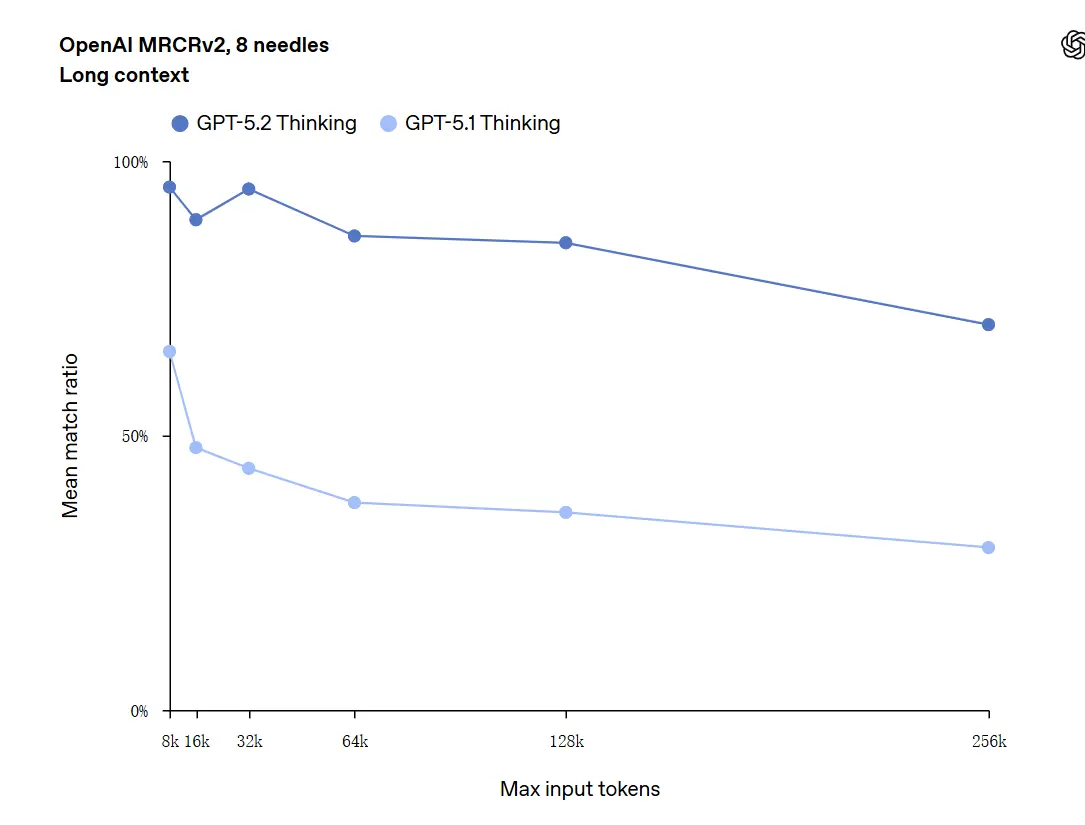

La comprensione di contesti lunghi è uno dei miglioramenti principali. Il modello sottostante di GPT-5.2 supporta una finestra di contesto da 400k token e — cosa importante — mantiene un’accuratezza più elevata man mano che il contenuto rilevante si sposta in profondità in quel contesto. GDPval, una suite di compiti per “knowledge work ben specificato” in 44 occupazioni, dove GPT-5.2 Thinking raggiunge la parità o supera i giudici umani esperti su una larga quota di compiti. Segnalazioni indipendenti confermano che il modello conserva e sintetizza informazioni su molti documenti molto meglio rispetto ai modelli precedenti. È un passo avanti davvero pratico per attività come due diligence, sintesi legali, revisioni della letteratura e comprensione di codebase.

GPT-5.2 può gestire contesti fino a 256,000 token (circa 200+ pagine di documenti). Inoltre, nel test di comprensione di testi lunghi "OpenAI MRCRv2", GPT-5.2 Thinking ha raggiunto un tasso di accuratezza vicino al 100%.

Avvertenza sul “100% di accuratezza”: ha descritto i miglioramenti come “prossimi al 100%” per micro‑compiti ristretti; i dati di OpenAI sono meglio descritti come “allo stato dell’arte e in molti casi pari o superiori ai livelli di esperti umani sui compiti valutati”, non letteralmente impeccabili in tutti gli usi. I benchmark mostrano grandi progressi ma non perfezione universale.

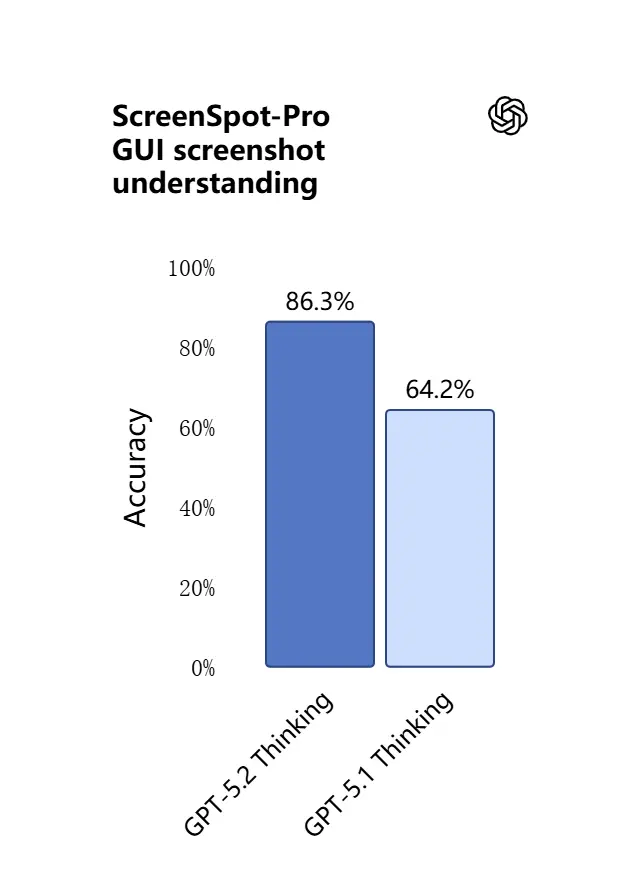

3) Cosa c’è di nuovo nella comprensione visiva e nel ragionamento multimodale?

Le capacità di visione in GPT-5.2 sono più acute e pratiche. Il modello è migliore nell’interpretare screenshot, leggere grafici e tabelle, riconoscere elementi dell’interfaccia utente e combinare input visivi con contesti testuali lunghi. Non è solo didascalizzazione: GPT-5.2 può estrarre dati strutturati dalle immagini (ad esempio, tabelle in un PDF), spiegare grafici e ragionare su diagrammi in modi che supportano azioni degli strumenti a valle (ad esempio, generare un foglio di calcolo da un report fotografato).

.webp)

Effetto pratico: i team possono fornire al modello intere presentazioni, report di ricerca scansionati o documenti ricchi di immagini e chiedere sintesi trasversali ai documenti — riducendo notevolmente il lavoro manuale di estrazione.

4) In che modo sono cambiati l’invocazione degli strumenti e l’esecuzione dei compiti?

GPT-5.2 spinge ulteriormente verso il comportamento agentico: è migliore nel pianificare compiti multi‑passo, decidere quando chiamare strumenti esterni ed eseguire sequenze di chiamate API/strumenti per completare un lavoro end‑to‑end. Miglioramenti di “agentic tool‑calling” — il modello proporrà un piano, chiamerà strumenti (database, compute, filesystem, browser, esecutori di codice) e sintetizzerà i risultati in un deliverable finale con maggiore affidabilità rispetto ai modelli precedenti. L’API introduce routing e controlli di sicurezza (liste di strumenti consentiti, scaffolding degli strumenti) e l’interfaccia di ChatGPT può instradare automaticamente le richieste alla variante 5.2 appropriata (Instant vs Thinking).

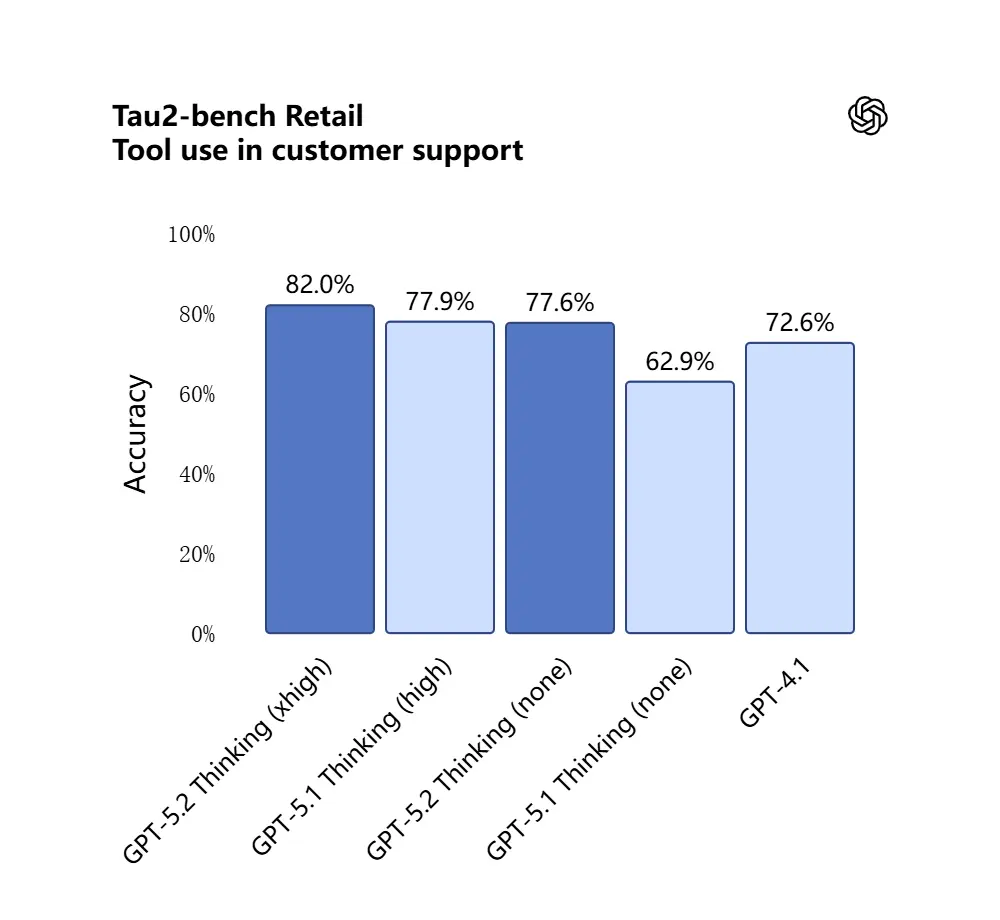

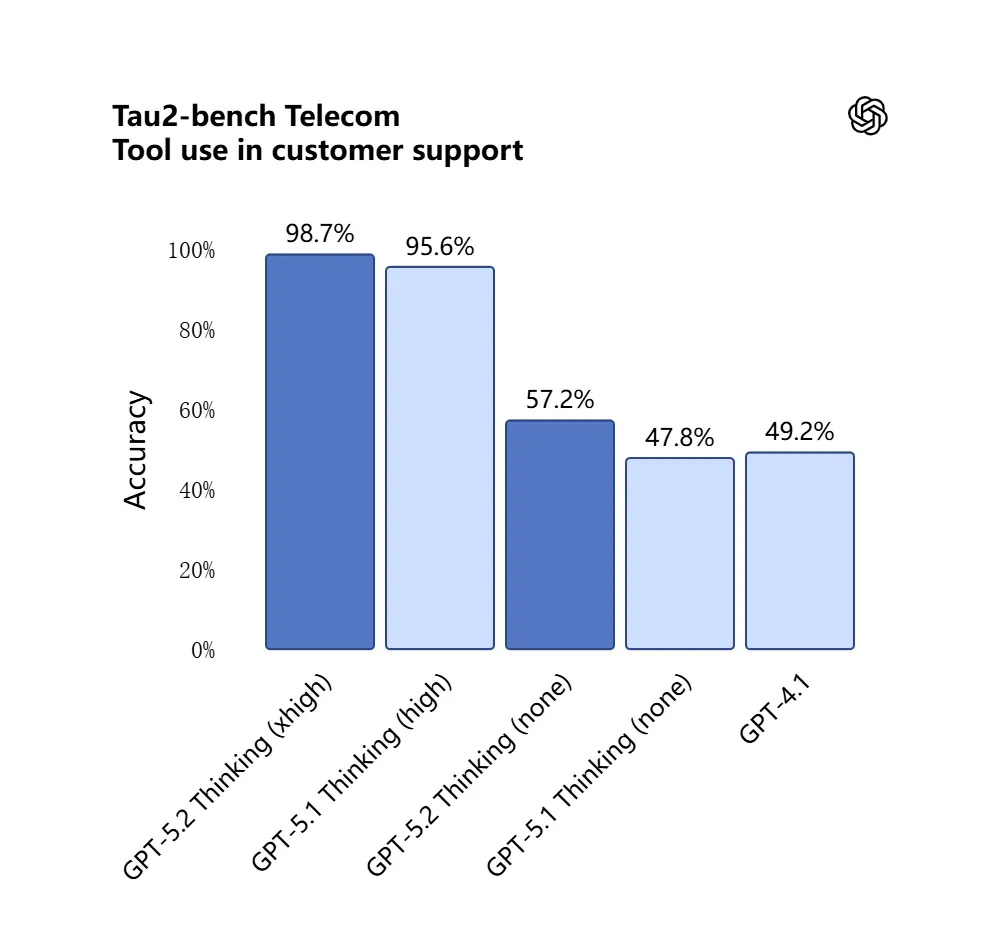

GPT-5.2 ha ottenuto il 98.7% nel benchmark Tau2-Bench Telecom, dimostrando capacità mature di tool‑calling in compiti complessi multi‑turno.

Perché è importante: ciò rende GPT-5.2 più utile come assistente autonomo per workflow come “acquisisci questi contratti, estrai le clausole, aggiorna un foglio di calcolo e scrivi un’email di riepilogo” — attività che in precedenza richiedevano un’accurata orchestrazione.

5) Capacità di programmazione evolute

GPT-5.2 è nettamente migliore nei compiti di ingegneria del software: scrive moduli più completi, genera ed esegue test con maggiore affidabilità, comprende grafi di dipendenze di progetto complessi ed è meno incline al “coding pigro” (saltare boilerplate o non collegare i moduli tra loro). Su benchmark di coding a livello industriale (SWE-bench Pro, ecc.) GPT-5.2 stabilisce nuovi record. Per i team che usano LLM come pair‑programmer, questo miglioramento può ridurre la verifica manuale e il rework richiesti dopo la generazione.

Nel test SWE-Bench Pro (compito reale di ingegneria del software industriale), il punteggio di GPT-5.2 Thinking è migliorato a 55.6%, mentre ha raggiunto anche un nuovo massimo dell’80% nel test SWE-Bench Verified.

_Software%20engineering.webp)

Nelle applicazioni pratiche, questo significa:

- Il debug automatico del codice in ambiente di produzione porta a una maggiore stabilità;

- Supporto per programmazione multi‑linguaggio (non limitata a Python);

- Capacità di completare in modo indipendente attività di riparazione end‑to‑end.

Quali sono le differenze tra GPT-5.2 e GPT-5.1?

In breve: GPT-5.2 è un miglioramento iterativo ma sostanziale. Mantiene l’architettura e le basi multimodali della famiglia GPT-5, ma avanza in quattro dimensioni pratiche:

- Profondità e coerenza del ragionamento. 5.2 introduce livelli di sforzo di ragionamento più elevati e una concatenazione migliore per problemi multi‑passo; 5.1 aveva migliorato il ragionamento in precedenza, ma 5.2 alza l’asticella per matematica complessa e logica multi‑stadio.

- Affidabilità su contesti lunghi. Entrambe le versioni hanno esteso il contesto, ma 5.2 è ottimizzata per mantenere l’accuratezza in profondità su input molto lunghi (OpenAI sostiene una ritenzione migliorata fino a centinaia di migliaia di token).

- Visione + fedeltà multimodale. 5.2 migliora il cross‑referencing tra immagini e testo — ad esempio, leggendo un grafico e integrando quei dati in un foglio di calcolo — mostrando un’accuratezza più elevata a livello di compito.

- Comportamento agentico degli strumenti e funzionalità API. 5.2 espone nuovi parametri di sforzo di ragionamento (

xhigh) e funzionalità di compattazione del contesto nell’API, e OpenAI ha affinato la logica di routing in ChatGPT così che l’interfaccia possa scegliere automaticamente la variante migliore. - Meno errori, maggiore stabilità: GPT-5.2 riduce il suo "tasso di illusione" (tasso di risposte false) del 38%. Risponde a domande di ricerca, scrittura e analisi in modo più affidabile, riducendo i casi di "fatti inventati". In compiti complessi, il suo output strutturato è più chiaro e la logica più stabile. Nel frattempo, la sicurezza delle risposte del modello è significativamente migliorata nei compiti legati alla salute mentale. Si comporta in modo più robusto in scenari sensibili come salute mentale, autolesionismo, suicidio e dipendenza emotiva.

Nelle valutazioni di sistema, GPT-5.2 Instant ha ottenuto 0.995 (su 1.0) nel compito "Supporto alla salute mentale", significativamente più alto di GPT-5.1 (0.883).

Quantitativamente, i benchmark pubblicati da OpenAI mostrano guadagni misurabili su GDPval, benchmark di matematica (FrontierMath) e valutazioni di ingegneria del software. GPT-5.2 supera GPT-5.1 nei compiti di fogli di calcolo tipici del junior investment banking di alcuni punti percentuali.

GPT-5.2 è gratuito — quanto costa?

Posso usare GPT-5.2 gratuitamente?

OpenAI ha distribuito GPT-5.2 partendo dai piani ChatGPT a pagamento e dall’accesso API. Storicamente, OpenAI ha mantenuto i modelli più rapidi/profondi dietro livelli a pagamento pur rendendo disponibili varianti più leggere più ampiamente in seguito; con 5.2 l’azienda ha dichiarato che la distribuzione sarebbe iniziata sui piani a pagamento (Plus, Pro, Business, Enterprise) e che l’API è disponibile per gli sviluppatori. Ciò significa che l’accesso gratuito immediato è limitato: il livello gratuito potrebbe ricevere accesso degradato o instradato (ad esempio verso sotto‑varianti più leggere) più avanti, man mano che OpenAI scala il rollout.

La buona notizia è che CometAPI ora si integra con GPT-5.2, ed è attualmente in promozione natalizia. Ora puoi usare GPT-5.2 tramite CometAPI; il playground ti consente di interagire liberamente con GPT-5.2, e gli sviluppatori possono usare l’API GPT-5.2 (CometAPI è prezzato al 20% rispetto a OpenAI) per costruire workflow.

Quanto costa via API (uso sviluppatore / produzione)?

L’uso dell’API è fatturato per token. I prezzi della piattaforma pubblicati da OpenAI al lancio mostrano (CometAPI è prezzato al 20% rispetto a OpenAI):

- GPT-5.2 (chat standard) — $1.75 per 1M token di input e $14 per 1M token di output (si applicano sconti sugli input memorizzati in cache).

- GPT-5.2 Pro (flagship) — $21 per 1M token di input e $168 per 1M token di output (significativamente più costoso perché pensato per carichi di lavoro ad alta accuratezza e ad alto consumo di calcolo).

- In confronto, GPT-5.1 era più economico (ad es., $1.25 in / $10 out per 1M token).

Interpretazione: i costi dell’API sono aumentati rispetto alle generazioni precedenti; il prezzo indica che il ragionamento premium e le prestazioni su contesti lunghi di 5.2 sono prezzati come un livello di prodotto distinto. Per i sistemi di produzione, i costi del piano dipendono fortemente da quanti token si inviano/producono e da quanto spesso si riutilizzano input memorizzati in cache (gli input memorizzati in cache ricevono forti sconti).

Cosa significa in pratica

- Per uso occasionale tramite l’interfaccia di ChatGPT, i piani di abbonamento mensili (Plus, Pro, Business, Enterprise) sono il percorso principale. I prezzi dei livelli di abbonamento ChatGPT non sono cambiati con la release 5.2 (OpenAI mantiene stabili i prezzi dei piani anche se l’offerta di modelli cambia).

- Per uso in produzione e per sviluppatori, prevedi un budget per i costi dei token. Se la tua app invia in streaming molte risposte lunghe o elabora documenti estesi, il prezzo dei token di output ($14 / 1M token per Thinking) dominerà i costi a meno che tu non memorizzi accuratamente in cache gli input e riutilizzi gli output.

GPT-5.2 Instant vs GPT-5.2 Thinking vs GPT-5.2 Pro

OpenAI ha lanciato GPT-5.2 con tre varianti mirate allo scopo per soddisfare i casi d’uso: Instant, Thinking e Pro:

- GPT-5.2 Instant: Veloce, conveniente, ottimizzato per il lavoro quotidiano — FAQ, how‑to, traduzioni, bozze rapide. Latenza più bassa; buone prime bozze e workflow semplici.

- GPT-5.2 Thinking: Risposte più profonde e di qualità superiore per lavoro prolungato — sintesi di documenti lunghi, pianificazione multi‑passo, code review dettagliate. Latenza bilanciata e qualità; il ‘cavallo da tiro’ predefinito per compiti professionali.

- GPT-5.2 Pro: Qualità e affidabilità più alte. Più lento e costoso; ideale per compiti difficili e ad alto rischio (ingegneria complessa, sintesi legali, decisioni di alto valore) e quando è richiesto uno sforzo di ragionamento ‘xhigh’.

Tabella di confronto

| Caratteristica / Metrica | GPT-5.2 Instant | GPT-5.2 Thinking | GPT-5.2 Pro |

|---|---|---|---|

| Uso previsto | Attività quotidiane, bozze rapide | Analisi profonda, documenti lunghi | Qualità più alta, problemi complessi |

| Latenza | La più bassa | Moderata | La più alta |

| Sforzo di ragionamento | Standard | Alto | xHigh disponibile |

| Ottimo per | FAQ, tutorial, traduzioni, prompt brevi | Sintesi, pianificazione, fogli di calcolo, coding | Ingegneria complessa, sintesi legali, ricerca |

| Esempi di nome API | gpt-5.2-chat-latest | gpt-5.2 | gpt-5.2-pro |

| Prezzo token di input (API) | $1.75 / 1M | $1.75 / 1M | $21 / 1M |

| Prezzo token di output (API) | $14 / 1M | $14 / 1M | $168 / 1M |

| Disponibilità (ChatGPT) | Rollout; piani a pagamento poi più ampio | Rollout sui piani a pagamento | Utenti Pro / Enterprise (a pagamento) |

| Esempio di caso d’uso tipico | Scrivere email, piccoli snippet di codice | Creare modello finanziario multi‑foglio, Q&A su report lunghi | Audit del codebase, generare design di sistema di produzione |

Chi è adatto a usare GPT-5.2?

GPT-5.2 è progettato pensando a un ampio set di utenti target. Di seguito raccomandazioni basate sui ruoli:

Imprese e team di prodotto

Se costruisci prodotti per il knowledge work (assistenti di ricerca, revisione contratti, pipeline di analisi o strumenti per sviluppatori), le capacità di contesto lungo e agentiche di GPT-5.2 possono ridurre significativamente la complessità di integrazione. Le imprese che necessitano di una comprensione robusta dei documenti, report automatizzati o copiloti intelligenti troveranno utili Thinking/Pro. Microsoft e altri partner di piattaforma stanno già integrando 5.2 negli stack di produttività (ad es., Microsoft 365 Copilot).

Sviluppatori e team di ingegneria

I team che vogliono usare LLM come pair‑programmer o automatizzare generazione/test del codice trarranno beneficio dalla maggiore fedeltà di programmazione in 5.2. L’accesso API (con modalità thinking o pro) abilita sintesi più profonde di grandi codebase grazie alla finestra di contesto da 400k token. Aspettati di pagare di più sull’API quando usi Pro, ma la riduzione del debug e della revisione manuale può giustificare quel costo per sistemi complessi.

Ricercatori e analisti con grandi volumi di dati

Se sintetizzi regolarmente letteratura, analizzi lunghi report tecnici o desideri progettazione di esperimenti assistita dal modello, il contesto lungo e i miglioramenti matematici di GPT-5.2 aiutano ad accelerare i workflow. Per ricerche riproducibili, abbina il modello a un prompt engineering attento e passaggi di verifica.

Piccole imprese e utenti esperti

ChatGPT Plus (e Pro per gli utenti esperti) riceverà accesso instradato alle varianti 5.2; ciò rende l’automazione avanzata e output di alta qualità alla portata di team più piccoli senza costruire un’integrazione API. Per utenti non tecnici che necessitano di una migliore sintesi di documenti o creazione di slide, GPT-5.2 offre un valore pratico evidente.

Note pratiche per sviluppatori e operatori

Funzionalità API da tenere d’occhio

- Livelli di

reasoning.effort(ad es.,medium,high,xhigh) ti permettono di indicare al modello quanta computazione spendere nel ragionamento interno; usalo per scambiare latenza con accuratezza per richiesta. - Compattazione del contesto: l’API include strumenti per comprimere e compattare la cronologia in modo che il contenuto realmente rilevante sia preservato per catene lunghe. Questo è critico quando devi mantenere l’uso effettivo di token gestibile.

- Scaffolding degli strumenti e controlli degli strumenti consentiti: i sistemi di produzione dovrebbero consentire esplicitamente una whitelist di ciò che il modello può invocare e registrare le chiamate agli strumenti per auditing.

Suggerimenti per il controllo dei costi

- Metti in cache gli embedding di documenti usati di frequente e usa input memorizzati in cache (che ricevono forti sconti) per query ripetute sullo stesso corpus. I prezzi della piattaforma di OpenAI includono sconti significativi per input memorizzati in cache.

- Instrada le query esplorative/a basso valore verso Instant e riserva Thinking/Pro per job batch o passaggi finali.

- Stima con attenzione l’uso dei token (input + output) quando proietti i costi dell’API perché output lunghi moltiplicano il costo.

In sintesi — dovresti passare a GPT-5.2?

Se il tuo lavoro dipende dal ragionamento su documenti lunghi, sintesi tra documenti, interpretazione multimodale (immagini + testo) o dalla creazione di agenti che chiamano strumenti, GPT-5.2 è un chiaro upgrade: aumenta l’accuratezza pratica e riduce il lavoro di integrazione manuale. Se esegui principalmente chatbot ad alto volume e bassa latenza o applicazioni con budget stretti, Instant (o modelli precedenti) può essere ancora una scelta ragionevole.

GPT-5.2 rappresenta un passaggio deliberato da “chat migliore” a “assistente professionale migliore”: più calcolo, più capacità e livelli di costo più elevati — ma anche veri guadagni di produttività per i team che possono sfruttare contesto lungo affidabile, matematica/ragionamento migliorati, comprensione di immagini ed esecuzione agentica di strumenti.

Per iniziare, esplora le funzionalità dei modelli GPT-5.2(GPT-5.2;GPT-5.2 pro, GPT-5.2 chat ) nel Playground e consulta la Guida API per istruzioni dettagliate. Prima di accedere, assicurati di aver effettuato l’accesso a CometAPI e di aver ottenuto la chiave API. CometAPI offre un prezzo di gran lunga inferiore a quello ufficiale per aiutarti nell’integrazione.

Pronti a partire?→ Prova gratuita dei modelli gpt-5.2 !