Kimi K2 rappresenta un significativo passo avanti nei modelli linguistici open source di grandi dimensioni, combinando un'architettura all'avanguardia con un mix di esperti e una formazione specializzata per attività di agentic. Di seguito, ne esploriamo le origini, la progettazione, le prestazioni e le considerazioni pratiche per l'accesso e l'utilizzo.

Cos'è Kimi K2?

Kimi K2 è un modello linguistico basato su una miscela di esperti (MoE) da trilioni di parametri, sviluppato da Moonshot AI. Presenta 32 miliardi di parametri "attivati" – quelli coinvolti per token – e un conteggio totale di parametri esperti di 1 trilione, consentendo una capacità enorme senza costi di inferenza lineare. Basato sull'ottimizzatore Muon, Kimi K2 è stato addestrato su oltre 15.5 trilioni di token, raggiungendo stabilità a scale precedentemente considerate impraticabili. Il modello è offerto in due varianti principali:

Kimi‑K2‑Istruisci: Pre-ottimizzato per applicazioni conversazionali e agentive, pronto per l'implementazione immediata in sistemi di dialogo e flussi di lavoro abilitati da strumenti.

Kimi‑K2‑Base: Un modello di base adatto alla ricerca, alla messa a punto personalizzata e alla sperimentazione di basso livello.

Come funziona la sua architettura?

- Mix di esperti (MoE): A ogni livello, un meccanismo di controllo seleziona un piccolo sottoinsieme di esperti (8 su 384) per elaborare ogni token, riducendo drasticamente il calcolo per l'inferenza e mantenendo al contempo un'enorme base di conoscenza.

- Livelli specializzati: Incorpora un singolo strato denso insieme a 61 strati totali, con 64 teste di attenzione e dimensioni nascoste studiate su misura per l'efficienza del MoE.

- Contesto e vocabolario: Supporta fino a 128 K token di lunghezza di contesto e un vocabolario di 160 K token, consentendo la comprensione e la generazione di dati di lunga durata.

Perché Kimi K2 è importante?

Kimi K2 amplia i confini dell'intelligenza artificiale open source offrendo prestazioni paragonabili ai principali modelli proprietari, in particolare nei benchmark di codifica e ragionamento.

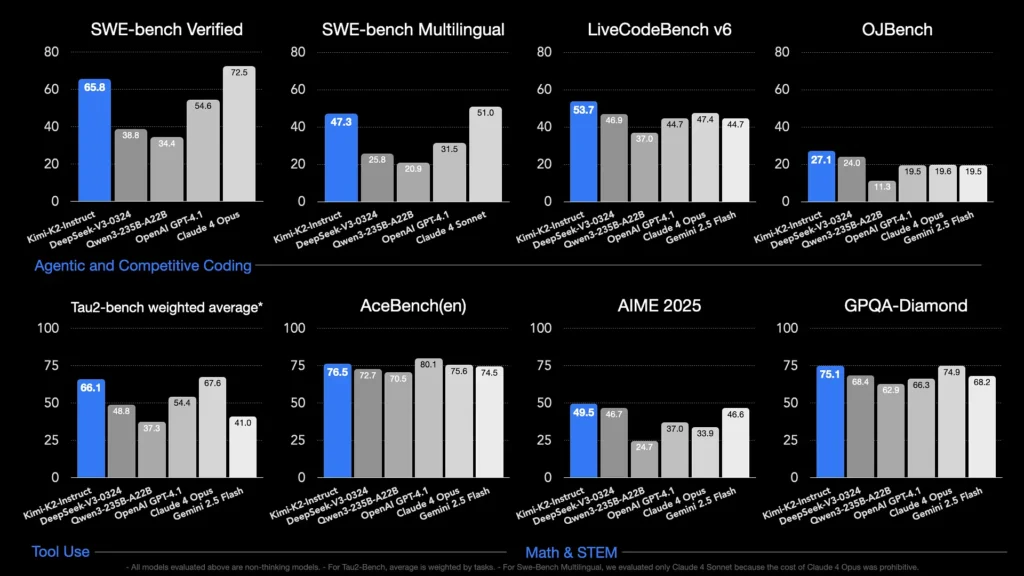

Quali parametri di riferimento ne mettono in mostra le capacità?

- LiveCodeBench v6: Raggiunge un tasso di superamento del test del 1%, superando i modelli open source e rivaleggiando con i sistemi chiusi come GPT-53.7 (4.1%).

- SWE-bench verificato: Ha ottenuto un punteggio del 65.8%, superando il 4.1% di GPT-54.6 e risultando secondo solo a Claude Sonnet 4 nei test comparativi disponibili al pubblico.

- MultiPL‑E e OJBench: Dimostra una solida capacità di codifica multilingue (85.7% su MultiPL-E) e prestazioni affidabili nelle sfide di programmazione del mondo reale.

- Matematica-500: Raggiunge il 97.4%, superando il 4.1% di GPT-92.4, dimostrando la sua abilità nel ragionamento matematico formale.

Come è ottimizzato per le attività agentiche?

Oltre alla generazione grezza, Kimi K2 è stato addestrato con scenari sintetici di utilizzo di strumenti – dati del Model Context Protocol (MCP) – per richiamare strumenti esterni, ragionare attraverso processi multi-step e risolvere autonomamente i problemi. Questo lo rende particolarmente adatto ad ambienti come Cline, dove può orchestrare l'esecuzione del codice, l'interazione con le API e l'automazione del flusso di lavoro in modo fluido.

Come posso accedere a Kimi K2?

Le opzioni di accesso spaziano dalle piattaforme ufficiali, alle distribuzioni open source, fino alle integrazioni di terze parti, soddisfacendo le esigenze di ricerca, sviluppo e aziendali.

Piattaforma ufficiale Moonshot AI

Moonshot AI offre inferenza ospitata tramite la sua piattaforma, fornendo accesso API a bassa latenza per entrambe le varianti Kimi-K2-Base e Kimi-K2-Instruct. Il prezzo è suddiviso in livelli in base al consumo di elaborazione, con piani aziendali che includono supporto prioritario e distribuzioni on-premise. Gli utenti possono registrarsi sul sito web di Moonshot AI e recuperare le chiavi API per un'integrazione immediata.

CometaAPI

CometAPI ha già integrato K2 nella sua offerta. Combina l'inferenza K2 con un'infrastruttura GPU gestita, garanzie SLA e livelli di prezzo scalabili, consentendo alle organizzazioni di scegliere tra l'utilizzo dell'API a consumo o la capacità riservata con sconti sul volume.

CometAPI è una piattaforma API unificata che aggrega oltre 500 modelli di intelligenza artificiale (IA) di provider leader, come la serie GPT di OpenAI, Gemini di Google, Claude di Anthropic, Midjourney, Suno e altri, in un'unica interfaccia intuitiva per gli sviluppatori. Offrendo autenticazione, formattazione delle richieste e gestione delle risposte coerenti, CometAPI semplifica notevolmente l'integrazione delle funzionalità di IA nelle tue applicazioni.

Gli sviluppatori possono accedere API Kimi K2(kimi-k2-0711-preview)Attraverso CometaAPIPer iniziare, esplora le capacità del modello in Parco giochi e consultare il Guida APIper istruzioni dettagliate. Prima di accedere, assicurati di aver effettuato l'accesso a CometAPI e di aver ottenuto la chiave API.

Integrazioni di strumenti di terze parti

- Cline: Un popolare IDE incentrato sul codice che supporta nativamente Kimi K2 tramite

cline:moonshotai/kimi-k2provider, che offre agli sviluppatori l'accesso con un clic alla chat, alla generazione di codice e ai flussi di lavoro agentici all'interno del loro editor. - Spazi per il viso avvolgenti: Demo ospitate dalla community e interfacce utente minimali consentono agli utenti di interagire con i modelli K2-Instruct direttamente nel browser. È richiesto un account Hugging Face e le prestazioni possono variare in base alle risorse di backend condivise.

Come si usa Kimi K2?

Una volta scelto un metodo di accesso, puoi utilizzare K2 per una varietà di attività: dalla chat all'esecuzione di codice fino agli agenti autonomi.

Tramite API o piattaforma SDK

- Autentica: Recupera la tua chiave API da Moonshot AI o CometAPI.

- Inizializza il client: Utilizzare l'SDK ufficiale (Python/JavaScript) o le richieste HTTP standard.

- Scegli la variante del modello:

- Kimi‑K2‑Base per la messa a punto e la ricerca.

- Kimi‑K2‑Istruisci per chat e agenti plug-and-play.

- Il modello di CometAPI:

kimi-k2-0711-preview

- Invia richieste: Formattare gli input in base al modello di chat (ruoli di sistema, utente, assistente) per sfruttare al meglio il comportamento di esecuzione delle istruzioni.

Esecuzione locale con llama.cpp

Per configurazioni offline o self-hosted, utilizzare i pesi GGUF quantizzati Unsloth (245 GB per la quantità dinamica a 1.8 bit).

- Scarica i pesi: Dal repository GitHub o Hugging Face di Moonshot AI.

- Installa llama.cpp: Assicurati di avere a disposizione un disco sufficiente (≥ 250 GB) e una combinazione di RAM+VRAM (≥ 250 GB) per una velocità di trasmissione di circa 5 token/s.

- Modello di lancio:

./main --model kimi-k2-gguf.q8_0 --prompt "Your prompt here" - Regola le impostazioni: Utilizzare i parametri consigliati (

rope_freq_base,context_len) documentato nella guida Unsloth per prestazioni stabili.

Integrazioni con strumenti di sviluppo

- Plugin IDE: Diversi plugin della community abilitano K2 negli IDE VS Code, Neovim e JetBrains. La configurazione in genere richiede di specificare l'endpoint API e l'ID del modello nelle impostazioni.

- Framework di automazione: Sfrutta il core agentic di K2 con framework come LangChain o Haystack per concatenare prompt, chiamate API e fasi di esecuzione del codice in automazioni complesse.

Quali sono i casi d'uso tipici per Kimi K2?

La combinazione di scalabilità, formazione agentiva e accesso aperto di K2 lo rende versatile in diversi ambiti.

Assistenza alla codifica

Dalla generazione di boilerplate e refactoring alla correzione di bug e alla profilazione delle prestazioni, i benchmark di codifica SOTA di K2 si traducono in guadagni di produttività concreti, spesso superando le alternative in termini di leggibilità e semplicità.

Conoscenza e ragionamento

Con una lunghezza di contesto di 128 K, K2 gestisce documenti lunghi, domande e risposte multi-documento e ragionamenti a catena. La sua architettura MoE garantisce la conservazione di conoscenze eterogenee senza dimenticanze catastrofiche.

Flussi di lavoro agentici

K2 eccelle nell'orchestrazione di attività in più fasi, come il recupero di dati, l'invocazione di API, l'aggiornamento di basi di codice e il riepilogo dei risultati, rendendolo ideale per assistenti autonomi nell'assistenza clienti, nell'analisi dei dati e in DevOps.

Come si confronta Kimi K2 con altri modelli open source?

Mentre le recenti release di V3 di DeepSeek e Meta hanno dominato le notizie all'inizio del 2025, Kimi K2 si differenzia per:

Intelligenza Agentica

Kimi K2 è stato progettato specificamente per flussi di lavoro "agentici", automatizzando le attività tramite chiamate di strumenti, comandi shell, automazione web e integrazioni API. Il suo set di dati di training, potenziato e auto-riproducibile, include diversi esempi di chiamate di strumenti, consentendo una perfetta integrazione con i sistemi reali.

Razionalizzazione dei costi

Con un costo di inferenza per token inferiore di circa l'80-90% rispetto a modelli come Claude Sonnet 4, Kimi K2 offre prestazioni di livello aziendale senza prezzi esorbitanti, favorendo una rapida adozione tra gli sviluppatori attenti al prezzo.

Licenze e accessibilità

A differenza di alcune versioni open source gravate da licenze restrittive, Kimi K2 è disponibile con una licenza permissiva che consente l'uso commerciale, lavori derivati e distribuzioni locali, in linea con la filosofia open source di Moonshot AI.

- Unendo un design MoE all'avanguardia, una formazione rigorosa basata su agenti e la disponibilità open source, Kimi K2 consente a sviluppatori e ricercatori di creare applicazioni intelligenti e autonome senza costi proibitivi o ecosistemi chiusi. Che si tratti di scrivere codice, creare flussi di lavoro complessi in più fasi o sperimentare ragionamenti su larga scala, K2 offre una base versatile e ad alte prestazioni.