Kimi K2 Thinking è la nuova variante "pensante" della famiglia Kimi K2 di Moonshot AI: un modello Mixture-of-Experts (MoE) sparso e con un trilione di parametri, progettato esplicitamente per pensare mentre si agisce — ovvero, per intercalare un ragionamento approfondito basato su una catena di pensiero con chiamate di strumenti affidabili, pianificazione a lungo termine e autocontrolli automatizzati. Combina un'ampia dorsale sparsa (≈1T parametri totali, ~32B attivati per token), una pipeline di quantizzazione INT4 nativa e un design scalabile tempo di inferenza ragionamento (più "token pensanti" e più round di chiamata degli strumenti) piuttosto che un semplice aumento del numero di parametri statici.

In parole povere: K2 Thinking tratta il modello come un metodo di risoluzione dei problemi agente invece di un generatore di linguaggio one-shot. Questo passaggio – da "modello linguistico" a "modello di pensiero" – è ciò che rende questa versione degna di nota e il motivo per cui molti professionisti la considerano una pietra miliare nell'intelligenza artificiale agentiva open source.

Cos'è esattamente "Kimi K2 Thinking"?

Architettura e specifiche chiave

K2 Thinking è costruito come un modello MoE sparso (384 esperti, 8 esperti selezionati per token) con circa 1 trilione di parametri totali e al ~32B parametri attivati Per inferenza. Utilizza scelte architetturali ibride (attenzione MLA, attivazioni SwiGLU) ed è stato addestrato con l'ottimizzatore Muon/MuonClip di Moonshot su grandi budget di token, descritti nel loro rapporto tecnico. La variante di pensiero estende il modello base con quantizzazione post-addestramento (supporto INT4 nativo), una finestra di contesto di 256k e ingegneria per esporre e stabilizzare la traccia di ragionamento interna del modello durante l'uso reale.

Cosa significa “pensare” in pratica

"Pensare" qui è un obiettivo ingegneristico: consentire al modello di (1) generare lunghe catene strutturate di ragionamento interno (token di catena di pensiero), (2) richiamare strumenti esterni (ricerca, sandbox Python, browser, database) come parte di tale ragionamento, (3) valutare e autoverificare le affermazioni intermedie e (4) iterare attraverso molti di questi cicli senza compromettere la coerenza. La documentazione e la scheda modello di Moonshot mostrano K2 Thinking addestrato e ottimizzato esplicitamente per alternare ragionamento e chiamate di funzione e per mantenere un comportamento agentico stabile attraverso centinaia di passaggi.

Qual è l'obiettivo principale?

I limiti dei modelli tradizionali su larga scala sono:

- Il processo di generazione è miope e privo di logica trasversale;

- L'utilizzo degli strumenti è limitato (solitamente è possibile richiamare solo strumenti esterni una o due volte);

- Non sono in grado di autocorreggersi nei problemi complessi.

L'obiettivo principale di K2 Thinking è risolvere questi tre problemi. In pratica, K2 Thinking può, senza intervento umano: eseguire 200-300 chiamate consecutive di strumenti; mantenere centinaia di passaggi di ragionamento logicamente coerenti; risolvere problemi complessi attraverso l'autoverifica contestuale.

Riposizionamento: modello linguistico → modello di pensiero

Il progetto K2 Thinking illustra un cambiamento strategico più ampio nel campo: andare oltre la generazione di testo condizionale verso risolutori di problemi agentiL'obiettivo principale non è principalmente quello di migliorare la perplessità o la previsione del token successivo, ma di creare modelli in grado di:

- Pianifica le proprie strategie multi-fase;

- Coordinare strumenti ed effettori esterni (ricerca, esecuzione di codice, basi di conoscenza);

- Verifica risultati intermedi e correggere gli errori;

- Sostenere coerenza tra contesti lunghi e lunghe catene di strumenti.

Questa riformulazione modifica sia la valutazione (i parametri di riferimento enfatizzano i processi e i risultati, non solo la qualità del testo) sia l'ingegneria (strutture per il routing degli strumenti, il conteggio dei passaggi, l'autocritica, ecc.).

Metodi di lavoro: come funzionano i modelli di pensiero

Nella pratica, K2 Thinking dimostra diversi metodi di lavoro che caratterizzano l'approccio del "modello di pensiero":

- Tracce interne persistenti: Il modello produce passaggi intermedi strutturati (tracce di ragionamento) che vengono mantenuti nel contesto e possono essere riutilizzati o verificati in seguito.

- Routing dinamico degli utensili: In base a ogni passaggio interno, K2 decide quale strumento chiamare (ricerca, interprete di codice, browser web) e quando chiamarlo.

- Scalabilità del tempo di prova: Durante l'inferenza, il sistema può espandere la sua "profondità di pensiero" (più token di ragionamento interno) e aumentare il numero di chiamate agli strumenti per esplorare meglio le soluzioni.

- Autoverifica e recupero: Il modello verifica esplicitamente i risultati, esegue test di integrità e ripianifica quando i controlli falliscono.

Questi metodi combinano l'architettura del modello (MoE + contesto lungo) con l'ingegneria del sistema (orchestrazione degli strumenti, controlli di sicurezza).

Quali innovazioni tecnologiche consentono a Kimi K2 Thinking?

Il meccanismo di ragionamento di Kimi K2 Thinking supporta il pensiero intervallato e l'uso degli strumenti. Il ciclo di ragionamento di K2 Thinking:

- Comprensione del problema (analisi e astrazione)

- Generazione di un piano di ragionamento multi-step (catena di piani)

- Utilizzo di strumenti esterni (codice, browser, motore matematico)

- Verifica e revisione dei risultati (verifica e revisione)

- Concludere il ragionamento (concludere il ragionamento)

Di seguito, presenterò tre tecniche chiave che rendono possibili i cicli di ragionamento in xx.

1) Scalabilità del tempo di test

Che cosa è: Le tradizionali "leggi di scala" si concentrano sull'aumento del numero di parametri o dati durante l'addestramento. L'innovazione di K2 Thinking risiede in: l'espansione dinamica del numero di token (ovvero, la profondità di pensiero) durante la "fase di ragionamento"; l'espansione simultanea del numero di chiamate agli strumenti (ovvero, l'ampiezza dell'azione). Questo metodo è chiamato test-time scaling e il suo presupposto fondamentale è: "Una catena di ragionamento più lunga + strumenti più interattivi = un salto qualitativo nell'intelligenza effettiva".

Perché è importante: K2 Thinking ottimizza esplicitamente questo aspetto: Moonshot dimostra che l'espansione dei "token di pensiero" e del numero/profondità delle chiamate degli strumenti produce miglioramenti misurabili nei benchmark agentici, consentendo al modello di superare altri modelli di dimensioni simili o maggiori in scenari FLOP-matched.

2) Ragionamento potenziato dagli strumenti

Che cosa è: K2 Thinking è stato progettato per analizzare in modo nativo gli schemi degli strumenti, decidere autonomamente quando richiamare uno strumento e incorporare i risultati degli strumenti nel suo flusso di ragionamento in corso. Moonshot ha addestrato e ottimizzato il modello per intervallare la catena di pensiero con le chiamate di funzione, quindi ha stabilizzato questo comportamento in centinaia di passaggi sequenziali dello strumento.

Perché è importante: Questa combinazione (analisi affidabile + stato interno stabile + strumenti API) è ciò che consente al modello di navigare sul Web, eseguire codice e orchestrare flussi di lavoro in più fasi come parte di un'unica sessione.

All'interno della sua architettura interna, il modello forma una traiettoria di esecuzione del "processo di pensiero visualizzato": prompt → token di ragionamento → chiamata dello strumento → osservazione → ragionamento successivo → risposta finale

3) Coerenza a lungo termine e autoverifica

Che cosa è: La coerenza a lungo orizzonte è la capacità del modello di mantenere un piano e uno stato interno coerenti attraverso molti passaggi e in contesti molto lunghi. L'autoverifica implica che il modello controlli proattivamente i suoi output intermedi e riesegua o riveda i passaggi quando una verifica fallisce. I compiti lunghi spesso causano deviazioni o allucinazioni nei modelli. K2 Thinking affronta questo problema con diverse tecniche: finestre di contesto molto lunghe (256k), strategie di addestramento che preservano lo stato attraverso lunghe sequenze CoT e modelli di fedeltà/giudice espliciti a livello di frase per rilevare affermazioni non supportate.

Perché è importante: Il meccanismo di "Memoria di Ragionamento Ricorrente" mantiene la persistenza dello stato di ragionamento, conferendogli caratteristiche di "stabilità di pensiero" e di "auto-supervisione contestuale" simili a quelle umane. Poiché i compiti si estendono su più fasi (ad esempio, progetti di ricerca, attività di codifica multi-file, lunghi processi editoriali), mantenere un singolo thread coerente diventa essenziale. L'autoverifica riduce gli errori silenziosi; anziché restituire una risposta plausibile ma errata, il modello può rilevare incongruenze e consultare nuovamente gli strumenti o ripianificare.

funzionalità:

- Coerenza contestuale: mantiene la continuità semantica su oltre 10 token;

- Rilevamento e ripristino degli errori: identifica e corregge le deviazioni logiche nei primi processi di pensiero;

- Ciclo di autoverifica: verifica automaticamente la ragionevolezza della risposta una volta completato il ragionamento;

- Fusione del ragionamento multi-percorso: seleziona il percorso ottimale da più catene logiche.

Quali sono le quattro capacità principali di K2 Thinking?

Ragionamento profondo e strutturato

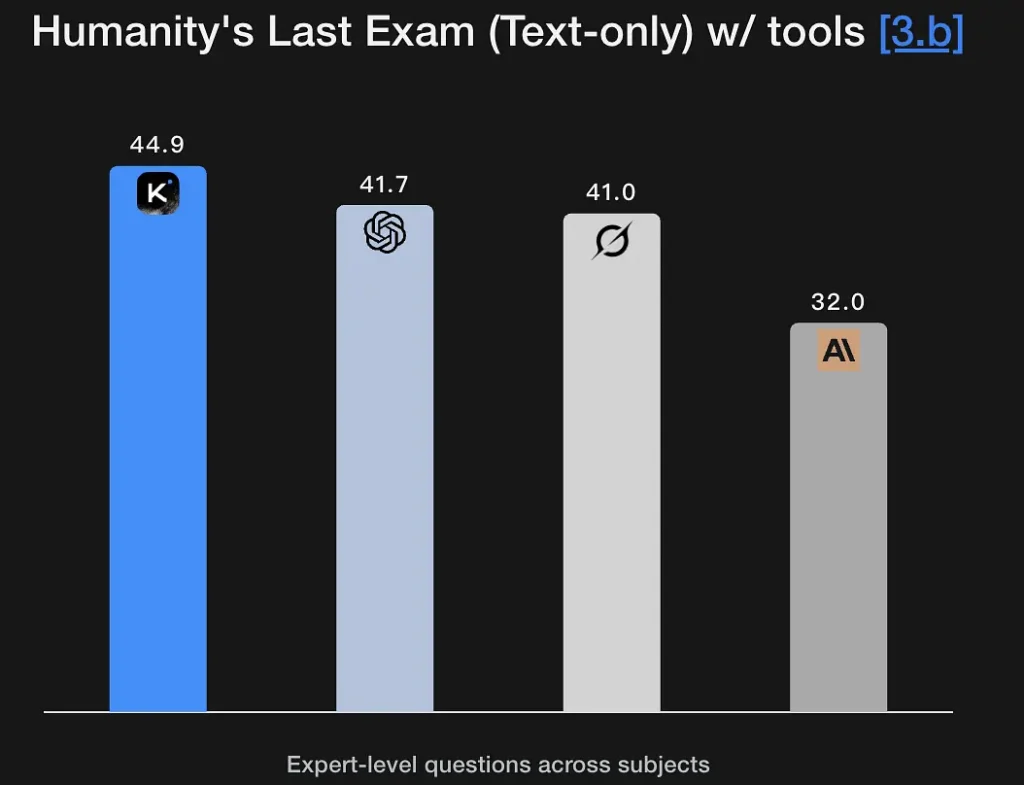

K2 Thinking è ottimizzato per generare tracce di ragionamento esplicite e multifase e utilizzarle per giungere a conclusioni solide. Il modello ottiene punteggi elevati nei benchmark di matematica e ragionamento rigoroso (benchmark in stile GSM8K, AIME, IMO) e dimostra la capacità di mantenere intatto il ragionamento su lunghe sequenze, un requisito fondamentale per la risoluzione di problemi di livello di ricerca. Le sue eccellenti prestazioni nell'Ultimo Esame dell'Umanità (44.9%) dimostrano capacità analitiche di livello esperto. È in grado di estrarre framework logici da descrizioni semantiche fuzzy e di generare grafici di ragionamento.

Caratteristiche principali:

- Supporta il ragionamento simbolico: comprende e utilizza strutture matematiche, logiche e di programmazione.

- Possiede capacità di verifica delle ipotesi: può proporre e verificare spontaneamente ipotesi.

- Può eseguire la scomposizione dei problemi in più fasi: scompone obiettivi complessi in più sottoattività.

Ricerca agentica

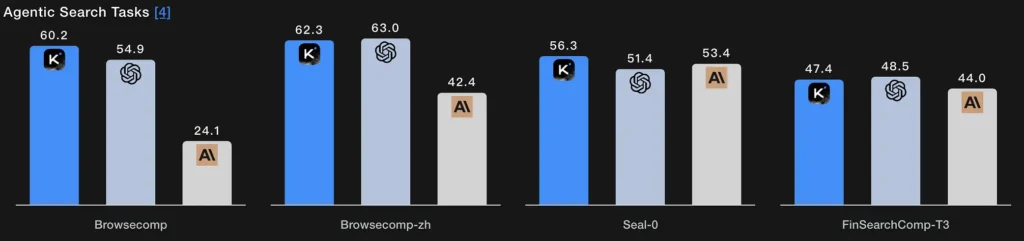

Invece di un singolo passaggio di recupero, la ricerca agentica consente al modello di pianificare una strategia di ricerca (cosa cercare), eseguirla tramite ripetute chiamate web/strumenti, sintetizzare i risultati in arrivo e perfezionare la query. I punteggi di BrowseComp e Seal-0 di K2 Thinking, abilitati dagli strumenti, indicano ottime prestazioni in questa funzionalità; il modello è progettato esplicitamente per supportare ricerche web multi-round con pianificazione con stato.

Essenza tecnica:

- Il modulo di ricerca e il modello linguistico formano un ciclo chiuso: generazione di query → recupero della pagina web → filtraggio semantico → fusione del ragionamento.

- Il modello può adattare la propria strategia di ricerca in modo adattivo, ad esempio cercando prima le definizioni, poi i dati e infine verificando le ipotesi.

- In sostanza, si tratta di un'intelligenza composita di "recupero di informazioni + comprensione + argomentazione".

Codifica agentica

Questa è la capacità di scrivere, eseguire, testare e iterare sul codice come parte di un ciclo di ragionamento. K2 Thinking ottiene risultati competitivi nei benchmark di live coding e verifica del codice, supporta toolchain Python nelle sue chiamate di strumenti e può eseguire cicli di debug multi-step chiamando una sandbox, leggendo gli errori e riparando il codice in passaggi ripetuti. I suoi punteggi EvalPlus/LiveCodeBench riflettono questi punti di forza. Il raggiungimento di un punteggio del 71.3% nel test SWE-Bench Verified significa che è in grado di completare correttamente oltre il 70% delle attività di riparazione software reali.

Dimostra inoltre prestazioni stabili nell'ambiente competitivo LiveCodeBench V6, evidenziando le sue capacità di implementazione e ottimizzazione degli algoritmi.

Essenza tecnica:

- Adotta un processo di “analisi semantica + refactoring a livello AST + verifica automatica”;

- L'esecuzione e il test del codice vengono eseguiti tramite chiamate di strumenti a livello di esecuzione;

- Realizza uno sviluppo automatizzato a ciclo chiuso dalla comprensione del codice → diagnosi degli errori → generazione di patch → verifica del successo.

Scrittura agentica

Oltre alla prosa creativa, la scrittura agentica è una produzione di documenti strutturata e orientata a un obiettivo che può richiedere ricerca esterna, citazioni, generazione di tabelle e perfezionamento iterativo (ad esempio, produrre una bozza → verificare i fatti → rivedere). Il contesto esteso e l'orchestrazione degli strumenti di K2 Thinking lo rendono adatto a flussi di lavoro di scrittura in più fasi (brief di ricerca, riassunti di regolamenti, contenuti multi-capitolo). Le percentuali di vittoria aperte del modello nei test in stile Arena e le metriche di scrittura longform supportano questa affermazione.

Essenza tecnica:

- Genera automaticamente segmenti di testo utilizzando la pianificazione del pensiero agentico;

- Controlla internamente la logica del testo tramite token di ragionamento;

- È possibile richiamare simultaneamente strumenti quali ricerca, calcolo e generazione di grafici per ottenere una "scrittura multimodale".

Come puoi utilizzare K2 Thinking oggi?

Modalità di accesso

K2 Thinking è disponibile come versione open source (pesi del modello e checkpoint) e tramite endpoint di piattaforma e hub della community (piattaforma Hugging Face e Moonshot). È possibile effettuare l'auto-hosting se si dispone di risorse di calcolo sufficienti, oppure utilizzare CometaAPIAPI/interfaccia utente ospitata per un onboarding più rapido. Documenta anche un reasoning_content campo che, quando abilitato, mostra i token di pensiero interni al chiamante.

Consigli pratici per l'utilizzo

- Inizia con i blocchi di costruzione agentici: esporre prima un piccolo set di strumenti deterministici (ricerca, sandbox Python e un database di dati attendibile). Fornire schemi di strumenti chiari in modo che il modello possa analizzare/validare le chiamate.

- Ottimizza il calcolo in fase di test: per la risoluzione di problemi complessi, prevedere budget di analisi più ampi e più turni di chiamata degli strumenti; misurare il miglioramento della qualità rispetto a latenza/costi. Moonshot promuove la scalabilità dei tempi di test come leva primaria.

- Utilizzare le modalità INT4 per l'efficienza dei costi: K2 Thinking supporta la quantizzazione INT4, che offre accelerazioni significative; ma convalida il comportamento dei casi limite nelle tue attività.

- Ragionamento superficiale sui contenuti con attenzione: esporre le catene interne può aiutare il debug, ma aumenta anche l'esposizione a errori del modello grezzo. Trattare il ragionamento interno come diagnostica non autorevole; abbinalo alla verifica automatica.

Conclusione

Kimi K2 Thinking è una risposta deliberatamente progettata per la prossima era dell'intelligenza artificiale: non solo modelli più grandi, ma agenti che pensano, agiscono e verificanoCombina scalabilità MoE, strategie di calcolo in fase di test, inferenza nativa a bassa precisione e orchestrazione esplicita degli strumenti per consentire una risoluzione dei problemi sostenuta e articolata. Per i team che necessitano di una risoluzione dei problemi articolata e dispongono della disciplina ingegneristica necessaria per integrare, sottoporre a sandbox e monitorare sistemi agenti, K2 Thinking rappresenta un importante e concreto passo avanti, nonché un importante stress test per il modo in cui l'industria e la società governeranno un'IA sempre più efficiente e orientata all'azione.

Gli sviluppatori possono accedere Kimi K2 Thinking API tramite CometAPI, l'ultima versione del modello è sempre aggiornato con il sito ufficiale. Per iniziare, esplora le capacità del modello nel Parco giochi e consultare il Guida API per istruzioni dettagliate. Prima di accedere, assicurati di aver effettuato l'accesso a CometAPI e di aver ottenuto la chiave API. CometaAPI offrire un prezzo molto più basso rispetto al prezzo ufficiale per aiutarti a integrarti.

Pronti a partire? → Iscriviti oggi a CometAPI !

Se vuoi conoscere altri suggerimenti, guide e novità sull'IA seguici su VK, X e al Discordia!