Cos'è Llama 4?

Meta Platforms ha svelato la sua ultima suite di modelli linguistici di grandi dimensioni (LLM) nella serie Llama 4, segnando un significativo progresso nella tecnologia dell'intelligenza artificiale. La collezione Llama 4 introduce due modelli principali nell'aprile 2025: Llama 4 Scout e Llama 4 Maverick. Questi modelli sono progettati per elaborare e tradurre vari formati di dati, tra cui testo, video, immagini e audio, mostrando le loro capacità multimodali. Inoltre, Meta ha presentato in anteprima Llama 4 Behemoth, un modello imminente pubblicizzato come uno dei più potenti LLM fino ad oggi, destinato ad assistere nell'addestramento di modelli futuri.

In cosa differisce Llama 4 dai modelli precedenti?

Funzionalità multimodali migliorate

A differenza dei suoi predecessori, Llama 4 è progettato per gestire più modalità di dati senza soluzione di continuità. Ciò significa che può analizzare e generare risposte basate su testo, immagini, video e input audio, rendendolo altamente adattabile per diverse applicazioni.

Introduzione di modelli specializzati

Meta ha introdotto due versioni specializzate nella serie Llama 4:

- Lama 4 Esploratore: Un modello compatto ottimizzato per funzionare in modo efficiente su una singola GPU Nvidia H100. Vanta una finestra di contesto da 10 milioni di token e ha dimostrato prestazioni superiori rispetto ai concorrenti come Gemma 3 e Mistral 3.1 di Google in vari benchmark.

- Lama 4 Maverick: Un modello più grande, paragonabile in termini di prestazioni a GPT-4o e DeepSeek-V3 di OpenAI, che eccelle in particolare nelle attività di codifica e ragionamento, utilizzando al contempo un minor numero di parametri attivi.

Inoltre, Meta sta sviluppando Lama 4 Behemoth, un modello con 288 miliardi di parametri attivi e un totale di 2 trilioni, che punta a superare modelli come GPT-4.5 e Claude Sonnet 3.7 nei benchmark STEM.

Adozione dell'architettura Mixture of Experts (MoE)

Llama 4 impiega un'architettura "mixture of experts" (MoE), dividendo il modello in unità specializzate per ottimizzare l'utilizzo delle risorse e migliorare le prestazioni. Questo approccio consente un'elaborazione più efficiente attivando solo sottoinsiemi rilevanti del modello per attività specifiche.

Come si confronta Llama 4 con altri modelli di intelligenza artificiale?

Llama 4 si posiziona in modo competitivo tra i principali modelli di intelligenza artificiale:

- Benchmark delle prestazioni: Le prestazioni di Llama 4 Maverick sono paragonabili a quelle di GPT-4o e DeepSeek-V3 di OpenAI nelle attività di codifica e ragionamento, mentre Llama 4 Scout supera modelli come Gemma 3 e Mistral 3.1 di Google in vari benchmark.

- Approccio Open Source: Meta continua a offrire modelli Llama come open source, promuovendo una più ampia collaborazione e integrazione tra le piattaforme. Tuttavia, la licenza Llama 4 impone restrizioni alle entità commerciali con oltre 700 milioni di utenti, stimolando discussioni sulla vera apertura del modello.

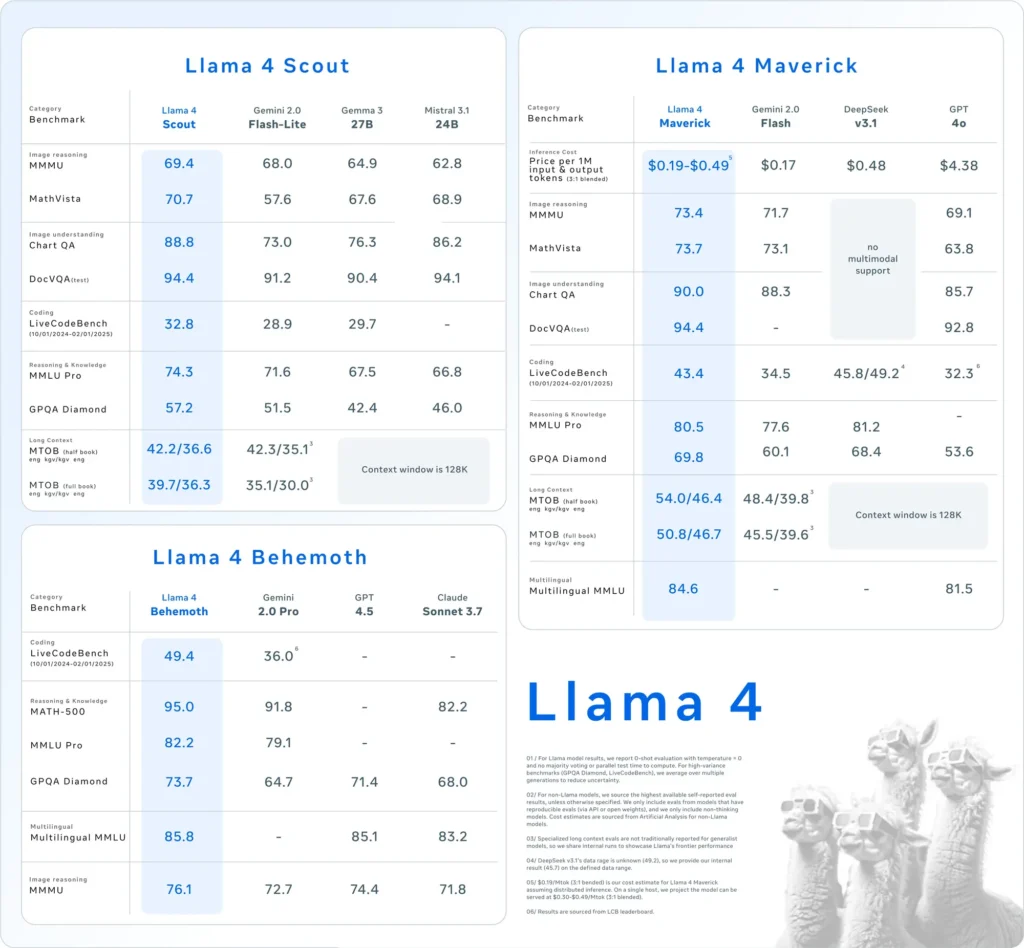

| Categoria | Segno di riferimento | Lama 4 Maverick | GPT-4o | Gemelli 2.0 Flash | Guida DeepSeek v3.1 |

|---|---|---|---|---|---|

| Ragionamento sull'immagine | MMMU | 73.4 | 69.1 | 71.7 | Nessun supporto multimodale |

| MatematicaVista | 73.7 | 63.8 | 73.1 | Nessun supporto multimodale | |

| Comprensione delle immagini | GraficoQA | 90.0 | 85.7 | 88.3 | Nessun supporto multimodale |

| DocVQA (prova) | 94.4 | 92.8 | - | Nessun supporto multimodale | |

| codifica | LiveCodeBench | 43.4 | 32.3 | 34.5 | 45.8/49.2 |

| Ragionamento e conoscenza | MMLU Pro | 80.5 | - | 77.6 | 81.2 |

| Diamante GPQA | 69.8 | 53.6 | 60.1 | 68.4 | |

| Plurilingue | MMLU multilingue | 84.6 | 81.5 | - | - |

| Contesto lungo | MTOB (mezzo libro) eng→kgv/kgv→eng | 54.0/46.4 | Contesto limitato a 128K | 48.4/39.8 | Contesto limitato a 128K |

| MTOB (libro completo) eng→kgv/kgv→eng | 50.8/46.7 | Contesto limitato a 128K | 45.5/39.6 | Contesto limitato a 128K |

Come si comporta Llama 4 nei test di benchmark?

Le valutazioni di riferimento forniscono informazioni sulle prestazioni dei modelli Llama 4:

- Lama 4 Esploratore: Questo modello supera diversi concorrenti, tra cui Gemma 3 e Mistral 3.1 di Google, in vari benchmark. La sua capacità di operare con una finestra di contesto di 10 milioni di token su una singola GPU evidenzia la sua efficienza ed efficacia nella gestione di attività complesse.

- Lama 4 Maverick: Paragonabile in termini di prestazioni a GPT-4o e DeepSeek-V3 di OpenAI, Llama 4 Maverick eccelle nelle attività di codifica e ragionamento utilizzando meno parametri attivi. Questa efficienza non va a discapito della capacità, rendendolo un forte contendente nel panorama LLM.

- Lama 4 Behemoth: Con 288 miliardi di parametri attivi e un totale di 2 trilioni, Llama 4 Behemoth supera modelli come GPT-4.5 e Claude Sonnet 3.7 nei benchmark STEM. Il suo ampio conteggio dei parametri e le sue prestazioni indicano il suo potenziale come modello fondamentale per futuri sviluppi dell'IA.

Questi risultati di riferimento sottolineano l'impegno di Meta nel migliorare le capacità dell'intelligenza artificiale e nel posizionare la serie Llama 4 come un attore formidabile nel settore.

Come possono gli utenti accedere a Llama 4?

Meta ha integrato i modelli Llama 4 nel suo assistente AI, rendendoli accessibili su piattaforme come WhatsApp, Messenger, Instagram e il web. Questa integrazione consente agli utenti di sperimentare le funzionalità avanzate di Llama 4 all'interno di applicazioni familiari.

Per sviluppatori e ricercatori interessati a sfruttare Llama 4 per applicazioni personalizzate, Meta fornisce accesso ai pesi del modello tramite piattaforme come Hugging Face e i suoi canali di distribuzione. Questo approccio open source consente alla comunità AI di innovare e basarsi sulle capacità di Llama 4.

È importante notare che, sebbene Llama 4 sia commercializzato come open source, la licenza impone restrizioni alle entità commerciali con oltre 700 milioni di utenti. Le organizzazioni dovrebbero rivedere i termini della licenza per garantire la conformità alle linee guida di Meta.

Costruisci velocemente con Llama 4 su CometAPI

CometAPI fornisce accesso a oltre 500 modelli di intelligenza artificiale, tra cui modelli multimodali open source e specializzati per chat, immagini, codice e altro. Il suo punto di forza principale risiede nella semplificazione del processo tradizionalmente complesso di integrazione dell'intelligenza artificiale. Centralizzando l'aggregazione delle API in un'unica piattaforma, consente agli utenti di risparmiare tempo e risorse preziose che altrimenti verrebbero spese nella gestione di piattaforme e provider separati. Con essa, l'accesso ai principali strumenti di intelligenza artificiale come Claude, OpenAI, Deepseek e Gemini è disponibile tramite un singolo abbonamento unificato. Puoi utilizzare l'API in CometAPI per creare musica e opere d'arte, generare video e creare i tuoi flussi di lavoro

CometaAPI offrire un prezzo molto più basso del prezzo ufficiale per aiutarti a integrare API di Llama 4, e riceverai $ 1 sul tuo account dopo esserti registrato e aver effettuato l'accesso! Benvenuto per registrarti e provare CometAPI. CometAPI paga a consumo,API di Llama 4 in CometAPI i prezzi sono strutturati come segue:

| Categoria | lama-4-non conformista | lama-4-scout |

| Prezzi dell'API | Input token: $0.48/M token | Input token: $0.216/M token |

| Token di output: $ 1.44/M di token | Token di output: $ 1.152/M di token |

- Si prega di fare riferimento a API di Llama 4 per i dettagli sull'integrazione.

- Per informazioni sul modello lanciato in Comet API, vedere https://api.cometapi.com/new-model.

- Per informazioni sul prezzo del modello in Comet API, vedere https://api.cometapi.com/pricing

Inizia a costruire CometAPI oggi – registrati qui per un accesso gratuito o scala senza limiti di velocità tramite l'aggiornamento a un Piano a pagamento CometAPI.

Quali sono le implicazioni del rilascio di Llama 4?

Integrazione tra le Meta Piattaforme

Llama 4 è integrato nell'assistente AI di Meta su piattaforme come WhatsApp, Messenger, Instagram e il web, migliorando l'esperienza utente con funzionalità AI avanzate.

Impatto sul settore dell’intelligenza artificiale

L'uscita di Llama 4 sottolinea la spinta aggressiva di Meta verso l'intelligenza artificiale, con piani di investire fino a 65 miliardi di dollari nell'espansione della sua infrastruttura di intelligenza artificiale. Questa mossa riflette la crescente competizione tra i giganti della tecnologia per guidare l'innovazione dell'intelligenza artificiale.

Considerazioni sul consumo energetico

Le ingenti risorse computazionali richieste per Llama 4 sollevano preoccupazioni circa il consumo energetico e la sostenibilità. Gestire un cluster di oltre 100,000 GPU richiede molta energia, innescando discussioni sull'impatto ambientale dei modelli di intelligenza artificiale su larga scala.

Cosa riserva il futuro per Llama 4?

Meta prevede di discutere ulteriori sviluppi e applicazioni di Llama 4 alla prossima conferenza LlamaCon del 29 aprile 2025. La comunità AI prevede approfondimenti sulle strategie di Meta per affrontare le sfide attuali e sfruttare le capacità di Llama 4 in vari settori.

In sintesi, Llama 4 rappresenta un significativo progresso nei modelli di linguaggio AI, offrendo capacità multimodali migliorate e architetture specializzate. Nonostante le sfide di sviluppo, gli investimenti sostanziali e le iniziative strategiche di Meta posizionano Llama 4 come un formidabile contendente nel panorama AI in evoluzione.