2025年XNUMX月、アリババは Qwen3-Coderは、複雑なコーディングワークフローとエージェントプログラミングタスク向けに特別に設計された、最も高度なオープンソースAIモデルです。このプロフェッショナルガイドでは、コア機能と主要なイノベーションの理解から、付属ツールのインストールと使用方法まで、必要な情報をステップバイステップで解説します。 クウェンコード エージェントスタイルのコーディングを自動化するCLIツールです。ベストプラクティス、トラブルシューティングのヒント、プロンプトとリソース割り当ての最適化方法などを学び、Qwen3-Coderを最大限に活用しましょう。

Qwen3-Coder とは何ですか? なぜ重要なのですか?

AlibabaのQwen3-Coderは、480億パラメータ、35億のアクティブパラメータを持つMixture-of-Experts(MoE)モデルであり、大規模コンテキストのコーディングタスクをサポートするために構築されています。ネイティブで256万1千トークン(外挿法を使用すれば最大23万トークン)を処理できます。2025年XNUMX月XNUMX日にリリースされたこのモデルは、「エージェントAIコーディング」における大きな飛躍を象徴しており、コード生成だけでなく、複雑なプログラミング課題を手動介入なしに自律的に計画、デバッグ、反復処理できます。

Qwen3-Coder は以前のバージョンとどう違うのでしょうか?

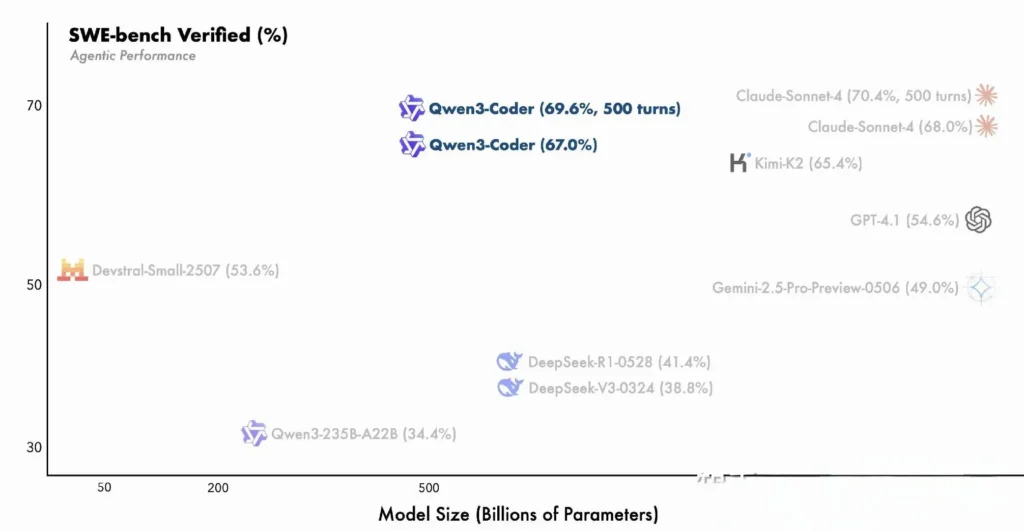

Qwen3-Coderは、Qwen3ファミリーのイノベーション(多段階推論のための「思考モード」と迅速な応答のための「非思考モード」の両方を統合)を基盤とし、タスクの複雑さに応じてモードを動的に切り替える単一の統合フレームワークです。高密度で小規模なコンテキストに限定されていたQwen2.5-Coderとは異なり、Qwen3-CoderはスパースなMixture-of-Expertsアーキテクチャを採用し、SWE-Bench VerifiedやCodeForces ELOレーティングなどのベンチマークにおいて最先端のパフォーマンスを発揮します。主要なコーディングメトリクスにおいて、AnthropicのClaudeやOpenAIのGPT-4などのモデルと同等かそれ以上の性能を発揮します。

Qwen3-Coderの主な機能:

- 巨大なコンテキストウィンドウ: ネイティブでは 256 K トークン、外挿により最大 1 M トークンまで処理できるため、コードベース全体または長いドキュメントを XNUMX 回のパスで処理できます。

- エージェント機能: コードを自律的に計画、生成、テスト、デバッグできる専用の「エージェント モード」により、手動によるエンジニアリングのオーバーヘッドが削減されます。

- 高いスループットと効率: Mixture-of-Experts 設計では、推論ごとに 35 億個のパラメータのみをアクティブ化し、パフォーマンスと計算コストのバランスをとります。

- オープンソースで拡張可能: Apache 2.0 でリリースされ、完全に文書化された API とコミュニティ主導の機能強化が GitHub で利用可能です。

- 多言語・クロスドメイン: Python、JavaScript、Go、Rust など、数十のプログラミング言語にわたる 7.5 兆トークン (70% がコード) でトレーニングされました。

開発者はどのようにして Qwen3-Coder を使い始めることができますか?

Qwen3‑Coder はどこからダウンロードしてインストールできますか?

モデルの重みと Docker イメージは次の場所から取得できます。

- GitHub: https://github.com/QwenLM/Qwen3-Coder

- 抱き合う顔: https://huggingface.co/QwenLM/Qwen3-Coder-480B-A35B-Instruct

- モデルスコープ: Alibaba公式リポジトリ

リポジトリのクローンを作成し、事前に構築された Docker コンテナをプルするだけです。

git clone https://github.com/QwenLM/Qwen3-Coder.git

cd Qwen3-Coder

docker pull qwenlm/qwen3-coder:latest

トランスフォーマーを使ったモデルのロード

from transformers import AutoModelForCausalLM, AutoTokenizer

model_name = "Qwen/Qwen3-Coder-480B-A35B-Instruct"

model = AutoModelForCausalLM.from_pretrained(

model_name,

torch_dtype="auto",

device_map="auto"

)

tokenizer = AutoTokenizer.from_pretrained(model_name)

このコードはモデルとトークナイザーを初期化し、利用可能な GPU 全体にレイヤーを自動的に分散します。

環境をどのように構成すればよいですか?

- ハードウェア要件:

- 48 GB以上のVRAMを搭載したNVIDIA GPU(A100 80 GBを推奨)

- 128~256 GBのシステムRAM

-

依存関係:

pip install -r requirements.txt # PyTorch, CUDA, tokenizers, etc. -

APIキー(オプション):

クラウドホスト型推論の場合は、ALIYUN_ACCESS_KEYおよびALIYUN_SECRET_KEY環境変数として。

エージェントコーディングに Qwen コードを使用する方法を教えてください。

ここからは、ステップバイステップで始めるためのガイドです。 Qwen3 コーダー ビア クウェンコード CLI(単に qwen):

1。 前提条件

- Node.js 20以上 (公式インストーラーまたは以下のスクリプトを使用してインストールできます)

- npmNode.jsにバンドルされている

# (Linux/macOS)

curl -qL https://www.npmjs.com/install.sh | sh

2. QwenコードCLIをインストールする

npm install -g @qwen-code/qwen-code

代わりにソースからインストールするには:

git clone https://github.com/QwenLM/qwen-code.git

cd qwen-code

npm install

npm install -g

3. 環境を設定する

Qwenコードは OpenAI対応 内部のAPIインターフェース。以下の環境変数を設定してください。

export OPENAI_API_KEY="your_api_key_here"

export OPENAI_BASE_URL="https://dashscope-intl.aliyuncs.com/compatible-mode/v1"

export OPENAI_MODEL="qwen3-coder-plus"

OPENAI_MODEL 次のいずれかに設定できます。

qwen3-coder-plus(Qwen3‑Coder-480B-A35B-Instruct のエイリアス)- または、展開したその他の Qwen3-Coder バリアント。

4. 基本的な使い方

- 対話型コーディング REPL を開始します。

qwen

これにより、Qwen3-Coder を利用したエージェント コーディング セッションが開始されます。

- シェルからのワンオフプロンプト。コードスニペットを要求したり、関数を完了したりするには、次の操作を行います。

qwen code complete \

--model qwen3-coder-plus \

--prompt "Write a Python function that reverses a linked list."

- ファイルベースのコード補完、既存のファイルを自動的に入力またはリファクタリングします。

qwen code file-complete \

--model qwen3-coder-plus \

--file ./src/utils.js

- チャット形式のインタラクション、Qwen を「チャット」モードで使用し、複数ターンのコーディング対話に最適です。

qwen chat \

--model qwen3-coder-plus \

--system "You are a helpful coding assistant." \

--user "Generate a REST API endpoint in Express.js for user authentication."

CometAPI API 経由で Qwen3-Coder を呼び出すにはどうすればよいでしょうか?

CometAPIは、OpenAIのGPTシリーズ、GoogleのGemini、AnthropicのClaude、Midjourney、Sunoなど、主要プロバイダーの500以上のAIモデルを、開発者にとって使いやすい単一のインターフェースに統合する統合APIプラットフォームです。一貫した認証、リクエストフォーマット、レスポンス処理を提供することで、CometAPIはAI機能をアプリケーションに統合することを劇的に簡素化します。チャットボット、画像ジェネレーター、音楽作曲ツール、データドリブン分析パイプラインなど、どのようなアプリケーションを構築する場合でも、CometAPIを利用することで、反復処理を高速化し、コストを抑え、ベンダーに依存しない環境を実現できます。同時に、AIエコシステム全体の最新のブレークスルーを活用できます。

cometAPIユーザーの場合は、cometapiにログインしてキーとベースURLを取得できます。cometapiにログインしてキーとベースURLを取得するには、 Qwen3-Coder APIまず、モデルの機能を調べてみましょう。 プレイグラウンド そして相談する APIガイド 詳細な手順については、

CometAPI経由でQwen3-Coderを呼び出すには、他のモデルと同様にOpenAI互換エンドポイントを使用します。クライアントをCometAPIのベースURLに向け、CometAPIキーをベアラートークンとして提示し、 qwen3-coder-plus or qwen3-coder-480b-a35b-instruct モデル。

1。 前提条件

- 会員登録について at https://cometapi.com ダッシュボードで API トークンを追加/生成します。

- メモ APIキー (始まりは

sk-…). - OpenAI Chat API プロトコル (ロール + メッセージ) に関する知識。

2. ベースURLと認証

Base URL:

arduinohttps://api.cometapi.com/v1

エンドポイント:

bashPOST https://api.cometapi.com/v1/chat/completions

3. cURL / RESTの例

curl https://api.cometapi.com/v1/chat/completions \

-H "Authorization: Bearer sk-xxxxxxxxxxxx" \

-H "Content-Type: application/json" \

-d '{

"model": "qwen3-coder-plus",

"messages": [

{ "role": "system", "content": "You are a helpful coder." },

{ "role": "user", "content": "Generate a SQL query to find duplicate emails." }

],

"temperature": 0.7,

"max_tokens": 512

}'

- 世界の動き: JSONで

choices.message.content生成されたコードが含まれます。

Qwen3-Coder のエージェント機能をどのように活用しますか?

Qwen3-Coder のエージェント機能により、動的なツールの呼び出しと自律的なマルチステップ ワークフローが可能になり、コード生成中にモデルが外部関数または API を呼び出すことができるようになります。

ツールの呼び出しとカスタムツール

コードベースにカスタムツール(リンター、テストランナー、フォーマッタなど)を定義し、関数スキーマを介してモデルに公開します。例:

tools = [

{"name":"run_tests","description":"Execute the test suite and return results","parameters":{}},

{"name":"format_code","description":"Apply black formatter to the code","parameters":{}}

]

response = client.chat.completions.create(

messages=,

functions=tools,

function_call="auto"

)

Qwen3-Coderは3回のセッションでコードを自動的に生成、フォーマット、検証できるため、手動による統合のオーバーヘッドが削減されます()。

QwenコードCLIの使用

当学校区の qwen-code コマンドラインツールは、エージェントコーディングのための対話型 REPL を提供します。

qwen-code --model qwen3-coder-480b-a35b-instruct

> generate: "Create a REST API in Node.js with JWT authentication."

> tool: install_package(express)

> tool: create_file(app.js)

> tool: run_tests

この CLI は、透過的なログを使用して複雑なワークフローを調整するため、探索的なプロトタイピングや CI/CD パイプラインへの統合に最適です。

Qwen3-Coder は大規模なコードベースに適していますか?

Qwen3-Coderは拡張コンテキストウィンドウを備えているため、パッチやリファクタリングを生成する前に、最大数十万行のコードを含むリポジトリ全体を読み込むことができます。この機能により、小規模なコンテキストモデルでは実現できないグローバルリファクタリング、モジュール間分析、アーキテクチャ提案が可能になります。

Qwen3-Coder のユーティリティを最大化するためのベスト プラクティスは何ですか?

Qwen3-Coder を効果的に導入するには、CI/CD パイプラインへの慎重な構成と統合が必要です。

サンプリングとビームの設定をどのように調整すればよいですか?

- 温度: バランスのとれた創造性の場合は 0.6~0.8、決定論的なリファクタリングタスクの場合はそれより低い (0.2~0.4)。

- トップp: 0.7~0.9 では、最も可能性の高い継続に焦点を当てながら、時折斬新な提案も許可します。

- トップk標準的な使用では 20 ~ 50 です。高度に集中した出力を求める場合は 5 ~ 10 に減らします。

- 繰り返しペナルティ: 1.05~1.1 で、モデルが定型パターンを繰り返さないようにする。

プロジェクトの変動許容範囲に応じてこれらのパラメータを実験すると、生産性が大幅に向上します。

Qwen3-Coder を効果的に使用するためのベストプラクティスは何ですか?

コード品質のための迅速なエンジニアリング

- 具体的に: プロンプトで言語、スタイル ガイドライン、および必要な複雑さを指定します。

- 反復改良: モデルのエージェント機能を使用して、生成されたコードを繰り返しデバッグおよび最適化します。

- 温度調整:生成温度を下げる(例:

temperature=0.2) を使用すると、本番環境でより確定的な出力が得られます。

リソース利用の管理

- モデルバリアント: プロトタイプ作成には小規模な Qwen3-Coder バリアントから開始し、必要に応じてスケールを拡大します。

- 動的量子化: FP8 および GGUF 量子化チェックポイントを試して、パフォーマンスを大幅に低下させることなく GPU メモリ フットプリントを削減します。

- 非同期生成: 応答性を維持するために、長時間実行されるコード生成をバックグラウンド ワーカーにオフロードします。

これらのガイドラインに従うことで、Qwen3-Coder をソフトウェア開発ライフサイクルに統合することによる ROI を最大化できます。

上記のガイダンスに従って、アーキテクチャを理解し、モデルと Qwen Code CLI の両方をインストールして構成し、ベスト プラクティスを活用することで、単純なコード スニペットから完全に自律的なプログラミング エージェントまで、Qwen3-Coder の潜在能力を最大限に活用できるようになります。