人工知能(AI)は数多くの産業に革命をもたらしましたが、その最も魅力的な応用分野の一つが画像生成です。リアルな人間の顔の作成からシュールなアート作品の制作まで、AIによる画像生成能力は、アート、デザイン、そしてテクノロジーの分野に新たな道を開きました。この記事では、AIが生成する画像の仕組み、それを支えるモデル、そしてこの技術がもたらす幅広い影響について深く掘り下げます。

基礎を理解する: AI 画像生成はどのように機能するのか?

生成モデルとは何ですか?

生成モデルは、トレーニングデータに類似した新しいデータインスタンスを作成できるAIアルゴリズムの一種です。画像生成の文脈では、これらのモデルは既存の画像からパターンを学習し、その知識を用いて類似した新しい画像を生成します。

ニューラルネットワークの役割

AI画像生成の中核を成すのはニューラルネットワーク、特に畳み込みニューラルネットワーク(CNN)のようなディープラーニングモデルです。CNNはグリッド状のトポロジーでデータを処理するように設計されており、画像の分析と生成に最適です。CNNは、画像の理解と再現に不可欠なエッジ、テクスチャ、形状などのパターンを検出することで機能します。

AI画像生成における主要なAIモデル

生成的敵対的ネットワーク(GAN)

2014年にイアン・グッドフェローによって提唱されたGANは、生成器と識別器というXNUMXつのニューラルネットワークで構成されています。生成器は画像を作成し、識別器はそれを実際の画像と比較評価します。この敵対的プロセスを通じて、生成器は出力を改善し、よりリアルな画像を生成します。

スタイルGAN

NVIDIAが開発したStyleGANは、高品質な人間の顔を生成することで知られるGANの派生版です。スタイルベースの生成アーキテクチャを導入し、画像内の様々な詳細レベルを制御できます。StyleGAN2とStyleGAN3では、画像品質がさらに向上し、テクスチャのスティッキングなどの問題も解決されました。

拡散モデル

拡散モデルは、ランダムノイズから始めて、それを徐々に調整し、目的の出力に一致するように画像を生成します。高品質な画像を生成できることと、様々な用途に柔軟に対応できることから、人気が高まっています。

安定拡散

Stable Diffusionは、テキストから画像を生成するオープンソースの拡散モデルです。また、インペインティングとアウトペインティングも実行できるため、画像の編集や拡張も可能です。オープンソースであるため、開発者やアーティストが広く利用することができます。

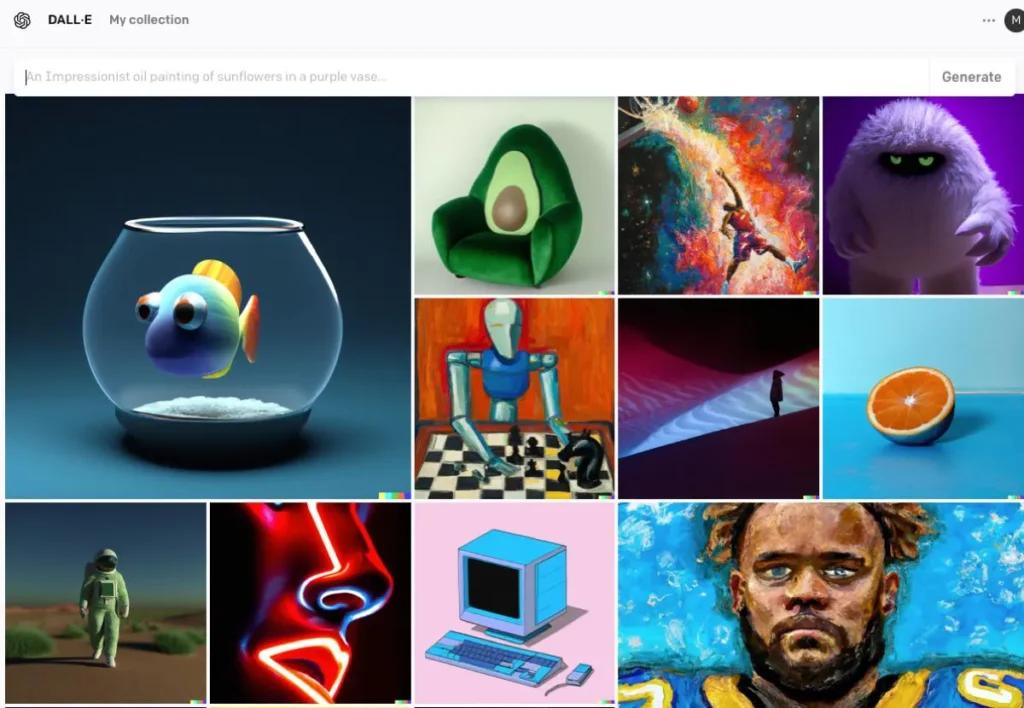

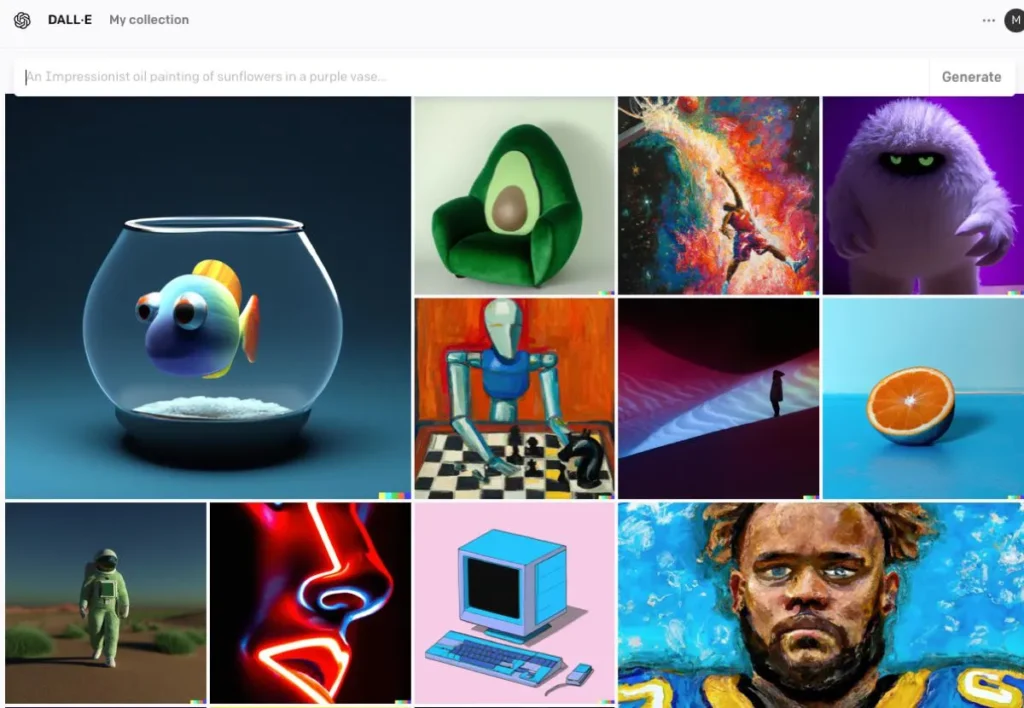

DALL・E

OpenAIによって開発されたDALL·Eは、テキスト記述から画像を生成するトランスフォーマーベースのモデルです。DALL·E 2とDALL·E 3はオリジナルを改良し、より高い解像度とより正確な画像とテキストの位置合わせを実現しています。DALL·E 3はChatGPTに統合されており、ユーザーインタラクションを強化します。

AI画像生成のプロセス

モデルのトレーニング

AIモデルは、大規模な画像データセットを用いた徹底的なトレーニングを必要とします。トレーニング中に、モデルは画像内のパターンや特徴を認識するようになり、トレーニングデータを模倣した新しい画像を生成できるようになります。

新しい画像の生成

トレーニングが完了すると、モデルは次の方法で新しい画像を生成できるようになります。

- 入力の受信: これはランダムノイズ (GAN の場合)、テキストプロンプト (DALL·E の場合)、または既存の画像 (編集用) である可能性があります。このステップでは、テキストの意味をキャプチャし、AI がコンテンツとコンテキストを理解できるようにします。

- 入力処理モデルはニューラルネットワーク層を通して入力を処理し、学習したパターンと特徴を適用します。エンコードされたテキストを用いて、AIは敵対的生成ネットワーク(GAN)や拡散モデルなどのモデルを用いて画像を生成します。これらのモデルは、ランダムノイズから始めて、それをテキストの説明と一致するように調整することで画像を生成します。

- 絞り込みと評価生成された画像は、テキストとの整合性を確保するために、アテンションメカニズムを用いて改良されます。識別モデルは、画像のリアリティと入力との整合性を評価し、さらなる改良のためのフィードバックを提供します。

- 画像の出力: 最終的な出力は、トレーニング データの特性と提供された特定の入力を反映した新しい画像です。

AI画像生成のコード例

ここでは、Generative Adversarial Networks (GAN)、Stable Diffusion、DALL·E という 3 つの主要な AI モデルを使用して画像を生成する方法を示す実用的な Python コード例を示します。

PyTorch を使用した敵対的生成ネットワーク (GAN)

敵対的生成ネットワーク(GAN)は、ジェネレーターとディスクリミネータという2つのニューラルネットワークで構成され、互いに競合しながら新しい現実的なデータインスタンスを生成します。以下は、PyTorchを使用して画像を生成する簡略化された例です。

pythonimport torch

import torch.nn as nn

# Define the Generator network

class Generator(nn.Module):

def __init__(self):

super(Generator, self).__init__()

self.fc1 = nn.Linear(100, 128)

self.fc2 = nn.Linear(128, 784) # Assuming output image size is 28x28

def forward(self, x):

x = torch.relu(self.fc1(x))

x = torch.tanh(self.fc2(x))

return x

# Instantiate the generator

generator = Generator()

# Generate a random noise vector

noise = torch.randn(1, 100)

# Generate an image

generated_image = generator(noise)

このコードは、100次元のノイズベクトルを入力として受け取り、784×28の画像に再形成できる28次元の出力を生成するシンプルな生成ネットワークを定義します。 tanh 活性化関数は、出力値が の範囲内にあることを保証します。これは、画像データでは一般的です。

フェイスディフューザーによる安定した拡散

安定拡散は、テキスト記述に基づいて画像を生成する強力なテキスト画像変換モデルです。ハグする顔 diffusers ライブラリは、このモデルを使用するための簡単なインターフェースを提供します。

pythonfrom diffusers import StableDiffusionPipeline

import torch

# Load the pre-trained Stable Diffusion model

pipe = StableDiffusionPipeline.from_pretrained("CompVis/stable-diffusion-v1-4")

pipe = pipe.to("cuda") # Move the model to GPU for faster inference

# Generate an image from a text prompt

prompt = "A serene landscape with mountains and a river"

image = pipe(prompt).images

# Save the generated image

image.save("generated_image.png")

このスクリプトは安定拡散モデルを読み込み、指定されたプロンプトに基づいて画像を生成します。最適なパフォーマンスを得るには、必要な依存関係がインストールされ、互換性のあるGPUが搭載されていることを確認してください。

OpenAI API を使用した DALL·E

DALL·Eは、OpenAIが開発したもう1つのテキスト画像変換モデルです。OpenAIのAPIを使って操作できます。

pythonimport openai

import requests

from PIL import Image

from io import BytesIO

# Set your OpenAI API key

openai.api_key = "your-api-key"

# Generate an image using DALL·E

response = openai.Image.create(

prompt="A futuristic cityscape at sunset",

n=1,

size="512x512"

)

# Get the URL of the generated image

image_url = response

# Download and display the image

image_response = requests.get(image_url)

image = Image.open(BytesIO(image_response.content))

image.save("dalle_generated_image.png")

交換する "your-api-key" 実際のOpenAI APIキーを入力してください。このスクリプトはDALL·Eモデルにプロンプトを送信し、生成された画像を取得します。画像はローカルに保存されます。

CometAPIは、 DALL-E 3 APICometAPIのキーを使ってアクセスすることもできます DALL-E 3 API、OpenAIよりも便利で高速です。

Comet APIのモデルの詳細については、以下を参照してください。 APIドキュメント.

これらの例は、さまざまなAIモデルを用いて画像を生成するための出発点となります。各モデルには独自の機能と要件があるため、プロジェクトのニーズに最適なモデルを選択してください。

結論

AIによる画像生成は、テクノロジーと創造性の交差点に位置し、ビジュアルコンテンツ制作において前例のない可能性をもたらします。AIがどのように画像を生成するのか、そのモデル、そしてこの技術が社会の様々な側面に統合していく上で、その影響を理解することは不可欠です。

CometAPI で AI 画像 API にアクセスする

CometAPIは、チャット、画像、コードなどに対応したオープンソースおよび特化したマルチモーダルモデルを含む、500以上のAIモデルへのアクセスを提供します。その最大の強みは、従来複雑だったAI統合プロセスを簡素化できることです。CometAPIを利用することで、Claude、OpenAI、Deepseek、Geminiといった主要なAIツールに、単一の統合サブスクリプションでアクセスできます。CometAPIのAPIを使用して、音楽やアートワークの作成、動画の生成、独自のワークフローの構築が可能です。

コメットAPI 統合を支援するために、公式価格よりもはるかに安い価格を提供します GPT-4o API ,ミッドジャーニーAPI 安定拡散API(安定拡散XL 1.0 API) と Flux API(FLUX.1 API など)があり、登録してログインするとアカウントに 1 ドルが加算されます。

CometAPIは最新の GPT-4o-イメージ API .