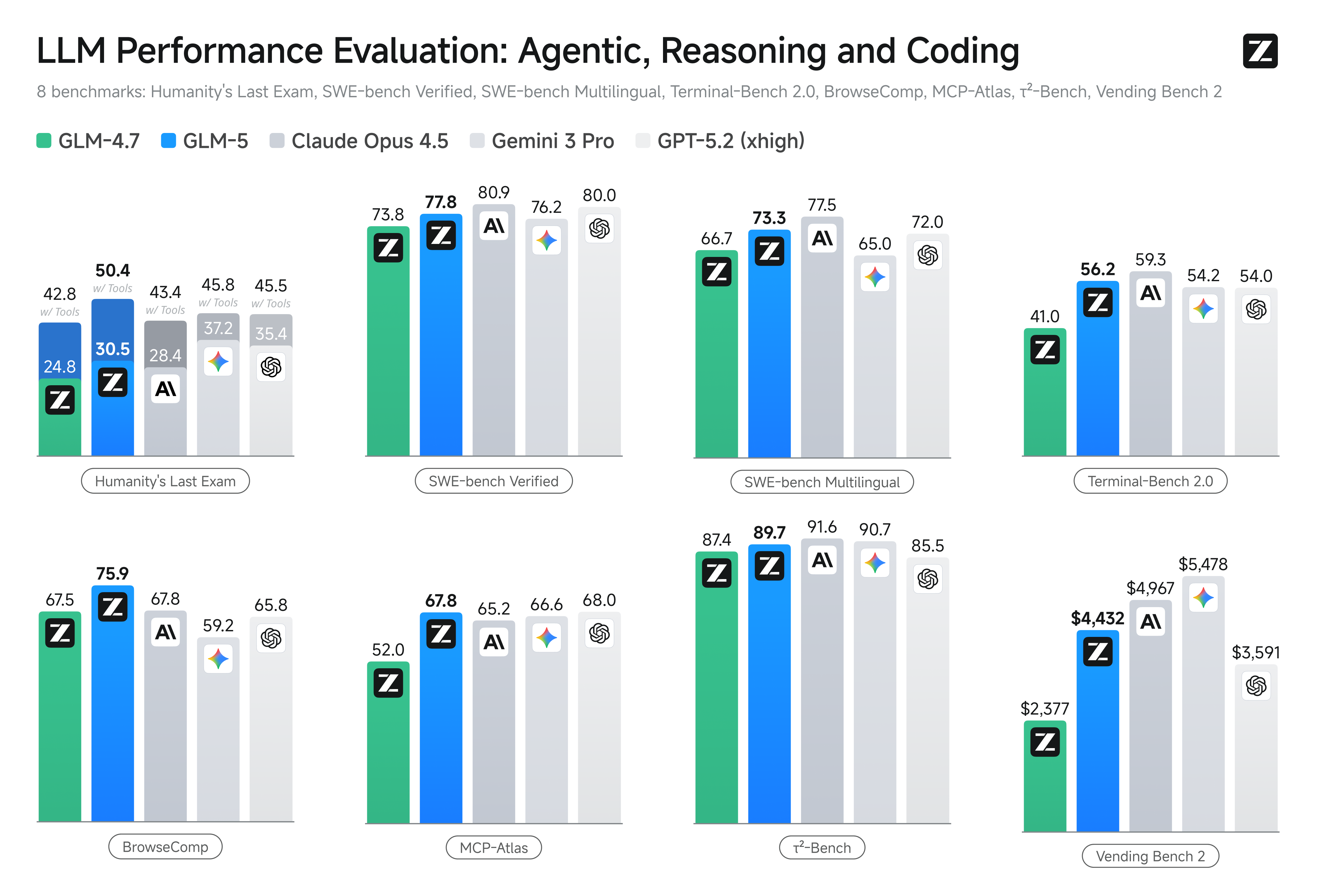

今週、中国のZhipu AI(多くの開発者チャネルでは Z.AI / zai-org のブランドで展開)が発表したGLM-5のリリースは、大規模モデルのリリースサイクルが加速する中で、さらなる一歩を示すものです。新モデルは Zhipu のフラッグシップとして位置づけられており、スケールの拡大、長期的なエージェント指向タスクへの最適化、そして長いコンテキストを維持しつつ推論コストを抑えるためのエンジニアリング上の選択が盛り込まれています。業界の初期レポートや開発者の実地検証によれば、従来の GLM 系と比べてコーディング、マルチステップ推論、エージェントのオーケストレーションにおいて有意な向上が確認されており、テストによっては Claude 4.5 に挑むケースも見られます。 ## GLM-5 とは何か、誰が開発したのか? GLM-5 は GLM ファミリーの最新メジャーリリースで、Z.ai(GLM シリーズを手がけるチーム)が開発・公開した大規模なオープンソース基盤モデルです。2026年2月上旬に発表された GLM-5 は、とりわけ「エージェント指向」のタスク、すなわちモデルが計画し、ツールを呼び出し、実行し、拡張された会話や自動エージェントにおいてコンテキストを保持し続けるような、マルチステップかつ長期的なワークフローに特化して調整されています。このリリースはモデル設計だけでなく、学習方法と実施場所の両面でも注目されます。Z.ai は自立性の強化を目指し、中国国内のハードウェアとツールチェーンを組み合わせて使用しました。 報告されているアーキテクチャおよび学習に関する数値は以下のとおりです。 * パラメータスケーリング: GLM-5 はおよそ744B パラメータまでスケールします(技術ノートの一部では「アクティブ」エキスパート数はより小さく、例としてアクティブ 40B と記載)。従来の GLM-4 系は約 355B/アクティブ 32B 程度でした。 * 事前学習データ: 学習コーパスは GLM-4 世代の約 23 兆トークンから、GLM-5 では約 28.5 兆トークンへと拡大したとされています。 * Sparse attention / DeepSeek Sparse Attention (DSA): 推論時の計算コストを抑えつつ長いコンテキストを維持するための疎アテンション方式。 * 設計上の重点: エージェントのオーケストレーション、長いコンテキストでの推論、コスト効率の高い推論にフォーカスしたエンジニアリング選択。 ### 起源とポジショニング GLM-5 は 2025年半ばの GLM-4.5 や 4.7 などのアップデートに続く系譜上に構築されています。Z.ai は GLM-5 を、「vibe coding」(クイックな単発コード出力)から「エージェント指向のエンジニアリング」へと踏み出すモデルとして位置づけています。すなわち、長いコンテキストウィンドウにまたがって、複雑な問題を扱い、複数ツールをオーケストレーションし、長期にわたるエージェントの挙動を構築・協調・維持できるよう設計されたことを強調しています。 ## GLM-5 の新機能は? ### 主なアーキテクチャ変更 * 大規模疎スケーリング(MoE): GLM-5 は、より大規模な疎な Mixture-of-Experts アーキテクチャへ移行しました。開発者ページや独立した解説によれば、総計約 744B パラメータ、トークンあたりアクティブ約 40B とされ、GLM-4.5(約 355B / アクティブ 32B)の構成から大きく前進しています。この疎スケーリングにより、トークンごとの計算量を抑えながら、非常に大きな総能力を提供できます。 * DeepSeek Sparse Attention (DSA): 長いコンテキスト能力を保持しつつ推論コストを線形に増加させないため、GLM-5 は疎アテンションメカニズム(DeepSeek)を統合し、長距離依存関係の重要部分を維持しつつ、超長文脈でのアテンション計算コストを削減します。 ### 基盤設計としてのエージェント指向エンジニアリング GLM-5 の目玉のひとつは、エージェント指向エンジニアリングに明確に照準を合わせている点です。すなわち、単発のチャットや要約にとどまらず、マルチステップのエージェントの「ブレイン」として、計画、ツール呼び出し、状態管理、長いコンテキストでの推論に用いられることを想定しています。Z.ai は GLM-5 をオーケストレーションループで機能するよう位置づけており、複雑な問題を分解し、外部ツールや API を呼び出し、複数ターンにまたがる長いタスクを追跡します。 #### なぜエージェント指向設計が重要か エージェント指向のワークフローは、実世界の自動化の中核です。たとえば自動化されたリサーチアシスタント、自律的なソフトウェアエンジニア、オペレーションのオーケストレーション、シミュレーション制御などです。こうした世界で機能するモデルには、強力な計画能力、安定したツールコールの挙動、数千トークン規模のコンテキストに対する堅牢性が求められます。 ### コーディング、推論、そして「長期的」挙動の改善 GLM-5 はコード生成と推論の改善を強調しています。Z.ai は、コードの記述、リファクタリング、デバッグ能力の向上に加え、長いやり取りにわたるマルチステップ推論の一貫性が高まったと主張しています。早期アクセスのレポートやパートナー評価では、開発者向けタスクにおいて、従来世代より顕著に強力であることが確認されています。 ### 実務的な開発者向け機能 * ドキュメント、コードベース、会話状態を保持できる、より大きなコンテキストウィンドウ * 安全なツール呼び出しと結果処理のためのツーリングプリミティブ * 複雑なタスクを分解・実行するための、より良い few-shot と chain-of-thought の性能 * エージェント機能とツールコール: GLM-5 はエージェントをネイティブにサポートし、関数/ツール呼び出し、ステートフルなセッション、長い対話とツール使用シーケンスの管理を強化します。これにより、Web 検索、データベース、タスク自動化を統合したエージェントが構築しやすくなります。 ## GLM-5 はベンチマークでどうか?  ### 具体的なベンチマークのハイライト * コーディングベンチマーク: 特定のコーディングタスクにおいて、GLM-5 は、Anthropic の Claude Opus 4.5 のような高度に最適化されたプロプライエタリモデルに匹敵(場合によっては同等)するコーディング性能に迫っています。結果はタスク(ユニットテスト、アルゴリズムコーディング、API 利用)に依存しますが、GLM-4.5 からの明確な改善が示されています。 * 推論とエージェントテスト: マルチステップ推論やエージェント評価スイート(マルチターンの計画、タスク分解ベンチマークなど)では、GLM-5 はオープンソースモデルの中で最高水準の結果を達成し、指標によっては特定タスクでクローズドモデルを上回るケースも確認されています。 ## GLM-5 にアクセスして試すには? GLM-5 は Zhipu AI(Z.ai)が開発した第 5 世代の大規模言語モデルで、**Mixture-of-Experts アーキテクチャ(総計約 745B、アクティブ約 44B)**を採用し、強力な推論、コーディング、エージェント指向ワークフローを目指しています。公式リリースは 2026年2月12日頃です。 現時点では、アクセス方法は主に次の 2 つです。 ### A) 公式 API アクセス(Z.ai またはアグリゲーター) Zhipu AI は自社モデルの API を提供しており、GLM-5 も API 経由で呼び出せます。 一般的な手順: 1. Z.ai/Open BigModel API アカウントに登録 2. ダッシュボードから API キーを取得 3. モデル名(例:

### 具体的なベンチマークのハイライト * コーディングベンチマーク: 特定のコーディングタスクにおいて、GLM-5 は、Anthropic の Claude Opus 4.5 のような高度に最適化されたプロプライエタリモデルに匹敵(場合によっては同等)するコーディング性能に迫っています。結果はタスク(ユニットテスト、アルゴリズムコーディング、API 利用)に依存しますが、GLM-4.5 からの明確な改善が示されています。 * 推論とエージェントテスト: マルチステップ推論やエージェント評価スイート(マルチターンの計画、タスク分解ベンチマークなど)では、GLM-5 はオープンソースモデルの中で最高水準の結果を達成し、指標によっては特定タスクでクローズドモデルを上回るケースも確認されています。 ## GLM-5 にアクセスして試すには? GLM-5 は Zhipu AI(Z.ai)が開発した第 5 世代の大規模言語モデルで、**Mixture-of-Experts アーキテクチャ(総計約 745B、アクティブ約 44B)**を採用し、強力な推論、コーディング、エージェント指向ワークフローを目指しています。公式リリースは 2026年2月12日頃です。 現時点では、アクセス方法は主に次の 2 つです。 ### A) 公式 API アクセス(Z.ai またはアグリゲーター) Zhipu AI は自社モデルの API を提供しており、GLM-5 も API 経由で呼び出せます。 一般的な手順: 1. Z.ai/Open BigModel API アカウントに登録 2. ダッシュボードから API キーを取得 3. モデル名(例: glm-5)を指定して、OpenAPI 風または REST API エンドポイントで呼び出し (OpenAI の GPT モデルを呼び出すのと同様) 4. プロンプトを設定して HTTP リクエストを送信 👉 Z.ai の料金ページでは、GLM-5 の公式トークン価格の例として以下が示されています。 * 入力トークン 100万あたり 約 $1.0 * 出力トークン 100万あたり 約 $3.2 ### B) サードパーティ API ラッパー —— CometAPI CometAPI や WaveSpeed のような API は、複数の AI モデル(OpenAI, Claude, Z.ai など)を統一インターフェースの裏でラップします。 * CometAPI のようなサービスでは、モデル ID を切り替えるだけで GLM 系モデルを呼び出せます。 (CometAPI は現在 GLM-5/GLM-4.7 に対応。) * CometAPI の glm-5 は公式価格の 20% に設定されています。 | 利用タイプ | 価格 | | ------------- | ---------------------------- | | 入力トークン | 約 $0.8 / 100万トークンあたり | | 出力トークン | 約 $2.56 / 100万トークンあたり | 重要な理由: 既存の OpenAI 互換クライアントコードを維持したまま、ベース URL やモデル ID を変えるだけで利用できます。 ### C) Hugging Face / Weights を使ったセルフホスティング 非公式の GLM-5 のウェイトリポジトリ(glm-5/glm-5-fp8 などの名称)が、Hugging Face のモデル一覧に見られます。 これらを使って: * モデルウェイトをダウンロード * vLLM, SGLang, xLLM, Transformers などを用いて、ローカルまたはクラウド GPU 群でサービング 長所: 最大限のコントロール、継続的な API コストが不要 短所: 計算資源要件が非常に大きい — 複数のハイエンド GPU とメモリ(数百 GB)を要する可能性が高く、小規模システムでは非現実的 ## では — GLM-5 は導入に値するのか、GLM-4.7 は維持すべきか? ### 短い答え(エグゼクティブサマリー) * 堅牢なマルチステップのエージェント挙動、プロダクション品質のコード生成、またはシステムレベルの自動化が必要な場合: GLM-5 は即時評価に値します。そのアーキテクチャ、スケール、チューニングはまさにこれらの成果を優先しています。 * コスト効率の高い高スループットのマイクロサービス(短いチャット、分類、軽量プロンプト)が必要な場合: GLM-4.7 は多くのプロバイダの価格表でトークンあたりのコストがかなり低く、能力も十分で、実運用での実績があるため、依然として最も経済的な選択肢でしょう。 ### 長い答え(実務的な推奨) 階層化モデル戦略を採用しましょう。日常的で高ボリュームの対話には GLM-4.7 を使い、高付加価値のエンジニアリング課題やエージェントのオーケストレーションには GLM-5 を割り当てます。長いコンテキスト、ツール統合、コードの正確性を要する小規模な製品領域で GLM-5 をパイロットし、節約されるエンジニアリング時間と追加のモデルコストを測定してください。時間とともに、GLM-5 の能力向上が広範な移行を正当化するかどうかが判断できるでしょう。 CometAPI を使えば、GLM-4.7 と GLM-5 をいつでも切り替えられます。 ## 現実世界のユースケース:GLM-5 が真価を発揮する場面 ### 1. 複雑なエージェントオーケストレーション GLM-5 はマルチステップの計画とツール呼び出しに重点を置いた設計のため、検索、API コール、プログラム実行を調整する必要があるシステム(例: 自動化リサーチアシスタント、反復的なコード生成器、データベースや外部 API を参照するマルチステップのカスタマーサービスエージェント)に適しています。 ### 2. 長文のエンジニアリングとコードベース推論 多数のファイルや大型コードベースを分析・リファクタリング・統合する必要がある場合、GLM-5 の拡張コンテキストと疎アテンションが直接の強みになります。コンテキスト切り捨てによる失敗モードが減り、長いスパンでも一貫性が向上します。 ### 3. ナレッジ集約型の統合 複雑なレポート(多部構成のリサーチブリーフ、法的要約、規制文書)を作成するアナリストやプロダクトチームは、安定したマルチステップ推論の改善や、ベンダー報告テストにおける幻覚の減少の恩恵を受けられます。 ### 4. ワークフローのエージェント指向自動化 複数システム(例: 計画 + 発券 + デプロイパイプライン)をオーケストレーションする自動化を構築するチームは、GLM-5 をツールコーリングフレームワークとセーフティラッパーに支えられた中央のプランナー兼実行器として活用できます。 ## 結論 GLM-5 は、急速に進化する最先端モデルの領域において重要なリリースです。エージェント指向エンジニアリング、コーディングと推論の改善、オープンウェイトの提供に重点が置かれており、長期的かつツール対応の AI システムを構築するチームにとって魅力的です。特定タスクでの実質的な成果と、コスト/性能の有望なトレードオフが示されていますが、本番導入前に自分たちのタスクに照らして評価し、統制されたベンチマークを行うことを推奨します。 開発者は CometAPI 経由でGLM-5にアクセスできます。まずはPlaygroundでモデルの能力を試し、詳細はAPI ガイドを参照してください。アクセス前に CometAPI にログインし、API キーを取得していることを確認してください。CometAPI は公式価格より大幅に低価格で、統合を支援します。 準備はいいですか?→ 今すぐ GLM-5 にサインアップ AI のヒント、ガイド、ニュースの詳細は、VK、X、Discord をフォローしてください。

GLM-5: 機能、性能ベンチマーク、およびアクセス

AnnaFeb 12, 2026