grok-code-fast-1 xAIの スピード重視、コスト効率の高いエージェントコーディングモデル IDE統合と自動コーディングエージェントを強化するために設計されています。 低レイテンシ, エージェント的行動 (ツール呼び出し、段階的な推論トレース)、および開発者の日常的なワークフローのためのコンパクトなコスト プロファイル。

主な機能(概要)

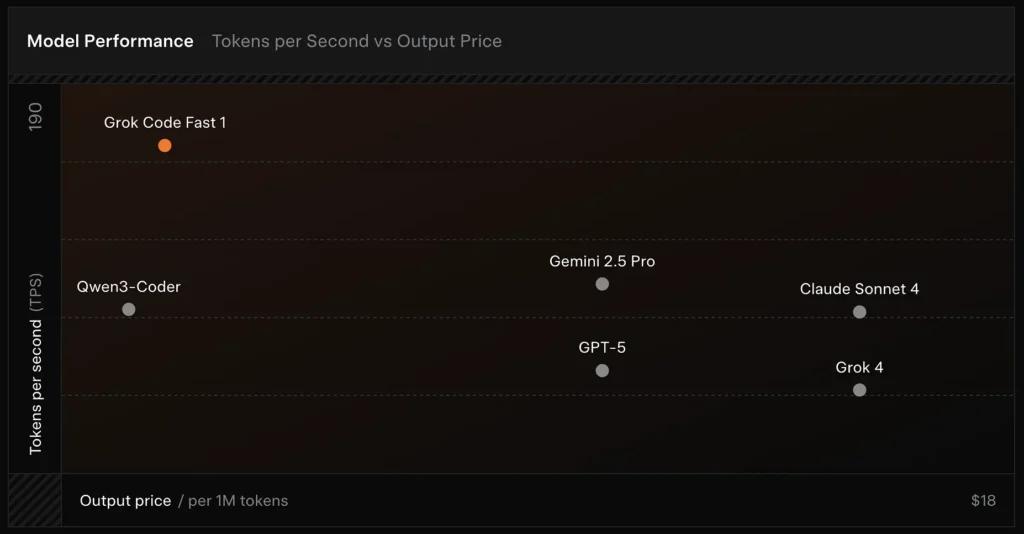

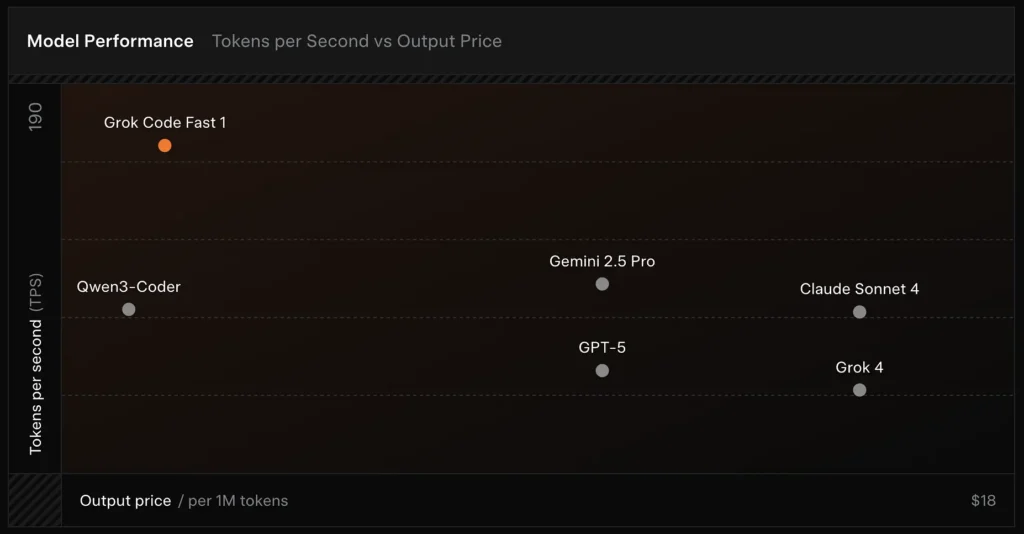

- 高スループット / 低レイテンシ: IDE での使用を想定し、非常に高速なトークン出力と素早い補完に重点を置いています。

- エージェント関数呼び出しとツール: 関数呼び出しと外部ツール オーケストレーション (テストの実行、リンター、ファイル フェッチ) をサポートし、マルチステップ コーディング エージェントを有効にします。

- 大きなコンテキストウィンドウ: 大規模なコードベースと複数ファイルのコンテキストを処理するように設計されています (プロバイダーはマーケットプレイス アダプターに 256k のコンテキスト ウィンドウをリストします)。

- 目に見える推論/痕跡: 応答には、エージェントの決定を検査およびデバッグ可能にすることを目的とした段階的な推論トレースが含まれる場合があります。

技術的な詳細

アーキテクチャとトレーニング: xAIによると、grok-code-fast-1は新しいアーキテクチャとプログラミングコンテンツを豊富に含む事前学習コーパスを用いてゼロから構築され、その後、高品質な実世界のプルリクエスト/コードデータセットを用いて学習後のキュレーションが行われた。このエンジニアリングパイプラインは、モデルを エージェントワークフロー内での実用 (IDE + ツールの使用)。

提供とコンテキスト: grok-code-fast-1 典型的な使用パターンは、ストリーミング出力、関数呼び出し、リッチコンテキストインジェクション(ファイルのアップロード/コレクション)を想定しています。多くのクラウドマーケットプレイスやプラットフォームアダプタでは、既に大規模コンテキストのサポート(アダプタによっては256kコンテキスト)がリストされています。

ユーザビリティ機能: 目に見えます 推論の痕跡 (モデルは計画/ツールの使用を明らかにします)、迅速なエンジニアリング ガイダンスとサンプルの統合、早期リリース パートナーの統合 (GitHub Copilot、Cursor など)。

ベンチマークパフォーマンス(スコアの基準)

SWE-ベンチ検証済み: xAIは、 70.8% ソフトウェアエンジニアリングモデルの比較によく使われるベンチマークであるSWE-Bench-Verifiedサブセットと比較して、自社のハーネスのスコアは高い。最近の実地評価では、 平均的な人間の評価 ≈ 7.6 混合コーディングスイートでは、一部の高価値モデル(例:Gemini 2.5 Pro)と競合しますが、高難易度推論タスクでは、Claude Opus 4やxAI独自のGrok 4といったより大規模なマルチモーダル/「最良推論」モデルに遅れをとります。ベンチマークではタスクによるばらつきも見られ、一般的なバグ修正や簡潔なコード生成には優れていますが、ニッチな問題やライブラリ固有の問題(Tailwind CSSの例)では劣っています。

比較 :

- Grok 4 と比較: Grok-code-fast-1は、絶対的な正確性とより深い推論を犠牲にして コストが大幅に削減され、スループットが高速化されます; Grok 4 は、より高機能なオプションのままです。

- vs クロード・オプス / GPTクラス: これらのモデルは、複雑、創造的、または難しい推論タスクで優位に立つことが多く、Grok-code-fast-1 は、レイテンシとコストが重要となる大量の日常的な開発者タスクで優れた競争力を発揮します。

制限とリスク

これまでに観察された実際的な制限:

- ドメインギャップ: ニッチなライブラリや異常にフレーム化された問題でパフォーマンスが低下します (例: Tailwind CSS エッジ ケース)。

- 推論トークンコストのトレードオフ: モデルは内部推論トークンを出力できるため、高度なエージェント的/冗長な推論によって推論出力の長さ (およびコスト) が増加する可能性があります。

- 精度 / エッジケース: Grok-code-fast-1は、ルーチンタスクに強い一方で、 幻覚 あるいは、新しいアルゴリズムや敵対的な問題ステートメントに対して誤ったコードを生成したり、要求の厳しいアルゴリズムのベンチマークにおいて、トップクラスの推論重視のモデルよりもパフォーマンスが劣る場合があります。

典型的な使用例

- IDE アシスタンスとラピッドプロトタイピング: 高速補完、増分コード書き込み、インタラクティブなデバッグ。

- 自動化エージェント/コードワークフロー: テストを調整し、コマンドを実行し、ファイルを編集するエージェント (例: CI ヘルパー、ボット レビュー担当者)。

- 日々のエンジニアリングタスク: コード スケルトン、リファクタリング、バグ トリアージの提案、および複数ファイルのプロジェクト スキャフォールディングを生成し、低レイテンシによって開発者のフローを大幅に改善します。

CometAPIからgrok-code-fast-1 APIを呼び出す方法

grok-code-fast-1 CometAPI の API 価格、公式価格より 20% オフ:

- 入力トークン: $0.16/Mトークン

- 出力トークン: $2.0/Mトークン

必要な手順

- ログインする コムタピまだユーザーでない場合は、まず登録してください

- インターフェースのアクセス認証情報APIキーを取得します。パーソナルセンターのAPIトークンで「トークンを追加」をクリックし、トークンキー(sk-xxxxx)を取得して送信します。

使用方法

- "を選択します。

grok-code-fast-1” エンドポイントを使用してAPIリクエストを送信し、リクエストボディを設定します。リクエストメソッドとリクエストボディは、弊社ウェブサイトのAPIドキュメントから取得できます。また、お客様の便宜を図るため、弊社ウェブサイトではApifoxテストも提供しています。 - 交換するアカウントの実際の CometAPI キーを使用します。

- コンテンツ フィールドに質問またはリクエストを入力します。モデルはこれに応答します。

- API 応答を処理して、生成された回答を取得します。

CometAPIは、シームレスな移行のために完全に互換性のあるREST APIを提供します。 APIドキュメント:

- ベースURL: https://api.cometapi.com/v1/chat/completions

- モデル名: 「

grok-code-fast-1「 - 認証: ベアラートークン経由

Authorization: Bearer YOUR_CometAPI_API_KEYヘッダ - コンテンツタイプ:

application/json.

API統合と例

Pythonスニペット チャット完了 CometAPI 経由で呼び出す:

pythonimport openai

openai.api_key = "YOUR_CometAPI_API_KEY"

openai.api_base = "https://api.cometapi.com/v1/chat/completions"

messages = [

{"role": "system", "content": "You are a helpful assistant."},

{"role": "user", "content": "Summarize grok-code-fast-1's main features."}

]

response = openai.ChatCompletion.create(

model="grok-code-fast-1",

messages=messages,

temperature=0.7,

max_tokens=500

)

print(response.choices.message)

も参照してください グロク4