xAIが発表したとき Grokコード高速1 2025年8月下旬、AIコミュニティは明確なシグナルを受け取りました。Grokはもはや単なる会話型アシスタントではなく、開発者のワークフローのために武器化されているのです。Grok Code Fast 1(略: コードファスト1)は、コーディングタスクに特化して調整された、低レイテンシ、低コストの推論モデルです。 エージェント的な コーディングワークフロー、つまりモデルが計画、ツールの呼び出しを行い、IDEやパイプライン内で自律的なコーディングアシスタントのように動作するワークフローです。このモデルは既にパートナー統合(特にGitHub Copilotのオプトインプレビュー)や、CometAPIなどの多くのクラウドおよびサードパーティプロバイダーのカタログに導入され始めています。

Grok Code Fast 1 とは何ですか? なぜ重要なのですか?

xAIの grok-code-fast-1 開発ツールや自動化ワークフローにおけるアクティブなパートナーとなることを目的とした、意図的に焦点を絞った低レイテンシのコーディングモデルです。速度、エージェント的なツール利用(検索、関数呼び出し、コード編集、テスト)、そしてリポジトリ間の大規模コンテキスト推論に最適化された実用的な「ペアプログラマー」として位置付けられており、xAIのGrokファミリーにおける専門的なバリアントであり、以下の2点を重視しています。 インタラクティブスピード および 経済的なトークンコスト コーディングワークフロー向け。最も広範でマルチモーダルなジェネラリストを目指して競争するのではなく、コードの読み取り、編集の提案、ツール(リンター/テスト)の呼び出し、そして迅速な反復といった、開発者の日常的なループに焦点を当てています。

なぜ今重要なのか:

- チームはIDEやCI内で即時のフィードバックをますます期待するようになっています。アシスタントのイテレーションごとに数秒待つと、作業フローが中断されてしまいます。Grok Code Fast 1は、こうした摩擦を軽減することを明確に目的として設計されています。

- それはサポートしています 関数呼び出し、構造化された出力、目に見える推論の痕跡複数ステップのタスク(検索→編集→テスト→検証)の自動化を向上させます。これにより、エージェント型コーディングシステムやオーケストレーションされた開発アシスタントに最適です。

ここで「エージェント的」が重要な理由

エージェントモデルは単なる「オートコンプリート」以上の機能を備えています。次のようなことが可能です。

- 呼び出す外部ツールを決定する(テストの実行、パッケージドキュメントの取得)

- タスクをサブステップに分割して実行する

- 構造化された JSON 結果を返したり、プログラムによって git スタイルの変更を行ったりできます。

Grok Code Fast 1 は、推論のトレースを意図的に公開し (開発者がストリーミング中に思考の連鎖を検査できるようにするため)、ネイティブ ツールの呼び出しを重視します。この 2 つの機能は、安全で操作可能なエージェント コーディングをサポートします。

パフォーマンスとスピード Grok Code Fast 1

Grok はどのようにして速度を測定するのでしょうか?

このモデルのブランドにおける「高速」とは、複数の側面を指します。

- 推論のレイテンシ — コード生成時や推論トレース生成時のトークンスループットと応答時間。このモデルは低レイテンシに最適化されているため、長時間バッチジョブだけでなく、インタラクティブなIDEループ(オートコンプリート、コードサジェスト、迅速なバグ修正)にも適しています。

- コスト効率 — トークンの価格設定とモデル構成は、日常的なコーディングタスクの使用ごとのコストを削減することを目的としています。サードパーティのマーケットプレイスでは、より大規模で一般的なモデルと比較して、より低い料金でリストされています。

- 開発者の生産性 — ワークフローにおける認識される「速度」: モデルの関数呼び出し機能や構造化されたテスト可能な出力を返す機能など、開発者がプロンプトから実行可能なコードを作成するまでの速度。

実際のパフォーマンスノート

| アクション / モデル | Grok コード ファスト 1 (観察) |

|---|---|

| シンプルな行補完 | 瞬時に |

| 関数生成(5~10行) | <1秒 |

| 複雑なコンポーネント/ファイルの生成(50行以上) | 2-5秒 |

| 大きな関数のリファクタリング | 5-10秒 |

性能比較

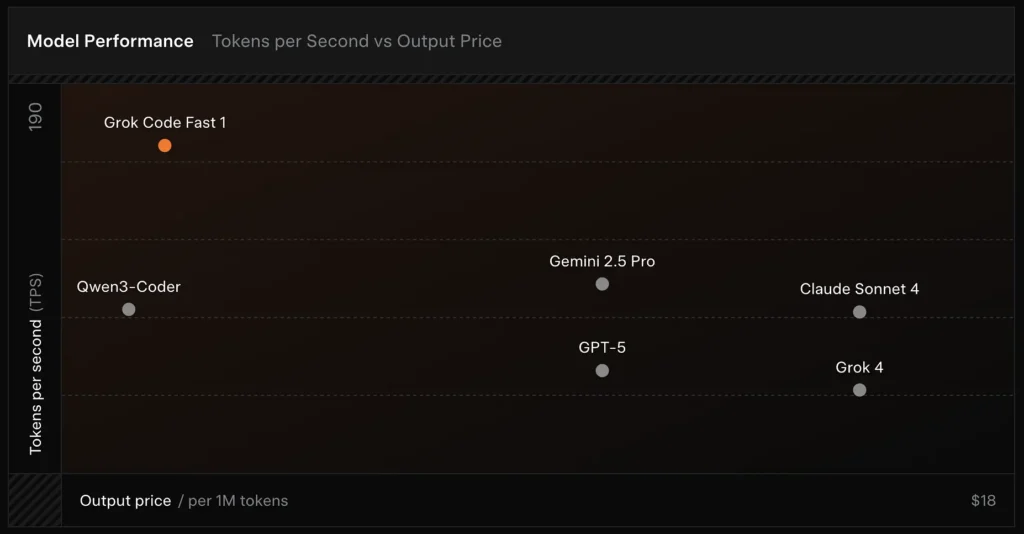

- 速度: テストでは 190 トークン/秒に達しました。

- 価格比較: GPT-5 の出力は 1 万トークンあたり約 18 ドルかかりますが、Grok Code Fast-1 はわずか 1.50 ドルです。

- 精度: SWE-Bench-Verified ベンチマークで 70.8% のスコアを獲得しました。

スピードを可能にする設計の選択

- 大きなコンテキストウィンドウ(256kトークン): モデルは大きなコードベースや長い会話履歴を切り捨てずに取り込むことができるため、コンテキストを繰り返しアップロードする必要性が減ります。

- キャッシュフレンドリーなプロンプト: モデルとプラットフォームは、エージェントのステップ間でほとんど変更されないプレフィックス トークンをキャッシュするように最適化されており、これにより繰り返しの計算が削減され、複数ステップのツールのやり取りのレイテンシが改善されます。

- ネイティブツール呼び出しプロトコル: GrokのAPIは、アドホックなXMLや脆弱な文字列ベースの「関数呼び出し」ではなく、モデルが推論プロセス中に呼び出せる構造化された関数/ツール定義をサポートします(要約や「思考の軌跡」がストリームバックされます)。これにより、解析作業が最小限に抑えられ、モデルは複数のツールを信頼性高く組み合わせることができます。

Grok Code Fast 1 はどのような機能を提供しますか?

以下は、開発者向けの統合において Grok Code Fast 1 が魅力的である主な機能です。

コア機能

- エージェントコーディング: ツール (テスト ランナー、リンター、パッケージ検索、git 操作) の呼び出しと複数ステップのワークフローの作成に対する組み込みサポート。

- ストリーミングにおける推論のトレース: ストリーミング モードで使用すると、API は中間の「推論コンテンツ」を表示するため、開発者とシステムはモデルの計画を観察し、介入することができます。

- 構造化された出力と関数呼び出し: プログラムでの使用に適した JSON または入力された結果を返します (自由形式のテキストだけではありません)。

- 非常に大きなコンテキスト(256kトークン): 単一セッション、ファイル間タスクに強力です。

- 高速推論: 革新的な加速テクノロジーとプロンプト キャッシュの最適化により推論速度が大幅に向上し、応答速度が非常に速くなり、ユーザーがプロンプトを読み終えるまでに数十回のツール呼び出しが完了することがよくあります。

- エージェントプログラミングの最適化: 一般的な開発ツール:grep、ターミナル操作、ファイル編集。Cursor、GitHub Copilot、Clineなどの主要なIDEにシームレスに統合されています。

- プログラミング言語の範囲: TypeScript、Python、Java、Rust、C++、Goなど、様々な言語に精通した優れたスキルを有しています。ゼロからプロジェクトを構築することから、複雑なコードベースのトラブルシューティング、詳細なバグ修正まで、あらゆる開発タスクに対応可能です。

開発者の人間工学

- OpenAI 互換 SDK サーフェス: xAI の API は、一般的な SDK との互換性を重視し、開発者のオンボーディングを短縮するための移行ガイダンスを提供します。

- CometAPI と BYOK のサポート: サードパーティプロバイダー コメットAPI OpenAI互換のエンドポイントを好むチーム向けに、REST経由でGrok Code Fast 1を公開します。これにより、OpenAIライクなAPIを必要とするツールチェーンへの統合が容易になります。

Grok Code Fast 1 は汎用 LLM とどう違うのでしょうか?

Grok Code Fast 1は、主力の会話型モデルの幅広さを犠牲にして、コード、開発ツール、そして迅速なツールループに関するよりタイトなチューニングを実現しています。具体的には、以下のようになります。

- トークン生成とツール呼び出しのラウンドトリップ待ち時間が短縮されます。

- より鮮明でアクションに重点を置いた出力 (構造化された応答、JSON/関数呼び出しメタデータ)。

- 大量のコードインタラクション向けに調整されたコストモデル(多くのゲートウェイリストでトークンあたりのコストが安い)

Grok Code Fast 1 はどの程度エージェント的ですか? 「エージェント的コーディング」とは実際にはどういう意味ですか?

「エージェント的」とは、モデルが外部ツールとのインタラクションを通じて複数ステップのタスクを計画・実行できることを意味します。Grok Code Fast 1 では、エージェント的パワーは以下の形態をとります。

- 関数呼び出しGrok は外部関数の呼び出し (例: テストの実行、ファイルの取得、リンターの呼び出し) を要求し、返された結果を後続の決定に組み込むことができます。

- 目に見える推論の痕跡: 出力には段階的な推論が含まれる場合があり、これを検査してエージェントの挙動をデバッグしたり、制御したりするために使用できます。この透明性は、コードベース全体の変更を自動化する際に役立ちます。

- 永続的なツールループGrok は、単一のモノリシックな応答を期待するのではなく、短い繰り返しの計画→実行→検証サイクルで使用するように設計されています。

エージェント行動から最も恩恵を受けるユースケース

- 自動コード修復: 失敗したテストを見つけ、編集を提案し、テストを実行し、反復します。

- リポジトリ分析: 何千ものファイルの使用パターンを検索し、要約を作成したり、正確なファイル/行への引用を含むリファクタリングを提案したりします。

- 支援された PR 生成: PR の説明を作成し、差分パッチを生成し、テストに注釈を付けます。これらはすべて、CI で実行できるオーケストレーションされたフロー内で実行されます。

開発者はどのようにして Grok Code Fast 1 API にアクセスして使用できますか?

xAIは、パブリックAPIとパートナー統合を通じてGrokモデルを公開しています。一般的なアクセスパターンは3つあります。

- ダイレクトxAI API — xAIアカウントを作成し、コンソールでAPIキーを生成し、RESTエンドポイントを呼び出します。xAIのドキュメントでは、RESTベースは次のように示されています。

https://api.x.ai標準のベアラートークン認証を指定します。ドキュメントとガイドでは、curlとSDKの例が提供されており、多くのツールレイヤーにおけるOpenAIスタイルのリクエストとの互換性が強調されています。 - IDE/サービス パートナー (プレビュー統合) — GitHub Copilot(オプトイン・パブリックプレビュー)とその他のパートナー(Cursor、Clineなど)がローンチ協力者として発表され、VS Codeなどのツール内でGrok Code Fast 1を有効化できるようになりました。これは「bring your own key」フローを通じて実現される場合もあります。ProまたはEnterpriseプランのCopilotをご利用の場合は、Grok Code Fast 1のオプトインオプションをご確認ください。

- サードパーティゲートウェイ(CometAPI、APIアグリゲータ) — ベンダーはプロバイダー間で API 呼び出しを標準化し、異なる料金階層を表示することがあります (プロトタイピングや複数プロバイダーのフォールバックに役立ちます)。 コメットAPI その他のレジストリには、モデルのコンテキスト、サンプル価格、および呼び出し例がリストされています。

以下に2つの実用的なコード例を示します(PythonネイティブSDKストリーミングとREST経由) コメットAPI) は、実際のアプリで Grok Code Fast 1 を実行する方法を示しています。

ツールを設計する: リクエストに関数/ツールの定義を登録してモデルが呼び出せるようにする。ストリーミングの場合はキャプチャする。

reasoning_contentモデルの計画を監視します。

ユースケースコード: Python (ネイティブ xAI SDK、ストリーミング サンプラー)

この例はxAIのドキュメントパターンから引用したものです。

XAI_API_KEY実際のキーを入力し、ツールの定義を環境に合わせて調整してください。ストリーミングではトークンと推論のトレースが表示されます。

# Save as grok_code_fast_example.py

import os

import asyncio

# Hypothetical xai_sdk per xAI docs

import xai_sdk

API_KEY = os.getenv("XAI_API_KEY") # store your key securely

async def main():

client = xai_sdk.Client(api_key=API_KEY)

# Example: ask the model to add a unit test and fix failing code

prompt = """

Repo structure:

/src/math_utils.py

/tests/test_math_utils.py

Task: run the tests, identify the first failing test case, and modify src/math_utils.py

to fix the bug. Show the minimal code diff and run tests again.

"""

# Start a streaming sample; we want to see reasoning traces

async for chunk in client.sampler.sample(

model="grok-code-fast-1",

prompt=prompt,

max_len=1024,

stream=True,

return_reasoning=True, # stream reasoning_content when available

):

# chunk may include tokens and reasoning traces

if hasattr(chunk, "delta"):

if getattr(chunk.delta, "reasoning_content", None):

# model is exposing its internal planning steps

print("", chunk.delta.reasoning_content, flush=True)

if getattr(chunk.delta, "token_str", None):

print(chunk.delta.token_str, end="", flush=True)

if __name__ == "__main__":

asyncio.run(main())

Notes

- 当学校区の

return_reasoning=Trueフラグは、推論トレースをストリーミングするためのドキュメントのガイダンスを表します。モデルの計画を監査できるように、それらをキャプチャして表示します。 - 実際のエージェント設定では、ツールも登録します(例:

run_tests,apply_patch)をモデルに呼び出し許可します。モデルは呼び出しを決定できます。run_tests()出力を使用してパッチを通知します。

ユースケースコード: REST (CometAPI / OpenAI互換)

スタックがOpenAIスタイルのRESTエンドポイントを期待している場合、 コメットAPI 露出する

grok-code-fast-1互換モデル文字列として使用できます。以下の例では、openaiスタイルのクライアント パターン。

import os

import requests

CometAPI_KEY = os.getenv("CometAPI_API_KEY")

BASE = "https://api.cometapi.com/v1/chat/completions"

headers = {

"Authorization": f"Bearer {CometAPI_KEY}",

"Content-Type": "application/json",

}

payload = {

"model": "grok-code-fast-1",

"messages": [

{"role": "system", "content": "You are Grok Code Fast 1, a fast coding assistant."},

{"role": "user", "content": "Write a function in Python that merges two sorted lists into one sorted list."}

],

"max_tokens": 300,

"stream": False

}

resp = requests.post(BASE, json=payload, headers=headers)

resp.raise_for_status()

print(resp.json())

Notes

- コメットAPI ネイティブgRPCまたはSDKアクセスが環境で問題となる場合にブリッジとして機能します。同じ256kコンテキストをサポートし、

grok-code-fast-1プロバイダーの可用性とレート制限を確認します。

実用的な統合パターンとベストプラクティスは何ですか?

IDEファースト(ペアプログラミング)

Grok Code Fast 1 を VS Code やその他の IDE に補完/アシスタントモデルとして組み込みます。短いプロンプトで、小さなテスト可能な編集を促します。アシスタントをタイトなループで実行します。パッチ生成 → テスト実行 → 失敗したテスト出力でアシスタントを再実行します。

CI自動化

Grok Code Fast 1 を使用すると、不安定な障害をトリアージし、修正を提案したり、新しく追加されたコードのユニットテストを自動生成したりできます。低レイテンシを実現する価格設定とアーキテクチャを採用しているため、より高価な汎用モデルと比較して、頻繁なCI実行に適しています。

エージェントオーケストレーション

このモデルを堅牢なツールガードと組み合わせます。提案されたパッチは常にサンドボックスで実行し、完全なテストスイートを実行し、セキュリティや設計に関する重要な変更については人間によるレビューを必須とします。また、可視的な推論トレースを用いてアクションを監査し、再現性を確保します。

迅速なエンジニアリングのヒント

- モデルに正確なファイルを提供するか、編集用に小さなフォーカスされたコンテキスト ウィンドウを提供します。

- 差分や JSON サマリーには構造化された出力スキーマを使用することをお勧めします。自動的に検証しやすくなります。

- マルチステップフローを実行するときは、モデルのツール呼び出しと結果をログに記録して、エージェントの動作を再生またはデバッグできるようにします。

具体的な使用例: 失敗した pytest テストを自動修正する

以下は、Grok Code Fast 1 をテスト修正ループに統合する方法を示した Python ワークフローの実例 (簡略化) です。

# pseudo-code: agentic test-fix loop with grok-code-fast-1

# 1) collect failing test output

failing_test_output = run_pytest_and_capture("tests/test_math.py")

# 2) ask Grok to propose a patch and tests

prompt = f"""

Pyproject: repo root

Failing test output:

{failing_test_output}

Please:

1) Explain root cause briefly.

2) Provide a patch in unified diff format that should fix the issue.

3) Suggest a minimal new/updated unit test to prove the fix.

"""

resp = call_grok_model("grok-code-fast-1", prompt, show_reasoning=True)

# 3) parse structured patch from response (validate!)

patch = extract_patch_from_response(resp)

if is_patch_safe(patch):

apply_patch(patch)

test_result = run_pytest_and_capture("tests/test_math.py")

report_back_to_grok(test_result)

else:

alert_human_review(resp)

このループは、開発者が変更の適用を制御できるようにしながら、エージェントの動作 (提案 → 検証 → 実行 → 反復) を実装する方法を示しています。

スタートガイド

CometAPIは、OpenAIのGPTシリーズ、GoogleのGemini、AnthropicのClaude、Midjourney、Sunoなど、主要プロバイダーの500以上のAIモデルを、開発者にとって使いやすい単一のインターフェースに統合する統合APIプラットフォームです。一貫した認証、リクエストフォーマット、レスポンス処理を提供することで、CometAPIはAI機能をアプリケーションに統合することを劇的に簡素化します。チャットボット、画像ジェネレーター、音楽作曲ツール、データドリブン分析パイプラインなど、どのようなアプリケーションを構築する場合でも、CometAPIを利用することで、反復処理を高速化し、コストを抑え、ベンダーに依存しない環境を実現できます。同時に、AIエコシステム全体の最新のブレークスルーを活用できます。

開発者はアクセスできる Grok コード ファースト 1 API CometAPIを通じて、最新モデルバージョン 公式ウェブサイトで常に更新されています。まずは、モデルの機能について調べてみましょう。 プレイグラウンド そして相談する APIガイド 詳細な手順についてはこちらをご覧ください。アクセスする前に、CometAPIにログインし、APIキーを取得していることを確認してください。 コメットAPI 統合を支援するために、公式価格よりもはるかに低い価格を提供します。

準備はいいですか?→ 今すぐCometAPIに登録しましょう !

結論

Grok Code Fast 1は、あらゆる仕事に最適な唯一のモデルとして宣伝されているわけではありません。むしろ、 専門家 — スピード、大きなコンテキストウィンドウ、そして反復あたりの低コストが最も重要となる、エージェント型でツールリッチなコーディングワークフロー向けに最適化されています。この組み合わせにより、多くのエンジニアリングチームにとって実用的な日常的なツールとなっています。ライブエディタ体験に十分な速度、反復処理に十分なコスト、そして適切な境界内で安全に統合できる十分な透明性を備えています。