Zhipu AI(Z.ai)が開発したGLM-4.5シリーズは、オープンソースの大規模言語モデル(LLM)における大きな進歩を象徴しています。推論、コーディング、エージェント機能を統合するように設計されたGLM-4.5は、様々なアプリケーションで堅牢なパフォーマンスを提供します。開発者、研究者、愛好家など、どなたでも、このガイドではGLM-4.5シリーズを効果的に利用するための詳細な情報を提供します。

GLM-4.5 シリーズとは何ですか? なぜ重要なのですか?

GLM-4.5は、複雑な推論とツールの使用のための「思考モード」と、即時の反応のための「非思考モード」というXNUMXつの異なるモードを組み合わせたハイブリッド推論モデルです。このデュアルモードアプローチにより、モデルは幅広いタスクを効率的に処理できます。このシリーズには、主にXNUMXつのバリエーションがあります。

- GLM-4.5: 合計 355 億のパラメーターと 32 億のアクティブ パラメーターを備えたこのモデルは、推論、生成、およびマルチエージェント タスクにわたる大規模な展開向けに設計されています。

- GLM-4.5-エア: 合計 106 億のパラメータと 12 億のアクティブ パラメータを備えた軽量バージョンで、コア機能を犠牲にすることなく、デバイス上および小規模クラウド推論用に最適化されています。

どちらのモデルもハイブリッド推論モードをサポートしており、「思考」モードと「非思考」モードを提供して複雑な推論タスクと迅速な応答のバランスを取ります。これらはオープンソースであり、MITライセンスの下でリリースされているため、商用利用や二次開発が可能です。

アーキテクチャと設計原則

GLM-4.5の中核は、MoEを活用し、専門のエキスパートサブネットワークを介してトークンを動的にルーティングすることで、優れたパラメータ効率とスケーリング動作を実現します()。このアプローチにより、フォワードパスごとに有効化するパラメータ数が少なくなり、推論およびコーディングタスクにおいて最先端のパフォーマンスを維持しながら運用コストを削減できます()。

主な機能

- ハイブリッド推論とコーディングGLM-4.5 は、自然言語理解ベンチマークとコード生成テストの両方で SOTA パフォーマンスを実証し、精度と流暢さにおいて独自のモデルに匹敵することがよくあります。

- エージェント統合: 組み込みのツール呼び出しインターフェイスにより、GLM-4.5 は、データベース クエリ、API オーケストレーション、インタラクティブなフロントエンド生成などの複数ステップのワークフローを XNUMX つのセッション内でオーケストレーションできます。

- マルチモーダルアーティファクトHTML/CSS ミニアプリから Python ベースのシミュレーションやインタラクティブな SVG まで、GLM-4.5 は完全に機能する成果物を出力できるため、ユーザー エンゲージメントと開発者の生産性が向上します。

GLM-4.5 がゲームチェンジャーである理由

GLM-4.5 は、その純粋なパフォーマンスだけでなく、企業や研究環境におけるオープンソース LLM の価値提案を再定義したことでも高く評価されています。

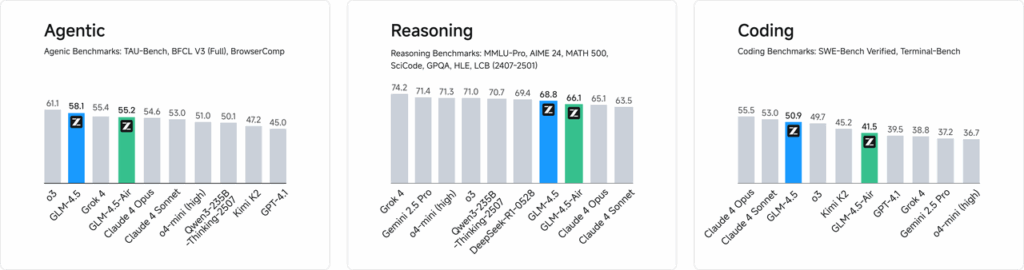

パフォーマンスベンチマーク

ウェブ開発、データ分析、自動化など、52のプログラミングタスクを対象とした独立評価において、GLM-4.5は、ツール呼び出しの信頼性と全体的なタスク完了において、他の主要なオープンソースモデルを一貫して上回りました。Claude Code、Kimi-K2、Qwen3-Coderとの比較テストでは、GLM-4.5は「SWE-bench Verified」リーダーボードなどのベンチマークでクラス最高のスコアを達成しました。

コスト効率

GLM-4.5のMoE設計は、精度の高さに加え、推論コストを大幅に削減します。API呼び出しの公開価格は、入力トークン0.8万個あたり2人民元、出力トークン100万個あたりXNUMX人民元と、同等の独自サービスと比べて約XNUMX分のXNUMXの低価格です。ピーク時生成速度はXNUMXトークン/秒で、このモデルは高スループット、低レイテンシの導入を法外な費用をかけずに実現します。

GLM-4.5 にアクセスするにはどうすればいいですか?

1. Z.aiプラットフォーム経由の直接アクセス

GLM-4.5とやり取りする最も簡単な方法は、Z.aiプラットフォームを使用することです。 チャット.z.aiユーザーはGLM-4.5モデルを選択し、ユーザーフレンドリーなインターフェースを介してインタラクションを開始できます。このプラットフォームは、複雑な統合を必要とせず、すぐにテストとプロトタイピングを可能にします。ユーザーは左上隅からGLM-4.5またはGLM-4.5-Airモデルを選択し、すぐにチャットを開始できます。このインターフェースはユーザーフレンドリーで、設定は不要であるため、迅速なインタラクションやデモンストレーションに最適です。

2. 開発者向けAPIアクセス

GLM-4.5をアプリケーションに統合したい開発者向けに、Z.ai APIプラットフォームが包括的なサポートを提供します。このAPIは、GLM-4.5とGLM-4.5-Airの両方のモデルに対応するOpenAI互換インターフェースを提供し、既存のワークフローへのシームレスな統合を容易にします。詳細なドキュメントと統合ガイドラインは、こちらをご覧ください。 Z.ai APIドキュメント .

3. オープンソースの展開

ローカル展開にご興味のある方は、Hugging FaceやModelScopeなどのプラットフォームでGLM-4.5モデルをご利用いただけます。これらのモデルはMITオープンソースライセンスの下で公開されており、商用利用および二次開発が可能です。vLLMやSGLangといった主流の推論フレームワークと統合することも可能です。

4. CometAPIとの統合

コメットAPI 統合APIプラットフォームを通じてGLM-4.5モデルへの効率的なアクセスを提供します。 ダスボラドこの統合により、認証、レート制限、エラー処理が簡素化されるため、手間のかからないセットアップを求める開発者にとって最適な選択肢となります。さらに、CometAPI の標準化された API フォーマットにより、GLM-4.5 と他の利用可能なモデル間のモデル切り替えや A/B テストが容易になります。

開発者はどのようにして GLM-4.5 シリーズにアクセスできますか?

GLM-4.5 を入手して展開するためのチャネルは、直接モデルのダウンロードから管理された API まで複数あります。

Hugging FaceとModelScope経由

Hugging FaceとModelScopeはどちらも、GLM-4.5シリーズ全体をzai-org名前空間でホストしています。MITライセンスに同意することで、開発者は以下のことが可能になります。

- リポジトリのクローンを作成する:

git clone https://huggingface.co/zai-org/GLM-4.5

- 依存関係をインストールする:

pip install transformers accelerate

- モデルをロードする:

from transformers import AutoModelForCausalLM, AutoTokenizer

tokenizer = AutoTokenizer.from_pretrained("zai-org/GLM-4.5")

model = AutoModelForCausalLM.from_pretrained("zai-org/GLM-4.5")

``` :contentReference{index=15}.

CometAPIを通じて

コメットAPI サーバーレスAPIを提供します GLM-4.5 および GLM-4.5 エア API トークンごとの支払い料金で、OpenAI 互換のエンドポイントを設定することで、既存のコードベースに最小限の調整を加えるだけで、OpenAI の Python クライアントから GLM-4.5 を呼び出すことができます。CometAPI は、GLM4.5 と GLM-4.5-air だけでなく、すべての公式モデルも提供します。

| モデル名 | 紹介する | 価格 |

glm-4.5 | 355億のパラメータを持つ、最も強力な推論モデル | 入力トークン $0.48 出力トークン $1.92 |

glm-4.5-air | コスト効率に優れ、軽量で強力なパフォーマンス | 入力トークン $0.16 出力トークン $1.07 |

glm-4.5-x | 高性能、強力な推論、超高速応答 | 入力トークン $1.60 出力トークン $6.40 |

glm-4.5-airx | 軽量で強力なパフォーマンス、超高速レスポンス | 入力トークン $0.02 出力トークン $0.06 |

glm-4.5-flash | 強力なパフォーマンス推論コーディングとエージェントに最適 | 入力トークン $3.20 出力トークン $12.80 |

PythonとREST APIの統合

カスタマイズした導入環境の場合、DockerまたはKubernetesを使用して、専用のGPUクラスター上でGLM-4.5をホストできます。一般的なRESTfulなセットアップは以下のとおりです。

推論サーバーの起動:

bashdocker run -p 8000:8000 zai-org/glm-4.5:latest

リクエストの送信:

bashcurl -X POST http://localhost:8000/generate \ -H "Content-Type: application/json" \ -d '{"prompt": "Translate to French: Hello.", "max_tokens": 50}' Responses conform to the JSON formats used by popular LLM APIs .

アプリケーションに GLM-4.5 を統合するためのベスト プラクティスは何ですか?

ROI を最大化し、堅牢なパフォーマンスを確保するには、チームは次の点を考慮する必要があります。

APIの最適化とレート制限

- バッチリクエスト: 同様のプロンプトをグループ化してオーバーヘッドを削減し、GPU スループットを活用します。

- 一般的なクエリのキャッシュ: 冗長な推論呼び出しを回避するために、頻繁に実行される補完をローカルに保存します。

- 適応サンプリング: 動的に調整

temperatureおよびtop_pクエリの複雑さに基づいて創造性と決定論のバランスをとります。

セキュリティとコンプライアンス

- データサニタイズ: モデルに送信する前に入力を前処理して機密情報を削除します。

- アクセス制御: 不正使用や乱用を防ぐために、API キー、IP 許可リスト、レート調整を実装します。

- 監査ログ: 特に金融や医療の分野で、企業や規制の要件に準拠するためのプロンプト、完了、メタデータを記録します。

スタートガイド

CometAPIは、OpenAIのGPTシリーズ、GoogleのGemini、AnthropicのClaude、Midjourney、Sunoなど、主要プロバイダーの500以上のAIモデルを、開発者にとって使いやすい単一のインターフェースに統合する統合APIプラットフォームです。一貫した認証、リクエストフォーマット、レスポンス処理を提供することで、CometAPIはAI機能をアプリケーションに統合することを劇的に簡素化します。チャットボット、画像ジェネレーター、音楽作曲ツール、データドリブン分析パイプラインなど、どのようなアプリケーションを構築する場合でも、CometAPIを利用することで、反復処理を高速化し、コストを抑え、ベンダーに依存しない環境を実現できます。同時に、AIエコシステム全体の最新のブレークスルーを活用できます。

GLM-4.5をアプリケーションに統合したい開発者にとって、CometAPIプラットフォームは堅牢なソリューションを提供します。このAPIはOpenAI互換のインターフェースを提供し、既存のワークフローへのシームレスな統合を可能にします。詳細なドキュメントと使用ガイドラインは、 Comet APIページ.

開発者はアクセスできる GLM-4.5 および GLM-4.5 エア API コメットAPI掲載されている最新モデルのバージョンは、記事の公開日時点のものです。まずは、モデルの機能をご確認ください。 プレイグラウンド そして相談する APIガイド 詳細な手順についてはこちらをご覧ください。アクセスする前に、CometAPIにログインし、APIキーを取得していることを確認してください。 コメットAPI 統合を支援するために、公式価格よりもはるかに低い価格を提供します。

結論

GLM-4.5は、大規模言語モデル分野における大きな進歩であり、幅広いアプリケーションに対応する汎用的なソリューションを提供します。ハイブリッド推論アーキテクチャ、エージェント機能、そしてオープンソースという特性は、高度なAI技術の活用を目指す開発者や組織にとって魅力的な選択肢となります。本ガイドで概説されている様々なアクセス方法を検討することで、ユーザーはGLM-4.5をプロジェクトに効果的に統合し、継続的な開発に貢献することができます。