OpenAI は最近、GPT-5-Codex-Mini モデルのリリース、マルチユーザー階層のレート制限の改善、モデル処理効率の最適化など、いくつかのアップデートを発表しました。

OpenAI GPT-5-コーデックス-ミニ は、新たに発表された開発者向けGPT-5-Codexのバリアントです。コストとスループットが最適化された小型モデルで、GPT-5-Codexのコーディング支援の大部分を、はるかに低コストで、より多くの使用可能ボリュームで提供することを目的としています。「Mini」バリアントは、長時間のコーディングセッション、バックグラウンド自動化、高頻度の開発ワークフローなど、同じプランでより多くのトークン/リクエストを取得することよりも、純粋なピーク性能が重要ではない場合に実用的な選択肢として位置付けられています。

GPT-5-Codex-Mini とその機能とは何ですか?

GPT-5-Codex-Miniは、OpenAIのGPT-5-Codexファミリーのコンパクトでコスト効率の高い派生版であり、Codex製品サーフェス(CLIおよびIDE統合)向けに特別にパッケージ化されています。これは、「より小型でコスト効率の高い」モデルとして位置付けられており、ピーク時の能力をわずかに犠牲にして、リソース消費を大幅に削減し、インタラクティブな開発者ワークフローに使用可能なクォータを増やしています。このミニモデルは、開発者がより多くのコーディングターンを実行できるようにすることを目的としています(OpenAIは、 使用量が4倍に増加 共通の明確に定義されたエンジニアリング タスクのレイテンシとコストを抑えながら、同じ ChatGPT サブスクリプション レベルでのコストを削減します。

GPT-5-Codex-Miniは、機能面ではCodex製品ラインのコア機能を継承しています。コードベースの深い理解と、「エージェント」方式による複数ステップのタスク実行です。Codex CLI機能に基づいて、開発者は対話型ターミナルで自然言語コマンド、コードスニペット、スクリーンショット、またはインターフェース設計図をCodexに送信できます。モデルはまず計画を提示し、その後、ユーザーの承認を得た上で、ファイルの閲覧、コードの編集、コマンドの実行、テストを自動的に行います。

モーダルの観点から見ると、Codex製品では、ターミナルまたはIDEのセッションに画像(UIスクリーンショット、設計図、エラーメッセージのスクリーンショットなど)を添付できます。モデルはテキストと画像の両方のコンテンツを理解できますが、出力は主にテキストコードと説明です。したがって、GPT-5-Codex-Miniは、「テキスト+画像入力、テキスト出力」を主とするコードプロキシモデルと見なすことができ、画像生成、音声生成、動画生成などのタスクは実行しません。

GPT-5-Codex-Mini と GPT-5-Codex を比較するとどうなりますか?

Codex の新機能は何ですか?

OpenAIは、GPT-5-Codex-Miniのリリースに加え、ChatGPT Plus、Business、EduユーザーレベルのCodexレート制限を一律50%引き上げ、利用可能なリクエスト数を大幅に増加させました。また、ChatGPT Proユーザーには優先処理権限が付与され、応答速度とタスク実行エクスペリエンスが向上します。

さらに、OpenAIはGPT-5-Codexモデルにマイナーアップグレードを行い、協調シナリオにおけるパフォーマンスを最適化しました。更新されたモデルでは、主要な評価指標が数パーセント向上し、トークン使用効率が約3%向上し、エッジケースの処理における堅牢性が向上し、ユーザーによるガイダンスの必要性が軽減されています。

| ユーザーレベル | GPT-5-コーデックス | GPT-5-コーデックス-ミニ |

|---|---|---|

| プラス/ビジネス/エデュ | メッセージ量がそれぞれ 1.5 倍に増加します。 | メッセージ量はそれぞれ 6 倍に増加します。 |

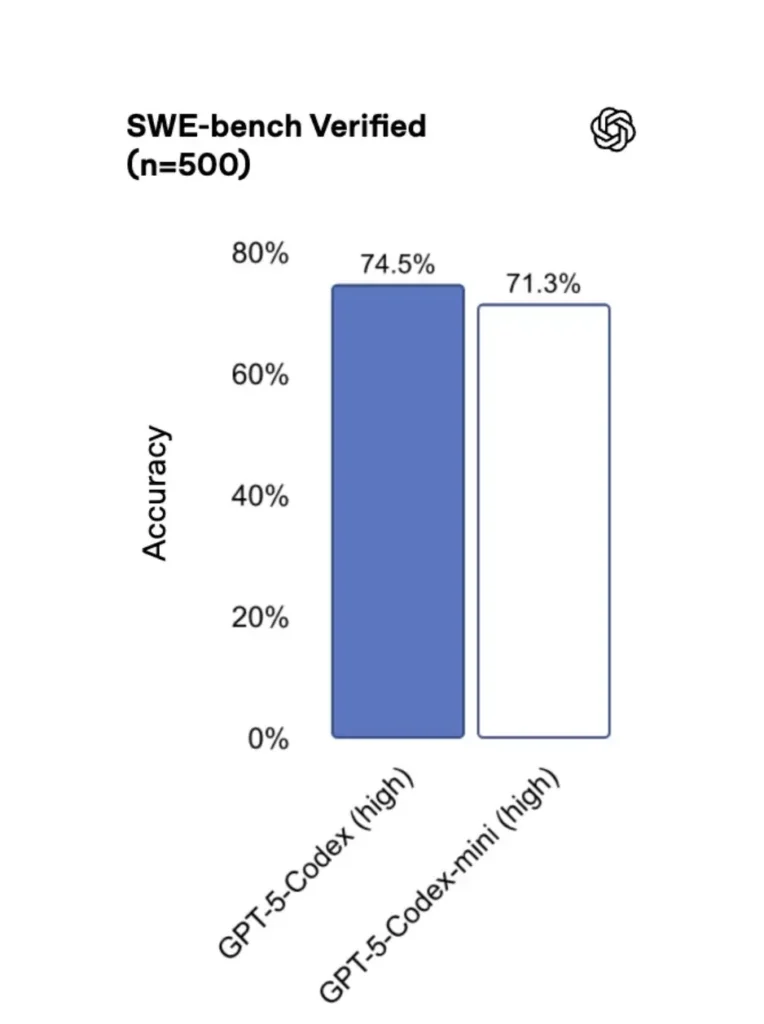

GPT-5-Codex-Mini vs GPT-5-Codex:ベンチマークの違い

GPT-5-Codex-Miniはオリジナルバージョンと比較してパフォーマンスがわずかに低下していますが、開発者は約4倍の使用クレジットを受け取ります。SWE-bench Verifiedテストでは、GPT-5 Highが72.8%、GPT-5-Codexが74.5%、GPT-5-Codex-Miniが71.3%のスコアを獲得しました。

Codex(およびそのミニバージョン)は、軽量のインタラクションで劇的に少ないトークンを使用します。OpenAIの資料では、単純なプロンプトで数十パーセントポイントの削減が可能であると主張しています(例えば、引用されている数字は トークンが約93.7%減少 いくつかのシナリオでは、Codex ファミリーと GPT-5 の軽量な相互作用について比較します。

GPT-5-Codex-MiniとGPT-5-Codex:機能の違い

- サイズとコスト: Miniは明らかに小型でコスト効率に優れています。OpenAIは、同じサブスクリプション制約下で約4倍の使用量を可能にすると説明しています。これは、開発者の日常的なタスクにおけるクォータと効率の最適化です。

- 能力範囲: GPT-5-Codexは、長時間にわたる複雑なエージェントタスク(大規模なリファクタリング、詳細なコードレビュー、長期にわたるテストサイクル)向けの高機能オプションです。Miniは、頻繁な短いインタラクション向けに、より高速でリソース消費を抑えるように調整されています。

- レイテンシとレート制限: Mini は通常、レイテンシが低く、プランごとに高いレート制限を許可するため、高密度でインタラクティブなワークフローに適しています。

- デフォルトのサーフェス: Mini は、Codex CLI および IDE 拡張機能で選択可能なモデルとして使用できます。GPT-5-Codex は、Codex のクラウド タスクおよび詳細なコード レビュー フローのデフォルトです。

ミニコーデックスとフルコーデックスの使い分け

- ミニ スキャフォールディング、反復的なコード生成、小さなリファクタリング、編集中の対話型補完、および割り当てまたはコスト制約下での作業に使用できます。

- GPT-5-コーデックス 包括的なコードレビュー、数時間かかる自律タスク、複雑なリファクタリング、モデルの最強の推論とテスト駆動型実行を必要とするタスクに適しています。

GPT-5-Codex-Mini (CLI、IDE、API) にアクセスするにはどうすればよいですか?

Codex CLI (ターミナルファースト)

OpenAI導入 gpt-5-codex-mini Codex CLI内のモデルオプションとして使用できます。一般的な使用パターンは、Codex CLIのワークフローに従います。対話型セッションの開始、モデルの指定、ファイルまたはスクリーンショットの添付、「Codex Cloudタスク」の実行などです。CLIはクイック /model フル gpt-5-codex および gpt-5-codex-mini初回実行時には、ChatGPT/Pro/Enterpriseアカウントで認証(またはAPIキーの提供)する必要があります。CLIには、Codexによるコードベースのスキャン、テストの実行、REPLのオープン、パッチ推奨事項の適用などを可能にする様々なコマンドが用意されています。

例 (Codex CLI 対話型セッション):

# Install Codex CLI (npm)

npm i -g @openai/codex

# or Homebrew on macOS

brew install --cask codex

# Launch in a repo

cd myproject

# Open a codex interactive session

codex

# In the session you can switch the model:

# (this is typed in the Codex TUI)

> /model gpt-5-codex-mini

# Ask Codex to generate a unit test

> Write pytest tests for function `calculate_discount` in discounts.py

このフローは、使用制限に近づくとツールが Mini を提案する新しい Codex CLI のデフォルトを反映しています。

VS Code / IDE拡張機能

はい、Codex IDE拡張機能(VS Code)にはすでに含まれています gpt-5-codex-mini オプションとして、Visual Studio CodeにCodex拡張機能をインストールすると、インラインコード補完、リファクタリングの提案、AIによるクイックフィックスを利用できます。また、この拡張機能はクイックアクション(コード生成、選択したコードの説明、リファクタリング)を提供し、エディターからCodex Cloudタスクを実行できます。VS Codeのステップ:

- VS Code 用の OpenAI Codex / ChatGPT 拡張機能をインストールします。

- ChatGPT アカウント (Plus/Pro/Business) でサインインします。

- コマンドパレットを開きます。

Cmd/Ctrl+Shift+P → Codex: Set Model→選択gpt-5-codex-mini. - インライン コマンドを使用します (コードを選択 → 右クリック → 「Codex で説明」または設定されたホットキーを押します)。

例: VS Code インライン コマンド (疑似ステップ)

- 関数を選択する

user_service.py. - メディア掲載

Cmd/Ctrl+Shift+P → Codex: Explain Selectionまたは、右クリック → 「Codex で説明」を使用します。 - 拡張機能により、Mini の説明、推奨テスト、Codex Cloud タスクを使用してレビュー用にブランチをプッシュするワンクリックの「PR を作成」ボタンを含むサイド パネルが開きます。

API についてはどうですか? アプリから呼び出すことはできますか?

OpenAIの発表によると APIサポートは近日中に開始されます GPT-5-Codex-Mini用。執筆時点では、このモデルはCodexツールチェーン(CLI/IDE)でのみ利用可能です。つまり、本番環境のAPIクライアントは、モデル名を準備する必要があります。 gpt-5-codex-mini 公開後はリクエスト/レスポンスAPIでご利用いただけます。それまでの間は、Codex CLIとIDEフローでプロトタイプを作成できます。

API アクセスが有効になっている場合、一般的な呼び出し (レスポンス スタイル) は次のようになります。

# illustrative — check OpenAI docs for final param names

from openai import OpenAI

client = OpenAI(api_key="sk-...")

resp = client.responses.create(

model="gpt-5-codex-mini",

input="Write a Python function that validates an email address and includes unit tests.",

max_tokens=512,

temperature=0.2

)

print(resp.output_text)

Codex Mini を使用した迅速なエンジニアリングのベストプラクティスは何ですか?

以下は、生産エンジニアリング ワークフローで Codex Mini から最大限の価値を引き出すための、現場でテストされた具体的なベスト プラクティスとパターンです。

1) モデル選択戦略 - 組み合わせ

頻度が高く複雑度の低いタスク(フォーマット、小規模なリファクタリング、自動テスト)にはMiniを使用し、複雑な設計、詳細なデバッグ、大規模なリポジトリ全体の変更にはCodexにフォールバックします。切り替えを自動化:Codex CLIは既にMiniの使用率を90%に設定しており、スクリプトで切り替えることもできます。 /model ツールを切り替えて、タスクの複雑さに基づいてモデルを選択します。

2) 迅速なエンジニアリングテンプレート

テスト生成、変更ログの下書き、コミットメッセージの生成、PRの説明など、繰り返し実行されるタスク向けに、簡潔で確定的なプロンプトテンプレートを作成します。これらのテンプレートは、再利用可能なスニペットとしてリポジトリに保存するか、Codexプロンプトプリセットとして保存します。

ユニットテストのプロンプトテンプレートの例:

# Template: generate_pytests

System: You are a precise Python developer. Produce pytest tests.

User: Given the function below, produce parametrized pytest functions that cover typical edge cases.

--- file: discounts.py

<insert function>

---

Return only valid Python test code with imports and fixtures.

3) セーフティネットの自動化 - 承認とCIゲーティング

人間の承認なしにモデルが直接コードをプッシュすることは絶対に許可しないでください。Codexの承認モードとCodex Cloudタスクを使用して、差分を作成し、CIで人間の承認を要求してください。Codex CLIは「承認モード」をサポートしているため、編集内容は適用前に承認を受ける必要があります。

4) モデル呼び出しのキャッシュと重複排除

繰り返しのプロンプト(例:関数の説明)の場合、プロンプトとファイルハッシュをキーとする応答をキャッシュします。これにより冗長な呼び出しが削減され、コストプロファイルを予測可能に保つことができます。

5) ストリーミング+増分差分を使用する

可能であれば、ファイル全体の書き換えではなく、ストリーミング出力と増分差分をリクエストしてください。これによりトークンの使用量が削減され、レビュー担当者が対象の変更点を確認しやすくなります。

6) ユニットテストファーストジェネレータフロー

テストを生成し、一時的な環境でローカルに実行します。テストが失敗した場合は、モデルが失敗したテストの修正を提供しながら反復処理を行います。各反復処理は、テスト出力を含む個別のプロンプトとしてフレーム化されます。

Codex CLI 自動化スニペットの例 (bash):

# Generate tests

codex --model gpt-5-codex-mini request "Generate pytest tests for discounts.py" > generated_tests.py

# Run tests locally

pytest generated_tests.py -q || {

echo "Tests failed. Opening Codex for debugging..."

codex --model gpt-5-codex-mini request "Tests failed. Here's pytest output: $(tail -n 50 pytest_output.txt). Propose a fix for discounts.py."

}

結論

GPT-5-Codex-Miniは実用的な製品戦略です。開発者のワークフローは、レイテンシ、コスト、そして途切れないフローが重要となる、多くの短いインタラクションによって支配されることが多いことを認識しています。IDEとCLIの使用に特化したミニ層を提供することで、OpenAIはチームが日々のコーディング支援を拡張できるようにし、あらゆるインタラクションに対して最もコストの高いモデルを即座に呼び出すことなく、拡張できるようにします。

開発者はアクセスできる GPT-5-Codex API ,GPT-5 プロ API CometAPI 経由でアクセスする場合、掲載されている最新モデルは記事公開日時点のものです。アクセスする前に、CometAPI にログインし、API キーを取得していることを確認してください。コメットAPI 統合を支援するために、公式価格よりもはるかに低い価格を提供します。

準備はいいですか?→ 今すぐCometAPIに登録しましょう !