2025年から2026年にかけて、AIツールの環境は統合が進みました。ゲートウェイAPI(CometAPIなど)は拡張され、数百のモデルへのOpenAIスタイルのアクセスを提供するようになりました。一方、エンドユーザー向けLLMアプリ(AnythingLLMなど)は「Generic OpenAI」プロバイダーの改良を続け、デスクトップアプリやローカルファーストアプリがOpenAI互換のエンドポイントを自由に呼び出せるようになりました。これにより、AnythingLLMのトラフィックをCometAPI経由でルーティングし、モデルの選択、コストルーティング、統合課金といったメリットを享受することが現在では容易になっています。しかも、AnythingLLMのローカルUIとRAG/エージェント機能は引き続き利用できます。

AnythingLLM とは何ですか? また、それを CometAPI に接続する理由は何ですか?

AnythingLLMとは何ですか?

AnythingLLMは、チャットアシスタント、検索拡張生成(RAG)ワークフロー、LLM駆動型エージェントを構築するためのオープンソースのオールインワンAIアプリケーションおよびローカル/クラウドクライアントです。洗練されたUI、開発者API、ワークスペース/エージェント機能、そしてローカルおよびクラウドLLMのサポートを提供します。デフォルトではプライベートに設定され、プラグインによって拡張可能です。AnythingLLMは、 一般的なOpenAI OpenAI 互換の LLM API と通信できるプロバイダー。

CometAPI とは何ですか?

CometAPIは、商用API集約プラットフォームであり、 500以上のAIモデル OpenAIスタイルのRESTインターフェースと統一された課金システムを通じて、複数のベンダー(OpenAI、Anthropic、Google/Geminiの派生モデル、画像/音声モデルなど)のモデルを同じインターフェースで呼び出すことができます。 https://api.cometapi.com/v1 エンドポイントと単一のAPIキー(形式 sk-xxxxxCometAPIは、次のような標準的なOpenAIスタイルのエンドポイントをサポートしています。 /v1/chat/completions, /v1/embeddingsなどがあり、すでに OpenAI 互換の API をサポートしているツールを簡単に適応させることができます。

AnythingLLM を CometAPI と統合する理由は何ですか?

3つの実際的な理由:

- モデルの選択とベンダーの柔軟性: AnythingLLMは、Generic OpenAIラッパーを介して「あらゆるOpenAI互換」LLMを利用できます。このラッパーをCometAPIに渡すことで、AnythingLLMのUIやフローを変更することなく、数百ものモデルに即座にアクセスできます。

- コスト/オペレーションの最適化: CometAPI を使用すると、モデルを一元的に切り替えて(またはより安価なモデルにダウンシフトして)コストを管理し、複数のプロバイダー キーを操作することなく統一された課金を維持できます。

- より迅速な実験: 異なるモデルをA/B比較することができます(例:

gpt-4o,gpt-4.5、Claude バリアント、オープンソースのマルチモーダル モデルなど、さまざまなモデルを同じ AnythingLLM UI 経由で使用できます。エージェント、RAG 応答、要約、マルチモーダル タスクに役立ちます。

統合前に準備する必要がある環境と条件

システムおよびソフトウェア要件(概要)

- AnythingLLMを実行しているデスクトップまたはサーバー(Windows、macOS、Linux)—デスクトップインストールまたはセルフホストインスタンス。最新のビルドで公開されていることを確認してください。 LLMの好み / AIプロバイダー 設定を行います。

- CometAPIアカウントとAPIキー(

sk-xxxxxスタイル シークレット)。このシークレットは、AnythingLLM の Generic OpenAI プロバイダーで使用します。 - マシンからネットワーク接続

https://api.cometapi.com(送信 HTTPS をブロックするファイアウォールはありません)。 - オプションですが推奨: テスト用の最新の Python または Node 環境 (Python 3.10+ または Node 18+)、curl、および CometAPI を AnythingLLM に接続する前に正常性チェックを行う HTTP クライアント (Postman / HTTPie)。

AnythingLLM固有の条件

当学校区の 一般的なOpenAI OpenAIのAPIサーフェスを模倣するエンドポイントには、LLMプロバイダーの使用が推奨されます。AnythingLLMのドキュメントでは、このプロバイダーは開発者向けであり、入力内容を理解する必要があると警告されています。ストリーミングを使用する場合、またはエンドポイントがストリーミングをサポートしていない場合は、AnythingLLMにGeneric OpenAIのストリーミングを無効にする設定が含まれています。

セキュリティと運用のチェックリスト

- CometAPI キーを他のシークレットと同様に扱います。リポジトリにコミットせず、可能な場合は OS キーチェーンまたは環境変数に保存します。

- RAG で機密文書を使用する予定の場合は、エンドポイントのプライバシー保証がコンプライアンスのニーズを満たしていることを確認してください (CometAPI のドキュメント/利用規約を確認してください)。

- 請求額の暴走を防ぐために、最大トークン数とコンテキスト ウィンドウの制限を決定します。

CometAPI を使用するために AnythingLLM をどのように構成しますか (ステップバイステップ)?

以下は具体的な手順のシーケンスです。その後に、AnythingLLM UI で設定を保存する前に接続をテストするための環境変数とコード スニペットの例を示します。

ステップ1 - CometAPIキーを取得する

- CometAPI で登録またはサインインしてください。

- 「APIキー」に移動してキーを生成します。次のような文字列が表示されます。

sk-xxxxx秘密にしておいてください。

ステップ2 - CometAPIがクイックリクエストで動作することを確認する

curl または Python を使用して、単純なチャット完了エンドポイントを呼び出し、接続を確認します。

Curlの例

curl -X POST "https://api.cometapi.com/v1/chat/completions" \

-H "Authorization: Bearer sk-xxxxx" \

-H "Content-Type: application/json" \

-d '{

"model": "gpt-4o",

"messages": ,

"max_tokens": 50

}'

これが200とJSONレスポンスを返した場合、 choices 配列の場合、キーとネットワークは機能しています。(CometAPI のドキュメントには、OpenAI スタイルのサーフェスとエンドポイントが表示されています)。

Pythonの例(リクエスト)

import requests

url = "https://api.cometapi.com/v1/chat/completions"

headers = {"Authorization": "Bearer sk-xxxxx", "Content-Type": "application/json"}

payload = {

"model": "gpt-4o",

"messages": ,

"max_tokens": 64

}

r = requests.post(url, json=payload, headers=headers, timeout=15)

print(r.status_code, r.json())

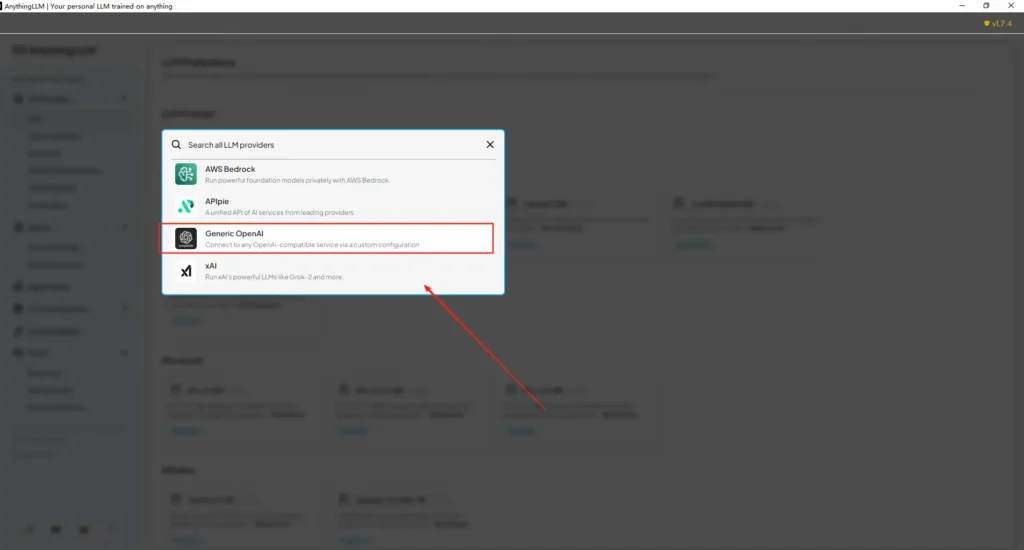

ステップ3 — AnythingLLM(UI)を構成する

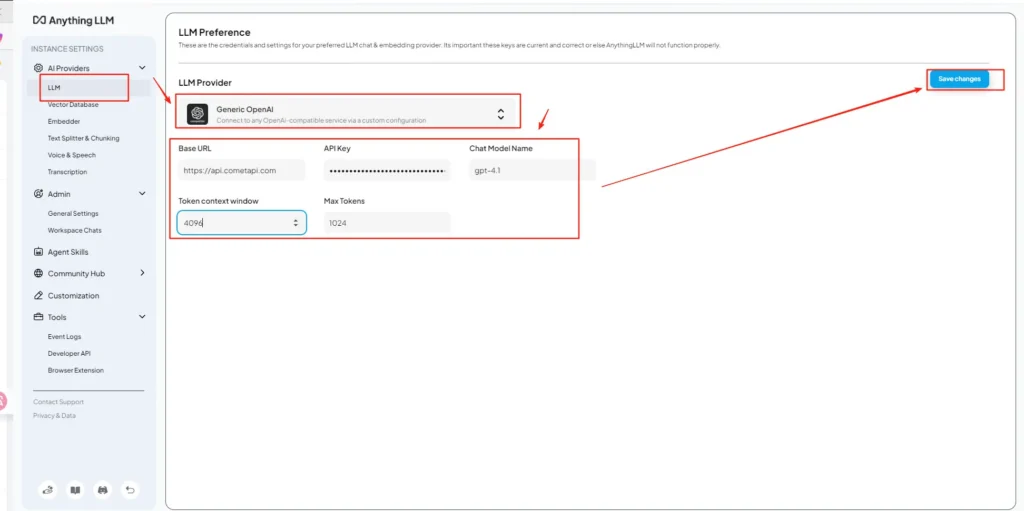

AnythingLLMを開く→設定→ AIプロバイダー → LLMの好み (またはお使いのバージョンで同様のパス)。 一般的なOpenAI プロバイダーを選択し、次のようにフィールドに入力します。

API設定(例)

• AnythingLLM 設定メニューに入り、AI プロバイダーの下にある LLM 設定を見つけます。

• モデルプロバイダーとしてGeneric OpenAIを選択し、https://api.cometapi.com/v1URLフィールドに入力します。

• 貼り付けsk-xxxxxAPIキー入力ボックスにCometAPIから取得したトークンを入力してください。トークンコンテキストウィンドウと最大トークン数は、実際のモデルに合わせて入力してください。このページでは、モデル名をカスタマイズすることもできます。gpt-4oモデル。

これは、AnythingLLM の「Generic OpenAI」ガイダンス (開発者ラッパー) および CometAPI の OpenAI 互換ベース URL アプローチと一致しています。

ステップ4 - モデル名とトークン制限を設定する

同じ設定画面で、CometAPI が公開しているモデル名を正確に追加またはカスタマイズします (例: gpt-4o, minimax-m2, kimi-k2-thinking)をAnythingLLM UIでユーザーに提示することで、これらのモデルをユーザーに提供できます。CometAPIは各ベンダーのモデル文字列を公開しています。

ステップ5 — AnythingLLMでテストする

新しいチャットを開始するか、既存のワークスペースを使用し、Generic OpenAIプロバイダー(複数のプロバイダーがある場合)を選択し、追加したCometAPIモデル名のいずれかを選択して、簡単なプロンプトを実行します。一貫した補完が表示されれば、統合は完了です。

AnythingLLMが内部的にこれらの設定を使用する方法

AnythingLLMのGeneric OpenAIラッパーはOpenAIスタイルのリクエストを構築します(/v1/chat/completions, /v1/embeddings)なので、ベースURLを指定してCometAPIキーを入力すると、AnythingLLMはチャット、エージェントコール、埋め込みリクエストをCometAPI経由で透過的にルーティングします。AnythingLLMエージェント( @agent フローの場合、それらは同じプロバイダーを継承します。

ベストプラクティスと起こりうる落とし穴は何ですか?

ベストプラクティス

- モデルに適したコンテキスト設定を使用します。 AnythingLLMのトークンコンテキストウィンドウと最大トークン数を、CometAPIで選択したモデルに合わせてください。一致しないと、予期しない切り捨てや呼び出しの失敗が発生します。

- API キーを保護します: CometAPIキーは環境変数またはKubernetes/シークレットマネージャーに保存し、gitにチェックインしないでください。AnythingLLMは、UIでキーを入力するとローカル設定に保存します。ホストストレージは機密情報として扱ってください。

- 実験フローには、より安価で小規模なモデルから始めましょう。 CometAPI を使用すると、開発用に低コストのモデルを試用し、本番環境用にプレミアムモデルを予約できます。CometAPI は、コストの切り替えと統合課金を明確に宣伝しています。

- 使用状況を監視し、アラートを設定する: CometAPI は使用状況ダッシュボードを提供します。予期せぬ請求を避けるために予算/アラートを設定します。

- エージェントとツールを個別にテストする: AnythingLLM エージェントはアクションをトリガーできます。まずは安全なプロンプトとステージングインスタンスでテストしてください。

よくある落とし穴

- UI vs

.env競合: セルフホスティングの場合、UI設定は上書きされる可能性があります.env変更(およびその逆)を確認します。生成された/app/server/.env再起動後に状況が元に戻る場合。コミュニティの問題レポートLLM_PROVIDERリセットします。 - モデル名の不一致: CometAPI で利用できないモデル名を使用すると、ゲートウェイから 400/404 エラーが発生します。必ず CometAPI モデルリストで利用可能なモデルをご確認ください。

- トークン制限とストリーミング: ストリーミングレスポンスが必要な場合は、CometAPI モデルがストリーミングをサポートしていることを確認してください(AnythingLLM の UI バージョンもストリーミングをサポートしていることを確認してください)。プロバイダーによっては、ストリーミングのセマンティクスが異なります。

この統合により、どのような実際の使用例が可能になりますか?

検索拡張生成 (RAG)

AnythingLLMのドキュメントローダーとベクターDBをCometAPI LLMと組み合わせることで、コンテキストアウェアな回答を生成できます。安価な埋め込みと高価なチャットモデルを組み合わせたり、すべてをCometAPIで処理して統一された課金体系を実現したりすることも可能です。AnythingLLMのRAGフローは、主要な組み込み機能です。

エージェント自動化

AnythingLLMはサポートしています @agent ワークフロー(ページの閲覧、ツールの呼び出し、自動化の実行)。CometAPIを介してエージェントのLLM呼び出しをルーティングすることで、エージェントコードを変更することなく、制御/解釈ステップのモデルを選択できます。

マルチモデルのA/Bテストとコスト最適化

ワークスペースまたは機能ごとにモデルを切り替える(例: gpt-4o 生産に関する回答については、 gpt-4o-mini (開発者向け) CometAPI により、モデルのスワップが簡単になり、コストが集中化されます。

マルチモーダルパイプライン

CometAPIは画像、音声、そして特殊モデルを提供します。AnythingLLMのマルチモーダルサポート(プロバイダー経由)とCometAPIのモデルを組み合わせることで、画像のキャプション作成、マルチモーダル要約、音声の書き起こしを同じインターフェースで実行できます。

結論

CometAPIは、マルチモデルゲートウェイ(500以上のモデル、OpenAIスタイルのAPI)としての地位を確立しており、AnythingLLMのような既にGeneric OpenAIプロバイダーをサポートしているアプリにとって最適なパートナーとなります。同様に、AnythingLLMのGenericプロバイダーと最新の設定オプションにより、このようなゲートウェイへの接続が容易になります。この統合により、2025年後半の実験と本番環境への移行が簡素化されます。

Comet API を使い始める方法

CometAPIは、OpenAIのGPTシリーズ、GoogleのGemini、AnthropicのClaude、Midjourney、Sunoなど、主要プロバイダーの500以上のAIモデルを、開発者にとって使いやすい単一のインターフェースに統合する統合APIプラットフォームです。一貫した認証、リクエストフォーマット、レスポンス処理を提供することで、CometAPIはAI機能をアプリケーションに統合することを劇的に簡素化します。チャットボット、画像ジェネレーター、音楽作曲ツール、データドリブン分析パイプラインなど、どのようなアプリケーションを構築する場合でも、CometAPIを利用することで、反復処理を高速化し、コストを抑え、ベンダーに依存しない環境を実現できます。同時に、AIエコシステム全体の最新のブレークスルーを活用できます。

まず、モデルの機能を調べてみましょうコメットAPI 会場は プレイグラウンド 詳細な手順についてはAPIガイドをご覧ください。アクセスする前に、CometAPIにログインし、APIキーを取得していることを確認してください。 とeタピ 統合を支援するために、公式価格よりもはるかに低い価格を提供します。

準備はいいですか?→ 今すぐCometAPIに登録しましょう !