AIは急速に進化しています。新しいマルチモーダルモデルと改良されたリアルタイムAPIにより、強力なAIを自動化プラットフォームに組み込むことが容易になり、同時に安全性と可観測性に関する議論も相まって、チームが本番環境システムを運用する方法が変わりつつあります。ローカル自動化を構築する人々にとって、実用的なパターンが生まれつつあります。それは、統合モデルゲートウェイ( コメットAPI)を使用して多くのモデルにアクセスし、それらのモデル呼び出しをセルフホスト型自動化ランナー( n8n)を使用して、データ、レイテンシ、コストを管理できます。このガイドでは、ステップバイステップで導入方法を説明します。 CometAPI + n8n (ローカル)、何に注意すべきか、そして問題が発生した場合のトラブルシューティング方法について説明します。

n8n とは何ですか? AI 自動化にとってなぜ重要ですか?

n8nは、ビジュアルエディタと大規模なノード(コネクタ)エコシステムを備えたオープンソースのワークフロー自動化ツールです。トリガー、変換、外部API呼び出しを繰り返し利用可能なワークフロー(Webhook、スケジュールジョブ、ファイル処理、チャットボットなど)に組み込むことができるように設計されています。n8nをローカルでセルフホスティングすることで、データの保存場所と実行を完全に制御できます。これは、機密性の高い入力を扱うサードパーティのAIモデルを呼び出す際に特に役立ちます。

n8n は実際にはどのように機能しますか?

- トリガー (Webhook、Cron) とアクション ノード (HTTP リクエスト、データベース ノード、電子メール) を備えたビジュアル キャンバス。

- コミュニティ ノードは機能を拡張します。コミュニティ パッケージをインストールして、ネイティブ ノードのように扱うことができます。

セルフホスティング n8n では次のことが実現します:

- 完全なデータ制御 — ワークフローと実行データは、管理するインフラストラクチャ上に残ります。

- カスタマイズ — クラウド機能を待たずにプライベート ノードまたはローカル統合を追加します。

- コストの予測可能性 — 高度な内部自動化によるタスクごとのクラウド請求の驚きはありません。

- セキュリティとコンプライアンス — 社内のポリシーや規制のニーズを満たしやすくなります。

CometAPI とは何ですか? また、なぜそれをモデル ゲートウェイとして使用するのですか?

コメットAPI は、数百ものサードパーティ製AIモデル(テキスト、埋め込み、画像生成など)を、単一のOpenAI互換インターフェースと課金モデルで利用できる統合APIゲートウェイです。つまり、試したいLLMや画像エンジンごとに個別の統合を追加する代わりに、1つのAPIを呼び出してリクエストで必要なモデルを選択するだけで済みます。これにより、実験、コスト管理、運用統合が簡素化されます。

利点:

- モデルの選択: 同じコードパスを持つ多くのベンダー/モデルを試してください。

- トークンプール/無料割り当て: 多くの統合ゲートウェイでは、実験用のクレジット/ティアを提供しています。

- よりシンプルなインフラ: 管理する認証システムとベース URL が 1 つずつ。

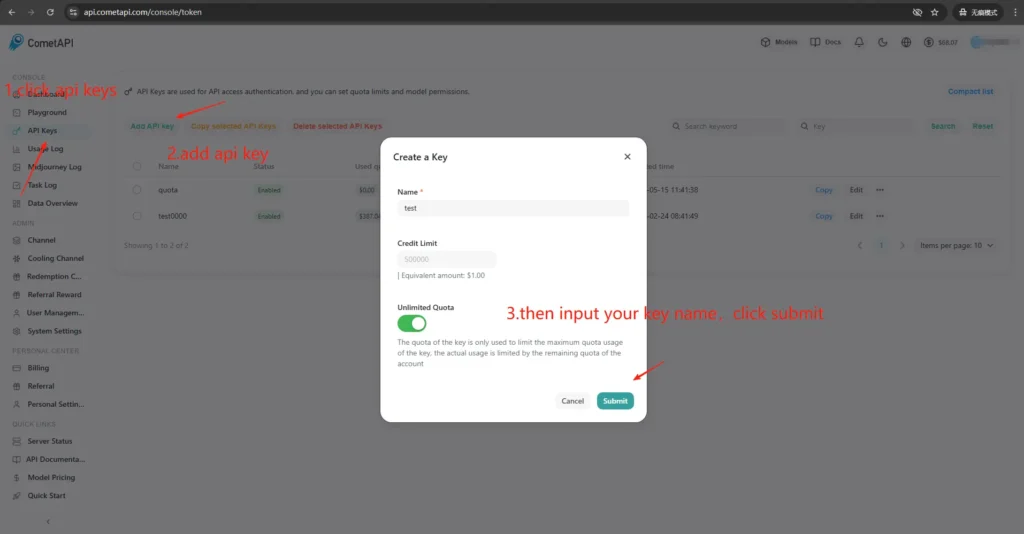

CometAPI のアクセスとキーを取得するにはどうすればよいですか?

- 会員登録について CometAPIサイト(またはベンダーダッシュボード)でご確認ください。ほとんどのゲートウェイには、テスト用の無料プランが用意されています。

- APIキーを取得する CometAPIダッシュボードから取得できる長い秘密の文字列です。ドキュメントに記載されている場所に配置してください(CometAPIはベアラー認証を使用します)。

https://api.cometapi.com/v1). - APIドキュメントを読む 使用する予定のエンドポイント(チャット補完、画像、埋め込み)について。CometAPIドキュメントには次のようなエンドポイントが記載されています。

/v1/chat/completionsおよび/v1/images/generations.

n8n と CometAPI の結合 (統合) が重要なのはなぜですか?

ここでの「ボンディング」とは、オートメーションランナー(n8n)とモデルゲートウェイ間の信頼性が高く安全な統合パスを意味します。適切なボンディングが重要な理由は以下のとおりです。

- それは保存します コンテキスト 通話全体(会話履歴、埋め込み)。

- 集中化 資格情報 秘密を 1 か所にまとめ、より安全なローテーションを実現します。

- 予測可能なエンドポイントと標準のリクエスト形式を使用することで、レイテンシとエラー領域を削減します。

- それは可能にします 可観測性 トラブルシューティング - どのモデル、プロンプト、応答が結果につながったかを把握します。

つまり、良好な結合により運用リスクが低減し、反復が高速化されます。

n8n をローカルに展開するにはどうすればよいですか (簡単な実用ガイド)?

n8nをローカルで実行するには、 npm またはDockerを使用します。Docker Composeは、ほとんどのセルフホストシナリオで推奨されるアプローチです(再現性が高く、依存関係を分離できるため)。以下に、最小限のDocker Composeの例と重要な注意事項を示します。

Docker を使用して n8n をセルフホストするにはどうすればよいですか?

Docker(およびDocker Compose)は、n8nを本番環境で実行するための最も堅牢で繰り返し実行可能な方法です。アプリを分離し、アップグレードを簡素化し、リバースプロキシやオーケストレーター(Docker Swarm、Kubernetes)との連携も良好です。n8nの公式ドキュメントにはDocker Composeリファレンスが含まれており、ここではそれを参考にして修正します。

本番環境では通常、次のもので構成されるスタックを実行します。

- n8nサービス(公式画像:

docker.n8n.io/n8nio/n8norn8nio/n8n(タグによって異なります)。 - PostgreSQL (またはサポートされている他の DB)。

- Redis (キュー モードを使用する予定の場合)。

- TLS、ホスト ルーティング、およびレート制限ルール用のリバース プロキシ (Traefik、Caddy、または nginx)。

このアーキテクチャは、DBの永続性、キューイング、Webプロキシといった懸念事項を明確に分離し、スケーリングとバックアップを容易にします。n8nの公式ドキュメントには、Docker Composeのパターンと環境変数のリファレンスが掲載されています。

これはステップバイステップのガイドです:

- フォルダを作成し、

docker-compose.yml標準的なn8nサービスを使用します。以下は、典型的な本番環境のニーズを満たす実用的なdocker-composeの例です。外部Postgres、Redis(キュー/実行モード用)、永続ボリューム、そしてTLSを処理するNginxリバースプロキシで構成されています。

```yaml

version: "3.8"

services:

n8n:

image: n8nio/n8n:latest

restart: unless-stopped

environment:

- DB_TYPE=postgresdb

- DB_POSTGRESDB_HOST=postgres

- DB_POSTGRESDB_PORT=5432

- DB_POSTGRESDB_DATABASE=n8n

- DB_POSTGRESDB_USER=n8n

- DB_POSTGRESDB_PASSWORD=supersecretpassword

- N8N_BASIC_AUTH_ACTIVE=true

- N8N_BASIC_AUTH_USER=admin

- N8N_BASIC_AUTH_PASSWORD=anothersecret

- WEBHOOK_TUNNEL_URL=https://n8n.example.com

- EXECUTIONS_MODE=queue

- QUEUE_BULL_REDIS_HOST=redis

ports:

- "5678:5678"

volumes:

- n8n_data:/home/node/.n8n

depends_on:

- postgres

- redis

postgres:

image: postgres:15

environment:

POSTGRES_DB: n8n

POSTGRES_USER: n8n

POSTGRES_PASSWORD: supersecretpassword

volumes:

- pgdata:/var/lib/postgresql/data

redis:

image: redis:7

volumes:

- redisdata:/data

volumes:

n8n_data:

pgdata:

redisdata:

2. 開始

docker compose up -d

3. ロケーション選択 `http://localhost:5678` 管理者ユーザーを作成してください。本番環境では、Postgres、SSL、適切な環境変数が必要になります。詳しくはDocker Composeの公式ドキュメントをご覧ください。

**注記と強化:**

- Do 秘密を平文で保存する `docker-compose.yml`; 本番環境では環境ファイル、Docker シークレット、または外部シークレット マネージャーを使用します。

- 交換する `WEBHOOK_URL` 実際の公開URLを設定し、リバースプロキシをルーティングするように設定してください。 `n8n.example.com` n8n コンテナに。

- `EXECUTIONS_MODE=queue` 堅牢なバックグラウンド処理を行うには、キュー ワーカーと Redis が必要です。

## npm / Node.js を使用して n8n をセルフホストするにはどうすればよいですか?

npm(またはpnpm)経由でインストールすると、n8nはホスト上で直接実行されます。これはコンテナレイヤーがないため軽量で、シングルユーザー向け、複雑性の低いインストール、または開発者向けマシンに適している可能性があります。ただし、依存関係の管理、分離、サービスの監視など、管理者の責任は大きくなります。n8nの公式ドキュメントには、npmのインストールガイドと注意事項が記載されています。

### 必要な OS パッケージと Node バージョン:

- 安定した LTS Node.js (Node 18 または Node 20+、n8n リリース要件に一致) を使用します。

- インストールを開始する `build-essential`, `git`、プロセス マネージャー (systemd を推奨)。

- 本番環境では、PostgreSQL と Redis を外部サービスとして使用します (Docker と同じ理由)。

### npm 経由で n8n をインストールして実行するにはどうすればよいですか (ステップバイステップ)?

1.Node.jsをインストールする(推奨:nvm)

Install nvm

curl -o- https://raw.githubusercontent.com/nvm-sh/nvm/v0.39.7/install.sh | bash

Reload your shell (adjust to your shell startup file if needed)

source ~/.bashrc # or ~/.zshrc

Install and use the latest LTS (usually 18 or 20)

nvm install --lts

nvm use --lts

Verify

node -v

npm -v

後で「n8n: command not found」と表示された場合は、ターミナルを再起動するか、nvm 管理の npm グローバル bin パスが PATH 上にあることを確認してください。

---

2. n8n(ローカル)をインストールして起動する

npm install -g n8n

n8n -v # verify version

3. フォアグラウンドで開始します。

n8n start

デフォルトの URL: <http://localhost:5678/> ポートが使用中の場合:

export N8N_PORT=5679

n8n start

オプション: バックグラウンドで実行し続けます (ローカルのまま):

npm install -g pm2

pm2 start "n8n" --name n8n

pm2 save

pm2 status

4.最初のアクセスとサインイン:

- ブラウザで http://localhost:5678/ を開きます。

- 初めて実行するときは、ウィザードに従って所有者アカウント (電子メール + パスワード) を作成し、サインインします。

## n8n で CometAPI コミュニティ ノードをインストールまたは構成するにはどうすればよいですか?

n8nは、検証済みのコミュニティノード(GUIインストール)と、セルフホスト時のnpmからの手動インストールの両方をサポートしています。CometAPIをn8nに統合する方法はXNUMXつあります。

### オプション A - CometAPI コミュニティ ノードを使用する (ノード パネルで使用可能な場合)

1. n8nでノードパネルを開きます( `+` or `Tab`).

2. CometAPI は検証済みのコミュニティ ノードであり、「コミュニティのその他の情報」の下に表示されます。クリックしてインストールします。

3. インストール後、プロンプトが表示されたらn8nを再起動してください。新しい **資格** → (ノードが提供している場合は CometAPI 資格情報タイプを選択) で、CometAPI トークンを貼り付けます。

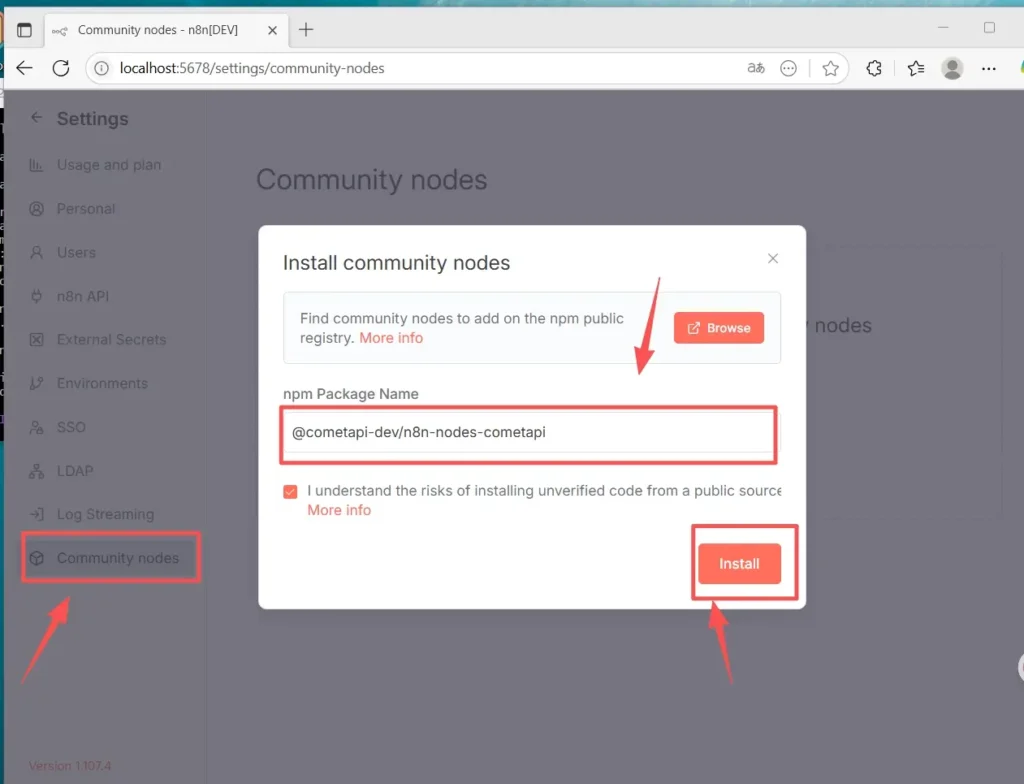

### オプション B - 手動インストール(GUI インストールが利用できない場合)

1. n8n ホスト/コンテナに SSH で接続します。

2. グローバルn8nにパッケージをインストールする `node_modules` またはカスタムフォルダー:

- 設定(左下)>コミュニティノードに移動し、「

- コミュニティノードをインストールする

- 「npm パッケージ名」に以下を入力します。 `@cometapi-dev/n8n-nodes-cometapi`リスク承認ボックスにチェックを入れ、「

- 「インストール」インストール後、ノードパネルで「CometAPI」を検索できるようになります。

3. n8nを再起動します。インスタンスがキューモードで実行されている場合は、ドキュメントに記載されている手動インストールルートに従う必要があります。

### ノードがインストールされているかどうかを確認する方法

- 再起動後、ノードパネルを開き、「CometAPI」または「Comet」を検索してください。ノードはコミュニティパッケージとしてマークされます。

- ノードが表示されない場合は、インスタンス所有者のアカウントが使用されていること (インスタンス所有者のみがインストールできます)、またはノード パッケージがコンテナ/イメージ ログにエラーなしでインストールされていることを確認します。

## ワークフローを作成し、APIを構成する方法

### 1. 新しいワークフローを作成する

- n8n インスタンス (セルフホスト) にログインします。

- 詳しくはこちら **「ワークフローを追加」** 新しい自動化キャンバスを開始します。

### 2.ノードを追加する

- トリガー ノードを追加します。「手動トリガー」または「 をクリックしたとき」を検索します。

- キャンバスの右側にある「+」をクリックし、「CometAPI」を検索してノードを追加します。

- 左側のノードリストから「CometAPI」を検索し、キャンバスにドラッグすることもできます。

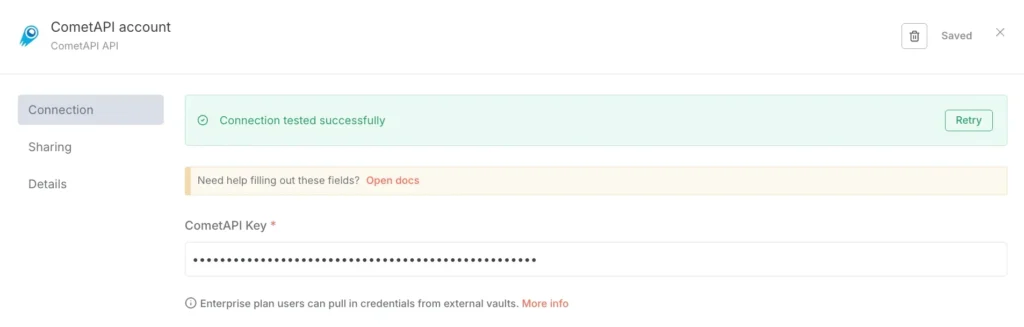

### 3. 資格情報を設定します(初回のみ)

- CometAPI ノードの「接続に使用する資格情報」の下で、「新規作成」を選択します。

- CometAPI コンソールで作成したトークンを「CometAPI キー」に貼り付けます。

- 保存します。ベース URL はデフォルトで https://www.cometapi.com/console/ に設定されており、通常は変更する必要はありません。

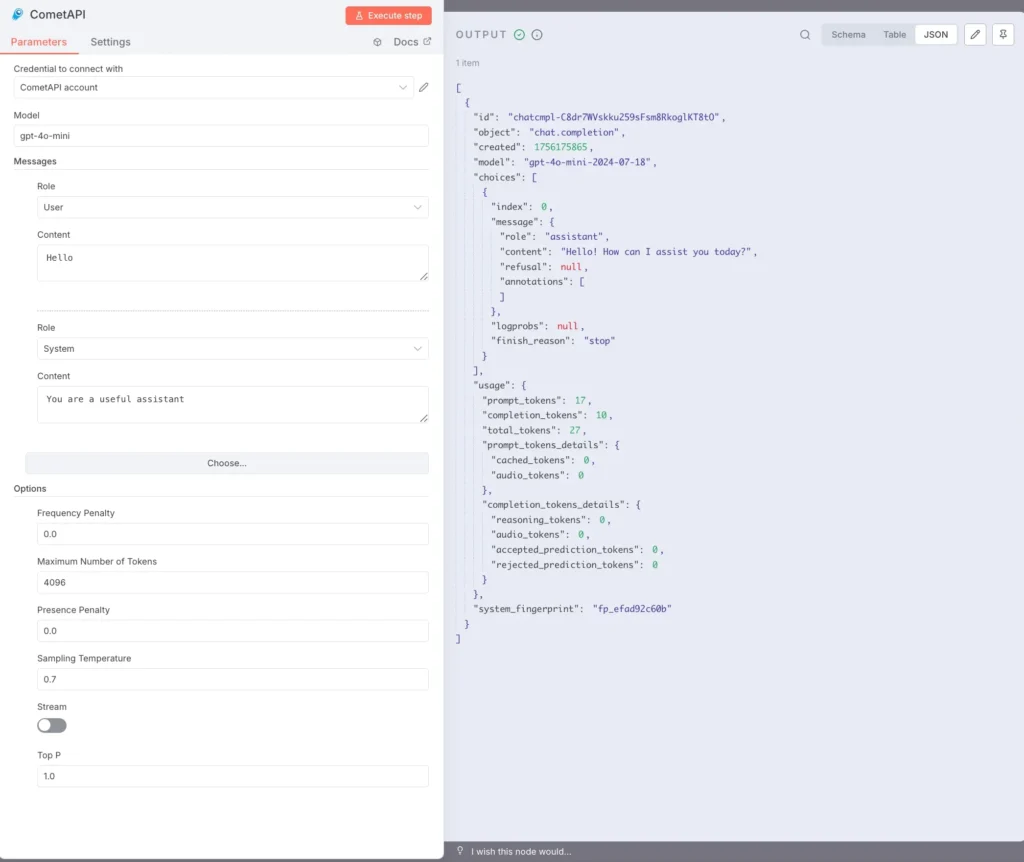

### 4. モデルとメッセージを設定します。

モデル: サポートされているモデルを入力します。例: `gpt-4o` or `gpt-4o-mini`.

メッセージ: 役割とコンテキストを入力する必要があります。役割にはユーザーまたはシステムを選択できます。

オプションパラメータ(必要に応じて):トークンの最大数(例:4096)、サンプリング温度(例:0.7)、PenaltyStream(ストリーミングの有効化/無効化)。具体的なパラメータの説明については、 [CometAPIドキュメント](https://api.cometapi.com/doc).

### 5.テキスト実行:

CometAPI ノードを選択し、「ステップを実行」をクリックするか、下部の「ワークフローを実行」をクリックします。

右側の OUTPUT パネルに JSON 応答 (選択肢、使用方法などを含む) が表示されます。

これで、npm 経由で Linux に n8n(Recommend) をローカルにインストールし、CometAPI コミュニティ ノードをインストールして構成し、gpt-4o などのモデルを呼び出して応答を受信するワークフローを実行できるようになりました。

## よくある問題とは何ですか? また、そのトラブルシューティング方法を教えてください。

### 1) 「401 不正」または「無効なAPIキー」

- CometAPIダッシュボードで正確なトークン文字列を確認してください(似たような名前のトークンが複数存在する場合があります)。コピーしてn8n認証情報に貼り付け、必要に応じてノードを再起動してください。

- 認証ヘッダーのフォーマットが `Bearer sk-xxxxx`.

### 2) コミュニティノードがインストールされない / 「キューモード」

- n8nが **キューモード**GUIインストールは無効にできます。手動インストールドキュメントに従って、npm経由でコミュニティノードをインストールするか、ノードを含むカスタムイメージをビルドしてください。インストール後、n8nを再起動してください。

### 3) インストール後にパレットにノードが見つからない

- n8nを再起動します。

- パッケージが正しいコンテキスト(コンテナイメージ内または `.n8n/custom` (そのパターンを使用する場合はパス)。

- コンテナ ログでモジュール解決エラーを確認します。

### 4) レート制限またはクォータの問題

- 使用状況と割り当てについては、CometAPI ダッシュボードを確認してください。

- 制限の警告または HTTP 429 を検出したときに、指数バックオフを実装し、より安価なモデルにフォールバックします。

## コミュニティ ノードが利用できない場合、またはより柔軟性が必要な場合、代替手段はありますか?

はい、いつでも **HTTPリクエスト** ノードを直接(フルコントロール)または [ベース URL を持つ OpenAI ノード](https://apidoc.cometapi.com/n8n-965890m0) リダイレクト(実用的なショートカット)。また、生のHTTPを使用すると、新しいCometAPIエンドポイント(画像/動画エンドポイントなど)がリリースされたときにも簡単に導入できます。 [ガイド](https://apidoc.cometapi.com/n8n-965890m0).

**も参照してください** [CometAPIでn8nを使用する方法](https://www.cometapi.com/ja/how-to-use-n8n-with-cometapi/?utm_source=chatgpt.com)

## まとめ:

CometAPIはモデルの選択肢と運用の簡素化を提供し、n8nは視覚的なオーケストレーションと拡張性を実現します。OpenAIの認証情報トリックを使えば、チャットや補完機能の迅速な統合が可能になり、コミュニティノードも存在し信頼されている場合は活用できます。あらゆるワークフローをコスト、レイテンシ、セキュリティの観点からインストルメント化し、重要な決定には人間によるフォールバックを優先し、モデル選択を動的に保つことで、AIベンダーの急速な変化にも対応できます。n8nとCometAPIの組み合わせは強力ですが、他の強力なツールと同様に、観察、テスト、反復といったガードレールが必要です。