DeepSeek-V3.1は、DeepSeekの最新のハイブリッド推論モデルです。高速な「非思考」チャットモードと、より慎重な「思考/推論」モードの両方をサポートし、最大128KBの長いコンテキスト、構造化された出力、関数呼び出しを提供します。DeepSeekのOpenAI互換API、Anthropic互換エンドポイント、またはCometAPIを介して直接アクセスできます。以下では、モデルの概要、ベンチマークとコストのハイライト、高度な機能(関数呼び出し、JSON出力、推論モード)について説明し、具体的なエンドツーエンドのコードサンプル(DeepSeek RESTの直接呼び出し(curl / Node / Python)、Anthropicクライアントの使用方法、CometAPI経由の呼び出し)を示します。

DeepSeek-V3.1 とは何ですか? このリリースの新機能は何ですか?

DeepSeek-V3.1は、DeepSeek V3ファミリーの最新リリースです。これは、大容量、専門家混合の大規模言語モデルラインで、 ハイブリッド推論設計 2つの動作「モード」 - 高速 考えないチャット モードと 思考者/推論者 より高度な推論タスクやエージェント/ツールの使用において、思考連鎖型のトレースを可視化できるモードです。本リリースでは、「思考」レイテンシの高速化、ツール/エージェント機能の向上、そしてドキュメント規模のワークフローにおけるコンテキスト処理の高速化に重点を置いています。

重要な実践的ポイント:

- 2つの操作モード:

deepseek-chatスループットとコストについては、deepseek-reasoner(推論モデル) 思考の連鎖のトレースやより高い推論の忠実度が必要な場合。 - 長いドキュメントに対するエージェント/ツールの処理とトークナイザー/コンテキストの改善がアップグレードされました。

- コンテキストの長さ: 最大約 128K トークン (長いドキュメント、コードベース、ログを有効にします)。

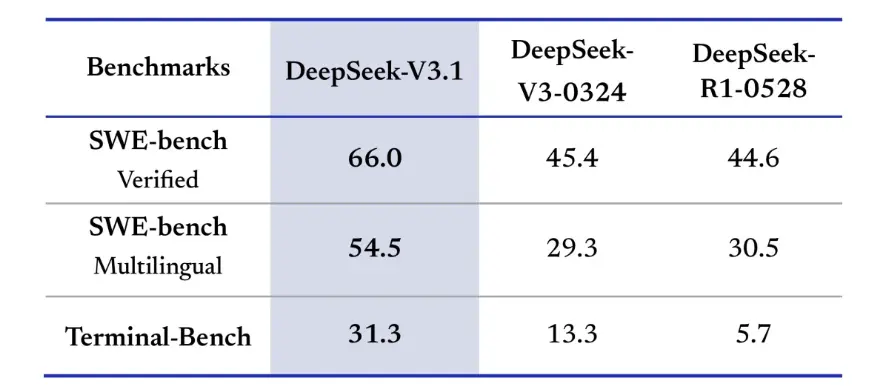

ベンチマークの突破

DeepSeek-V3.1は、実世界のコーディング課題において大幅な改善を示しました。ユニットテストの合格を確実にするためにモデルがGitHubの問題をどの程度修正しているかを測定するSWE-bench Verified評価において、V3.1は66%の成功率を達成しました。これに対し、V45-3とR0324はいずれも1%でした。多言語バージョンでは、V3.1は54.5%の問題を解決し、他のバージョンの約30%の成功率のほぼ3.1倍となりました。モデルが実際のLinux環境でタスクを正常に完了できるかどうかをテストするTerminal-Bench評価では、DeepSeek-V31は13%のタスクを成功させました。これに対し、他のバージョンはそれぞれ6%と3.1%でした。これらの改善は、DeepSeek-VXNUMXが実世界のツール環境でのコード実行と動作において、より信頼性が高いことを示しています。

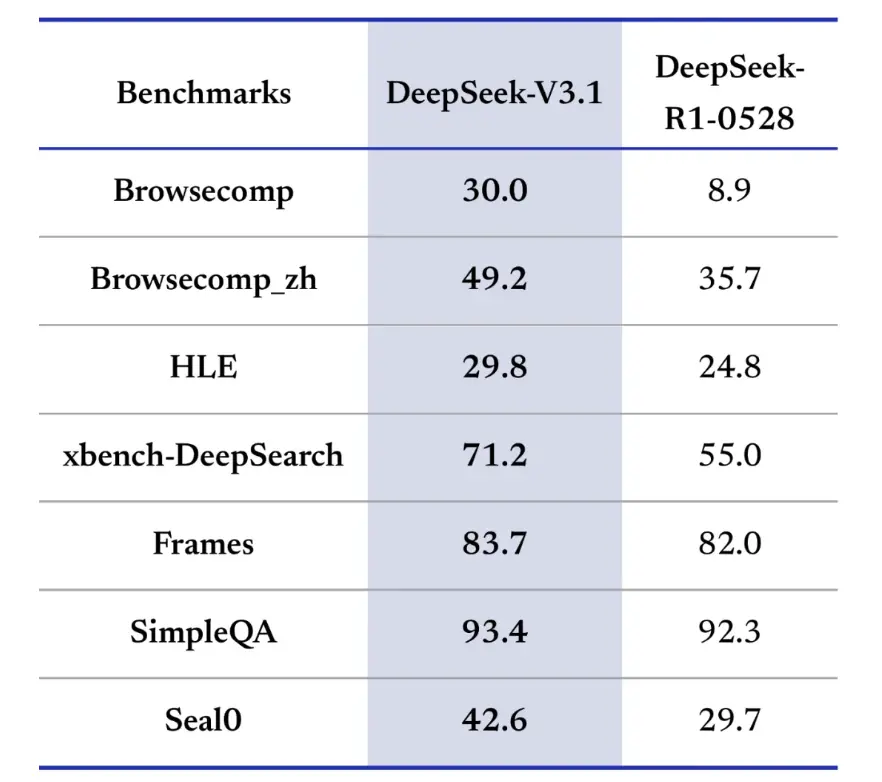

情報検索ベンチマークでも、DeepSeek-V3.1は閲覧、検索、質問応答で優れています。Webページからナビゲートして回答を抽出する必要があるBrowseComp評価では、V3.1は質問の30%に正しく回答したのに対し、R9は1%でした。中国語版では、DeepSeek-V3.1は49%の精度を達成したのに対し、R36は1%でした。Hard Language Exam (HLE)では、V3.1はR1をわずかに上回り、それぞれ30%と25%の精度を達成しました。ソース間で情報を統合する必要があるxbench-DeepSearchなどのディープサーチタスクでは、V3.1は71%のスコアを獲得したのに対し、R1は55%でした。DeepSeek-V3.1は、(構造化推論)、SimpleQA (事実に基づく質問応答)、Seal0 (ドメイン固有の質問応答)などのベンチマークでも、わずかですが一貫したリードを示しました。全体的に、V3.1 は情報検索と軽量の質問応答において R1 を大幅に上回りました。

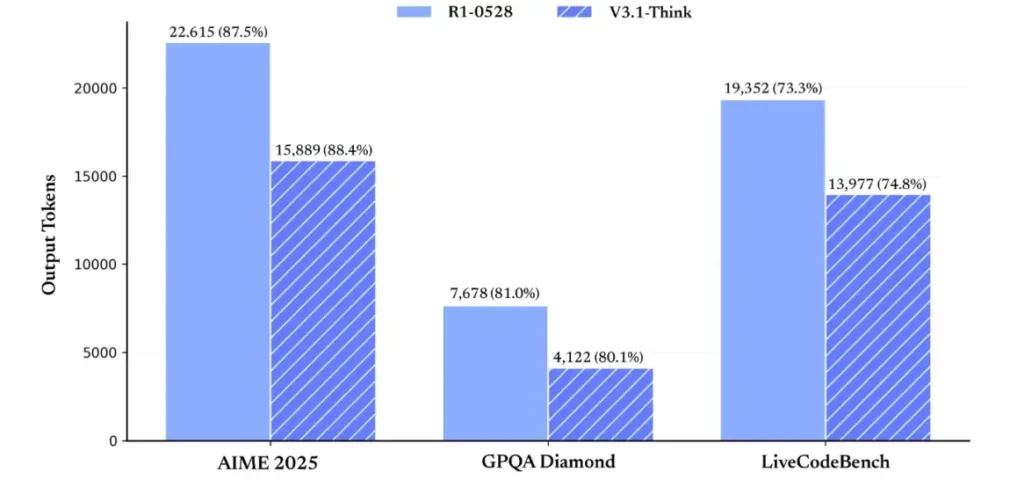

推論効率の面では、トークン使用結果がその有効性を実証しています。AIME 2025(難関数学試験)において、V3.1-ThinkはR1と同等かわずかに上回る精度(88.4%対87.5%)を達成しましたが、使用するトークン数は約30%少なくなっています。GPQA Diamond(多分野にわたる大学院試験)では、80.1つのモデルはほぼ互角(81.0%対3.1%)でしたが、V1はR3.1のほぼ半分のトークンを使用しました。コード推論を評価するLiveCodeBenchベンチマークでは、V74.8はより正確(73.3%対3.1%)であるだけでなく、より簡潔な結果となりました。これは、VXNUMX-Thinkが冗長性を避けながら詳細な推論を提供できることを示しています。

全体的に見て、V3.1はV3-0324と比較して大きな世代的飛躍を遂げています。R1と比較すると、V3.1はほぼすべてのベンチマークで高い精度を達成し、高度な推論タスクにおいてより効果的でした。R1と同等の性能を示した唯一のベンチマークはGPQAでしたが、コストはほぼXNUMX倍でした。

API キーを取得して開発アカウントを設定するにはどうすればよいですか?

ステップ 1: サインアップしてアカウントを作成する

- DeepSeekの開発者ポータル(DeepSeekドキュメント/コンソール)にアクセスし、メールアドレスまたはSSOプロバイダーでアカウントを作成してください。

- ポータルで必要な身元確認や請求設定を完了します。

ステップ 2: API キーを作成する

- ダッシュボードで、 APIキー → キーの作成キーに名前を付けます(例:

dev-local-01). - キーをコピーし、安全なシークレット マネージャーに保存します (以下の運用のベスト プラクティスを参照してください)。

ヒント: 一部のゲートウェイやサードパーティ製ルーター(CometAPIなど)では、単一のゲートウェイキーを使用してDeepSeekモデルにアクセスできます。これは、マルチプロバイダ冗長性に役立ちます( ディープシークV3.1API セクション)。

開発環境 (Linux/macOS/Windows) をセットアップするにはどうすればよいですか?

これは、DeepSeek (OpenAI 互換エンドポイント)、CometAPI、および Anthropic で動作する、Python および Node.js 用のシンプルで再現可能なセットアップです。

前提条件

- Python 3.10+ (推奨)、pip、virtualenv。

- Node.js 18+ および npm/yarn。

- curl (簡単なテスト用)。

Python 環境 (ステップバイステップ)

- プロジェクト ディレクトリを作成します。

mkdir deepseek-demo && cd deepseek-demo

python -m venv .venv

source .venv/bin/activate # macOS / Linux

# .venv\Scripts\activate # Windows PowerShell

- 最小限のパッケージをインストールします。

pip install --upgrade pip

pip install requests

# Optional: install an OpenAI-compatible client if you prefer one:

pip install openai

- API キーを環境変数に保存します (コミットしないでください)。

export DEEPSEEK_KEY="sk_live_xxx"

export CometAPI_KEY="or_xxx"

export ANTHROPIC_KEY="anthropic_xxx"

(Windows PowerShellの使用 $env:DEEPSEEK_KEY = "…")

ノード環境(ステップバイステップ)

- 初期化:

mkdir deepseek-node && cd deepseek-node

npm init -y

npm install node-fetch dotenv

- 作る

.envファイル:

DEEPSEEK_KEY=sk_live_xxx

CometAPI_KEY=or_xxx

ANTHROPIC_KEY=anthropic_xxx

DeepSeek-V3.1 を直接呼び出すにはどうすればいいですか? - ステップバイステップのコード例?

DeepSeekのAPIはOpenAIと互換性があります。以下は コピー&ペースト 例: curl、Python (リクエストと openai SDK スタイル)、Node。

ステップ1: 簡単なcurlの例

curl https://api.deepseek.com/v1/chat/completions \

-H "Authorization: Bearer $DEEPSEEK_KEY" \

-H "Content-Type: application/json" \

-d '{

"model": "deepseek-chat-v3.1",

"messages": [

{"role":"system","content":"You are a concise engineering assistant."},

{"role":"user","content":"Give a 5-step secure deployment checklist for a Django app."}

],

"max_tokens": 400,

"temperature": 0.0,

"reasoning_enabled": true

}'

注意: reasoning_enabled 思考モード(ベンダーフラグ)を切り替えます。正確なフラグ名はプロバイダーによって異なる場合がありますので、モデルのドキュメントをご確認ください。

ステップ2: シンプルなテレメトリを使用したPython(リクエスト)

import os, requests, time, json

API_KEY = os.environ

URL = "https://api.deepseek.com/v1/chat/completions"

payload = {

"model": "deepseek-chat-v3.1",

"messages": [

{"role": "system", "content": "You are a helpful coding assistant."},

{"role": "user", "content": "Refactor this Flask function to be testable: ..."}

],

"max_tokens": 600,

"temperature": 0.1,

"reasoning_enabled": True

}

start = time.time()

r = requests.post(URL, headers={

"Authorization": f"Bearer {API_KEY}",

"Content-Type": "application/json"

}, json=payload, timeout=60)

elapsed = time.time() - start

print("Status:", r.status_code, "Elapsed:", elapsed)

data = r.json()

print(json.dumps(data, indent=2))

CometAPI: DeepSeek V3.1への完全無料アクセス

登録なしですぐにアクセスしたい開発者にとって、CometAPIはDeepSeek V3.1(モデル名:deepseek-v3-1-250821; deepseek-v3.1)の魅力的な代替手段となります。このゲートウェイサービスは、複数のAIモデルを統合APIを通じて集約し、DeepSeekへのアクセスを提供するだけでなく、自動フェイルオーバー、使用状況分析、プロバイダー間の課金の簡素化などのメリットも提供します。

まず、CometAPIアカウントを作成します。 https://www.cometapi.com/プロセス全体はわずか20分で完了し、メールアドレスの確認のみが必要です。ログイン後、「APIキー」セクションで新しいキーを生成します。https://www.cometapi.com/ では、新規アカウントに無料クレジットと公式API価格のXNUMX%割引を提供しています。

技術的な実装には最小限のコード変更が必要です。APIエンドポイントをDeepSeekの直接URLからCometAPIゲートウェイに変更するだけです。

注: APIはストリーミングをサポートしています(

stream: true),max_tokens、温度、停止シーケンス、および他の OpenAI 互換 API と同様の関数呼び出し機能を備えています。

Anthropic SDK を使用して DeepSeek を呼び出すにはどうすればよいでしょうか?

DeepSeekはAnthropic互換のエンドポイントを提供しているので、SDKを次の場所に指定することでAnthropc SDKまたはClaude Codeツールを再利用することができます。 https://api.deepseek.com/anthropic モデル名を deepseek-chat (または deepseek-reasoner サポートされている場合)。

Anthropic API 経由で DeepSeek モデルを呼び出す

Anthropic SDKをインストールします:pip install anthropic。環境を設定します:

export ANTHROPIC_BASE_URL=https://api.deepseek.com/anthropic

export ANTHROPIC_API_KEY=YOUR_DEEPSEEK_KEY

メッセージを作成します:

import anthropic

client = anthropic.Anthropic()

message = client.messages.create(

model="deepseek-chat",

max_tokens=1000,

system="You are a helpful assistant.",

messages=[

{

"role": "user",

"content": [

{

"type": "text",

"text": "Hi, how are you?"

}

]

}

]

)

print(message.content)

Claude CodeでDeepSeekを使用する

インストール: npm install -g @anthropic-ai/claude-code。環境設定:

export ANTHROPIC_BASE_URL=https://api.deepseek.com/anthropic

export ANTHROPIC_AUTH_TOKEN=${YOUR_API_KEY}

export ANTHROPIC_MODEL=deepseek-chat

export ANTHROPIC_SMALL_FAST_MODEL=deepseek-chat

プロジェクト ディレクトリに入り、Claude コードを実行します。

cd my-project

claude

CometAPI 経由で Claude Code で DeepSeek を使用する

CometAPIはClaude Codeをサポートしています。インストール後、環境設定時にベースURLをhttps://api.cometapi.comに、キーをCometAPIのキーに置き換えるだけで、Claude CodeでCometAPIのDeepSeekモデルを使用できます。

# Navigate to your project folder cd your-project-folder

# Set environment variables (replace sk-... with your actual token)

export ANTHROPIC_AUTH_TOKEN=sk-...

export ANTHROPIC_BASE_URL=https://www.cometapi.com/console/

# Start Claude Code

claude

注意:

- DeepSeekはサポートされていないAnthropicモデル名を

deepseek-chat. - 人類適合性レイヤーは、

system,messages,temperature、ストリーミング、停止シーケンス、思考配列。

具体的な運用のベストプラクティス (セキュリティ、コスト、信頼性) は何ですか?

以下は、DeepSeek または大量の LLM の使用に適用される推奨される制作パターンです。

秘密とアイデンティティ

- APIキーをシークレットマネージャーに保存する(

.env(本番環境では) キーを定期的にローテーションし、最小限の権限でサービスごとにキーを作成します。 - 開発/ステージング/本番環境には別々のプロジェクト/アカウントを使用します。

レート制限と再試行

- 実施する 指数関数的バックオフ ジッターのあるHTTP 429/5xxの場合、再試行回数を制限します(例:3回)。

- 繰り返される可能性のあるリクエストには、べき等性キーを使用します。

Pythonの例 - バックオフ付きの再試行

import time, random, requests

def post_with_retries(url, headers, payload, attempts=3):

for i in range(attempts):

r = requests.post(url, json=payload, headers=headers, timeout=60)

if r.status_code == 200:

return r.json()

if r.status_code in (429, 502, 503, 504):

backoff = (2 ** i) + random.random()

time.sleep(backoff)

continue

r.raise_for_status()

raise RuntimeError("Retries exhausted")

原価管理

- リミット

max_tokens誤って巨大な出力を要求してしまうのを防ぎます。 - キャッシュモデルの応答 適切な場合(特に繰り返しプロンプトが表示される場合)。DeepSeekは、キャッシュヒットとキャッシュミスを価格設定で明確に区別します。キャッシュはコスト削減につながります。

deepseek-chat日常的な小さな返信用。deepseek-reasoner本当に CoT が必要な場合(より高価)

可観測性とログ記録

- リクエストに関するメタデータ(プロンプトハッシュ、トークン数、レイテンシ)のみをプレーンテキストで記録します。ユーザーデータ全体や機密コンテンツの記録は避けてください。サポートと請求の調整のために、リクエスト/レスポンスIDを保存します。

- リクエストごとのトークンの使用状況を追跡し、コストに関する予算/アラートを公開します。

安全性と幻覚のコントロール

- ツールの出力と決定論的検証 安全性が極めて重要なもの(金融、法律、医療)に。

- 構造化された出力には、

response_format+JSON スキーマを使用して、取り返しのつかないアクションを実行する前に出力を検証します。

展開パターン

- 専用のワーカー プロセスからモデル呼び出しを実行して、同時実行性とキューを制御します。

- 負荷の高いジョブを非同期ワーカー (Celery、Fargate タスク、Cloud Run ジョブ) にオフロードし、進行状況インジケーターを使用してユーザーに応答します。

- 極端なレイテンシ/スループットのニーズについては、プロバイダーの SLA を考慮し、セルフホストするかプロバイダー アクセラレータを使用するかを検討してください。

最後に

DeepSeek-V3.1は、高速チャットと複雑なエージェントタスクの両方に対応するよう設計された実用的なハイブリッドモデルです。OpenAI互換のAPI構成により、多くのプロジェクトで容易に移行できます。また、AnthropicおよびCometAPI互換レイヤーにより、既存のエコシステムにも柔軟に対応できます。ベンチマークとコミュニティレポートでは、コストとパフォーマンスのトレードオフが良好であることが示されていますが、他の新しいモデルと同様に、本格的な運用開始前に、実際のワークロード(プロンプト、関数呼び出し、安全性チェック、レイテンシ)で検証することをお勧めします。

CometAPIでは、OpenAI互換APIまたはユーザーフレンドリーなAPIを通じて安全に実行し、操作することができます。 遊び場レート制限はありません。

👉 今すぐCometAPIにDeepSeek-V3.1をデプロイしましょう!

CometAPI を使用する理由は何ですか?

- プロバイダーの多重化: コードを書き換えずにプロバイダーを切り替えます。

- 統合課金/指標: CometAPI を介して複数のモデルをルーティングすると、単一の統合サーフェスが得られます。

- モデルメタデータ: モデルバリアントごとのコンテキストの長さとアクティブなパラメータを表示します。