Google は 2025年12月17〜18日に、Gemini 3 ファミリーの低レイテンシかつコスト効率に優れたメンバーとして Gemini 3 Flash を発表しました。これは、Flash クラスのフットプリントで Pro 級の推論を提供し、広範なマルチモーダル入力(テキスト、画像、音声、動画)をサポートし、thinking_level とメディア解像度のコントロールを導入、Google AI Studio、Gemini API(REST / SDKs)、Vertex AI、Gemini CLI、そして Google Search / Gemini app のデフォルトモデルとして利用可能です。

Gemini 3 Flash とは何か、なぜ重要か

Gemini 3 Flash は Google の 3 シリーズモデルの一部です。品質・コスト・レイテンシのパレート・フロンティアを押し広げるよう設計されており、Gemini 3 Pro の多くの推論能力を提供しつつ、実行は大幅に高速かつ低コストです。この組み合わせにより、高頻度のインタラクティブなシナリオ(チャットボット、IDE アシスタント、リアルタイムのエージェントフロー)、レイテンシが重要な大量コンテンツ生成、低オーバーヘッドでマルチモーダル推論(画像+テキスト+音声)を必要とするアプリケーションに適しています。

主なポイント:

- 速度+低コストに明示的に最適化しつつ、強力な推論とマルチモーダルの忠実性を維持(旧 Gemini 2.5 Pro の3倍の速さ;Gemini 3 の最上位推論能力を保持)。

- エージェントループや反復的な開発ワークフロー(例:コード支援、マルチターンエージェント)の「スイートスポット」として位置づけられています。

- 柔軟: 課題の複雑さに応じて「思考時間」を調整でき、簡単な質問には即答し、複雑なタスクにはより多くのステップを検討します。

技術的性能とベンチマーク結果

Gemini 3 Flash は速度・知能・コストの3点でブレークスルーを達成しています。

1) エージェントループとマルチモーダル理解

Gemini 3 Flash は Gemini 3 ファミリー全体のアーキテクチャと学習の改良を継承しており、強力なマルチモーダル能力(テキスト、画像、動画、音声入力)と、従来の Flash モデルと比較して向上した推論を実現します。Google は、ドキュメント解析(OCR+推論)、動画要約、画像+テキストの Q&A、マルチモーダルなコーディングタスクなどを処理できると位置づけています。低レイテンシと組み合わさったこのマルチモーダル能力は、本モデルの技術的なセールスポイントのひとつです。

Google は内部ベンチマークの主張を公開しており、エージェント的なコーディング性能の高さ(SWE-bench Verified ~78%)や、Flash が多くのタスクで Pro 級の推論に迫りつつ、エージェントループや準リアルタイムのワークフローに十分な速さを維持していることを強調しています。

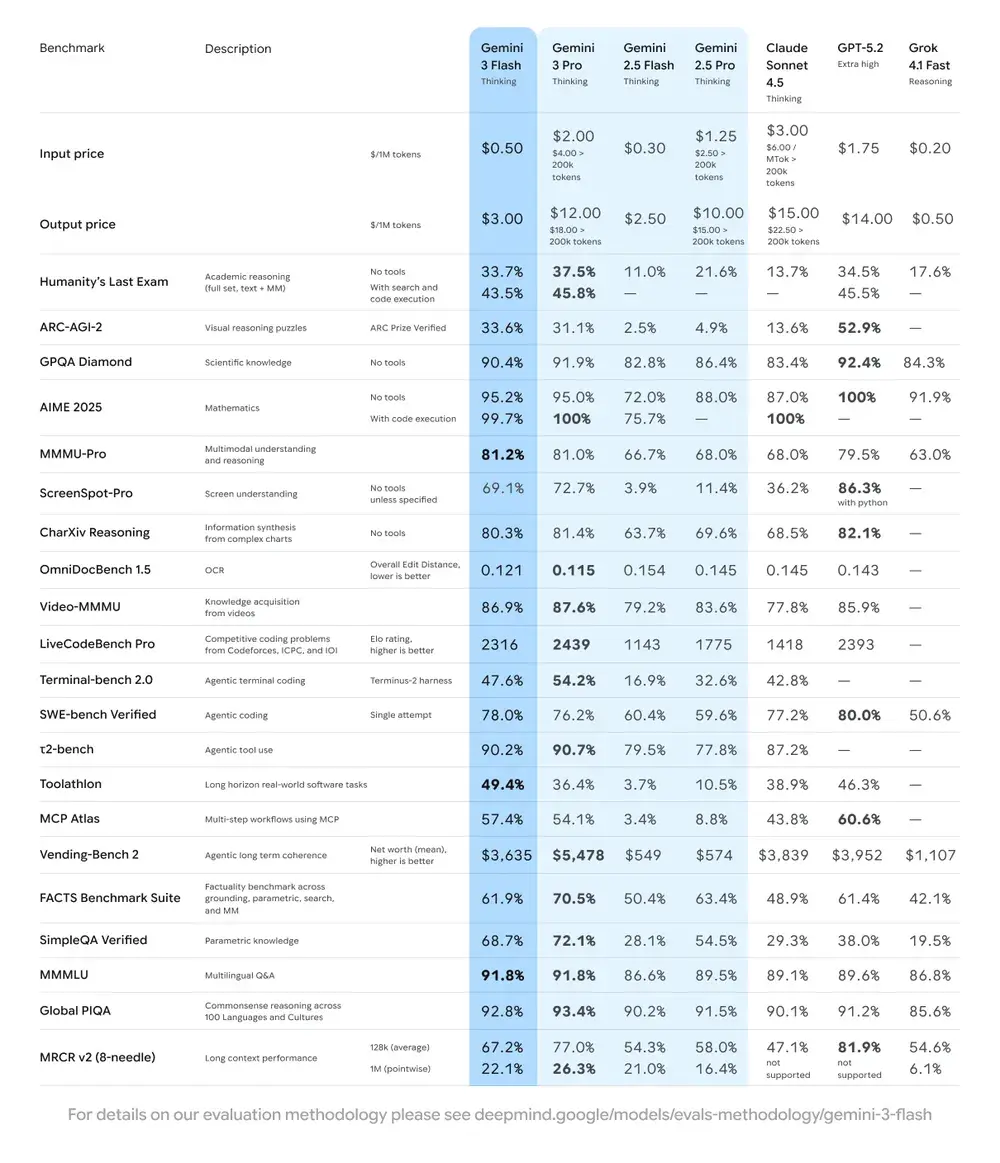

| ベンチマーク | Gemini 3 Flash スコア | 比較モデル | 改善度 |

|---|---|---|---|

| GPQA Diamond(博士レベルの推論) | 90.4% | Gemini 2.5 Pro を上回る | 大幅 |

| Humanity’s Last Exam(一般知識テスト) | 33.7%(ツールなし) | Gemini 3 Pro に近い | 高度な推論 |

| MMMU Pro(マルチモーダル理解) | 81.2% | Gemini 3 Pro と同等 | — |

| SWE-bench Verified(コーディング能力ベンチマーク) | 78% | Gemini 3 Pro と 2.5 系列より高い | 優れた |

2) コストと効率

Gemini 3 Flash の開発思想は「パレート・フロンティア」、すなわち速度・品質・コストの最適なバランスを追求することです。Gemini 3 Flash は価格性能に明示的に最適化されています。Google は、同等タスクにおける Flash の価格を Pro より大幅に低く掲示しており、より低い運用コストで大量のリクエストを処理できるように位置づけています。多くのワークロードで、Flash はコスト効率の高いデフォルトを意図しており、例えば Flash preview の料金は、入力トークン 100万あたり約 $0.50、出力トークン 100万あたり $3.00(Flash preview tier)です。実運用では、Pro のトークン単価がネックになる高頻度タスクでも実用的になります。

効率性の指標

- 速度: Gemini 2.5 Pro の3倍の速度(Artificial Analysis のテストに基づく)。

- トークン効率: 同じタスクを完了するのに平均 30% 少ないトークンを使用。つまり、同じ費用でより速く、より良い結果が得られます。

- Gemini 3 Flash には「Dynamic Thinking Mode」を搭載—タスクの複雑さに応じて推論の深さを適応させ、必要なときは「少し長く考え」、簡単なタスクには迅速に応答します。

実務上の示唆: コールあたり・トークンあたりの単価が下がると、同じ予算でより多くのクエリ、長いコンテキスト、あるいは高いサンプリング率を実行できます。効率向上によりインフラの複雑さ(ホットインスタンスの削減)も下げ、応答時間の保証を改善できます。

3) パフォーマンスベンチマーク

Gemini 3 Flash は複数の学術・実用ベンチマークで「フロンティア級」の性能を示しつつ、従来の Pro モデルよりも良好なレイテンシとコストを提供します。Google は、複雑な推論や知識系ベンチマーク(例:GPQA 系)での高スコアなどを提示して、その能力を示しています。

Gemini 3 Flash API の使い方

どのアクセス方法を使うべきか

- 推奨(シンプル+堅牢): Comet が示す SDK 統合パターンを使用—既存の GenAI SDK を Comet のベース URL に向け、Comet の API キーを指定するだけです。これにより、リクエスト/ストリームのパースを自前で再実装する必要がなくなります。

- 代替(生の HTTP / curl / カスタムスタック): CometAPI のエンドポイントに直接 POST できます(Comet は OpenAI 互換またはプロバイダ固有の形状を受理)。

Authorization: Bearer <sk-...>を使用し、ボディのモデル文字列はgemini-3-flash。利用したいモデルの正確なパスやクエリパラメータは Comet の API ドキュメントで確認してください。

クイックサマリー — 行うこと

- CometAPI にサインアップして API トークンを作成。

- アクセス方法を選択(推奨:下の SDK ラッパーパターン;予備:生 HTTP/cURL)。

- CometAPI のベース URL 経由で

gemini-3-flashモデルを呼び出す(Comet がリクエストを Google の Gemini バックエンドへルーティング)。 - モデル要件に従って streaming / function-calls / マルチモーダル入力を処理(詳細は後述)。

以下は(CometAPI のサンプルパターンに基づく)CometAPI 経由で gemini-3-flash を呼び出す簡潔な例です。<YOUR_COMETAPI_KEY> を実際のキーに置き換えてください。モデル ID とエンドポイントは CometAPI のドキュメントに一致しています。

from google import genaiimport os# Get your CometAPI key from https://api.cometapi.com/console/token, and paste it hereCOMETAPI_KEY = os.environ.get("COMETAPI_KEY") or "<YOUR_COMETAPI_KEY>"BASE_URL = "https://api.cometapi.com"client = genai.Client( http_options={"api_version": "v1beta", "base_url": BASE_URL}, api_key=COMETAPI_KEY,)response = client.models.generate_content( model="gemini-3-flash", contents="Explain how AI works in a few words",)print(response.text)

検討すべき主要なリクエストパラメータ

thinking_level— 内部の推論深度を制御:MINIMAL、LOW、MEDIUM、HIGH。深い多段推論が不要な場合は最低レイテンシとコストのためにMINIMALを使用。media_resolution— ビジョン/動画入力向け:low、medium、high、ultra_high。低解像度はトークン換算とレイテンシを抑えます。streamGenerateContentとgenerateContent— 部分応答を逐次受け取りたい場合はストリーミングで体感レイテンシを改善。- Function calling / JSON Mode — 機械可読な出力が必要な場合は構造化レスポンスを使用。

マルチモーダル入力の送信(実践的なヒント)

- Images/PDFs: 大きなメディアには Cloud Storage の URI(gs://)を推奨。小さな画像は多くの API が base64 を受理します。モダリティごとのトークン計上に注意—PDF はエンドポイントによっては画像/ドキュメント枠でカウントされる場合があります。

- Video/audio: 短いクリップは URI を渡せます。長尺メディアはバッチ処理ワークフローかチャンク配信を使用。最大入力サイズとエンコーディング制約は API ドキュメントで確認。

- Function calling / tools: 構造化された関数スキーマを用いて JSON 出力を取得し、安全なツール呼び出しを可能にします。Gemini 3 Flash はストリーミングの function calling をサポートし UX を改善します。

Gemini 3 Flash をどこで利用できるか

Gemini 3 Flash は Google のコンシューマ向けおよび開発者向けの各種サーフェスで利用可能です。

- Google Search と Gemini app — Search の AI Mode のデフォルトモデルとしてロールアウトされ、エンドユーザー向けの Gemini app に統合されています。

- Google AI Studio — 開発者がすぐに試し、テスト用の API キーを発行できる場。

- Gemini API(Generative Language / AI Developer API) —

gemini-3-flash-preview(ドキュメント/リリースノートのモデル ID)として、標準の generateContent / streamGenerateContent エンドポイント経由で利用可能。 - Vertex AI(Google Cloud) — エンタープライズ向けの本番運用に適したアクセス、価格/クオータ。

- Gemini CLI — 端末ベースの開発やスクリプトワークフロー向け。

サードパーティゲートウェイ CometAPI

CometAPI はすでに gemini-3-flash をカタログに追加しており、モデルページで CometAPI の統一エンドポイントからの呼び出し方法を説明しています。提供されるモデル API は公式価格の 20% の価格で提供されています。

Gemini 3 Flash を使う際のベストプラクティス

1) タスクごとに thinking_level を選び調整

- 単純な Q&A や高頻度のインタラクティブタスクには

MINIMAL/LOWを設定。 - 多段の計画やより深い思考過程が必要なタスクには

MEDIUM/HIGHを選択的に使用。 thinking_levelを変更する際はコストと品質のベンチマークを実施。Google のドキュメントでは、thinking_levelが内部の思考シグネチャとレイテンシを変化させると注意喚起しています。

2) media_resolution でビジョンの計算量を制御

画像や動画を渡す場合は、タスクで許容可能な最小の media_resolution を選びます。例えば、サムネイルや大量抽出には low、ビジュアルデザインの講評には high を使用。これにより画像のトークン換算を抑え、レイテンシも低下します。

3) 自動化には構造化出力を優先

機械可読な出力が必要な場合(例:エンティティ抽出、ツール呼び出し)は JSON Mode / function calling を使用。これにより下流処理が大幅に簡素化されます。可能な限り厳密な JSON スキーマを強制し、クライアント側でバリデーションしてください。

4) 長い応答には積極的にストリーミングを活用

streamGenerateContent は体感レイテンシを下げ、UI の段階的レンダリングを可能にします。長いマルチモーダルタスクでは部分出力をストリームして、ユーザーに即時の進捗を見せましょう。

5) キャッシュとコンテキスト管理でコストを抑制

- 参照が繰り返される場合はコンテキストキャッシュを使用(価格とトークン計上はモデルごとに異なります)。

- 不要に長いコンテキストは送らない—簡潔なプロンプトを心がけ、大規模なナレッジには retrieval + grounding を使用。

Gemini 3 Flash の典型的なユースケース

大量トラフィックの会話型エージェント

Flash は、低レイテンシかつ推論あたりの低コストが求められるチャットボットやカスタマーサポートアシスタントに最適です。ストリーミング対応と高い tokens/sec により、体感の待ち時間と運用コストを削減します。

マルチモーダルアシスタントとドキュメントパイプライン

Flash は画像、PDF、短い動画の処理に長けているため、請求書抽出、マニュアルに対するマルチモーダル Q&A、画像付きのカスタマーサポート、ナレッジベース向け PDF 取り込みなどが一般的な用途です。

リアルタイム動画解析とモデレーション

事前テストで報告された高い出力速度(≈218 t/s)により、短い動画のほぼリアルタイムな分析と要約、ハイライト検出、適切に設計されたライブコンテンツのモデレーションパイプラインが可能になります。

エージェント的な開発ツールとコーディング支援

SWE-bench スコアと報告されているコーディング性能により、Flash は低レイテンシを重視する高速なコーディングアシスタント、CLI ヘルパー、その他の開発ワークフローに適した選択肢です。

結論 — 今すぐ Gemini 3 Flash を採用すべきか

Gemini 3 Flash は、トップエンドの Pro モデルのレイテンシやコストなしで、強力な推論とマルチモーダル知性を必要とするチームにとって戦略的な選択肢です。特に、エージェント的なコーディングアシスタント、インタラクティブなマルチモーダルエージェント、ドキュメント処理パイプライン、そして低レイテンシとスケールが最優先のあらゆるシステムに適しています。初期ベンチマーク(Google と独立系の分析の双方)では、Flash は品質面で競争力がありつつ、スループットとコストで大きな優位性を示しています。

始めるには、Gemini 3 Flash の機能を Playground で試し、詳細な手順は API ガイド を参照してください。アクセス前に、CometAPI にログインして API キーを取得していることを確認してください。CometAPI は公式より大幅に低い価格を提供し、統合を支援します。

Ready to Go?→ Free trial of Gemini 3 Flash !