GPT-5.2 API とは

GPT-5.2 API は ChatGPT における GPT-5.2 Thinking と同じです。GPT-5.2 Thinking は OpenAI の GPT-5.2 ファミリーの中位グレードのバリアントで、より深い作業に向けて設計されています:多段階推論、長文の要約、高品質なコード生成、そして正確性と実用的な構造が生のスループットよりも重要となるプロフェッショナルな知的作業。API ではモデル gpt-5.2(Responses API / Chat Completions)として公開され、低レイテンシの Instant バリアントと、より高品質だが高価な Pro バリアントの中間に位置します。

主な機能

- 非常に長いコンテキストと圧縮: 有効ウィンドウ 400K、長い会話や文書にまたがる関連性を管理するための圧縮ツール。

- 推論負荷の設定:

none | medium | high | xhigh(xhigh は困難な推論に最大の内部計算を有効化)。xhighは Thinking/Pro バリアントで利用可能。 - より強力なツール/関数サポート: 一級のツール呼び出し、構造化出力を制約する文法(CFG/Lark)、複雑な多段自動化を簡素化するエージェント的挙動の改善。

- マルチモーダル理解: 画像+テキストのより豊かな理解と多段タスクへの統合。

- 安全性の向上/センシティブなコンテンツの取り扱い: 自傷などのセンシティブな領域で望ましくない応答を減らすための的確な介入。

技術的能力と仕様(開発者向け)

- API エンドポイントとモデル ID: Thinking 用は

gpt-5.2(Responses API)、チャット/インスタントのワークフロー用はgpt-5.2-chat-latest、Pro ティア用はgpt-5.2-pro;該当箇所で Responses API および Chat Completions から利用可能。 - 推論トークンと負荷管理: API はリクエストごとに計算資源(推論負荷)を割り当てる明示的パラメータをサポート;負荷を高くするとレイテンシとコストは増加しますが、複雑なタスクにおける出力品質が向上します。

- 構造化出力ツール: 文法(Lark / CFG)に対応し、モデル出力を DSL や厳密な構文へ制約可能(SQL、JSON、DSL 生成に有用)。

- 並列ツール呼び出しとエージェント協調: 並列性の改善と洗練されたツールオーケストレーションにより、複雑なシステムプロンプトや多エージェントの足場の必要性を低減。

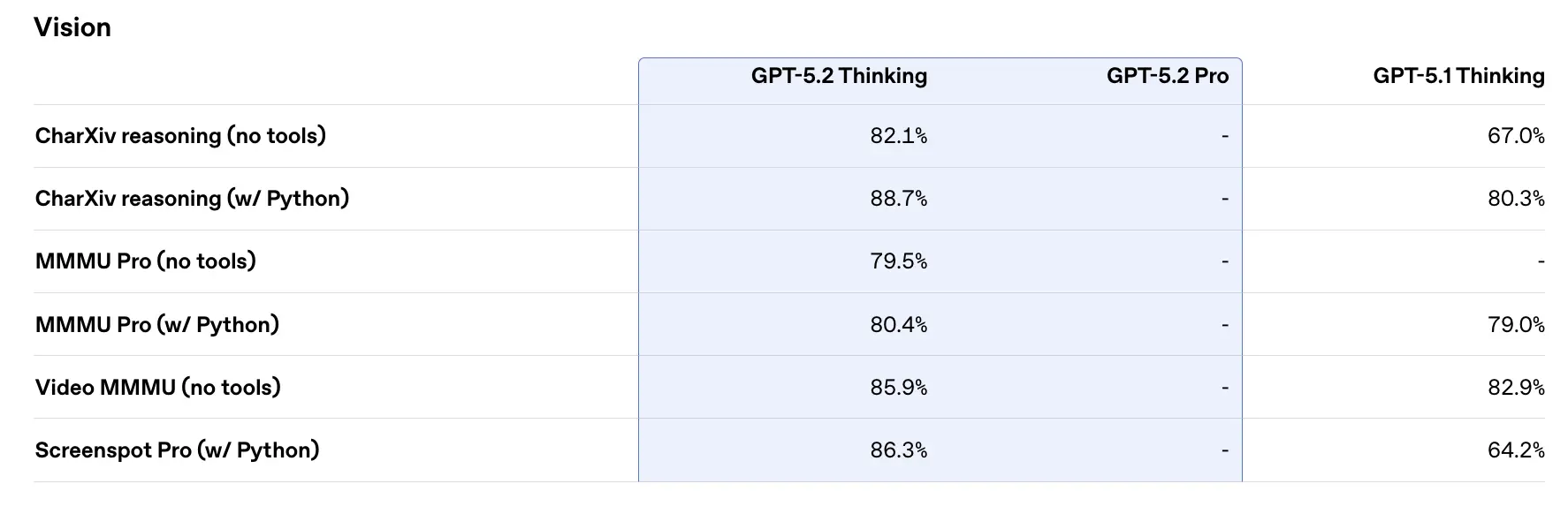

ベンチマーク性能と支援データ

OpenAI は GPT-5.2 に関する多様な内部/外部ベンチマーク結果を公開しています。抜粋(OpenAI の報告値):

- GDPval(44 職種、知的作業) — GPT-5.2 Thinking は比較の 70.9% において「トップ業界プロフェッショナルに勝利または同等」。OpenAI によれば、GDPval タスクでの出力は**>11× の速度**、<1% のコスト(速度とコストの推定は過去データに基づく)で達成。これらのタスクにはスプレッドシートモデル、プレゼンテーション、短い動画が含まれます。

- SWE-Bench Pro(コーディング) — GPT-5.2 Thinking は SWE-Bench Pro で**≈55.6%、SWE-Bench Verified(Python のみ)で~80%**を達成したと OpenAI は報告しており、同社の評価ではコード生成/エンジニアリングにおける SOTA を更新。これにより、実務ではより信頼できるデバッグとエンドツーエンドの修正が可能になると OpenAI は例示しています。

- GPQA Diamond(大学院レベルの科学 Q&A) — GPT-5.2 Pro: 93.2%、GPT-5.2 Thinking: 92.4%(ツールなし、最大推論)。

- ARC-AGI シリーズ — ARC-AGI-2(より難度の高い流動的推論ベンチマーク)では、GPT-5.2 Thinking が52.9%、GPT-5.2 Pro が54.2%(OpenAI によれば、これらは chain-of-thought スタイルのモデルにおける SOTA)。

- 長コンテキスト(OpenAI MRCRv2) — GPT-5.2 Thinking は 4-needle MRCR 変種で 256k トークンまでほぼ 100% の精度を示し、長コンテキスト設定で GPT-5.1 を大幅に上回るスコア。(OpenAI は MRCRv2 のチャートと表を公開。)

同時代モデルとの比較

- vs Google Gemini 3(Gemini 3 Pro / Deep Think): Gemini 3 Pro は~1,048,576(≈1M)トークンのコンテキストウィンドウ、広範なマルチモーダル入力(テキスト、画像、音声、動画、PDF)、Vertex AI / AI Studio を介した強力なエージェント統合が公表されています。理論上、Gemini 3 のより大きなコンテキストウィンドウは非常に大規模な単一セッションのワークロードにおける差別化要因です;トレードオフにはツール面やエコシステム適合性が含まれます。

- vs Anthropic Claude Opus 4.5: Anthropic の Opus 4.5 はエンタープライズ向けのコーディング/エージェントワークフローを重視し、強力な SWE-bench 結果と長いエージェントセッションでの堅牢性を報告。Anthropic は Opus を 200k のコンテキストウィンドウと専用のエージェント/Excel 統合で、オートメーションとコード生成向けに位置付けています。Opus 4.5 はエンタープライズの自動化とコードタスクで強力な競合です。

実用的な要点: GPT-5.2 は(400k コンテキスト、高トークン出力、推論/コーディングの改善)というバランスの取れた一連の進化を狙っています。Gemini 3 は絶対的に最大の単一セッション・コンテキスト(≈1M)をターゲットにし、Claude Opus はエンタープライズエンジニアリングとエージェント的堅牢性に焦点を当てます。コンテキストサイズ、モダリティのニーズ、機能/ツール適合性、コスト/レイテンシのトレードオフを照合して選択してください。

GPT-5.2 API の利用方法

Step 1: API キーの取得

cometapi.com にログインします。まだユーザーでない場合は、まず登録してください。CometAPI console にサインインし、インターフェースのアクセス認証 API キーを取得します。パーソナルセンターの API トークンで「Add Token」をクリックし、トークンキー: sk-xxxxx を取得して送信します。

Step 2: GPT-5.2 API にリクエストを送信

「gpt-5.2」エンドポイントを選択して API リクエストを送信し、リクエストボディを設定します。リクエストメソッドとリクエストボディは当社サイトの API ドキュメントから取得できます。当社サイトは利便性のため Apifox テストも提供しています。<YOUR_API_KEY> をアカウントの実際の CometAPI キーに置き換えてください。開発者はこれらを Responses API / Chat エンドポイント経由で呼び出します。

質問やリクエストを content フィールドに挿入します—これに対してモデルが応答します。API レスポンスを処理して生成された回答を取得します。

Step 3: 結果の取得と検証

API レスポンスを処理して生成された回答を取得します。処理後、API はタスクのステータスと出力データを返します。