アリババの最新の人工知能の進歩は、 Qwen3-Coderは、急速に進化する AI 駆動型ソフトウェア開発の分野における重要なマイルストーンとなります。23 年 2025 月 3 日に発表された Qwen480-Coder は、オープンソースのエージェント コーディング モデルであり、定型コードの生成からコードベース全体のデバッグまで、複雑なプログラミング タスクに自律的に取り組むように設計されています。最先端の専門家混合 (MoE) アーキテクチャに基づいて構築され、トークンごとに 35 億がアクティブ化された 3 億のパラメーターを誇るこのモデルは、パフォーマンスと計算効率の最適なバランスを実現します。この記事では、QwenXNUMX-Coder の特徴を探り、ベンチマーク パフォーマンスを検証し、技術革新を解き明かし、開発者に最適な使用方法を案内し、モデルの受容と将来の展望について考察します。

Qwen3‑Coder とは何ですか?

Qwen3-Coderは、22年2025月3日に正式発表されたQwenファミリーの最新のエージェント型コーディングモデルです。「これまでで最もエージェント型コードモデル」として設計されたフラッグシップモデルであるQwen480-Coder-35B-A480B-Instructは、合計35億個のパラメータを備え、Mixture-of-Experts(MoE)設計によりトークンあたり256億個のパラメータをアクティブ化します。最大XNUMXトークンのコンテキストウィンドウをネイティブにサポートし、外挿技術によりXNUMX万トークンまで拡張可能で、リポジトリ規模のコード理解と生成のニーズに対応します。

Apache 2.0 に基づくオープンソース

Alibabaのコミュニティ主導型開発へのコミットメントに基づき、Qwen3-CoderはApache 2.0ライセンスの下でリリースされています。このオープンソースの利用により、透明性が確保され、サードパーティによる貢献が促進され、学術界と産業界の両方における導入が加速します。研究者やエンジニアは、事前学習済みの重みにアクセスし、フィンテックから科学計算まで、特定の分野向けにモデルを微調整することができます。

Qwen2.5からの進化

2.5億から0.5億のパラメータを持つモデルを提供し、コード生成ベンチマーク全体でSOTA結果を達成したQwen32-Coderの成功を基に、Qwen3-Coderは、より大規模で強化されたデータパイプラインと革新的なトレーニング体制を通じて、前身の機能を拡張しています。Qwen2.5-Coderは、綿密なデータクリーニングと合成データ生成により、5.5兆トークン以上でトレーニングされました。Qwen3-Coderは、7.5%のコード比率で70兆トークンを取り込み、以前のモデルを活用してノイズの多い入力をフィルタリングおよび書き換えることで、優れたデータ品質を実現します。

Qwen3-Coder を差別化する主な革新は何ですか?

Qwen3-Coder が他と一線を画すのは、いくつかの重要な革新によるものです。

- エージェントタスクオーケストレーションQwen3-Coder は、スニペットを生成するだけでなく、ドキュメントの読み取り、ユーティリティの呼び出し、出力の検証など、複数の操作を人間の介入なしに自律的に連結できます。

- 強化された思考予算開発者は推論の各ステップにどれだけの計算を割り当てるかを設定できるため、大規模なコード合成にとって極めて重要な速度と徹底性の間のトレードオフをカスタマイズできます。

- シームレスなツール統合Qwen3-Coder のコマンドライン インターフェイス「Qwen Code」は、関数呼び出しプロトコルとカスタマイズされたプロンプトを採用して一般的な開発者ツールと統合し、既存の CI/CD パイプラインや IDE に簡単に組み込むことができます。

Qwen3‑Coder のパフォーマンスは競合他社と比べてどうですか?

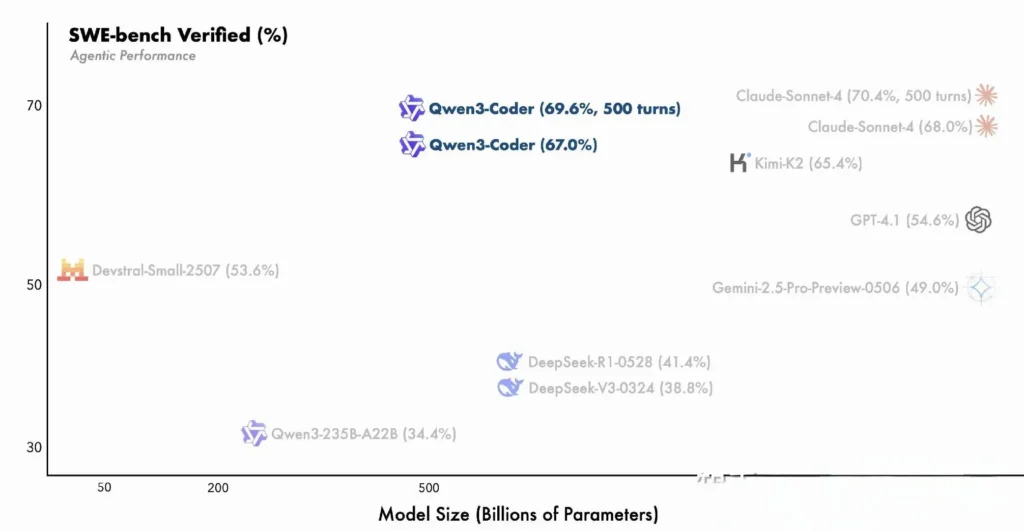

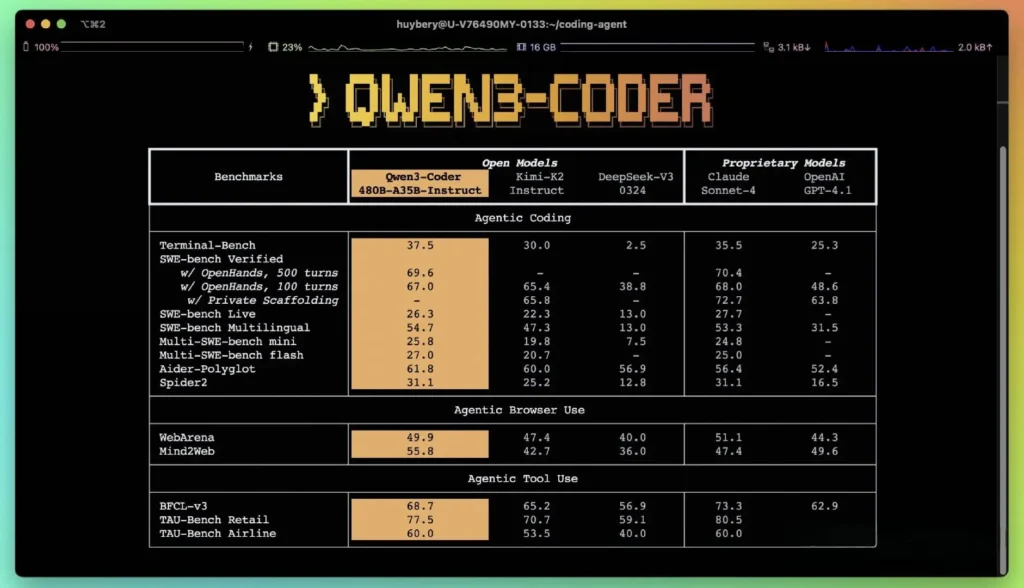

ベンチマーク対決

Alibabaが公開したパフォーマンス指標によると、Qwen3-Coderは、DeepSeekのコーデックススタイルモデルやMoonshot AIのK2といった国内有数の代替品を凌駕し、複数のベンチマークにおいて米国のトップクラスのコーディング能力に匹敵、あるいは上回っています。第三者による評価では、以下の点が評価されています。

- アイダー・ポリグロット: Qwen3-Coder-480Bはスコアを達成しました **61.8%**強力な多言語コード生成と推論を示します。

- MBPPとHumanEval: 独立したテストでは、Qwen3-Coder-480B-A35B は、特にマルチステップのコーディング チャレンジにおいて、機能の正確性と複雑なプロンプトの処理の両方で GPT-4.1 よりも優れていることが報告されています。

- 480Bパラメータバリアントは、85%以上の実行成功率を達成しました。 SWEベンチ 検証済みスイート - DeepSeek のトップモデル (78%) と Moonshot の K2 (82%) の両方を上回り、Claude Sonnet 4 の 86% にほぼ匹敵します。

独自モデルとの比較

Alibabaは、Qwen3-Coderのエージェント機能は、エンドツーエンドのコーディングワークフローにおいて、AnthropicのClaudeやOpenAIのGPT-4と同等であると主張しており、これはオープンソースモデルとしては驚くべき成果です。初期テスターは、マルチターンプランニング、動的なツール呼び出し、自動エラー修正により、フルスタックWebアプリケーションの構築やCI/CDパイプラインの統合といった複雑なタスクを、最小限の人間による指示で処理できると報告しています。これらの機能は、コード実行を通じて自己検証するモデルの能力によって強化されており、これは純粋に生成的なLLMではあまり顕著ではありません。

Qwen3-Coder の背後にある技術革新とは何ですか?

専門家混合(MoE)アーキテクチャ

Qwen3-Coderの中核を成すのは、最先端のMoE設計です。すべてのトークンに対してすべてのパラメータをアクティブ化する密モデルとは異なり、MoEアーキテクチャは、特定のトークンタイプまたはタスクに合わせて調整された特化したサブネットワーク(エキスパート)を選択的に使用します。Qwen3-Coderでは、合計480億個のパラメータが複数のエキスパートに分散され、トークンごとにアクティブなパラメータは35億個のみです。このアプローチにより、同等の密モデルと比較して推論コストを60%以上削減しながら、コード合成とデバッグにおける高い忠実度を維持できます。

思考モードと非思考モード

Qwen3ファミリーの幅広いイノベーションを借用したQwen3-Coderは、 デュアルモード推論 フレームワーク:

- 思考モード アルゴリズム設計やファイル間のリファクタリングなどの複雑な複数ステップの推論タスクに、より大きな「思考予算」を割り当てます。

- 非思考モード シンプルなコード補完や API 使用スニペットに適した、迅速でコンテキスト主導の応答を提供します。

この統合モード切り替えにより、チャットに最適化されたタスクと推論に最適化されたタスクで別々のモデルを操作する必要がなくなり、開発者のワークフローが合理化されます。

自動テストケース合成による強化学習

Qwen3-Coderの際立った革新性は、ネイティブの256Kトークンコンテキストウィンドウ(主要なオープンモデルの標準的な容量のXNUMX倍)と、外挿法(YaRNなど)による最大XNUMX万トークンのサポートです。これにより、モデルはリポジトリ全体、ドキュメントセット、または複数ファイルのプロジェクトをXNUMX回のパスで処理でき、ファイル間の依存関係を維持し、繰り返しのプロンプトを削減できます。実証テストでは、コンテキストウィンドウの拡張により、特に環境駆動型強化学習シナリオにおいて、長期的なタスクパフォーマンスにおいて、効果は減少するものの、依然として有意な向上が見られることが示されています。

開発者はどのようにして Qwen3-Coder にアクセスして使用できますか?

Qwen3-Coder のリリース戦略では、オープン性と導入の容易さを重視しています。

- オープンソースモデルの重みすべてのモデル チェックポイントは Apache 2.0 の下で GitHub で利用可能であり、完全な透明性とコミュニティ主導の機能強化が可能になります。

- コマンドラインインターフェース(Qwenコード): Google Gemini Code からフォークされた CLI は、カスタマイズされたプロンプト、関数呼び出し、プラグイン アーキテクチャをサポートし、既存のビルド システムや IDE とシームレスに統合します。

- クラウドとオンプレミスの展開: 事前構成された Docker イメージと Kubernetes Helm チャートにより、クラウド環境でのスケーラブルなデプロイメントが容易になり、ローカル量子化レシピ (2~8 ビットの動的量子化) により、コモディティ GPU でも効率的なオンプレミス推論が可能になります。

- CometAPI経由のAPIアクセス: 開発者は、次のようなプラットフォーム上のホストされたエンドポイントを通じてQwen3-Coderと対話することもできます。 コメットAPIオープンソースを提供する(

qwen3-coder-480b-a35b-instruct) および商用バージョン(qwen3-coder-plus; qwen3-coder-plus-2025-07-22)も同じ価格です。業務用は長さ1Mです。 - ハグ顔Alibaba は、Qwen3-Coder のウェイトと付属のライブラリを、ロイヤルティなしで学術的および商業的に使用できる Apache 2.0 ライセンスの下でパッケージ化し、Hugging Face と GitHub の両方で無料で利用できるようにしました。

CometAPI による API と SDK の統合

CometAPIは、OpenAIのGPTシリーズ、GoogleのGemini、AnthropicのClaude、Midjourney、Sunoなど、主要プロバイダーの500以上のAIモデルを、開発者にとって使いやすい単一のインターフェースに統合する統合APIプラットフォームです。一貫した認証、リクエストフォーマット、レスポンス処理を提供することで、CometAPIはAI機能をアプリケーションに統合することを劇的に簡素化します。チャットボット、画像ジェネレーター、音楽作曲ツール、データドリブン分析パイプラインなど、どのようなアプリケーションを構築する場合でも、CometAPIを利用することで、反復処理を高速化し、コストを抑え、ベンダーに依存しない環境を実現できます。同時に、AIエコシステム全体の最新のブレークスルーを活用できます。

開発者は Qwen3-Coder CometAPI 経由で利用可能な互換性のある OpenAI スタイルの API を通じて。 コメットAPIオープンソースを提供する(qwen3-coder-480b-a35b-instruct) および商用バージョン(qwen3-coder-plus; qwen3-coder-plus-2025-07-22)は同価格で提供されています。商用版は1MBです。Pythonのサンプルコード(OpenAI互換クライアントを使用)は、ベストプラクティスに基づき、サンプリング設定として temperature = 0.7、top_p = 0.8、top_k = 20、repetition_penalty = 1.05 を推奨しています。出力長は最大65,536トークンまで拡張できるため、大規模なコード生成タスクに適しています。

まず、モデルの機能を調べてみましょう。 プレイグラウンド そして相談する APIガイド 詳細な手順についてはこちらをご覧ください。アクセスする前に、CometAPIにログインし、APIキーを取得していることを確認してください。

Hugging FaceとAlibaba Cloudのクイックスタート

Qwen3-Coderを試してみたい開発者は、リポジトリのHugging Faceでモデルを見つけることができます。 Qwen/Qwen3‑Coder‑480B‑A35B‑Instruct統合は、 transformers ライブラリ(バージョン4.51.0以上) KeyError: 'qwen3_moe') と OpenAI 互換の Python クライアント。最小限の例:

from transformers import AutoModelForCausalLM, AutoTokenizer

model = AutoModelForCausalLM.from_pretrained("Qwen/Qwen3-480B-A35B-Instruct")

tokenizer = AutoTokenizer.from_pretrained("Qwen/Qwen3-480B-A35B-Instruct")

input_ids = tokenizer("def fibonacci(n):", return_tensors="pt").input_ids

output = model.generate(input_ids, max_length=200, temperature=0.7, top_p=0.8, top_k=20, repetition_penalty=1.05)

print(tokenizer.decode(output))

カスタムツールとエージェントワークフローの定義

Qwen3-Coderの優れた機能の一つは 動的ツール呼び出し開発者は外部ユーティリティ(リンター、フォーマッタ、テストランナーなど)を登録し、コーディングセッション中にモデルがそれらを自律的に呼び出すようにすることができます。この機能により、Qwen3-Coderは受動的なコードアシスタントから能動的なコーディングエージェントへと進化し、テストの実行、コードスタイルの調整、さらには会話インテントに基づいたマイクロサービスのデプロイまでが可能になります。

Qwen3-Coder によってどのような潜在的なアプリケーションと将来の方向性が可能になりますか?

Qwen3-Coderは、オープンソースの自由度とエンタープライズグレードのパフォーマンスを組み合わせることで、新世代のAI駆動型開発ツールへの道を切り開きます。自動コード監査やセキュリティコンプライアンスチェックから、継続的なリファクタリングサービス、AIを活用したDevOpsアシスタントまで、このモデルの汎用性は既にスタートアップ企業や社内イノベーションチームに刺激を与えています。

ソフトウェア開発ワークフロー

早期導入企業からは、定型的なコーディング、依存関係管理、初期スキャフォールディングにかかる時間が30~50%削減されたという報告があり、エンジニアは価値の高い設計やアーキテクチャのタスクに集中できるようになりました。継続的インテグレーションスイートでは、Qwen3-Coderを活用してテストの自動生成、リグレッションの検出、さらにはリアルタイムのコード分析に基づくパフォーマンス最適化の提案まで行うことができます。

エンタープライズプレイ

金融、ヘルスケア、eコマースなどの企業がQwen3-Coderをミッションクリティカルなシステムに統合するにつれ、ユーザーチームとAlibabaの研究開発部門間のフィードバックループにより、ドメイン固有のチューニング、セキュリティプロトコルの強化、IDEプラグインの強化といった改良が加速されます。さらに、Alibabaのオープンソース戦略は、グローバルコミュニティからの貢献を奨励し、拡張機能、ベンチマーク、ベストプラクティスライブラリからなる活気あるエコシステムを育んでいます。

結論

要約すると、Qwen3-CoderはソフトウェアエンジニアリングにおけるオープンソースAIの画期的な成果です。コードを書くだけでなく、開発パイプライン全体を人間の介入を最小限に抑えながらオーケストレーションする、強力なエージェントモデルです。この技術を自由に利用でき、容易に統合できるようにすることで、アリババは高度なAIツールへのアクセスを民主化し、ソフトウェア開発がますます協調的、効率的、そしてインテリジェントになる時代への基盤を築いています。

よくあるご質問

Qwen3-Coder が「エージェント的」である理由は何ですか?

エージェントAIとは、複数のステップからなるタスクを自律的に計画・実行できるモデルを指します。Qwen3-Coderは、外部ツールの呼び出し、テストの実行、コードベースの管理を人間の介入なしに実行できるため、このパラダイムを体現しています。

Qwen3-Coder は本番環境での使用に適していますか?

Qwen3-Coder はベンチマークや実際のテストで優れたパフォーマンスを示していますが、企業は重要な本番ワークフローに統合する前に、ドメイン固有の評価を実施し、ガードレール (出力検証パイプラインなど) を実装する必要があります。

Mixture‑of‑Experts アーキテクチャは開発者にどのようなメリットをもたらしますか?

MoEは、トークンごとに関連するサブネットワークのみをアクティブ化することで推論コストを削減し、生成速度の向上と計算コストの削減を実現します。この効率性は、クラウド環境におけるAIコーディングアシスタントのスケーリングに不可欠です。