Qwen3-Max-Previewは、アリババのQwen3ファミリーにおける最新の主力プレビューモデルです。262兆以上のパラメータを持つMixture-of-Experts(MoE)スタイルのモデルで、XNUMXkトークンという非常に長いコンテキストウィンドウを備え、エンタープライズ/クラウド向けにプレビュー版としてリリースされています。*深い推論、長い文書の理解、コーディング、エージェントワークフロー.

基本情報と見出しの特徴

- 名前 / ラベル:

qwen3-max-preview(指示する)。 - スケール: 1兆を超えるパラメータ (兆パラメータのフラッグシップ)。これは、今回のリリースにおけるマーケティングおよび統計上の重要なマイルストーンです。

- コンテキストウィンドウ: 262,144トークン (非常に長い入力と複数ファイルのトランスクリプトをサポートします)。

- モード: 命令を最適化した「Instruct」バリアントで、 思考 (意図的な思考の連鎖)と 思考しない Qwen3 ファミリーの高速モード。

- 在庫: プレビューアクセス Qwen チャット, アリババクラウドモデルスタジオ (OpenAI互換またはDashScopeエンドポイント)およびルーティングプロバイダー コメットAPI.

技術的な詳細(アーキテクチャとモード)

- 建築: Qwen3-MaxはQwen3の設計系統を踏襲しており、 高密度 + 専門家の混合 (MoE) より大きなバリエーションのコンポーネントと、非常に大きなパラメータ数の推論効率を最適化するエンジニアリングの選択肢。

- 思考モードと非思考モード: Qwen3シリーズは 思考モード (複数ステップの思考連鎖スタイルの出力の場合)および 非思考モード より速く、簡潔な返信を実現するために、プラットフォームではこれらの動作を切り替えるパラメータを公開しています。

- コンテキスト キャッシュ/パフォーマンス機能: モデルスタジオリスト コンテキストキャッシュ 繰り返し入力コストを削減し、繰り返しコンテキストでのスループットを向上させるための大規模なリクエストのサポート。

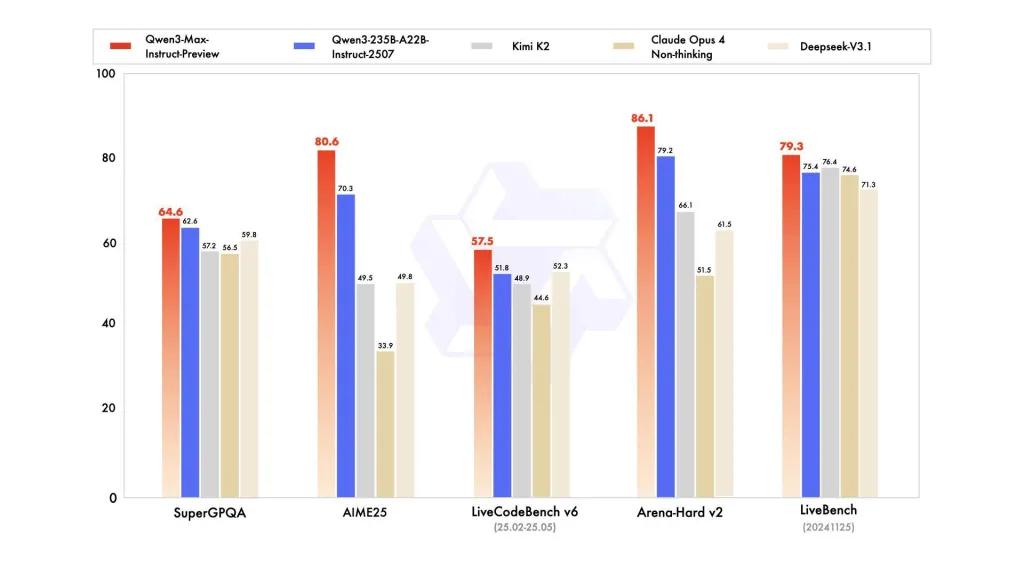

ベンチマークパフォーマンス

レポートでは、SuperGPQA、LiveCodeBench バリアント、AIME25、およびその他のコンテスト/ベンチマーク スイートが参照されており、Qwen3-Max が競争力があるかリードしているようです。

制限とリスク(実用および安全に関する注意事項)

- 完全なトレーニングレシピ/重みの不透明度: プレビュー版であるため、トレーニングデータやウェイトの完全なリリース、および再現性に関する資料は、以前のQwen3のオープンウェイト版と比べて制限されている可能性があります。一部のQwen3ファミリーモデルはオープンウェイト版でリリースされていましたが、Qwen3-Maxはクラウドアクセス用の制御されたプレビューとして提供されています。 再現性が低下する 独立した研究者向け。

- 幻覚と事実: ベンダーの報告では幻覚の軽減が謳われていますが、実際の使用においては、事実誤認や過信に基づく主張が依然として存在する可能性があります。法学修士(LLM)の標準的な注意事項が適用されます。リスクの高い導入を行う前に、独立した評価を実施する必要があります。

- 大規模なコスト: 巨大なコンテキストウィンドウと高い機能により、 トークンコスト 非常に長いプロンプトや本番環境のスループットには大きな負担がかかる可能性があります。キャッシュ、チャンク、予算管理などを活用してください。

- 規制とデータ主権に関する考慮事項: 企業ユーザーは、機密情報を処理する前に、Alibaba Cloud のリージョン、データの保存場所、コンプライアンスへの影響を確認する必要があります。(Model Studio のドキュメントには、リージョン固有のエンドポイントと注意事項が含まれています。)

ユースケース

- 大規模なドキュメント理解/要約: 法律文書、技術仕様書、複数ファイルの知識ベース(利点: 262Kトークン 窓)。

- ロングコンテキストのコード推論とリポジトリ規模のコードアシスト: 複数ファイルのコード理解、大規模な PR レビュー、リポジトリ レベルのリファクタリング提案。

- 複雑な推論と思考の連鎖のタスク: 数学のコンテスト、多段階の計画、「思考」の痕跡が追跡可能性に役立つエージェントワークフロー。

- 多言語、エンタープライズQ&A、構造化データ抽出: 大規模な多言語コーパスのサポートと構造化された出力機能 (JSON / テーブル)。

CometAPIからQqwen3-max-preview APIを呼び出す方法

qwen3-max-preview CometAPI の API 価格、公式価格より 20% オフ:

| 入力トークン | $0.24 |

| 出力トークン | $2.42 |

必要な手順

- ログインする コムタピまだユーザーでない場合は、まず登録してください

- インターフェースのアクセス認証情報APIキーを取得します。パーソナルセンターのAPIトークンで「トークンを追加」をクリックし、トークンキー(sk-xxxxx)を取得して送信します。

- このサイトの URL を取得します: https://api.cometapi.com/

使用方法

- 「qwen3-max-preview」エンドポイントを選択し、APIリクエストを送信し、リクエストボディを設定してください。リクエストメソッドとリクエストボディは、弊社ウェブサイトのAPIドキュメントから取得できます。また、お客様の便宜を図るため、弊社ウェブサイトではApifoxテストも提供しています。

- 交換するアカウントの実際の CometAPI キーを使用します。

- コンテンツ フィールドに質問またはリクエストを入力します。モデルはこれに応答します。

- API 応答を処理して、生成された回答を取得します。

API呼び出し

CometAPIは、シームレスな移行のために完全に互換性のあるREST APIを提供します。 APIドキュメント:

- コアパラメータ:

prompt,max_tokens_to_sample,temperature,stop_sequences - 終点:

https://api.cometapi.com/v1/chat/completions - モデルパラメータ: qwen3-max-プレビュー

- 認証:

Bearer YOUR_CometAPI_API_KEY - コンテンツタイプ:

application/json.

交換する

CometAPI_API_KEYキーを使って、 ベースURL.

Python (リクエスト) — OpenAI互換

import os, requests

API_KEY = os.getenv("CometAPI_API_KEY")

url = "https://api.cometapi.com/v1/chat/completions"

headers = {"Authorization": f"Bearer {API_KEY}", "Content-Type": "application/json"}

payload = {

"model": "qwen3-max-preview",

"messages": [

{"role":"system","content":"You are a concise assistant."},

{"role":"user","content":"Explain the pros and cons of using an MoE model for summarization."}

],

"max_tokens": 512,

"temperature": 0.1,

"enable_thinking": True

}

resp = requests.post(url, headers=headers, json=payload)

print(resp.status_code, resp.json())

ヒント: つかいます max_input_tokens, max_output_tokens、そしてモデルスタジオの コンテキストキャッシュ 非常に大きなコンテキストを送信してコストとスループットを制御する機能。

も参照してください Qwen3-Coder