2025 年 11 月 19 日から 20 日にかけて、OpenAI は関連性はあるものの異なる 2 つのアップグレードをリリースしました。 GPT-5.1-コーデックス-Max、Codexの新しいエージェントコーディングモデルであり、長期コーディング、トークン効率、およびマルチウィンドウセッションを維持するための「圧縮」を重視しています。 GPT-5.1 プロは、複雑で専門的な作業において、より明確でより有能な回答が得られるように調整された、更新されたプロレベルの ChatGPT モデルです。

GPT-5.1-Codex-Max とは何ですか? また、どのような問題を解決しようとしているのですか?

GPT-5.1-Codex-Maxは、OpenAIの特別なCodexモデルであり、次のようなコーディングワークフロー向けに調整されています。 持続的かつ長期的な推論と実行通常のモデルでは、複数ファイルのリファクタリング、複雑なエージェントループ、永続的なCI/CDタスクなど、非常に長いコンテキストによって処理が滞る可能性があるが、Codex-Maxは、 複数のコンテキストウィンドウにわたってセッション状態を自動的に圧縮および管理しますこれにより、単一のプロジェクトが数千(あるいはそれ以上)のトークンにまたがる場合でも、一貫性を保ちながら動作し続けることができます。OpenAIは、Codex-Maxを、コード対応エージェントを拡張エンジニアリング作業に真に役立つものにするための次のステップと位置付けています。

GPT-5.1-Codex-Max とは何ですか? また、どのような問題を解決しようとしているのですか?

GPT-5.1-Codex-Maxは、OpenAIの特別なCodexモデルであり、次のようなコーディングワークフロー向けに調整されています。 持続的かつ長期的な推論と実行通常のモデルでは、複数ファイルのリファクタリング、複雑なエージェントループ、永続的なCI/CDタスクなど、非常に長いコンテキストによって処理が滞る可能性があるが、Codex-Maxは、 複数のコンテキストウィンドウにわたってセッション状態を自動的に圧縮および管理しますこれにより、単一のプロジェクトが数千(またはそれ以上)のトークンにまたがる場合でも、一貫して動作し続けることができます。

OpenAI はこれを「開発サイクルのあらゆる段階でより高速、よりインテリジェント、よりトークン効率が高い」と説明しており、Codex サーフェスのデフォルト モデルとして GPT-5.1-Codex を置き換えることを明確に意図しています。

機能スナップショット

- マルチウィンドウの連続性のための圧縮: 重要なコンテキストを整理して保存し、何百万ものトークンと時間にわたって一貫して機能するようにします。0

- GPT-5.1-Codexと比較してトークン効率が向上しました。 一部のコード ベンチマークでは、同様の推論作業に対して思考トークンが最大で約 30% 少なくなります。

- 長期的なエージェントの耐久性: 内部的には、数時間/数日間のエージェント ループを維持することが観察されています (OpenAI は 24 時間を超える内部実行を記録しました)。

- プラットフォーム統合: Codex CLI、IDE 拡張機能、クラウド、コード レビュー ツール内で現在利用可能。API アクセスは近日中に開始されます。

- Windows環境のサポート: OpenAI は、Windows が Codex ワークフローで初めてサポートされ、現実世界の開発者の範囲が拡大したことを特に指摘しています。

競合製品 (GitHub Copilot、他のコーディング AI など) と比較するとどうですか?

GPT-5.1-Codex-Maxは、リクエストごとの補完ツールと比較して、より自律的で長期的な協働ツールとして提案されています。Copilotなどのアシスタントはエディター内での短期的な補完に優れていますが、Codex-Maxの強みは、複数ステップのタスクのオーケストレーション、セッション間の一貫性のある状態の維持、そして計画、テスト、反復を必要とするワークフローの処理にあります。とはいえ、ほとんどのチームにとって最適なアプローチは、複雑な自動化と継続的なエージェントタスクにはCodex-Maxを使用し、行レベルの補完には軽量なアシスタントを使用するというハイブリッドなアプローチになるでしょう。

GPT-5.1-Codex-Max はどのように機能しますか?

「コンパクション」とは何ですか? また、それはどのようにして長時間実行の作業を可能にするのですか?

中心的な技術進歩は 圧縮—セッション履歴を整理しながらコンテキストの重要な部分を保存する内部メカニズム。これによりモデルは一貫した作業を継続できる。 の試合に コンテキストウィンドウ。実際には、コンテキスト制限に近づいているCodexセッションは圧縮(古いトークンや価値の低いトークンを要約/保存)されるため、エージェントは新しいウィンドウを持ち、タスクが完了するまで繰り返し反復処理を続けることができます。OpenAIは、モデルが24時間以上連続してタスクを実行した内部実行を報告しています。

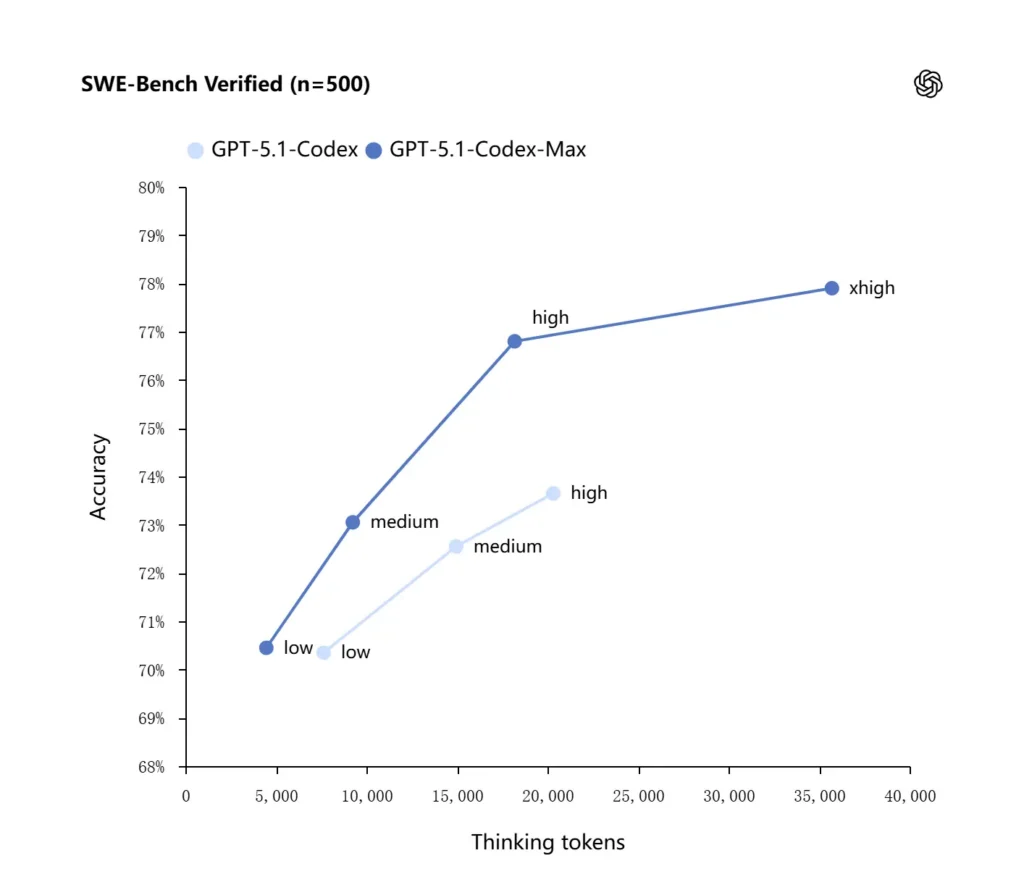

適応的推論とトークン効率

GPT-5.1-Codex-Maxは、トークン効率を高める改良された推論戦略を適用しています。OpenAIが報告した内部ベンチマークでは、MaxモデルはGPT-5.1-Codexと同等かそれ以上のパフォーマンスを達成しながら、大幅に少ない「思考」トークンを使用しています。OpenAIはおよそ 30%少ない SWE-bench Verifiedにおける思考トークンは、同等の推論努力で実行した場合の結果です。このモデルでは、レイテンシの影響を受けないタスク向けに「Extra High (xhigh)」推論努力モードも導入されており、これにより内部推論をより多く活用して、より高品質な出力を得ることができます。

システム統合とエージェントツール

Codex-Maxは、Codexのワークフロー(CLI、IDE拡張機能、クラウド、コードレビューサーフェス)内に配布され、実際の開発者ツールチェーンと連携できます。初期統合にはCodex CLIおよびIDEエージェント(VS Code、JetBrainsなど)が含まれており、APIアクセスは後日追加される予定です。設計目標は、よりスマートなコード合成だけでなく、ファイルのオープン、テストの実行、エラーの修正、リファクタリング、再実行といった複数ステップのワークフローを実行できるAIを実現することです。

GPT-5.1-Codex-Max はベンチマークと実際の作業でどのように機能しますか?

持続的な推論と長期的な課題

評価では、持続的な推論と長期的なタスクにおいて測定可能な改善が見られました。

- OpenAIの内部評価Codex-Maxは社内実験において「24時間以上」タスクを処理できること、そしてCodexを開発者ツールと統合することで社内エンジニアリング生産性指標(例:使用状況やプルリクエストのスループット)が向上したことが報告されています。これらはOpenAIの社内発表であり、実世界の生産性におけるタスクレベルの向上を示しています。

- 独立評価(METR): METRの独立報告書は、 観測された50%の時間範囲 (モデルが長時間のタスクを一貫して維持できる平均時間を表す統計)GPT-5.1-Codex-Maxの場合、約 2時間40分 (信頼区間は広い)GPT-5の同等の測定における2時間17分から改善しており、持続的な一貫性において、有意な傾向に沿った改善が見られます。METRの手法と信頼区間は変動性を重視していますが、この結果は、Codex-Maxが実用的な長期的パフォーマンスを向上させるという主張を裏付けています。

コードベンチマーク

OpenAIは、フロンティアコーディング評価、特にSWE-bench Verifiedにおいて、GPT-5.1-Codex-MaxがGPT-5.1-Codexをトークン効率で上回る性能を示したことを報告しています。同社は、同じ「中程度」の推論負荷において、Maxモデルは思考トークンを約30%削減しながら、より良い結果を生み出すと強調しています。より長い内部推論を許容するユーザーにとって、xhighモードはレイテンシを犠牲にして、回答をさらに向上させることができます。

| GPT‑5.1-Codex(高) | GPT‑5.1-Codex-Max(xhigh) | |

| SWEベンチ検証済み(n=500) | 73.7% | 77.9% |

| SWE-ランサー IC SWE | 66.3% | 79.9% |

| ターミナルベンチ 2.0 | 52.8% | 58.1% |

GPT-5.1-Codex-Max と GPT-5.1-Codex を比較するとどうなりますか?

パフォーマンスと目的の違い

- 範囲: GPT-5.1-Codex は、GPT-5.1 ファミリーの高性能コーディングバリアントでした。 コーデックスマックス は、Codex および Codex のような環境の推奨デフォルトとなることを意図した、エージェントによる長期的な後継です。

- トークン効率: Codex-Max は、SWE ベンチおよび内部使用において、重要なトークン効率の向上 (OpenAI の主張によると思考トークンが約 30% 減少) を示しています。

- コンテキスト管理: Codex-Max は、単一のコンテキスト ウィンドウを超えるタスクをサポートするために、圧縮とネイティブのマルチウィンドウ処理を導入しています。Codex では、同じ規模でこの機能をネイティブに提供していませんでした。

- ツールの準備: Codex-Max は、CLI、IDE、コード レビュー サーフェス全体のデフォルトの Codex モデルとして出荷され、運用開発者のワークフローの移行を示します。

どのモデルをいつ使用すればよいですか?

- GPT-5.1-Codexを使用する インタラクティブなコーディング支援、素早い編集、小さなリファクタリング、関連するコンテキスト全体が 1 つのウィンドウに簡単に収まる低レイテンシのユースケースなどに適しています。

- GPT-5.1-Codex-Maxを使用する 複数ファイルのリファクタリング、多くの反復サイクルを必要とする自動化されたエージェントタスク、CI/CD のようなワークフロー、または多くのインタラクションにわたってプロジェクトレベルの視点をモデルで保持する必要がある場合に使用します。

実用的なプロンプトパターンと最良の結果を得るための例はありますか?

効果的なプロンプトパターン

- 目標と制約を明確にします。 「X をリファクタリングし、パブリック API を維持し、関数名を維持し、テスト A、B、C が合格することを確認します。」

- 再現可能な最小限のコンテキストを提供します。 リポジトリ全体をダンプするのではなく、失敗したテストへのリンク、スタックトレース、関連ファイルスニペットを含めます。Codex-Maxは必要に応じて履歴を圧縮します。

- 複雑なタスクには段階的な指示を使用します。 大規模なジョブを一連のサブタスクに分割し、Codex-Max でそれらを反復処理します (例: 「1) テストを実行する 2) 失敗したテストの上位 3 つを修正する 3) リンターを実行する 4) 変更を要約する」)。

- 説明と相違点を尋ねます: 人間のレビュー担当者が安全性と意図を迅速に評価できるように、パッチと簡単な根拠の両方を要求します。

プロンプトテンプレートの例

リファクタリングタスク

「リファクタリング

payment/支払い処理を抽出するモジュールpayment/processor.py既存の呼び出し元に対して、公開関数のシグネチャを安定させておく。ユニットテストを作成する。process_payment()成功、ネットワーク障害、無効なカードをカバーするテストスイートを実行します。テストスイートを実行し、失敗したテストとパッチを統合差分形式で返します。

バグ修正 + テスト

「テスト

tests/test_user_auth.py::test_token_refreshトレースバックで失敗します。根本原因を調査し、最小限の変更で修正を提案し、回帰を防ぐためのユニットテストを追加してください。パッチを適用してテストを実行してください。

反復的なPR生成

「機能Xの実装:エンドポイントの追加

POST /api/exportエクスポート結果をストリーミングし、認証されます。エンドポイントを作成し、ドキュメントを追加し、テストを作成し、手動項目の概要とチェックリストを含むPRを作成してください。

これらのほとんどは、 ミディアム 努力; 切り替える xhigh 多数のファイルと複数のテスト反復にわたってモデルで深い推論を実行する必要がある場合。

GPT-5.1-Codex-Maxにアクセスするにはどうすればいいですか?

現在入手可能な場所

OpenAIはGPT-5.1-Codex-Maxを Codexツール 現在、Codex CLI、IDE拡張機能、クラウド、コードレビューフローはデフォルトでCodex-Maxを使用しています(Codex-Miniを選択することもできます)。APIの提供は準備中です。GitHub Copilotには、GPT-5.1およびCodexシリーズモデルを含むパブリックプレビューが用意されています。

開発者はGPT-5.1-Codex-Maxにアクセスでき、 GPT-5.1-Codex API CometAPIを通じて。まずは、コメットAPI 会場は プレイグラウンド 詳細な手順についてはAPIガイドをご覧ください。アクセスする前に、CometAPIにログインし、APIキーを取得していることを確認してください。 とeタピ 統合を支援するために、公式価格よりもはるかに低い価格を提供します。

準備はいいですか?→ 今すぐCometAPIに登録しましょう !

AIに関するヒント、ガイド、ニュースをもっと知りたい方は、フォローしてください。 VK, X および Discord!

クイックスタート(実践的なステップバイステップ)

- アクセスできることを確認してください: ChatGPT/Codex 製品プラン (Plus、Pro、Business、Edu、Enterprise) または開発者 API プランが GPT-5.1/Codex ファミリ モデルをサポートしていることを確認します。

- Codex CLI または IDE 拡張機能をインストールします。 コードタスクをローカルで実行する場合は、Codex CLI または VS Code / JetBrains / Xcode 用の Codex IDE 拡張機能をインストールしてください。サポートされているセットアップでは、ツールはデフォルトで GPT-5.1-Codex-Max になります。

- 推論努力を選択してください: 皮切りに ミディアム ほとんどのタスクでは、労力はかかりません。詳細なデバッグ、複雑なリファクタリング、またはモデルに高度な思考をさせたい場合や応答の遅延を気にしない場合は、 高いです or xhigh モード。ちょっとした修正には、 低いです 合理的です。

- リポジトリのコンテキストを提供します: モデルに明確な開始点を与えます。リポジトリのURL、またはファイルセットと簡単な指示(例:「支払いモジュールをリファクタリングして非同期I/Oを使用し、ユニットテストを追加し、関数レベルの契約を維持する」)です。Codex-Maxはコンテキストの制限に近づくと履歴を圧縮し、ジョブを継続します。

- テストを繰り返します: モデルがパッチを生成した後、テストスイートを実行し、進行中のセッションの一部として失敗をフィードバックします。圧縮とマルチウィンドウの継続性により、Codex-Maxは重要な失敗したテストのコンテキストを保持し、反復処理を実行できます。

まとめ:

GPT-5.1-Codex-Maxは、効率性と推論能力を向上させ、複雑で長時間にわたるエンジニアリングタスクを支えられるエージェント型コーディングアシスタントへの大きな一歩です。技術的進歩(圧縮、推論モード、Windows環境トレーニング)により、このモデルは現代のエンジニアリング組織に非常に適しています。ただし、チームがこのモデルを保守的な運用管理、明確な人間参加型ポリシー、そして堅牢な監視と組み合わせる必要があります。Codex-Maxを慎重に導入するチームにとって、Codex-Maxはソフトウェアの設計、テスト、保守の方法を変革する可能性を秘めており、反復的なエンジニアリング作業を、人間とモデル間のより価値の高いコラボレーションへと変えることができます。