DeepSeekがリリース ディープシークV3.2 V3.xラインの後継機として、 DeepSeek-V3.2-スペシャル 同社がエージェント/ツール利用のための高性能かつ推論重視のエディションと位置付けるV3.2のバリアント。V3.2は実験的な作業(V3.2-Exp)を基に構築され、より高度な推論機能、数学/競技プログラミングにおける「ゴールドレベル」のパフォーマンスに最適化されたSpecialeエディション、そしてDeepSeekがこの種のものとしては初と表現する、内部のステップバイステップ推論と外部ツールの呼び出しおよびエージェントワークフローを緊密に統合するデュアルモード「思考+ツール」システムを導入しています。

DeepSeek V3.2 とは何ですか? また、V3.2-Speciale との違いは何ですか?

DeepSeek-V3.2は、DeepSeekの実験的なバージョンであるV3.2-Expブランチの正式な後継バージョンです。DeepSeekはこれを次のように説明しています。 エージェント向けに構築された「推論重視」モデルファミリーつまり、自然な会話品質だけでなく、外部ツール (API、コード実行、データ コネクタ) を含む環境で動作する場合のマルチステップ推論、ツール呼び出し、および信頼性の高い思考連鎖スタイルの推論に特化して調整されたモデルです。

DeepSeek-V3.2(ベース)とは

- V3.2-Exp 実験ラインの主流製品後継として位置付けられ、DeepSeek のアプリ/Web/API を介して幅広く利用可能になる予定です。

- エージェントタスクの計算効率と堅牢な推論のバランスを保ちます。

DeepSeek-V3.2-Specialeとは

DeepSeek-V3.2-スペシャル DeepSeekがコンテストレベルの推論、高度な数学、そしてエージェントのパフォーマンス向けに調整された高機能版「スペシャルエディション」として販売しているバリアントです。「推論機能の限界を押し広げる」高機能版として販売されています。DeepSeekは現在、Specialeを一時的なアクセスルーティングを備えたAPIのみのモデルとして公開しています。初期のベンチマークでは、推論およびコーディングベンチマークにおいてハイエンドのクローズドモデルと競合する位置付けにあることが示唆されています。

どのような系譜とエンジニアリングの選択が V3.2 につながったのでしょうか?

V3.2は、DeepSeekが2025年にかけて発表した反復エンジニアリングの系譜を受け継いでいます。V3 → V3.1(Terminus)→ V3.2-Exp(実験段階)→ V3.2 → V3.2-Speciale。実験段階のV3.2-Expは、 DeepSeek スパースアテンション(DSA) — 非常に長いコンテキスト長におけるメモリと計算コストを削減しつつ、出力品質を維持することを目的とした、細粒度スパースアテンション機構。このDSA研究とコスト削減作業は、公式V3.2ファミリーへの技術的な足掛かりとなりました。

公式 DeepSeek 3.2 の新機能は何ですか?

1) 推論能力の向上 — 推論能力はどのように向上するのでしょうか?

DeepSeekはV3.2を 「まず推論する」 つまり、アーキテクチャと微調整は、複数ステップの推論を確実に実行し、思考の内部チェーンを維持し、エージェントが外部ツールを正しく使用するために必要な構造化された審議をサポートすることに重点を置いています。

具体的には、次のような改善が行われます。

- 明示的な段階的な問題解決と安定した中間状態を促すように調整されたトレーニングと RLHF (または同様のアライメント手順) (数学的推論、マルチステップのコード生成、およびロジックタスクに役立ちます)。

- より長いコンテキスト ウィンドウを保持し、モデルが以前の推論手順を忠実に参照できるようにするアーキテクチャと損失関数の選択。

- 同じモデルをより高速な「チャット」スタイル モード、または意図的に中間ステップを実行してから行動する慎重な「思考」モードのいずれかで動作させる実用的なモード (下記の「デュアル モード」を参照)。

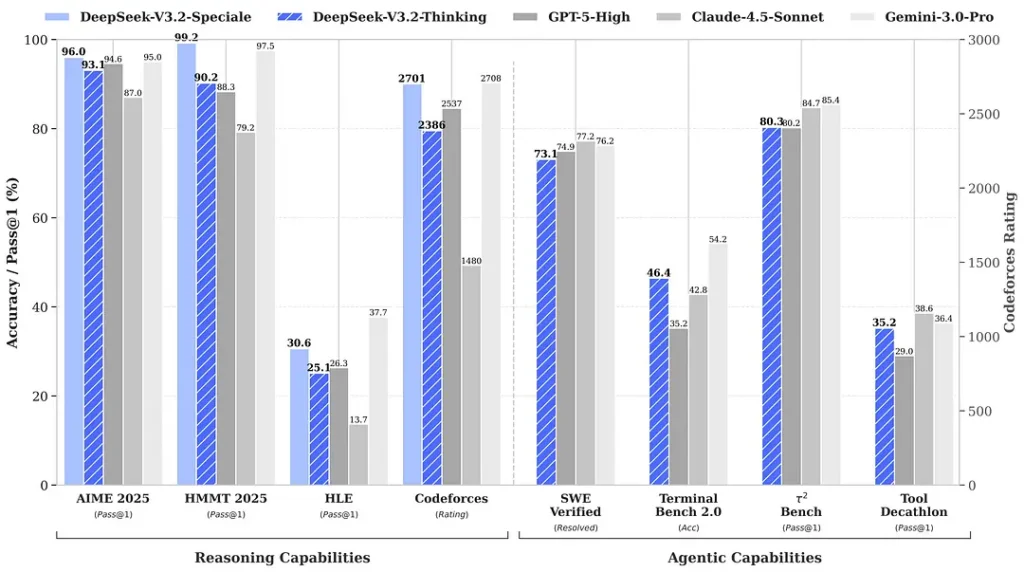

リリース時に引用されたベンチマークでは、数学および推論スイートで顕著な進歩が達成されたと主張されています。独立した初期のコミュニティベンチマークでも、競合評価セットで印象的なスコアが報告されています。

2) スペシャル エディションの画期的なパフォーマンス — どれくらい向上したのでしょうか?

DeepSeek-V3.2-スペシャル 標準のV3.2と比較して、推論精度とエージェントオーケストレーションの両面で向上しているとされています。プロバイダーは、Specialeを高負荷の推論ワークロードと高度なエージェントタスクを対象としたパフォーマンス層と位置付けています。現在はAPIのみで、一時的な高機能エンドポイントとして提供されています(DeepSeekは、Specialeの提供は当初限定的になると発表しています)。Specialeバージョンは、以前の数学モデルDeepSeek-Math-V2を統合しています。数学定理を証明し、論理的推論を独自に検証できます。また、複数の世界クラスのコンペティションで目覚ましい成績を収めています。

- 🥇 IMO(国際数学オリンピック)金メダル

- 🥇 CMO(中国数学オリンピック)金メダル

- 🥈 ICPC(国際コンピュータプログラミングコンテスト)第2位(人間コンテスト)

- 🥉 IOI(国際情報オリンピック)10位(人間コンテスト)

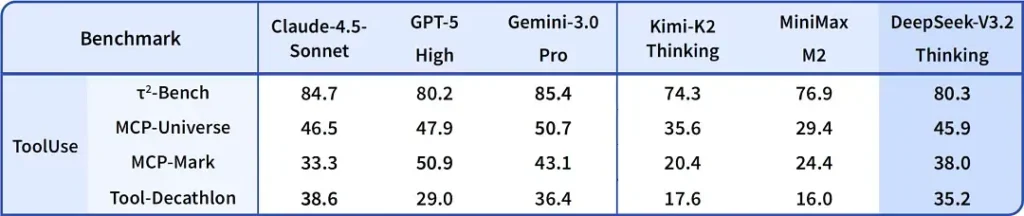

| ベンチマーク | GPT-5 高 | ジェミニ 3.0 プロ | キミK2の考え | DeepSeek-V3.2 の考え方 | DeepSeek-V3.2 スペシャル |

|---|---|---|---|---|---|

| エム2025 | 94.6 (13k) | 95.0 (15k) | 94.5 (24k) | 93.1 (16k) | 96.0 (23k) |

| HMMT 2025月XNUMX日 | 88.3 (16k) | 97.5 (16k) | 89.4 (31k) | 92.5 (19k) | 99.2 (27k) |

| HMMT 2025年11月 | 89.2 (20k) | 93.3 (15k) | 89.2 (29k) | 90.2 (18k) | 94.4 (25k) |

| IMOAnswerBench | 76.0 (31k) | 83.3 (18k) | 78.6 (37k) | 78.3 (27k) | 84.5 (45k) |

| ライブコードベンチ | 84.5 (13k) | 90.7 (13k) | 82.6 (29k) | 83.3 (16k) | 88.7 (27k) |

| コードフォース | 2537 (29k) | 2708 (22k) | - | 2386 (42k) | 2701 (77k) |

| GPQA ダイヤモンド | 85.7 (8k) | 91.9 (8k) | 84.5 (12k) | 82.4 (7k) | 85.7 (16k) |

| HLE | 26.3 (15k) | 37.7 (15k) | 23.9 (24k) | 25.1 (21k) | 30.6 (35k) |

3) デュアルモード「思考+ツール」システムを初めて実装

バージョン3.2で最も実用的に興味深い主張の一つは、 デュアルモードワークフロー 高速な会話操作と、ツールの使用と緊密に統合された、より低速で慎重な「思考」モードを分離し、選択できるようにします。

- 「チャット/高速」モード: 低遅延で、簡潔な回答と少ない内部推論のトレースを備えたユーザー向けチャット用に設計されており、カジュアルなヘルプ、短い Q&A、速度が重視されるアプリケーションに適しています。

- 「思考・推論」モード: 厳密な思考の連鎖、段階的な計画、外部ツール(API、データベースクエリ、コード実行)のオーケストレーションに最適化されています。思考モードで動作する場合、モデルはより明確な中間ステップを生成します。これらのステップは検査したり、エージェントシステムにおける安全で正確なツール呼び出しを促進するために使用できます。

このパターン(2モード設計)は以前の実験ブランチにも存在していましたが、DeepSeekはV3.2およびSpecialeでより深く統合しました。Specialeは現在、思考モードのみをサポートしています(そのためAPIゲーティングが使用されています)。速度と熟考を切り替える機能はエンジニアリングにとって非常に貴重です。なぜなら、開発者は現実世界のシステムと相互作用する必要があるエージェントを構築する際に、レイテンシと信頼性の適切なトレードオフを選択できるからです。

注目すべき理由: 多くの現代システムは、推論を説明する強力な思考連鎖モデル、または独立したエージェント/ツールオーケストレーション層のいずれかを提供しています。DeepSeekのフレームワークは、より緊密な結合を示唆しています。つまり、モデルが「思考」し、決定論的にツールを呼び出し、ツールからの応答に基づいてその後の思考を決定づけるのです。これは、自律エージェントを構築する開発者にとってよりシームレスなソリューションです。

入手する場所 ディープシーク v3.2

簡単に答えると、必要なものに応じて、いくつかの方法で DeepSeek v3.2 を入手できます。

- 公式ウェブ/アプリ(オンラインで使用) — V3.2 をインタラクティブに使用するには、DeepSeek Web インターフェイスまたはモバイル アプリを試してください。

- APIアクセス — DeepSeekはAPIを通じてV3.2を公開しています(ドキュメントにはモデル名、base_url、価格などが記載されています)。APIキーを登録して、v3.2エンドポイントを呼び出してください。

- ダウンロード可能/オープンウェイト(Hugging Face) — モデル(V3.2 / V3.2-Expバリアント)はHugging Faceで公開されており、ダウンロード可能です(オープンウェイト)。

huggingface-hubortransformersファイルをプルします。 - コメットAPI — AI API集約プラットフォームがホストエンドポイントを提供するV3.2-Exp。価格は公式価格より安価です。

実用的な注意点をいくつか紹介します。

- したい場合は ローカルで実行する重み、Hugging Faceモデルページにアクセスし(そこにあるライセンス/アクセス条件に同意してください)、

huggingface-cliortransformersダウンロードするには、GitHub リポジトリには通常、正確なコマンドが表示されます。 - したい場合は API経由の本番環境使用エンドポイント名と正しいものについては、cometapi APIドキュメントなどのプラットフォームに従ってください。

base_urlV3.2 バリアントの場合。

DeepSeek-V3.2-スペシャル:

- 研究目的のみに公開されており、「思考モード」ダイアログはサポートされていますが、ツール呼び出しはサポートされていません。

- 最大出力は 128K トークン (超長い Thinking Chain) に達します。

- 現在、2025 年 12 月 15 日まで無料でテストできます。

最終的な考え

DeepSeek-V3.2は、推論中心モデルの成熟における重要な一歩です。改良されたマルチステップ推論、特化した高性能エディション(Speciale)、そして製品化された「思考+ツール」の統合は、高度なエージェント、コーディングアシスタント、あるいは外部アクションと思考を交互に行う必要がある研究ワークフローを構築するすべての人にとって注目に値します。

開発者はCometAPIを通じてDeepSeek V3.2にアクセスできます。まずは、CometAPIのモデル機能を プレイグラウンド そして相談する APIガイド 詳細な手順についてはこちらをご覧ください。アクセスする前に、CometAPIにログインし、APIキーを取得していることを確認してください。 とeタピ 統合を支援するために、公式価格よりもはるかに低い価格を提供します。

準備はいいですか?→ 今すぐCometAPIに登録しましょう !