急速に進歩する人工知能の世界では、大規模言語モデル(LLM)の新たなリリースは、単なる数値的なバージョンアップ以上の意味を持つ。推論能力、コーディング能力、そして人間と機械の協働における進歩を示すものだ。2025年9月下旬には、 Zhipu AI (Z.ai) 発表 GLM-4.6一般言語モデルファミリーの最新メンバーである。GLM-4.5の堅牢なアーキテクチャと強力な推論基盤を基盤として、このアップデートではモデルの機能がさらに強化されている。 エージェント的推論、コーディング知能、長期文脈理解開発者と企業の両方にとってオープンでアクセスしやすいままです。

GLM-4.6とは何ですか?

GLM-4.6は、GLM(一般言語モデル)シリーズのメジャーリリースであり、高容量推論と実用的な開発者ワークフローのバランスをとるように設計されています。このリリースは、密接に関連する3つのユースケースを対象としています。(1) 高度なコード生成とコードに関する推論、(2) 非常に長い入力に対するモデル理解を必要とする拡張コンテキストタスク、(3) モデルが計画、ツール呼び出し、および複数ステップのプロセスのオーケストレーションを行うエージェントワークフローです。このモデルは、クラウドAPIとコミュニティモデルハブ向けのバリアントで提供され、ホスト型とセルフホスト型の両方のデプロイメントパターンに対応しています。

GLM-4.6は実質的に「開発者ファースト」のフラッグシップとして位置付けられています。その改良点は、ベンチマークの数値そのものだけでなく、開発者がアシスタント、コードコパイロット、ドキュメント駆動型エージェントや知識駆動型エージェントを構築する方法に本質的な変化をもたらす機能も備えています。ツールの使用を考慮した命令チューニング、コード品質とデバッグのためのきめ細かな改善、そしてパフォーマンスの線形劣化なしに非常に長いコンテキストを可能にするインフラストラクチャの選択に重点を置いたリリースとなることを期待してください。

GLM-4.6 は何を解決することを目指していますか?

- より長い有効コンテキスト ウィンドウをサポートすることで、長いコードベースや大きなドキュメントを扱う際の摩擦を軽減します。

- コード生成とデバッグの信頼性を向上させ、より慣用的でテスト可能な出力を生成します。

- 対象を絞った指導と強化スタイルの調整を通じて、エージェントの動作(計画、ツールの使用、複数ステップのタスク実行)の堅牢性を高めます。

GLM-4.5 から GLM-4.6 では、実際に何が変わりましたか?

- コンテキストスケーリング: 128K ジャンプ 200トークン ユーザーにとって最も大きなUX/アーキテクチャの変更点です。長いドキュメント、コードベース全体、あるいは拡張されたエージェントのトランスクリプトを、単一のコンテキストウィンドウとして処理できるようになりました。これにより、多くのワークフローにおいて、アドホックなチャンク処理や高コストな検索ループの必要性が軽減されます。

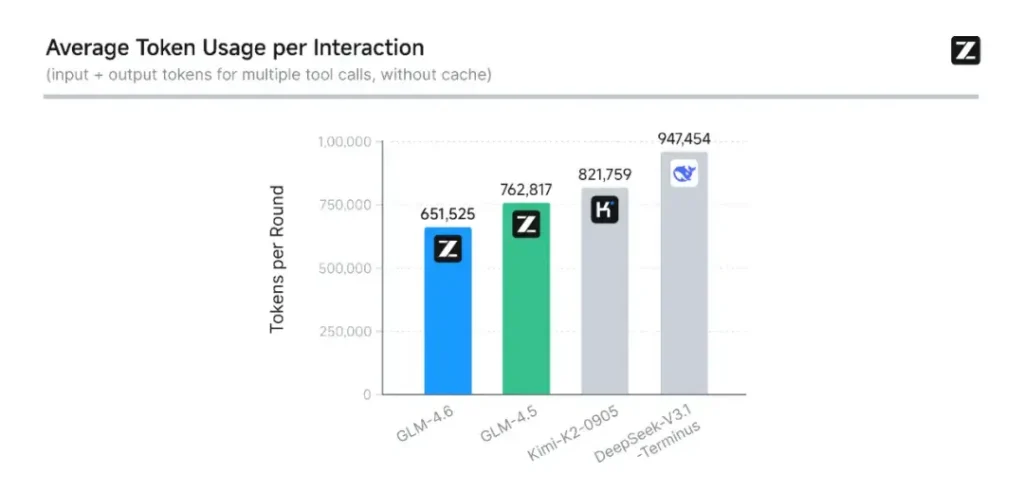

- コーディングと実世界での評価: Z.aiはCC-Bench(コーディングと完了のベンチマーク)をより難しい実際のタスクの軌跡で拡張し、GLM-4.6がタスクを次のように完了したと報告しています。 トークンが約15%減少 GLM-4.5よりも、複雑なマルチターンエンジニアリングタスクにおける成功率が向上しています。これは、トークン効率の向上と、応用コーディングシナリオにおける基本的な能力の向上を示しています。 Z.ai

- エージェントとツールの統合: GLM-4.6 には、ツール呼び出しおよび検索エージェントのより優れたサポート パターンが含まれています。これは、Web 検索、コード実行、またはその他のマイクロサービスを調整するためにモデルに依存する製品にとって重要です。

GLM-4.6 の主な機能は何ですか?

1. コンテキストウィンドウを200万トークンまで拡張

GLM-4.6の最も注目を集める機能の一つは、 大幅に拡張されたコンテキストウィンドウ前世代の128Kから拡張 200トークンGLM-4.6は、書籍全体、複雑な複数文書のデータセット、あるいは何時間にも及ぶ会話を1回のセッションで処理できます。この拡張により、理解度が向上するだけでなく、 長い入力に対する一貫した推論 — ドキュメント要約、法的分析、ソフトウェア エンジニアリング ワークフローにとって大きな飛躍です。

2. コーディングインテリジェンスの向上

Zhipu AI の内部 CCベンチ ベンチマーク、つまり実際のプログラミングタスクのスイートでは、GLM-4.6が達成していることを示しています。 コーディングの精度と効率が著しく向上このモデルは、構文的に正しく、論理的に健全なコードを生成しながら、 トークンが約15%減少 同等のタスクにおいてGLM-4.5よりも高い効率を実現しています。このトークン効率は、品質を犠牲にすることなく、より迅速かつ低コストでタスクを完了できることを意味します。これは、エンタープライズ展開において重要な要素です。

3. 高度な推論とツールの統合

GLM-4.6は、生のテキスト生成以外にも、 ツール拡張推論GLM-4.6は、データベースから検索ツール、実行環境に至るまで、多段階の計画と外部システムのオーケストレーションのためにトレーニングと調整が行われています。これは、GLM-4.6が「頭脳」として機能することを意味します。 自律型AIエージェント外部 API をいつ呼び出すか、結果をどのように解釈するか、セッション間でタスクの継続性をどのように維持するかを決定します。

4. 強化された自然言語アライメント

GLM-4.6は継続的な強化学習と嗜好の最適化を通じて、 よりスムーズな会話の流れ、より良いスタイルのマッチング、そしてより強力な安全性の調整このモデルは、正式な文書、教育指導、創造的な文章など、コンテキストに合わせてトーンと構造を調整し、ユーザーの信頼性と読みやすさを向上させます。

GLM-4.6 を動かすアーキテクチャは何ですか?

GLM-4.6 は専門家混合モデルですか?

推論方法の継続性: GLMチームは、GLM-4.5とGLM-4.6は基本的な推論パイプラインを共有しているため、既存のデプロイメント設定を最小限の摩擦でアップグレードできると述べています。これにより、既にGLM-4.xを使用しているチームの運用リスクが軽減されます。スケーリングパラメータとモデル設計の選択は、エージェント推論、コーディング、効率的な推論のための特化を重視しています。GLM-4.5レポートは、このファミリーのMoE戦略とトレーニング計画(多段階の事前トレーニング、エキスパートモデルの反復、アライメントのための強化学習)について、公開されている中で最も明確な説明を提供しています。GLM-4.6は、これらの教訓を適用しながら、コンテキストの長さとタスク固有の機能を調整します。

エンジニアのための実践的な建築ノート

- パラメータフットプリントとアクティブ化されたコンピューティング: パラメータの合計数が大きい場合(数千億)は、すべてのリクエストで同等のアクティベーション コストに直接変換されるわけではありません。MoE は、トークン シーケンスごとにエキスパートのサブセットのみがアクティブ化されることを意味し、多くのワークロードに対してより有利なコストとスループットのトレードオフを実現します。

- トークンの精度と形式: 公開重みは BF16 および F32 形式で配布されており、コミュニティ量子化 (GGUF、4 ビット/8 ビット) が急速に登場しています。これにより、チームはさまざまなハードウェア プロファイルで GLM-4.6 を実行できます。

- 推論スタックの互換性: Z.ai は、vLLM およびその他の最新の LLM ランタイムを互換性のある推論バックエンドとして文書化しており、これにより GLM-4.6 はクラウドとオンプレミスの両方の展開で実現可能になります。

ベンチマークパフォーマンス: GLM-4.6 のパフォーマンスはどうでしょうか?

どのようなベンチマークが報告されましたか?

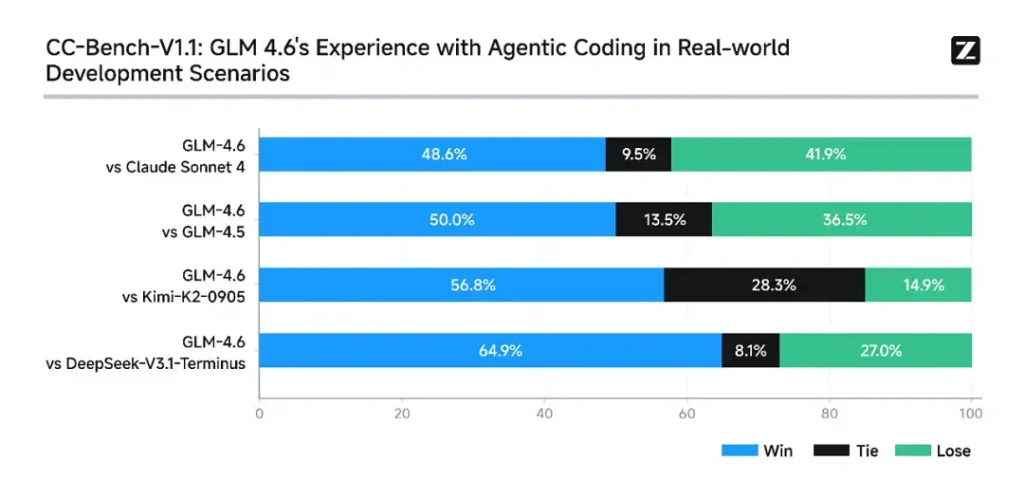

Z.aiはGLM-4.6を一連の 8つの公開ベンチマーク エージェントタスク、推論、コーディングなど、幅広いタスクを対象としています。また、CC-Bench(Docker隔離環境で実行される、人間による評価に基づく実タスクのコーディングベンチマーク)を拡張し、プロダクションエンジニアリングタスク(フロントエンド開発、テスト、アルゴリズムによる問題解決)をより適切にシミュレートしました。これらのタスクにおいて、GLM-4.6はGLM-4.5と比較して一貫した改善を示しました。

コーディング性能

- 実際のタスクが勝利: CC-Benchの人間による評価では、GLM-4.6は ほぼ同等 アントロピック社のクロード・ソネット4と直接対決したマルチターンタスクでZ.aiが報告 48.6%の勝利率 Docker分離環境下での人間による評価において(解釈:キュレーションされたセットにおけるClaude Sonnet 4との差はほぼ50/50)、GLM-4.6は、これらのタスクにおいて、国内の多くのオープンモデル(DeepSeekの亜種など)を上回るパフォーマンスを示しました。

- トークン効率: Z.aiレポート トークンが約15%減少 CC-Bench の軌跡では、GLM-4.5 と比較してタスクを完了するのに使用される時間が短く、これはレイテンシとコストの両方に影響します。

推論と数学

GLM-4.6は、GLM-4.5と比較して推論能力が向上し、ツール使用能力も強化されていると主張しています。GLM-4.5がハイブリッドな「思考」と直接応答モードを重視していたのに対し、GLM-4.6は、特に検索ツールや実行ツールと統合した場合の多段階推論の堅牢性を向上させています。

Z.aiのパブリックメッセージでは、GLM-4.6は 主要な国際および国内モデルと競争力がある 選択したベンチマークにおいて、具体的にはClaude Sonnet 4と競合し、コード/エージェントタスクにおいてはDeepSeekの派生版などの国内の代替品よりも優れた性能を発揮しています。しかし、一部のコーディングに特化したサブベンチマーク**では、GLM-4.6は依然としてClaude Sonnet 4.5(Anthropicのより最近のリリース)に遅れをとっており、完全な優位性というよりは、僅差の競争状態となっています。

GLM-4.6へのアクセス方法

- 1. Z.aiプラットフォームを通じて: 開発者はGLM-4.6に直接アクセスできます。 Z.aiのAPI or **チャットインターフェース(chat.z.ai)**これらのホスト型サービスにより、ローカル環境への導入を必要とせず、迅速な実験と統合が可能になります。APIは、標準的なテキスト補完と構造化されたツール呼び出しモードの両方をサポートしており、エージェント型ワークフローに不可欠です。

- 2. Hugging FaceとModelScopeのオープンウェイト: ローカル制御を好む人のために、Zhipu AIはGLM-4.6モデルファイルをリリースしました。 ハグ顔 および モデルスコープセーフテンソルバージョンを含む BF16 および F32 精度。コミュニティ開発者はすでに量子化されたGGUFバージョンを作成しており、コンシューマーグレードのGPUでの推論を可能にしています。

- 3. 統合フレームワーク: GLM-4.6は、次のような主要な推論エンジンとスムーズに統合されます。 vLLM, SGLang, LMデプロイ最新のサービングスタックに適応可能です。この汎用性により、企業は以下から選択できます。 , エッジ, オンプレミス展開 コンプライアンスまたはレイテンシーの要件に応じて異なります。

CometAPIは、OpenAIのGPTシリーズ、GoogleのGemini、AnthropicのClaude、Midjourney、Sunoなど、主要プロバイダーの500以上のAIモデルを、開発者にとって使いやすい単一のインターフェースに統合する統合APIプラットフォームです。一貫した認証、リクエストフォーマット、レスポンス処理を提供することで、CometAPIはAI機能をアプリケーションに統合することを劇的に簡素化します。チャットボット、画像ジェネレーター、音楽作曲ツール、データドリブン分析パイプラインなど、どのようなアプリケーションを構築する場合でも、CometAPIを利用することで、反復処理を高速化し、コストを抑え、ベンダーに依存しない環境を実現できます。同時に、AIエコシステム全体の最新のブレークスルーを活用できます。

最新の統合 GLM-4.6 はまもなく CometAPI に登場しますので、お楽しみに!GLM 4.6 モデルのアップロードが完了するまで、モデル ページで他のモデルを調べたり、AI プレイグラウンドで試したりしてください。

開発者はアクセスできる GLM-4.5 API CometAPIを通じて、 最新モデルバージョン 公式ウェブサイトで常に更新されています。まずは、モデルの機能について調べてみましょう。 プレイグラウンド そして相談する APIガイド 詳細な手順についてはこちらをご覧ください。アクセスする前に、CometAPIにログインし、APIキーを取得していることを確認してください。 コメットAPI 統合を支援するために、公式価格よりもはるかに低い価格を提供します。

準備はいいですか?→ 今すぐCometAPIに登録しましょう !

結論 — GLM-4.6が今なぜ重要なのか

GLM-4.6は、GLMラインにおける重要なマイルストーンです。開発者にとって実用的な改善(コンテキストウィンドウの延長、ターゲットを絞ったコーディングとエージェントの最適化、そして目に見えるベンチマークの向上)と、多くの組織が求めるオープン性とエコシステムの柔軟性を融合させているからです。コードアシスタント、長文ドキュメントエージェント、ツールを活用した自動化を開発するチームにとって、GLM-4.6は最有力候補として評価する価値があります。