GPT-5-Codexは、OpenAIが新たにエンジニアリングに特化したGPT-5の派生版であり、Codex製品ファミリーにおけるエージェントソフトウェアエンジニアリング向けに特別に調整されています。これは、大規模な実世界のエンジニアリングワークフローに対応するように設計されています。具体的には、プロジェクトをゼロから作成し、機能とテストを追加し、デバッグとリファクタリングを行い、外部ツールやテストスイートと連携しながらコードレビューを実行するといった作業です。今回のリリースは、全く新しい基本モデルではなく、ターゲットを絞った製品の改良を表しています。OpenAIはGPT-5-CodexをCodex CLI、Codex IDE拡張機能、Codex Cloud、GitHubワークフロー、ChatGPTモバイルエクスペリエンスに統合しました。APIの提供は計画されていますが、すぐには提供されません。

GPT-5-Codex とは何ですか? なぜ存在するのですか?

GPT-5-Codexは、コーディングに特化したGPT-5です。一般的な会話アシスタントではなく、強化学習とエンジニアリングに特化したデータセットを用いて調整・トレーニングされており、反復的なツール支援コーディングタスク(テストの実行、障害の反復処理、モジュールのリファクタリング、PR規則の遵守など)をより適切にサポートします。OpenAIはこれを、以前のCodexの後継として位置付けていますが、GPT-5を基盤として構築することで、大規模なコードベースにおける推論の深さを向上させ、複数段階のエンジニアリングタスクをより確実に実行します。

動機は実用的です。開発者のワークフローは、単一のスニペットの提案以上の機能を持つエージェントへの依存度が高まっています。OpenAIは、モデルを「生成 → テスト実行 → 修正 → 繰り返し」というループと組織のPR規範に特化させることで、単発の補完を提供するだけのAIではなく、チームメイトのように感じられるAIを目指しています。「関数を生成する」から「機能をリリースする」というこの移行こそが、このモデルの独自の価値です。

GPT-5-Codex はどのように設計およびトレーニングされるのでしょうか?

高レベルアーキテクチャ

GPT-5-Codexは、GPT-5アーキテクチャ(より広義のGPT-5系)の派生版であり、ゼロから構築された新しいアーキテクチャではありません。つまり、GPT-5のコアとなるトランスフォーマーベースの設計、スケーリング特性、推論機能の改良を継承しつつ、Codex固有のトレーニングと、ソフトウェアエンジニアリングタスクを対象とした強化学習ベースの微調整機能が追加されています。OpenAIの補遺では、GPT-5-Codexは複雑な実世界のエンジニアリングタスクでトレーニングされており、コードが実行・検証される環境における強化学習を重視していると説明されています。

コードはどのようにトレーニングされ、最適化されたのでしょうか?

GPT-5-Codexのトレーニング計画では、 現実世界のエンジニアリングタスクCodexは、複数ファイルのリファクタリング、プルリクエストの差分、実行中のテストスイート、デバッグセッション、人間によるレビューシグナルといった、具体的なソフトウェア開発ワークフローから構築されたデータセットと環境に対し、強化学習型のファインチューニングを適用します。トレーニングの目的は、コード編集全体の正確性を最大化し、テストに合格し、高い精度と関連性を持つレビューコメントを生成することです。この点が、Codexを一般的なチャットベースのファインチューニングと差別化しています。損失関数、評価ハーネス、報酬シグナルは、エンジニアリングの成果(テスト合格、正しい差分、不要なコメントの減少)に合わせて調整されています。

「エージェント的」トレーニングとは

- 実行主導の微調整モデルは、生成されたコードが実行、テスト、評価されるコンテキストでトレーニングされます。フィードバックループはテスト結果と人間の嗜好シグナルから生成され、テストスイートが合格するまでモデルが反復処理を続けます。

- 人間のフィードバックからの強化学習 (RLHF): これまでの RLHF の作業と精神的には似ていますが、マルチステップのコーディング タスク (PR の作成、テストの実行、障害の修正) に適用されているため、モデルは一連のアクションにわたって一時的なクレジットの割り当てを学習します。

- リポジトリ規模のコンテキストトレーニングと評価には大規模なリポジトリとリファクタリングが含まれており、モデルがファイル間の推論、命名規則、コードベースレベルの影響を学習するのに役立ちます。()

GPT-5-Codex はツールの使用と環境の相互作用をどのように処理しますか?

重要なアーキテクチャ上の特徴は、ツールの呼び出しと調整能力の向上です。Codexは従来、モデルの出力を、テストの実行、ファイルのオープン、検索の呼び出しなどができる小規模なランタイム/エージェントシステムと組み合わせてきました。GPT-5-Codexは、ツールを呼び出すタイミングを学習し、テストのフィードバックを後続のコード生成により適切に統合することで、これを拡張します。これにより、合成と検証の間のループが効果的に閉じられます。これは、モデルがアクション(「テストXを実行」など)を発行し、テスト出力と差分に基づいて後続の世代を条件付ける軌跡を学習することで実現されます。

GPT-5-Codex は実際に何ができるのでしょうか? その機能は何ですか?

決定的な製品イノベーションの一つは 適応的思考の持続時間GPT-5-Codexは、隠れた推論の実行量を調整します。些細なリクエストは高速かつ低コストで実行され、複雑なリファクタリングや長時間実行されるタスクでは、モデルはより長く「考える」ことができます。同時に、小規模でインタラクティブなターンでは、モデルは汎用GPT-5インスタンスよりもはるかに少ないトークンを消費します。GPT-93.7と比較して、推論と出力を含むトークンを5%節約します。この可変推論戦略は、必要に応じて素早い応答を生成し、必要に応じて深く徹底した実行を行うことを目的としています。

コア機能

- プロジェクトの生成とブートストラップ: 高レベルのプロンプトから、CI、テスト、基本的なドキュメントを含むプロジェクト全体のスケルトンを作成します。

- エージェントテストと反復: コードを生成し、テストを実行し、障害を分析し、コードにパッチを適用し、テストが成功するまで再実行することで、開発者の編集 → テスト → 修正ループの一部を効果的に自動化します。

- 大規模なリファクタリング: 動作とテストを維持しながら、多数のファイルにわたって体系的なリファクタリングを実行します。これは、GPT-5-Codexと汎用GPT-5を比較した際の最適化領域として明示されています。

- コードレビューとPR生成: プロジェクトの規則と人間によるレビューの期待に沿った PR の説明、差分による変更の提案、レビュー コメントを作成します。

- 大規模コンテキストのコード推論: 一般的なチャット モデルと比較して、複数ファイルのコードベース、依存関係グラフ、および API 境界をナビゲートして推論する能力に優れています。

- 視覚的な入力と出力: クラウドで作業する場合、GPT-5-Codex は画像/スクリーンショットを受け入れ、進行状況を視覚的に検査し、視覚的なアーティファクト (構築された UI のスクリーンショット) をタスクに添付できます。これは、フロントエンドのデバッグとビジュアル QA ワークフローにとって実用的な利点です。

エディターとワークフローの統合

Codex は開発者のワークフローに深く統合されています。

- CLI コーデックス — ターミナルファーストのインタラクションで、スクリーンショット、ToDoトラッキング、エージェント承認をサポートします。CLIはオープンソースで、エージェントによるコーディングワークフロー向けに調整されています。

- Codex IDE拡張機能 — エージェントを VS Code (およびフォーク) に埋め込むことで、ローカルの差分をプレビューしたり、クラウド タスクを作成したり、状態を保持したままクラウドとローカルのコンテキスト間で作業を移動したりできるようになります。

- Codexクラウド / GitHub — クラウド タスクは、PR を自動レビューし、テスト用の一時コンテナーを生成し、タスク ログとスクリーンショットを PR スレッドに添付するように構成できます。

注目すべき制限とトレードオフ

- 狭い範囲の最適化: 一部の非コーディングのプロダクション評価では、GPT-5-Codex の方が一般的な GPT-5 バリアントよりもわずかに低くなっています。これは、特殊化によって一般性がトレードオフされる可能性があることを思い出させます。

- テストへの依存: エージェントの動作は利用可能な自動テストに依存します。テストカバレッジが低いコードベースでは、自動検証に限界が生じ、人間による監視が必要になる場合があります。

GPT-5-Codex はどのようなタスクに特に向いているのでしょうか、あるいは向いていないのでしょうか?

得意なこと: 複雑なリファクタリング、大規模プロジェクトのスキャフォールディングの作成、テストの作成と修正、PR の期待の遵守、複数ファイルのランタイム問題の診断など。

あまり得意ではないこと: ワークスペースでは提供されない最新の情報や独自の内部知識を必要とするタスク、あるいは人間によるレビューなしで高い正確性を保証するタスク(安全性が重要なシステムでは依然として専門家が必要)などです。また、独立したレビューでは、他の特殊なコーディングモデルと比較して、生のコード品質に関しても一貫性がないことが指摘されています。つまり、エージェント型ワークフローの強みが、あらゆるベンチマークにおいてクラス最高の正確性につながるわけではないということです。

ベンチマークは GPT-5-Codex のパフォーマンスについて何を明らかにしますか?

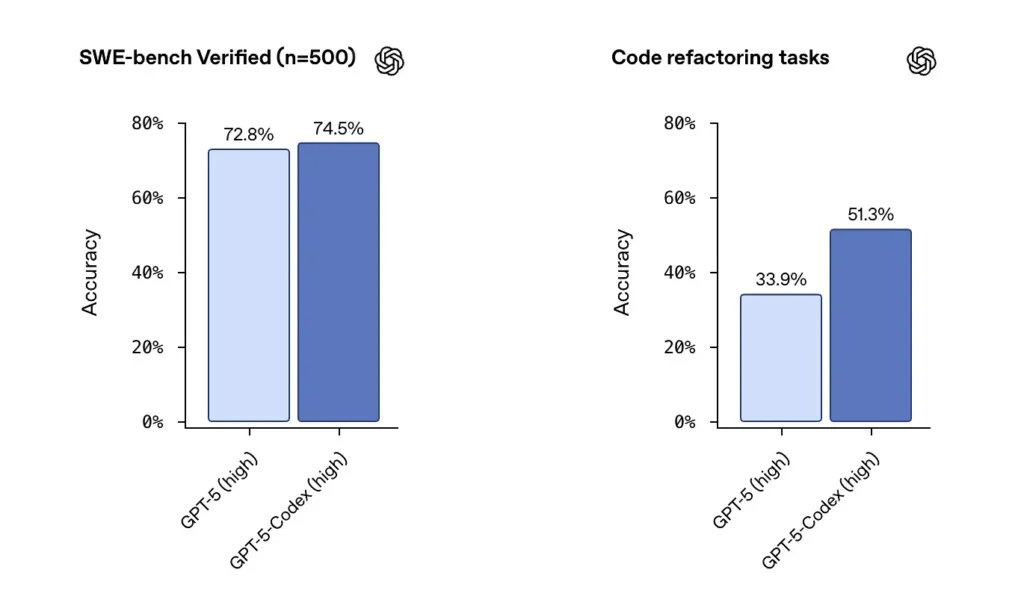

SWEベンチ / SWEベンチ検証済みOpenAIは、GPT-5-CodexがSWE-bench VerifiedなどのエージェントコーディングベンチマークにおいてGPT-5を上回り、大規模リポジトリから抽出されたコードリファクタリングタスクでも優れたパフォーマンスを示していると述べています。500の実際のソフトウェアエンジニアリングタスクを含むSWE-bench Verifiedデータセットにおいて、GPT-5-Codexは74.5%の成功率を達成しました。これは、同じベンチマークにおけるGPT-5の72.8%を上回り、エージェントの能力向上を浮き彫りにしています。実際のオープンソースプロジェクトから抽出された500のプログラミングタスク。以前は477のタスクしかテストできませんでしたが、現在は500タスクすべてをテストできます → より包括的な結果。

以前のGPT-5設定からGPT-5-Codexに移行すると、コードリファクタリングの評価スコアが大幅に上昇しました。特定の高冗長リファクタリングメトリックで約34%から約51%に変化したなどの数値が初期の分析で強調されていました。これらの向上は、改善を反映している点で意味があります。 大規模で現実的なリファクタリング おもちゃの例というよりはむしろ、再現性と正確なテストハーネスに関する注意点が残ります。

開発者やチームはどのようにして GPT-5-Codex にアクセスできますか?

OpenAIはGPT-5-CodexをCodex製品サーフェスに組み込みました。これは、Codexが現在実行されているすべての場所(例えば、Codex CLIや統合されたCodexエクスペリエンス)で利用可能です。CLIとChatGPTサインイン経由でCodexを使用している開発者は、更新されたCodexエクスペリエンスでGPT-5-Codexモデルをサーフェス上に表示できます。OpenAIは、APIキーを使用するユーザー向けに、このモデルがより広範なAPIで「まもなく」利用可能になると発表していますが、最初のロールアウト時点では、主なアクセスパスはパブリックAPIエンドポイントではなく、Codexツール経由となります。

CLI コーデックス

Codex を有効にしてサンドボックスリポジトリ内のドラフト PR をレビューすることで、リスクなしでコメントの品質を評価できます。承認モードは慎重に使用してください。

- エージェントコーディングワークフローを中心に再設計されました。

- 画像 (ワイヤーフレーム、デザイン、UI バグのスクリーンショットなど) の添付のサポートにより、モデルのコンテキストが提供されます。

- 複雑なタスクの進行状況を追跡するためのタスク リスト機能を追加しました。

- 外部ツールのサポート(Web検索、MCP接続)を提供しました。

- 新しいターミナル インターフェイスでは、ツールの呼び出しと diff フォーマットが改善され、権限モードが 3 つのレベル (読み取り専用、自動、フル アクセス) に簡素化されました。

IDE拡張機能

IDE ワークフローに統合: インラインプレビューと迅速なイテレーションを求める開発者向けに、Codex IDE拡張機能を追加します。コンテキストを保持したままクラウドとローカル間でタスクを移動することで、複雑な機能における摩擦を軽減できます。

- VS Code、カーソルなどをサポートします。

- エディターから直接 Codex を呼び出すと、現在開いているファイルとコードのコンテキストを活用して、より正確な結果が得られます。

- コンテキストの継続性を維持しながら、ローカル環境とクラウド環境間でタスクをシームレスに切り替えます。

- プラットフォームを切り替えることなく、エディター内でクラウド タスクの結果を表示および操作します。

GitHub 統合と Cloud Functions

- 自動 PR レビュー: ドラフトから準備完了までの進行を自動的にトリガーします。

- 開発者が PR の @codex セクションで直接、対象を絞ったレビューをリクエストできるようにサポートします。

- 大幅に高速化されたクラウド インフラストラクチャ: コンテナ キャッシュにより、タスク応答時間が 90% 短縮されます。

- 自動環境構成: セットアップ スクリプトを実行し、依存関係をインストールします (例: pip install)。

- ブラウザを自動的に実行し、フロントエンドの実装をチェックし、タスクまたは PR にスクリーンショットを添付します。

安全性、セキュリティ、制限に関する考慮事項は何ですか?

OpenAI は、Codex エージェントに対する多層的な緩和策を重視しています。

- モデルレベルのトレーニング: 即座の注射に抵抗し、有害または危険性の高い行動を制限するための安全トレーニングを対象とする。

- 製品レベルの制御: サンドボックス化されたデフォルトの動作、設定可能なネットワークアクセス、コマンド実行時の承認モード、追跡可能性のための端末ログと引用、そして機密性の高い操作に対して人間の承認を要求する機能。OpenAIはまた、これらの緩和策と、特に生物学および化学分野の機能に関するリスク評価を説明した「システムカード補足資料」も公開しています。

これらの制御は、コマンドを実行して依存関係をインストールできるエージェントには現実世界の攻撃対象領域とリスクがあるという事実を反映しています。OpenAI のアプローチは、モデルのトレーニングと製品の制約を組み合わせて悪用を制限することです。

既知の制限は何ですか?

- 人間のレビュー担当者の代わりではありません: OpenAIはCodexを明示的に推奨しています 追加の レビュー担当者は、代替者ではありません。特にセキュリティ、ライセンス、アーキテクチャの決定においては、人間による監視が依然として重要です。

- ベンチマークと主張は注意深く読む必要があります。 レビュー担当者は、モデルの比較において、評価サブセット、冗長性設定、コストのトレードオフにおける差異を指摘しています。初期の独立テストでは、結果はまちまちでした。Codexは強力なエージェント動作とリファクタリングの改善を示しましたが、他のベンダーと比較した相対的な精度はベンチマークと構成によって異なります。

- 幻覚と不安定な行動: 他のLLMと同様に、Codexは誤動作(URLの偽装、依存関係グラフの誤りなど)を起こす可能性があり、エージェントを長時間実行しても、エッジケースでは脆弱性が発生する可能性があります。出力はテストと人間によるレビューで検証する必要があります。

ソフトウェアエンジニアリングへのより広範な影響は何でしょうか?

GPT-5-Codexは、LLM設計の成熟化を示しています。ベンダーは、言語の裸の機能を改善するだけでなく、最適化を行っています。 行動 長時間のエージェントタスク(複数時間の実行、テスト駆動開発、統合レビューパイプライン)に適しています。これにより、生産性の単位が単一のスニペット生成から タスク完了 — チケットを受け取り、一連のテストを実行し、検証済みの実装を反復的に生成するモデルの能力。これらのエージェントが堅牢になり、適切に管理されれば、ワークフローは大きく変わります(手動リファクタリングの削減、PRサイクルの迅速化、開発者の時間を設計と戦略に集中させることなど)。しかし、この移行には、慎重なプロセス設計、人による監視、そして安全性のガバナンスが必要です。

結論 — 何を学ぶべきでしょうか?

GPT-5-Codexは、 エンジニアグレード LLM:Codexエコシステム内で有能なコーディングエージェントとして機能するようにトレーニング、調整、製品化されたGPT-5のバリアントです。適応型推論時間、長時間の自律実行、統合サンドボックス実行、ターゲットを絞ったコードレビューの改善といった具体的な新しい動作をもたらしますが、言語モデルによくある注意点(人間による監視の必要性、評価のニュアンス、そして時折の幻覚)は維持されています。チームにとって賢明な道は、慎重な実験です。安全なリポジトリで試験運用し、結果指標を監視し、エージェントをレビュー担当者のワークフローに段階的に組み込んでいきます。OpenAIがAPIアクセスを拡大し、サードパーティのベンチマークが増加するにつれて、コスト、精度、ベストプラクティスのガバナンスに関するより明確な比較と、より具体的なガイダンスが期待されます。

スタートガイド

CometAPIは、OpenAIのGPTシリーズ、Google Gemini、AnthropicのClaude、Midjourney、Sunoなど、主要プロバイダーが提供する500以上のAIモデルを、開発者にとって使いやすい単一のインターフェースに統合する統合APIプラットフォームです。一貫した認証、リクエストフォーマット、レスポンス処理を提供することで、CometAPIはAI機能をアプリケーションに統合することを劇的に簡素化します。チャットボット、画像ジェネレーター、音楽作曲ツール、データドリブン分析パイプラインなど、どのようなアプリケーションを構築する場合でも、CometAPIを利用することで、反復処理を高速化し、コストを抑え、ベンダーに依存しない環境を実現できます。同時に、AIエコシステム全体の最新のブレークスルーを活用できます。

開発者はアクセスできる GPT-5-Codex API CometAPI 経由でアクセスする場合、掲載されている最新モデルは記事公開日時点のものです。アクセスする前に、CometAPI にログインし、API キーを取得していることを確認してください。