Kimi K2は、最先端の専門家混合アーキテクチャとエージェントタスクに特化した学習を組み合わせた、オープンソースの大規模言語モデルにおける大きな飛躍を表しています。以下では、Kimi KXNUMXの起源、設計、パフォーマンス、そしてアクセスと使用に関する実用的な考慮事項について考察します。

Kimi K2とは何ですか?

Kimi K2は、Moonshot AIが開発した32兆パラメータのMixture of Experts(MoE)言語モデルです。トークンごとに1億個の「アクティブ化」パラメータと合計2兆個のエキスパートパラメータを特徴としており、線形推論コストをかけずに大規模な処理能力を実現します。Muonオプティマイザーを基盤とするKimi K15.5は、XNUMX兆トークン以上の学習を行い、これまで非実用的と考えられていた規模でも安定性を実現しました。このモデルは、主に以下のXNUMXつのバージョンで提供されています。

キミ-K2-インストラクト: 会話型およびエージェント型アプリケーション向けに事前調整されており、対話システムやツール対応のワークフローにすぐに導入できます。

キミ-K2-ベース: 研究、カスタムの微調整、低レベルの実験に適した基礎モデル。

そのアーキテクチャはどのように機能しますか?

- 専門家の混合(MoE): 各レイヤーでは、ゲーティング メカニズムによって各トークンを処理するエキスパートの小さなサブセット (8 名中 384 名) が選択され、大規模な知識ベースを維持しながら推論の計算が大幅に削減されます。

- 特殊レイヤー: 合計 61 のレイヤーに加えて単一の高密度レイヤーを組み込み、64 個のアテンション ヘッドと、MoE の効率に合わせて調整された隠しディメンションを備えています。

- 文脈と語彙: 最大 128 K トークンのコンテキスト長と 160 K トークンの語彙をサポートし、長文の理解と生成を可能にします。

なぜキミK2が重要なのか?

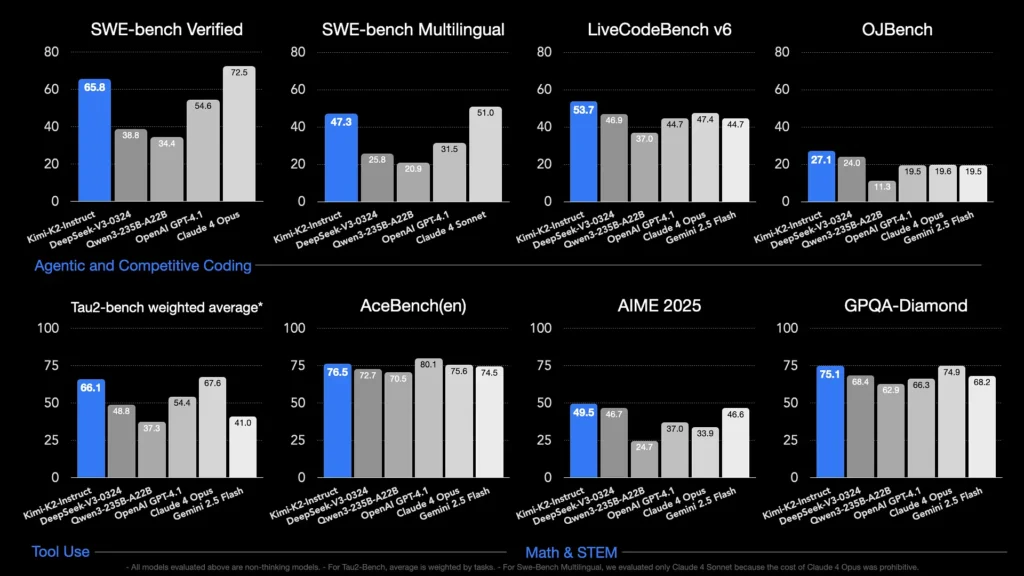

Kimi K2 は、特にコーディングと推論のベンチマークにおいて、主要な独自モデルと同等のパフォーマンスを提供することで、オープンソース AI の限界を押し広げます。

その能力を示すベンチマークは何ですか?

- ライブコードベンチv6: 合格率1%を達成し、オープンソースモデルをリードし、GPT-53.7 (4.1%) などのクローズドシステムに匹敵します。

- SWEベンチ検証済み: スコアは 65.8% で、GPT-4.1 の 54.6% を上回り、公開されている比較テストでは Claude Sonnet 4 に次ぐ成績でした。

- MultiPL-E & OJBench: 堅牢な多言語コーディング能力 (MultiPL-E で 85.7%) と、実際のプログラミング課題全体にわたる信頼性の高いパフォーマンスを実証します。

- 数学500: 97.4% を達成し、GPT-4.1 の 92.4% を上回り、形式的な数学的推論における優れた能力を示しました。

エージェントタスク向けにはどのように最適化されていますか?

Kimi K2は、生データの生成に加え、合成ツール使用シナリオ(モデルコンテキストプロトコル(MCP)データ)を用いて学習し、外部ツールの呼び出し、複数段階のプロセスによる推論、そして自律的な問題解決を実現しました。これにより、Clineのような環境では、コード実行、APIインタラクション、ワークフロー自動化をシームレスにオーケストレーションできるため、特に優れた性能を発揮します。

Kimi K2にアクセスするにはどうすればいいですか?

アクセス オプションは、公式プラットフォーム、オープン ソース ディストリビューション、サードパーティ統合に及び、研究、開発、企業のニーズに応えます。

公式ムーンショットAIプラットフォーム

Moonshot AIは、自社プラットフォームを通じてホスト型推論サービスを提供しており、Kimi-K2-BaseとKimi-K2-Instructの両方のバリアントに低レイテンシのAPIアクセスを提供しています。価格はコンピューティング使用量に基づいて段階的に設定されており、エンタープライズプランには優先サポートとオンプレミス導入が含まれています。ユーザーはMoonshot AIのウェブサイトでサインアップし、APIキーを取得してすぐに統合できます。

コメットAPI

CometAPIはすでにK2を自社のサービスに統合しています。K2推論をマネージドGPUインフラストラクチャ、SLA保証、スケーラブルな価格帯と組み合わせることで、組織は従量課金制のAPI使用量とボリュームディスカウント付きの予約容量のいずれかを選択できます。

CometAPIは、OpenAIのGPTシリーズ、GoogleのGemini、AnthropicのClaude、Midjourney、Sunoなど、主要プロバイダーが提供する500以上のAIモデルを、開発者にとって使いやすい単一のインターフェースに統合する統合APIプラットフォームです。一貫した認証、リクエストフォーマット、レスポンス処理を提供することで、CometAPIはAI機能をアプリケーションに統合することを劇的に簡素化します。

開発者はアクセスできる キミK2 API(kimi-k2-0711-preview)を通して コメットAPIまず、モデルの機能を調べてみましょう。 プレイグラウンド そして相談する APIガイド詳細な手順についてはこちらをご覧ください。アクセスする前に、CometAPIにログインし、APIキーを取得していることを確認してください。

サードパーティツールの統合

- クライン: Kimi K2をネイティブにサポートする人気のコード中心のIDE。

cline:moonshotai/kimi-k2プロバイダーにより、開発者はエディター内でチャット、コード生成、エージェントワークフローにワンクリックでアクセスできるようになります。 - 顔を合わせるスペース: コミュニティホストのデモと最小限のUIにより、ユーザーはブラウザ内でK2-Instructモデルを直接操作できます。Hugging Faceアカウントが必要です。パフォーマンスは共有バックエンドリソースに応じて異なる場合があります。

Kimi K2 はどのように使用しますか?

アクセス方法を選択すると、チャットからコード実行、自律エージェントまで、さまざまなタスクに K2 を使用できます。

APIまたはプラットフォームSDK経由

- 認証する: Moonshot AI または CometAPI から API キーを取得します。

- クライアントの初期化: 公式 SDK (Python/JavaScript) または標準の HTTP リクエストを使用します。

- モデルバリアントを選択:

- キミ-K2-ベース 微調整と研究のため。

- キミ-K2-インストラクト プラグアンドプレイのチャットとエージェント向け。

- CometAPI のモデル:

kimi-k2-0711-preview

- 送信プロンプト: チャット テンプレート (システム、ユーザー、アシスタントの役割) ごとに入力をフォーマットして、最適化された指示に従う動作を活用します。

llama.cpp を使ってローカルで実行する

オフラインまたはセルフホストのセットアップの場合は、Unsloth 量子化 GGUF 重み (245 ビットの動的量子の場合は 1.8 GB) を使用します。

- 重みをダウンロード: Moonshot AI GitHub または Hugging Face リポジトリから。

- llama.cpp をインストールします。 ~250 トークン/秒のスループットを実現するには、十分なディスク (≥ 250 GB) と RAM + VRAM の合計 (≥ 5 GB) があることを確認してください。

- 発売モデル:

./main --model kimi-k2-gguf.q8_0 --prompt "Your prompt here" - 設定の調整: 推奨パラメータを使用する(

rope_freq_base,context_len) 安定したパフォーマンスを得るには、Unsloth ガイドに記載されています。

開発ツールとの統合

- IDE プラグイン: いくつかのコミュニティプラグインにより、VS Code、Neovim、JetBrains IDE で K2 を有効化できます。設定では通常、API エンドポイントとモデル ID を指定します。

- 自動化フレームワーク: LangChain や Haystack などのフレームワークで K2 のエージェント コアを活用し、プロンプト、API 呼び出し、コード実行ステップを複雑な自動化に連結します。

Kimi K2 の典型的な使用例は何ですか?

K2 は、規模、エージェント トレーニング、オープン アクセスを組み合わせているため、さまざまなドメインで多用途に使用できます。

コーディング支援

定型句の生成とリファクタリングからバグ修正とパフォーマンス プロファイリングまで、K2 の SOTA コーディング ベンチマークは実際の生産性向上につながり、多くの場合、読みやすさとシンプルさの点で他の方法よりも優れています。

知識と推論

128Kのコンテキスト長を持つK2は、長い文書、複数文書のQ&A、思考連鎖推論などに対応します。MoEアーキテクチャにより、壊滅的な忘却を起こさずに多様な知識を保持できます。

エージェントワークフロー

K2 は、データの取得、API の呼び出し、コードベースの更新、結果の要約など、複数のステップから成るタスクのオーケストレーションに優れているため、顧客サポート、データ分析、DevOps における自律アシスタントに最適です。

Kimi K2 は他のオープンソース モデルとどう違うのでしょうか?

DeepSeek の V3 と Meta の最近のオープン リリースが 2025 年の初めに注目を集めましたが、Kimi K2 は次の点で他社と差別化しています。

エージェントインテリジェンス

Kimi K2は、ツール呼び出し、シェルコマンド、Web自動化、API統合によるタスクの自動化といった「エージェント型」ワークフロー向けに明確に設計されています。自己再生型拡張学習データセットには、多様なツール呼び出し例が含まれており、実世界のシステムとのシームレスな統合を可能にします。

コスト効率

Kimi K80 は、Claude Sonnet 90 などのモデルと比較してトークンあたりの推論コストが約 4~2% 低く、高額な価格設定をせずにエンタープライズ グレードのパフォーマンスを提供し、価格に敏感な開発者の間で急速な導入を促進します。

ライセンスとアクセシビリティ

制限的なライセンスに縛られた特定のオープンソース リリースとは異なり、Kimi K2 は、Moonshot AI のオープンソース精神に沿って、商用利用、派生作品、ローカル展開を許可する許容ライセンスの下で提供されます。

- 最先端のMoE設計、厳格なエージェントトレーニング、そしてオープンソースの可用性を融合させたKimi K2は、開発者や研究者が法外なコストや閉鎖的なエコシステムに縛られることなく、インテリジェントな自律型アプリケーションを構築できるよう支援します。コードの記述、複雑な複数ステップのワークフローの構築、大規模推論の実験など、K2は多用途で高性能な基盤を提供します。