2025년 XNUMX월 알리바바가 공개 Qwen3-코더복잡한 코딩 워크플로 및 에이전트 프로그래밍 작업을 위해 특별히 설계된 가장 진보된 오픈소스 AI 모델입니다. 이 전문 가이드는 핵심 기능과 주요 혁신 기술 이해부터 함께 제공되는 설치 및 사용까지 필요한 모든 내용을 단계별로 안내합니다. 웬 코드 자동화된 에이전트 방식 코딩을 위한 CLI 도구입니다. 이 과정에서 Qwen3‑Coder를 최대한 활용하기 위해 모범 사례, 문제 해결 팁, 프롬프트 및 리소스 할당을 최적화하는 방법을 배우게 됩니다.

Qwen3‑Coder란 무엇이고 왜 중요한가요?

알리바바의 Qwen3-Coder는 480억 개의 활성 매개변수를 포함하는 35억 개의 매개변수를 가진 전문가 혼합(MoE) 모델로, 대규모 컨텍스트 코딩 작업을 지원하도록 설계되었으며, 기본적으로 256만 1천 개의 토큰(외삽법을 사용하면 최대 23만 개)을 처리합니다. 2025년 XNUMX월 XNUMX일에 출시된 이 모델은 "에이전트 AI 코딩" 분야에서 큰 도약을 보여줍니다. 이 모델은 코드를 생성할 뿐만 아니라 수동 개입 없이 복잡한 프로그래밍 과제를 자율적으로 계획, 디버깅 및 반복 수행할 수 있습니다.

Qwen3‑Coder는 이전 버전과 어떻게 다릅니까?

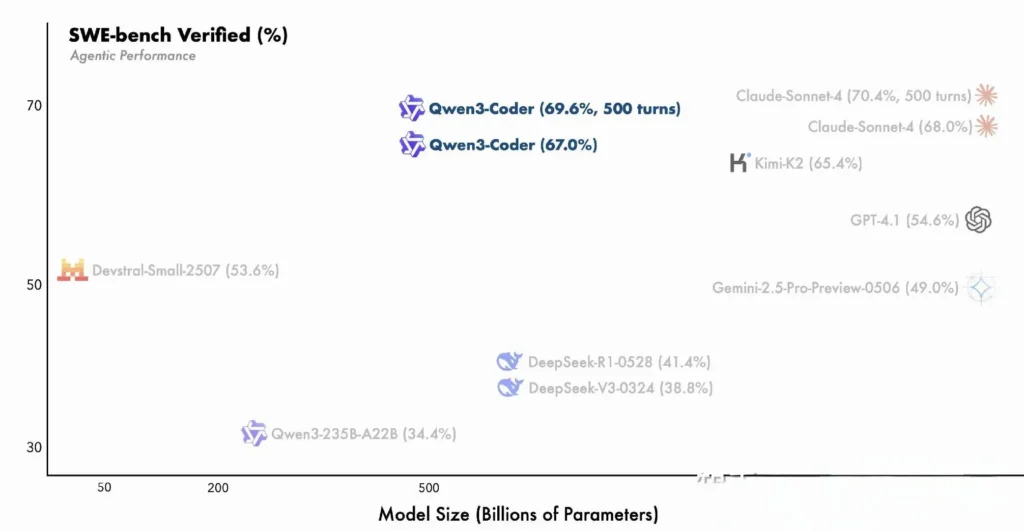

Qwen3‑Coder는 Qwen3 제품군의 혁신 기술을 기반으로 합니다. 다단계 추론을 위한 "사고 모드"와 신속한 대응을 위한 "비사고 모드"를 모두 하나의 통합 프레임워크로 통합하여 작업 복잡성에 따라 동적으로 모드를 전환합니다. 밀도가 높고 작은 컨텍스트에 국한되었던 Qwen2.5‑Coder와 달리, Qwen3‑Coder는 희소한 Mixture‑of‑Experts 아키텍처를 사용하여 SWE‑Bench Verified 및 CodeForces ELO 등급과 같은 벤치마크에서 최첨단 성능을 제공하며, 주요 코딩 지표에서 Anthropic의 Claude 및 OpenAI의 GPT‑4와 같은 모델을 따라잡거나 능가합니다.

Qwen3‑Coder의 주요 기능:

- 대규모 컨텍스트 창: 기본적으로 256개의 토큰을 지원하며, 추정을 통해 최대 1M개까지 지원하여 한 번에 전체 코드베이스나 긴 문서를 처리할 수 있습니다.

- 에이전트 기능: 수동 엔지니어링 오버헤드를 줄여 코드를 자율적으로 계획, 생성, 테스트 및 디버깅할 수 있는 전담 "에이전트 모드"입니다.

- 높은 처리량 및 효율성: 전문가 혼합 설계는 추론 당 35억 개의 매개변수만 활성화하여 성능과 계산 비용의 균형을 맞춥니다.

- 오픈 소스 및 확장 가능: Apache 2.0에서 출시되었으며, 완벽하게 문서화된 API와 커뮤니티 중심의 개선 사항은 GitHub에서 제공됩니다.

- 다국어 및 크로스 도메인: Python, JavaScript부터 Go, Rust까지 수십 개의 프로그래밍 언어에 걸쳐 7.5조 개의 토큰(70%는 코드)을 사용하여 학습했습니다.

개발자는 어떻게 Qwen3‑Coder를 시작할 수 있나요?

Qwen3‑Coder는 어디에서 다운로드하고 설치할 수 있나요?

모델 가중치와 Docker 이미지는 다음에서 얻을 수 있습니다.

- GitHub : https://github.com/QwenLM/Qwen3-Coder

- 포옹하는 얼굴: https://huggingface.co/QwenLM/Qwen3-Coder-480B-A35B-Instruct

- 모델 범위: 알리바바 공식 저장소

간단히 리포를 복제하고 미리 빌드된 Docker 컨테이너를 가져옵니다.

git clone https://github.com/QwenLM/Qwen3-Coder.git

cd Qwen3-Coder

docker pull qwenlm/qwen3-coder:latest

모델에 변압기 로드

from transformers import AutoModelForCausalLM, AutoTokenizer

model_name = "Qwen/Qwen3-Coder-480B-A35B-Instruct"

model = AutoModelForCausalLM.from_pretrained(

model_name,

torch_dtype="auto",

device_map="auto"

)

tokenizer = AutoTokenizer.from_pretrained(model_name)

이 코드는 모델과 토크나이저를 초기화하고 사용 가능한 GPU에 레이어를 자동으로 분배합니다.

내 환경을 어떻게 구성하나요?

- 하드웨어 요구 사항 :

- ≥ 48GB VRAM이 있는 NVIDIA GPU(A100 80GB 권장)

- 128–256GB 시스템 RAM

-

종속성 :

pip install -r requirements.txt # PyTorch, CUDA, tokenizers, etc. -

API 키(선택 사항):

클라우드 호스팅 추론의 경우 다음을 설정하세요.ALIYUN_ACCESS_KEY및ALIYUN_SECRET_KEY환경 변수로서.

에이전트 코딩에 Qwen Code를 어떻게 사용하나요?

다음은 시작 및 실행을 위한 단계별 가이드입니다. Qwen3‑코더 를 통해 웬 코드 CLI(단순히 호출됨) qwen):

1. 선결 요건

- 노드.js 20+ (공식 설치 프로그램이나 아래 스크립트를 통해 설치할 수 있습니다)

- npmNode.js와 함께 제공되는

# (Linux/macOS)

curl -qL https://www.npmjs.com/install.sh | sh

2. Qwen Code CLI 설치

npm install -g @qwen-code/qwen-code

양자 택일로소스에서 설치하려면:

git clone https://github.com/QwenLM/qwen-code.git

cd qwen-code

npm install

npm install -g

3. 환경 구성

Qwen 코드는 다음을 사용합니다. OpenAI 호환 내부 API 인터페이스입니다. 다음 환경 변수를 설정하세요.

export OPENAI_API_KEY="your_api_key_here"

export OPENAI_BASE_URL="https://dashscope-intl.aliyuncs.com/compatible-mode/v1"

export OPENAI_MODEL="qwen3-coder-plus"

OPENAI_MODEL 다음 중 하나로 설정할 수 있습니다.

qwen3-coder-plus(Qwen3‑Coder-480B-A35B-Instruct로 별칭됨)- 또는 배포한 다른 Qwen3‑Coder 변형.

4. 기본 사용법

- 대화형 코딩 REPL 시작:

qwen

그러면 Qwen3‑Coder가 지원하는 에이전트 코딩 세션으로 넘어갑니다.

- Shell에서 코드 조각을 요청하거나 기능을 완료하려면 일회성 프롬프트를 사용합니다.

qwen code complete \

--model qwen3-coder-plus \

--prompt "Write a Python function that reverses a linked list."

- 파일 기반 코드 완성, 기존 파일을 자동으로 채우거나 리팩토링:

qwen code file-complete \

--model qwen3-coder-plus \

--file ./src/utils.js

- 채팅 스타일 상호 작용, 다중 턴 코딩 대화에 적합한 "채팅" 모드에서 Qwen 사용:

qwen chat \

--model qwen3-coder-plus \

--system "You are a helpful coding assistant." \

--user "Generate a REST API endpoint in Express.js for user authentication."

CometAPI API를 통해 Qwen3-Coder를 호출하려면 어떻게 해야 하나요?

CometAPI는 OpenAI의 GPT 시리즈, Google의 Gemini, Anthropic의 Claude, Midjourney, Suno 등 주요 공급업체의 500개 이상의 AI 모델을 단일 개발자 친화적인 인터페이스로 통합하는 통합 API 플랫폼입니다. CometAPI는 일관된 인증, 요청 형식 지정 및 응답 처리를 제공하여 애플리케이션에 AI 기능을 통합하는 과정을 획기적으로 간소화합니다. 챗봇, 이미지 생성기, 음악 작곡가 또는 데이터 기반 분석 파이프라인 등 어떤 제품을 구축하든 CometAPI를 사용하면 AI 생태계 전반의 최신 혁신 기술을 활용하면서 반복 작업을 더 빠르게 수행하고 비용을 관리하며 공급업체에 구애받지 않을 수 있습니다.

cometAPI 사용자인 경우 cometapi에 로그인하여 키와 기본 URL을 가져오고 cometapi에 로그인하여 키와 기본 URL을 가져올 수 있습니다. Qwen3-Coder API시작하려면 모델의 기능을 탐색하세요. 운동장 그리고 상담하십시오 API 가이드 자세한 지침은

CometAPI를 통해 Qwen3‑Coder를 호출하려면 다른 모델과 동일한 OpenAI 호환 엔드포인트를 사용합니다. 즉, 클라이언트를 CometAPI의 기본 URL로 가리키고 CometAPI 키를 Bearer 토큰으로 제시하고 다음을 지정하기만 하면 됩니다. qwen3-coder-plus or qwen3-coder-480b-a35b-instruct 모델입니다.

1. 선결 요건

- 가입하기 at https://cometapi.com 대시보드에 API 토큰을 추가/생성하세요.

- 당신의 메모 API 키 (로 시작

sk-…). - OpenAI Chat API 프로토콜(역할 + 메시지)에 대한 지식이 필요합니다.

2. 기본 URL 및 인증

기본 URL:

arduinohttps://api.cometapi.com/v1

종점:

bashPOST https://api.cometapi.com/v1/chat/completions

3. cURL / REST 예제

curl https://api.cometapi.com/v1/chat/completions \

-H "Authorization: Bearer sk-xxxxxxxxxxxx" \

-H "Content-Type: application/json" \

-d '{

"model": "qwen3-coder-plus",

"messages": [

{ "role": "system", "content": "You are a helpful coder." },

{ "role": "user", "content": "Generate a SQL query to find duplicate emails." }

],

"temperature": 0.7,

"max_tokens": 512

}'

- 응답: JSON 포함

choices.message.content생성된 코드를 포함합니다.

Qwen3-Coder의 에이전트 기능을 어떻게 활용하시나요?

Qwen3-Coder의 에이전트 기능은 동적 도구 호출과 자율적인 다단계 워크플로를 지원하여 코드 생성 중에 모델이 외부 함수나 API를 호출할 수 있도록 합니다.

도구 호출 및 사용자 정의 도구

코드베이스에 린터, 테스트 러너, 포맷터와 같은 사용자 지정 도구를 정의하고 함수 스키마를 통해 모델에 노출합니다. 예:

tools = [

{"name":"run_tests","description":"Execute the test suite and return results","parameters":{}},

{"name":"format_code","description":"Apply black formatter to the code","parameters":{}}

]

response = client.chat.completions.create(

messages=,

functions=tools,

function_call="auto"

)

그러면 Qwen3-Coder는 하나의 세션에서 자율적으로 코드를 생성, 포맷하고 검증하여 수동 통합 오버헤드를 줄일 수 있습니다().

Qwen Code CLI 사용

The qwen-code 명령줄 도구는 에이전트 코딩을 위한 대화형 REPL을 제공합니다.

qwen-code --model qwen3-coder-480b-a35b-instruct

> generate: "Create a REST API in Node.js with JWT authentication."

> tool: install_package(express)

> tool: create_file(app.js)

> tool: run_tests

이 CLI는 투명한 로그를 통해 복잡한 워크플로를 조율하므로 탐색적 프로토타입 제작이나 CI/CD 파이프라인 통합에 이상적입니다.

Qwen3-Coder는 대규모 코드베이스에 적합합니까?

확장된 컨텍스트 윈도우 덕분에 Qwen3-Coder는 패치나 리팩토링을 생성하기 전에 최대 수십만 줄의 코드까지 전체 저장소를 처리할 수 있습니다. 이 기능을 통해 소규모 컨텍스트 모델에서는 따라올 수 없는 글로벌 리팩토링, 모듈 간 분석 및 아키텍처 제안을 수행할 수 있습니다.

Qwen3-Coder의 유용성을 극대화하기 위한 모범 사례는 무엇입니까?

Qwen3-Coder를 효과적으로 도입하려면 CI/CD 파이프라인에 대한 신중한 구성과 통합이 필요합니다.

샘플링과 빔 설정은 어떻게 조정해야 하나요?

- 온도: 균형 잡힌 창의성의 경우 0.6

0.8, 결정론적 리팩토링 작업의 경우 더 낮음(0.20.4). - 상단‑p: 0.7–0.9는 가끔 새로운 제안을 허용하면서 가장 가능성 있는 연속에 집중합니다.

- 탑케이: 표준 사용 시 20

50개, 집중적인 결과물을 원할 경우 510개로 줄이세요. - 반복 페널티: 1.05–1.1은 모델이 보일러플레이트 패턴을 반복하는 것을 방지합니다.

프로젝트의 변동 허용 범위에 맞춰 이러한 매개변수를 실험하면 생산성을 크게 향상시킬 수 있습니다.

Qwen3-Coder를 효과적으로 사용하기 위한 모범 사례는 무엇입니까?

코드 품질을 위한 신속한 엔지니어링

- 구체적으로: 프롬프트에서 언어, 스타일 가이드라인, 원하는 복잡성을 지정합니다.

- 반복적 개선: 모델의 에이전트 기능을 사용하여 생성된 코드를 반복적으로 디버깅하고 최적화합니다.

- 온도 조정: 생성 온도를 낮추십시오(예:

temperature=0.2) 생산 환경에서 보다 결정론적인 결과를 얻으려면.

리소스 활용 관리

- 모델 변형: 프로토타입을 위해 작은 Qwen3-Coder 변형으로 시작한 다음 필요에 따라 확장합니다.

- 동적 양자화: FP8 및 GGUF 양자화 체크포인트를 실험하여 성능을 크게 떨어뜨리지 않고 GPU 메모리 사용량을 줄입니다.

- 비동기 생성: 응답성을 유지하기 위해 장기 실행 코드 생성을 백그라운드 작업자에게 넘깁니다.

이러한 가이드라인을 준수하면 Qwen3-Coder를 소프트웨어 개발 라이프사이클에 통합하여 ROI를 극대화할 수 있습니다.

위의 지침을 따르면(아키텍처 이해, 모델과 Qwen Code CLI 설치 및 구성, 모범 사례 활용) 간단한 코드 조각부터 완전 자율 프로그래밍 에이전트까지 Qwen3-Coder의 잠재력을 최대한 활용할 수 있습니다.