인공지능(AI)은 수많은 산업에 혁명을 일으켰으며, 가장 매력적인 응용 분야 중 하나는 이미지 생성입니다. 사실적인 사람 얼굴을 만드는 것부터 초현실적인 예술 작품을 만드는 것까지, AI 이미지 생성 능력은 예술, 디자인, 그리고 기술 분야에 새로운 지평을 열었습니다. 이 글에서는 AI가 생성하는 이미지의 메커니즘, 이를 구동하는 모델, 그리고 이 기술이 미치는 광범위한 영향을 심층적으로 살펴봅니다.

기본 사항 이해: AI 이미지 생성은 어떻게 작동하나요?

생성 모델이란 무엇인가?

생성 모델은 학습 데이터와 유사한 새로운 데이터 인스턴스를 생성할 수 있는 AI 알고리즘의 한 종류입니다. 이미지 생성 측면에서, 이러한 모델은 기존 이미지에서 패턴을 학습하고 이를 활용하여 새롭고 유사한 이미지를 생성합니다.

신경망의 역할

AI 이미지 생성의 핵심은 신경망, 특히 합성곱 신경망(CNN)과 같은 딥러닝 모델입니다. CNN은 격자 형태의 토폴로지로 데이터를 처리하도록 설계되어 이미지 분석 및 생성에 이상적입니다. CNN은 이미지를 이해하고 재현하는 데 필수적인 에지, 질감, 모양과 같은 패턴을 감지하여 작동합니다.

AI 이미지 생성의 주요 AI 모델

GAN (Generative Adversarial Networks)

2014년 이언 굿펠로우가 도입한 GAN은 생성자와 판별자라는 두 개의 신경망으로 구성됩니다. 생성자는 이미지를 생성하고 판별자는 실제 이미지와 비교하여 이미지를 평가합니다. 이러한 적대적 과정을 통해 생성자는 출력값을 개선하여 더욱 사실적인 이미지를 생성합니다.

스타일

NVIDIA에서 개발한 StyleGAN은 고품질 사람 얼굴을 생성하는 것으로 알려진 GAN 변형입니다. 스타일 기반 생성기 아키텍처를 도입하여 이미지의 다양한 세부 묘사 수준을 제어할 수 있습니다. StyleGAN2와 StyleGAN3은 이미지 품질을 더욱 향상시키고 텍스처 고착과 같은 문제를 해결했습니다.

확산 모델

확산 모델은 무작위 노이즈로 시작하여 원하는 출력에 맞춰 점진적으로 미세 조정하여 이미지를 생성합니다. 이 모델은 고품질 이미지를 생성할 수 있고 다양한 응용 분야에서 유연하게 적용 가능하여 인기를 얻고 있습니다.

안정적인 확산

Stable Diffusion은 텍스트-이미지 생성을 지원하는 오픈소스 확산 모델입니다. 또한 인페인팅(inpainting)과 아웃페인팅(outpainting)을 수행하여 이미지 편집 및 확장을 지원합니다. 오픈소스 특성 덕분에 개발자와 아티스트들이 널리 이용할 수 있습니다.

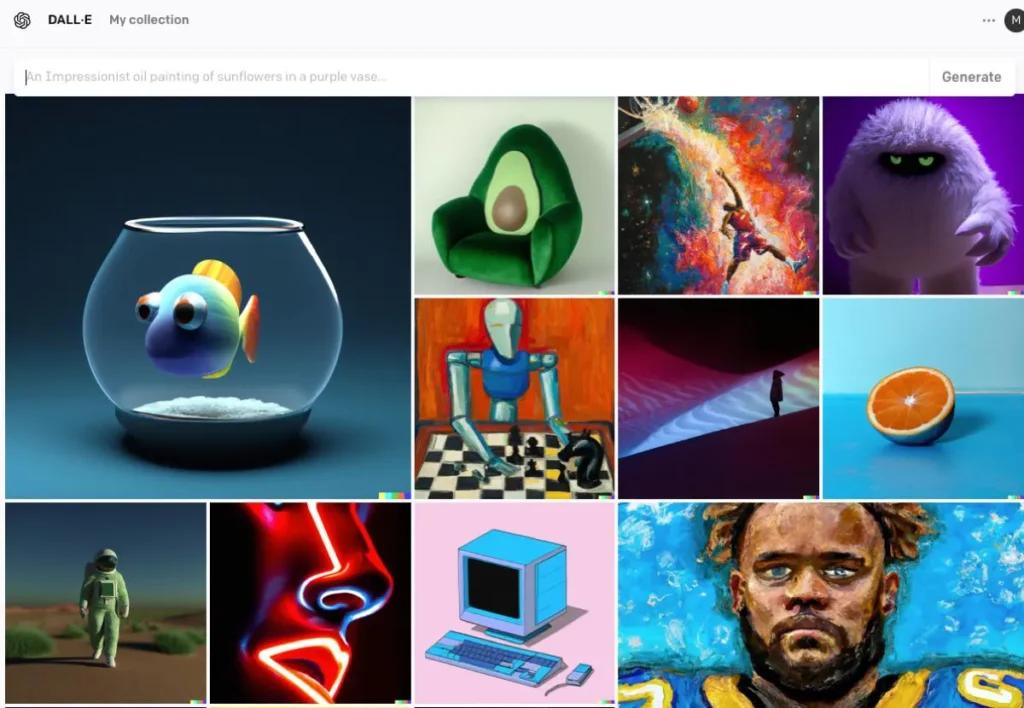

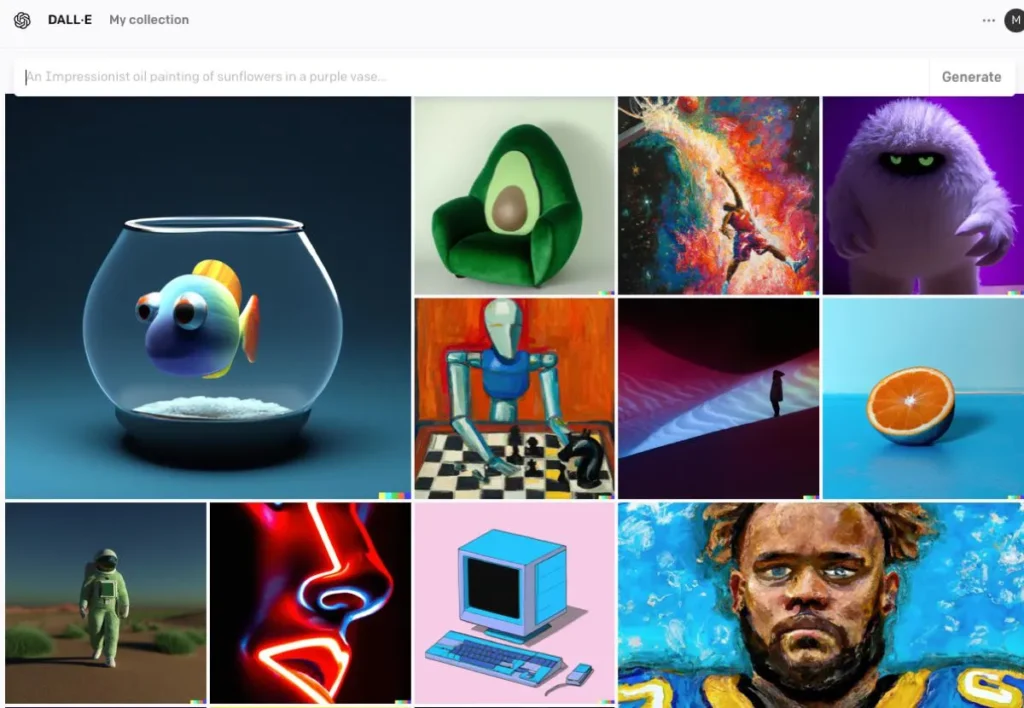

DALL · E

OpenAI에서 개발한 DALL·E는 텍스트 설명으로부터 이미지를 생성할 수 있는 변환기 기반 모델입니다. DALL·E 2와 DALL·E 3는 기존 모델을 개선하여 더 높은 해상도와 더욱 정확한 이미지-텍스트 정렬을 제공합니다. DALL·E 3는 향상된 사용자 상호작용을 위해 ChatGPT에 통합되었습니다.

AI 이미지 생성 프로세스

모델 훈련

AI 모델은 방대한 이미지 데이터셋에 대한 광범위한 학습이 필요합니다. 학습 과정에서 모델은 이미지 내의 패턴과 특징을 인식하는 법을 배우고, 이를 통해 학습 데이터를 모방하는 새로운 이미지를 생성할 수 있습니다.

새로운 이미지 생성

일단 훈련이 완료되면, 모델은 다음과 같은 방법으로 새로운 이미지를 생성할 수 있습니다.

- 입력 받기: 이는 무작위 노이즈(GAN의 경우), 텍스트 프롬프트(DALL·E의 경우), 기존 이미지(편집용)일 수 있습니다. 이 단계에서는 텍스트의 의미적 의미를 포착하여 AI가 콘텐츠와 맥락을 이해할 수 있도록 합니다.

- 입력 처리: 모델은 신경망 계층을 통해 입력을 처리하고 학습된 패턴과 특징을 적용합니다. 인코딩된 텍스트를 사용하여 AI는 생성적 적대 신경망(GAN)이나 확산 모델과 같은 모델을 사용하여 이미지를 생성합니다. 이러한 모델은 무작위 노이즈로 시작하여 텍스트 설명과 일치하도록 이미지를 정제하여 생성합니다.

- 개선 및 평가생성된 이미지는 주의 메커니즘을 사용하여 텍스트와의 일관성을 확보하는 방식으로 개선됩니다. 판별 모델은 이미지의 사실성과 입력 이미지와의 일관성을 평가하여 추가 개선을 위한 피드백을 제공합니다.

- 이미지 출력: 최종 출력은 훈련 데이터의 특성과 제공된 특정 입력을 반영하는 새로운 이미지입니다.

AI 이미지 생성의 코드 예

다음은 세 가지 주요 AI 모델인 생성적 적대 신경망(GAN), 안정적 확산, DALL·E를 사용하여 이미지를 생성하는 방법을 보여주는 실용적인 Python 코드 예제입니다.

PyTorch를 활용한 생성적 적대 신경망(GAN)

생성적 적대 신경망(GAN)은 생성자(Generator)와 판별자(Discriminator)라는 두 개의 신경망으로 구성되어 있으며, 서로 경쟁하여 새롭고 현실적인 데이터 인스턴스를 생성합니다. 다음은 PyTorch를 사용하여 이미지를 생성하는 간단한 예입니다.

pythonimport torch

import torch.nn as nn

# Define the Generator network

class Generator(nn.Module):

def __init__(self):

super(Generator, self).__init__()

self.fc1 = nn.Linear(100, 128)

self.fc2 = nn.Linear(128, 784) # Assuming output image size is 28x28

def forward(self, x):

x = torch.relu(self.fc1(x))

x = torch.tanh(self.fc2(x))

return x

# Instantiate the generator

generator = Generator()

# Generate a random noise vector

noise = torch.randn(1, 100)

# Generate an image

generated_image = generator(noise)

이 코드는 100차원 노이즈 벡터를 입력으로 받아 784차원 출력을 생성하는 간단한 생성기 네트워크를 정의합니다. 이 출력은 28×28 이미지로 재구성될 수 있습니다. tanh 활성화 함수는 출력 값이 이미지 데이터에서 일반적인 범위에 있도록 보장합니다.

허깅 페이스 디퓨저를 사용한 안정적인 확산

Stable Diffusion은 텍스트 설명을 기반으로 이미지를 생성하는 강력한 텍스트-이미지 변환 모델입니다. 껴안는 얼굴 diffusers 라이브러리는 이 모델을 사용하기 위한 쉬운 인터페이스를 제공합니다.

pythonfrom diffusers import StableDiffusionPipeline

import torch

# Load the pre-trained Stable Diffusion model

pipe = StableDiffusionPipeline.from_pretrained("CompVis/stable-diffusion-v1-4")

pipe = pipe.to("cuda") # Move the model to GPU for faster inference

# Generate an image from a text prompt

prompt = "A serene landscape with mountains and a river"

image = pipe(prompt).images

# Save the generated image

image.save("generated_image.png")

이 스크립트는 안정 확산 모델을 로드하고 제공된 프롬프트에 따라 이미지를 생성합니다. 최적의 성능을 위해 필요한 종속성이 설치되어 있고 호환되는 GPU가 있는지 확인하세요.

OpenAI API를 활용한 DALL·E

DALL·E는 OpenAI에서 개발한 또 다른 텍스트-이미지 변환 모델입니다. OpenAI의 API를 사용하여 상호작용할 수 있습니다.

pythonimport openai

import requests

from PIL import Image

from io import BytesIO

# Set your OpenAI API key

openai.api_key = "your-api-key"

# Generate an image using DALL·E

response = openai.Image.create(

prompt="A futuristic cityscape at sunset",

n=1,

size="512x512"

)

# Get the URL of the generated image

image_url = response

# Download and display the image

image_response = requests.get(image_url)

image = Image.open(BytesIO(image_response.content))

image.save("dalle_generated_image.png")

교체 "your-api-key" 실제 OpenAI API 키와 함께 사용합니다. 이 스크립트는 DALL·E 모델에 프롬프트를 전송하고 생성된 이미지를 가져옵니다. 그런 다음 이미지는 로컬에 저장됩니다.

CometAPI는 또한 통합합니다 DALL-E 3 API, CometAPI의 키를 사용하여 액세스할 수도 있습니다. DALL-E 3 APIOpenAI보다 편리하고 빠릅니다.

Comet API의 자세한 모델 정보는 다음을 참조하세요. API doc.

이 예시들은 다양한 AI 모델을 사용하여 이미지를 생성하는 시작점을 제공합니다. 각 모델은 고유한 기능과 요구 사항을 가지고 있으므로 프로젝트의 요구에 가장 적합한 모델을 선택하십시오.

결론

AI 이미지 생성은 기술과 창의성의 교차점에 위치하며, 시각 콘텐츠 제작에 전례 없는 가능성을 제공합니다. AI가 이미지를 생성하는 방식, 관련 모델, 그리고 이 기술이 사회의 다양한 측면에 어떻게 통합되는지 이해하는 것은 필수적입니다.

CometAPI에서 AI 이미지 API에 액세스

CometAPI는 채팅, 이미지, 코드 등을 위한 오픈소스 및 특수 멀티모달 모델을 포함하여 500개 이상의 AI 모델에 대한 액세스를 제공합니다. CometAPI의 주요 강점은 기존의 복잡한 AI 통합 프로세스를 간소화하는 것입니다. Claude, OpenAI, Deepseek, Gemini와 같은 주요 AI 도구에 대한 액세스를 단일 통합 구독을 통해 이용할 수 있습니다. CometAPI의 API를 사용하여 음악 및 아트워크를 제작하고, 비디오를 제작하고, 자신만의 워크플로를 구축할 수 있습니다.

코멧API 공식 가격보다 훨씬 낮은 가격을 제공하여 통합을 돕습니다. GPT-4o API ,중간 여정 API 안정 확산 API(안정된 확산 XL 1.0 API) 및 Flux API(FLUX.1 API 등)을 입력하고 등록하고 로그인하면 계정에 1달러가 적립됩니다!

CometAPI는 최신 기능을 통합합니다. GPT-4o-이미지 API .