그록-코드-패스트-1 xAI의 것입니다 속도 중심, 비용 효율적인 에이전트 코딩 모델 IDE 통합 및 자동화된 코딩 에이전트를 구동하도록 설계되었습니다. 낮은 대기 시간, 대리인 행동 (도구 호출, 단계별 추론 추적) 및 일상적인 개발자 워크플로를 위한 간결한 비용 프로필.

주요 기능(한눈에 보기)

- 높은 처리량 / 낮은 지연 시간: IDE 사용을 위한 매우 빠른 토큰 출력과 빠른 완성에 중점을 두었습니다.

- 에이전트 함수 호출 및 툴링: 다단계 코딩 에이전트를 활성화하기 위해 함수 호출과 외부 도구 오케스트레이션(테스트 실행, 린터, 파일 가져오기)을 지원합니다.

- 큰 컨텍스트 창: 대규모 코드베이스와 다중 파일 컨텍스트를 처리하도록 설계되었습니다(공급자는 마켓플레이스 어댑터에서 256k 컨텍스트 창을 나열합니다).

- 눈에 보이는 추론 / 흔적: 응답에는 에이전트의 결정을 검사하고 디버깅할 수 있도록 하는 단계별 추론 추적이 포함될 수 있습니다.

기술적 세부 사항

건축 및 교육: xAI는 grok-code-fast-1이 새로운 아키텍처와 풍부한 프로그래밍 콘텐츠가 포함된 사전 학습 코퍼스를 기반으로 처음부터 구축되었다고 밝혔습니다. 이후 모델은 고품질의 실제 풀 리퀘스트/코드 데이터셋을 기반으로 학습 후 큐레이션을 거쳤습니다. 이 엔지니어링 파이프라인은 모델을 실용적인 에이전트 워크플로우 내부 (IDE + 도구 사용).

제공 및 컨텍스트: grok-code-fast-1 일반적인 사용 패턴은 스트리밍 출력, 함수 호출, 그리고 풍부한 컨텍스트 주입(파일 업로드/수집)을 가정합니다. 여러 클라우드 마켓플레이스와 플랫폼 어댑터는 이미 대규모 컨텍스트 지원(일부 어댑터에서는 25만 6천 개의 컨텍스트 지원)을 제공합니다.

사용성 특징: 명백한 추론 흔적 (모델은 계획/도구 사용법을 표면화하고), 신속한 엔지니어링 지침과 예시 통합, 조기 출시 파트너 통합(예: GitHub Copilot, Cursor)을 제공합니다.

벤치마크 성능(점수)

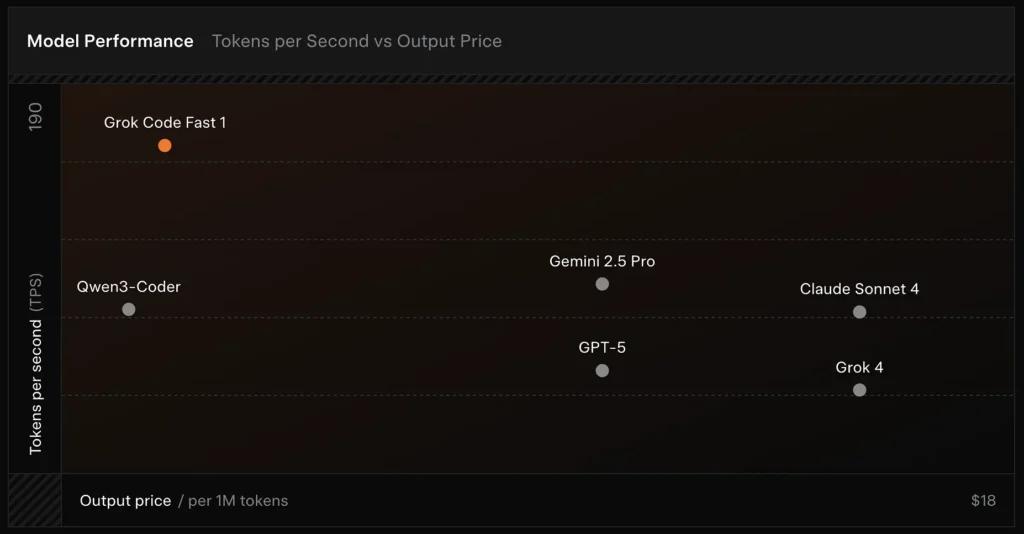

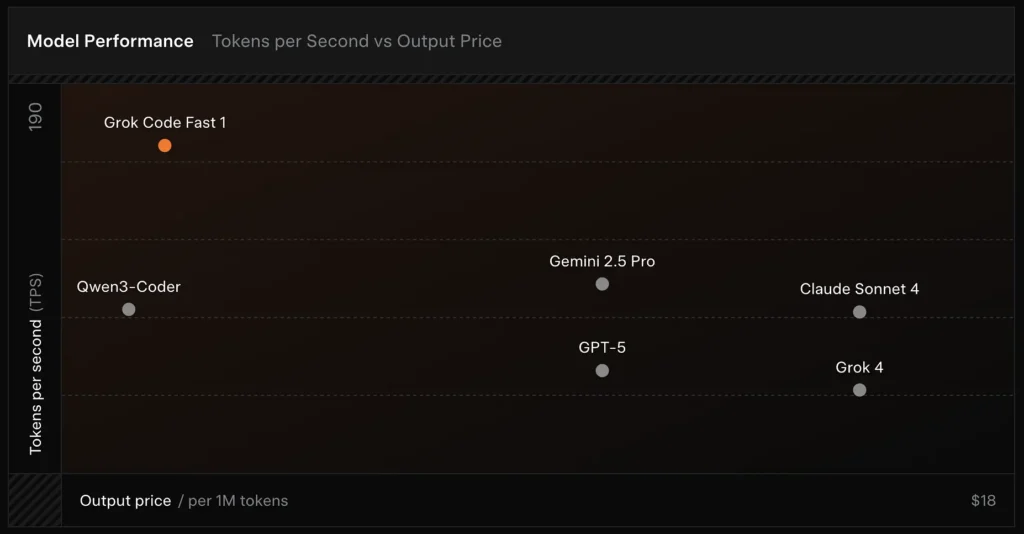

SWE-Bench-Verified: xAI는 다음을 보고합니다. 70.8% SWE-Bench-Verified 하위 집합(소프트웨어 엔지니어링 모델 비교에 일반적으로 사용되는 벤치마크)에 대한 내부 하네스 점수. 최근 실습 평가에서 보고된 바에 따르면 평균 인간 평가 ≈ 7.6 혼합 코딩 제품군에서는 일부 고부가가치 모델(예: Gemini 2.5 Pro)과 경쟁하지만, 난이도가 높은 추론 과제에서는 Claude Opus 4나 xAI 자체 Grok 4와 같은 대규모 멀티모달/"최고 추론 모델"보다 뒤처집니다. 벤치마크 결과는 과제별로 차이를 보이는데, 일반적인 버그 수정 및 간결한 코드 생성에는 우수하지만, 특정 분야 또는 라이브러리 관련 문제(예: Tailwind CSS)에서는 취약합니다.

비교 :

- vs Grok 4: Grok-code-fast-1은 절대적인 정확성과 더 깊은 추론을 교환합니다. 훨씬 낮은 비용과 더 빠른 처리량; Grok 4는 여전히 더 높은 성능의 옵션입니다.

- vs 클로드 오푸스 / GPT급: 이러한 모델은 종종 복잡하고 창의적이거나 어려운 추론 작업을 주도합니다. Grok-code-fast-1은 지연 시간과 비용이 중요한 대량의 일상적인 개발자 작업에서 우수한 경쟁력을 갖습니다.

제한 사항 및 위험

지금까지 관찰된 실제적 한계:

- 도메인 갭: 틈새 라이브러리나 특이하게 정의된 문제에서 성능이 저하되는 경우(예: Tailwind CSS의 예외 사례).

- 추론 토큰 비용 상쇄: 모델이 내부 추론 토큰을 방출할 수 있기 때문에, 높은 수준의 에이전트적/자세한 추론은 추론 출력 길이(및 비용)를 늘릴 수 있습니다.

- 정확도/에지 케이스: Grok-code-fast-1은 일상적인 작업에 강력하면서도 환각 또는 새로운 알고리즘이나 적대적인 문제 진술에 대해 잘못된 코드를 생성할 수 있으며, 까다로운 알고리즘 벤치마크에서 추론에 중점을 둔 최고의 모델보다 성능이 떨어질 수 있습니다.

일반적인 사용 사례

- IDE 지원 및 신속한 프로토타입 제작: 빠른 완성, 증분 코드 작성, 대화형 디버깅.

- 자동화된 에이전트/코드 워크플로: 테스트를 조율하고, 명령을 실행하고, 파일을 편집하는 에이전트(예: CI 도우미, 봇 검토자).

- 일상적인 엔지니어링 작업: 낮은 지연 시간으로 개발자 흐름을 실질적으로 개선하는 코드 스켈레톤, 리팩터링, 버그 분류 제안 및 다중 파일 프로젝트 스캐폴딩을 생성합니다.

CometAPI에서 grok-code-fast-1 API를 호출하는 방법

grok-code-fast-1 CometAPI의 API 가격 책정, 공식 가격 대비 20% 할인:

- 입력 토큰: $0.16/M 토큰

- 출력 토큰: $2.0/M 토큰

필수 단계

- 에 로그인 코메타피닷컴. 아직 당사 사용자가 아니신 경우 먼저 등록해 주시기 바랍니다.

- 인터페이스의 액세스 자격 증명 API 키를 받으세요. 개인 센터의 API 토큰에서 "토큰 추가"를 클릭하고 토큰 키(sk-xxxxx)를 받아 제출하세요.

사용 방법

- "

grok-code-fast-1API 요청을 전송하고 요청 본문을 설정하는 엔드포인트입니다. 요청 메서드와 요청 본문은 웹사이트 API 문서에서 확인할 수 있습니다. 웹사이트에서는 사용자의 편의를 위해 Apifox 테스트도 제공합니다. - 바꾸다 귀하 계정의 실제 CometAPI 키를 사용합니다.

- 질문이나 요청을 콘텐츠 필드에 입력하세요. 모델이 이에 응답합니다.

- . API 응답을 처리하여 생성된 답변을 얻습니다.

CometAPI는 완벽한 호환성을 갖춘 REST API를 제공하여 원활한 마이그레이션을 지원합니다. 주요 세부 정보는 다음과 같습니다. API doc:

- 기본 URL: https://api.cometapi.com/v1/chat/completions

- 모델명 : "

grok-code-fast-1" - 입증: 베어러 토큰을 통해

Authorization: Bearer YOUR_CometAPI_API_KEY머리글 - 컨텐츠 타입:

application/json.

API 통합 및 예제

Python 스니펫 채팅 완료 CometAPI를 통해 호출:

pythonimport openai

openai.api_key = "YOUR_CometAPI_API_KEY"

openai.api_base = "https://api.cometapi.com/v1/chat/completions"

messages = [

{"role": "system", "content": "You are a helpful assistant."},

{"role": "user", "content": "Summarize grok-code-fast-1's main features."}

]

response = openai.ChatCompletion.create(

model="grok-code-fast-1",

messages=messages,

temperature=0.7,

max_tokens=500

)

print(response.choices.message)

도 참조 그록 4