Zhipu AI(Z.ai)에서 개발한 GLM-4.5 시리즈는 오픈 소스 대규모 언어 모델(LLM) 분야에서 상당한 발전을 이루었습니다. 추론, 코딩 및 에이전트 기능을 통합하도록 설계된 GLM-4.5는 다양한 애플리케이션에서 강력한 성능을 제공합니다. 이 가이드는 개발자, 연구자 또는 전문가 등 누구에게나 GLM-4.5 시리즈에 효과적으로 접근하고 활용하는 방법에 대한 자세한 정보를 제공합니다.

GLM-4.5 시리즈는 무엇이고 왜 중요한가요?

GLM-4.5는 두 가지 모드를 결합한 하이브리드 추론 모델입니다. 복잡한 추론 및 도구 사용을 위한 "사고 모드"와 즉각적인 반응을 위한 "비사고 모드"입니다. 이러한 이중 모드 접근 방식을 통해 모델은 다양한 작업을 효율적으로 처리할 수 있습니다. 이 시리즈는 두 가지 주요 변형으로 구성됩니다.

- GLM-4.5: 총 355억 개의 매개변수와 32억 개의 활성 매개변수를 특징으로 하는 이 모델은 추론, 생성 및 다중 에이전트 작업 전반에 걸친 대규모 배포를 위해 설계되었습니다.

- GLM-4.5-에어: 총 106억 개의 매개변수와 12억 개의 활성 매개변수를 갖춘 경량 버전으로, 핵심 기능을 희생하지 않고도 온디바이스 및 소규모 클라우드 추론에 최적화되었습니다.

두 모델 모두 하이브리드 추론 모드를 지원하여 복잡한 추론 작업과 빠른 대응의 균형을 맞추기 위해 "사고" 모드와 "비사고" 모드를 제공합니다. 이 두 모델은 오픈 소스이며 MIT 라이선스에 따라 배포되므로 상업적 사용과 2차 개발이 가능합니다.

건축 및 디자인 원칙

GLM-4.5는 핵심적으로 MoE를 활용하여 특수 전문가 하위 네트워크를 통해 토큰을 동적으로 라우팅하여 탁월한 매개변수 효율성과 확장 동작을 구현합니다(). 이러한 접근 방식은 순방향 패스당 활성화해야 하는 매개변수 수를 줄여 추론 및 코딩 작업에서 최첨단 성능을 유지하면서 운영 비용을 절감합니다().

주요 기능

- 하이브리드 추론 및 코딩: GLM-4.5는 자연어 이해 벤치마크와 코드 생성 테스트에서 SOTA 성능을 입증했으며, 정확도와 유창성 면에서 독점 모델과 경쟁하는 경우가 많았습니다.

- 에이전트 통합: 내장된 도구 호출 인터페이스를 통해 GLM-4.5는 단일 세션 내에서 데이터베이스 쿼리, API 오케스트레이션, 대화형 프런트엔드 생성과 같은 다단계 워크플로를 조율할 수 있습니다.

- 다중 모달 아티팩트: HTML/CSS 미니 앱부터 Python 기반 시뮬레이션과 대화형 SVG까지 GLM-4.5는 완벽한 기능을 갖춘 아티팩트를 출력하여 사용자 참여와 개발자 생산성을 향상시킵니다.

GLM-4.5가 게임 체인저인 이유는 무엇인가?

GLM-4.5는 뛰어난 성능뿐만 아니라 기업과 연구 환경에서 오픈소스 LLM의 가치 제안을 새롭게 정의했다는 점에서도 칭찬을 받았습니다.

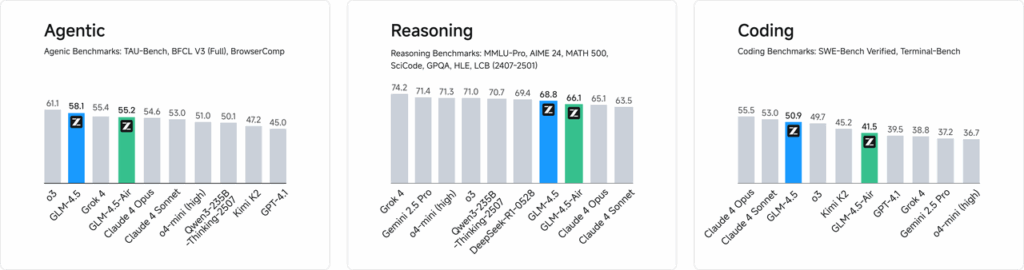

성능 벤치 마크

웹 개발, 데이터 분석, 자동화를 아우르는 52개 프로그래밍 작업에 대한 독립적인 평가에서 GLM-4.5는 도구 호출 안정성과 전반적인 작업 완료도 측면에서 다른 주요 오픈소스 모델들을 지속적으로 능가했습니다. Claude Code, Kimi-K2, Qwen3-Coder와의 비교 테스트에서 GLM-4.5는 "SWE-bench Verified" 리더보드와 같은 벤치마크에서 동급 최고 점수를 달성했습니다.

비용 효율성

GLM-4.5의 MoE 설계는 정확성을 넘어 추론 비용을 획기적으로 절감합니다. API 호출에 대한 공개 가격은 입력 토큰 백만 개당 0.8위안, 출력 토큰 백만 개당 2위안으로, 동급 독점 서비스 비용의 약 100분의 XNUMX 수준입니다. 초당 XNUMX개의 토큰을 생성하는 최대 속도와 더불어, 이 모델은 과도한 비용 없이 높은 처리량과 낮은 지연 시간의 배포를 지원합니다.

GLM-4.5에 어떻게 접속할 수 있나요?

1. Z.ai 플랫폼을 통한 직접 접근

GLM-4.5와 상호작용하는 가장 간단한 방법은 Z.ai 플랫폼을 이용하는 것입니다. chat.z.ai사용자는 GLM-4.5 모델을 선택하고 사용자 친화적인 인터페이스를 통해 상호작용을 시작할 수 있습니다. 이 플랫폼을 사용하면 복잡한 통합 없이 즉시 테스트하고 프로토타입을 제작할 수 있습니다. 사용자는 왼쪽 상단에서 GLM-4.5 또는 GLM-4.5-Air 모델을 선택하고 즉시 채팅을 시작할 수 있습니다. 이 인터페이스는 사용자 친화적이며 별도의 설정이 필요하지 않아 빠른 상호작용 및 데모에 이상적입니다.

2. 개발자를 위한 API 접근

GLM-4.5를 애플리케이션에 통합하려는 개발자를 위해 Z.ai API 플랫폼은 포괄적인 지원을 제공합니다. 이 API는 GLM-4.5 및 GLM-4.5-Air 모델 모두에 OpenAI 호환 인터페이스를 제공하여 기존 워크플로와의 원활한 통합을 지원합니다. 자세한 문서 및 통합 지침은 다음에서 확인할 수 있습니다. Z.ai API 문서 .

3. 오픈소스 배포

로컬 배포에 관심이 있는 분들을 위해 Hugging Face 및 ModelScope와 같은 플랫폼에서 GLM-4.5 모델을 사용할 수 있습니다. 이 모델은 MIT 오픈 소스 라이선스에 따라 배포되므로 상업적 사용 및 XNUMX차 개발이 가능합니다. vLLM 및 SGLang과 같은 주류 추론 프레임워크와 통합할 수 있습니다.

4. CometAPI와의 통합

코멧API 통합 API 플랫폼을 통해 GLM-4.5 모델에 대한 간소화된 액세스를 제공합니다. 다스보라드이 통합은 인증, 속도 제한 및 오류 처리를 간소화하여 번거로움 없는 설정을 원하는 개발자에게 탁월한 선택입니다. 또한, CometAPI의 표준화된 API 형식을 통해 GLM-4.5와 다른 사용 가능한 모델 간의 간편한 모델 전환 및 A/B 테스트가 가능합니다.

개발자는 GLM-4.5 시리즈에 어떻게 액세스할 수 있나요?

GLM-4.5를 얻고 배포하는 데에는 직접 모델을 다운로드하는 것부터 관리되는 API까지 다양한 채널이 있습니다.

Hugging Face와 ModelScope를 통해

Hugging Face와 ModelScope는 모두 zai-org 네임스페이스에서 전체 GLM-4.5 시리즈를 호스팅합니다. MIT 라이선스에 동의하면 개발자는 다음을 수행할 수 있습니다.

- 저장소 복제:

git clone https://huggingface.co/zai-org/GLM-4.5

- 종속성 설치:

pip install transformers accelerate

- 모델 로드:

from transformers import AutoModelForCausalLM, AutoTokenizer

tokenizer = AutoTokenizer.from_pretrained("zai-org/GLM-4.5")

model = AutoModelForCausalLM.from_pretrained("zai-org/GLM-4.5")

``` :contentReference{index=15}.

CometAPI를 통해

코멧API 서버리스 API를 제공합니다 GLM‑4.5 및 GLM-4.5 에어 API 토큰당 지불 요금으로 OpenAI 호환 엔드포인트를 구성하여 기존 코드베이스를 최소한으로 조정하여 OpenAI의 Python 클라이언트를 통해 GLM-4.5를 호출할 수 있습니다. CometAPI는 GLM4.5와 GLM-4.5-air뿐만 아니라 모든 공식 모델도 제공합니다.

| 모델 이름 | 소개 | 가격 |

glm-4.5 | 355억 개의 매개변수를 갖춘 가장 강력한 추론 모델 | 입력 토큰 $0.48 출력 토큰 $1.92 |

glm-4.5-air | 비용 효율적인 경량 강력한 성능 | 입력 토큰 $0.16 출력 토큰 $1.07 |

glm-4.5-x | 고성능 강력한 추론 초고속 응답 | 입력 토큰 $1.60 출력 토큰 $6.40 |

glm-4.5-airx | 가볍고 강력한 성능 초고속 응답 | 입력 토큰 $0.02 출력 토큰 $0.06 |

glm-4.5-flash | 추론 코딩 및 에이전트에 적합한 강력한 성능 | 입력 토큰 $3.20 출력 토큰 $12.80 |

Python 및 REST API 통합

맞춤형 배포의 경우, 조직은 Docker 또는 Kubernetes를 사용하여 전용 GPU 클러스터에 GLM-4.5를 호스팅할 수 있습니다. 일반적인 RESTful 설정은 다음과 같습니다.

추론 서버 실행:

bashdocker run -p 8000:8000 zai-org/glm-4.5:latest

요청 보내기:

bashcurl -X POST http://localhost:8000/generate \ -H "Content-Type: application/json" \ -d '{"prompt": "Translate to French: Hello.", "max_tokens": 50}' Responses conform to the JSON formats used by popular LLM APIs .

애플리케이션에 GLM-4.5를 통합하는 모범 사례는 무엇입니까?

ROI를 극대화하고 강력한 성과를 보장하려면 팀은 다음 사항을 고려해야 합니다.

API 최적화 및 속도 제한

- 일괄 요청: 유사한 프롬프트를 그룹화하여 오버헤드를 줄이고 GPU 처리량을 활용합니다.

- 일반 쿼리 캐싱: 중복된 추론 호출을 방지하기 위해 자주 완료되는 항목을 로컬에 저장합니다.

- 적응형 샘플링: 동적으로 조정

temperature및top_p창의성과 결정론의 균형을 맞추기 위해 쿼리 복잡성을 기반으로 합니다.

컴플라이언스

- 데이터 살균: 모델로 전송하기 전에 민감한 정보를 제거하기 위해 입력을 사전 처리합니다.

- 컨트롤에 액세스: API 키, IP 허용 목록, 속도 제한을 구현하여 오용 및 남용을 방지합니다.

- 감사 로깅: 특히 금융이나 의료 분야에서 기업 및 규제 요구 사항을 준수하기 위해 프롬프트, 완료 및 메타데이터를 기록합니다.

시작 가이드

CometAPI는 OpenAI의 GPT 시리즈, Google의 Gemini, Anthropic의 Claude, Midjourney, Suno 등 주요 공급업체의 500개 이상의 AI 모델을 단일 개발자 친화적인 인터페이스로 통합하는 통합 API 플랫폼입니다. CometAPI는 일관된 인증, 요청 형식 지정 및 응답 처리를 제공하여 애플리케이션에 AI 기능을 통합하는 과정을 획기적으로 간소화합니다. 챗봇, 이미지 생성기, 음악 작곡가 또는 데이터 기반 분석 파이프라인 등 어떤 제품을 구축하든 CometAPI를 사용하면 AI 생태계 전반의 최신 혁신 기술을 활용하면서 반복 작업을 더 빠르게 수행하고 비용을 관리하며 공급업체에 구애받지 않을 수 있습니다.

GLM-4.5를 애플리케이션에 통합하려는 개발자에게 CometAPI 플랫폼은 강력한 솔루션을 제공합니다. 이 API는 OpenAI 호환 인터페이스를 제공하여 기존 워크플로에 원활하게 통합할 수 있습니다. 자세한 설명서와 사용 지침은 다음에서 확인할 수 있습니다. Comet API 페이지.

개발자는 액세스할 수 있습니다 GLM‑4.5 및 GLM-4.5 에어 API 을 통하여 코멧API, 나열된 최신 모델 버전은 기사 발행일을 기준으로 합니다. 시작하려면 모델의 기능을 살펴보세요. 운동장 그리고 상담하십시오 API 가이드 자세한 내용은 CometAPI를 참조하세요. 접속하기 전에 CometAPI에 로그인하고 API 키를 발급받았는지 확인하세요. 코멧API 공식 가격보다 훨씬 낮은 가격을 제공하여 통합을 돕습니다.

결론

GLM-4.5는 대규모 언어 모델 분야에서 상당한 발전을 이루었으며, 다양한 애플리케이션에 다재다능한 솔루션을 제공합니다. 하이브리드 추론 아키텍처, 에이전트 기능, 그리고 오픈 소스라는 특성은 고급 AI 기술을 활용하고자 하는 개발자와 조직에게 매력적인 옵션입니다. 본 가이드에 설명된 다양한 접근 방법을 활용하여 사용자는 GLM-4.5를 프로젝트에 효과적으로 통합하고 지속적인 개발에 기여할 수 있습니다.