AI는 빠르게 발전하고 있습니다. 새로운 멀티모달 모델과 향상된 실시간 API 덕분에 강력한 AI를 자동화 플랫폼에 쉽게 내장할 수 있게 되었고, 안전성과 가시성에 대한 논의는 팀의 프로덕션 시스템 운영 방식을 변화시키고 있습니다. 로컬 자동화를 구축하는 사람들에게는 통합 모델 게이트웨이(예: 코멧API) 많은 모델에 액세스하고 해당 모델 호출을 자체 호스팅 자동화 실행기(예: n8n) 데이터, 지연 시간 및 비용을 제어할 수 있습니다. 이 가이드에서는 시작하는 방법을 단계별로 보여줍니다. CometAPI + n8n(로컬), 주의해야 할 점, 그리고 일이 잘못되었을 때 문제를 해결하는 방법에 대해 설명합니다.

n8n이란 무엇이고 AI 자동화에 왜 중요한가요?

n8n은 시각적 편집기와 대규모 노드(커넥터) 생태계를 갖춘 오픈소스 워크플로 자동화 도구입니다. 트리거, 변환 및 외부 API 호출을 반복 가능한 워크플로(웹훅, 예약된 작업, 파일 처리, 챗봇 등)로 연결할 수 있도록 설계되었습니다. n8n을 로컬에 자체 호스팅하면 데이터 상주 및 실행을 완벽하게 제어할 수 있으며, 이는 민감한 입력을 처리하는 타사 AI 모델을 호출할 때 특히 유용합니다.

n8n은 실제로 어떻게 작동하나요?

- 트리거(Webhook, Cron)와 작업 노드(HTTP 요청, 데이터베이스 노드, 이메일)가 포함된 시각적 캔버스입니다.

- 커뮤니티 노드는 기능을 확장합니다. 즉, 커뮤니티 패키지를 설치하고 네이티브 노드처럼 처리할 수 있습니다.

셀프호스팅 n8n은 다음과 같은 이점을 제공합니다.

- 전체 데이터 제어 — 워크플로와 실행 데이터는 관리하는 인프라에 보관됩니다.

- 맞춤설정으로 들어간다 — 클라우드 기능을 기다리지 않고도 개인 노드나 로컬 통합을 추가할 수 있습니다.

- 비용 예측 가능성 — 내부 자동화가 심화되어도 작업별 클라우드 청구에 대한 예상치 못한 일이 발생하지 않습니다.

- 보안 및 규정 준수 — 내부 정책 및 규제 요구 사항을 충족하기가 더 쉽습니다.

CometAPI란 무엇이고, 왜 이를 모델 게이트웨이로 사용해야 합니까?

코멧API 는 단일 OpenAI 호환 인터페이스 및 청구 모델 뒤에 수백 개의 타사 AI 모델(텍스트, 임베딩, 이미지 생성 등)을 제공하는 통합 API 게이트웨이입니다. 즉, 시도하려는 모든 LLM 또는 이미지 엔진에 맞춤형 통합을 추가하는 대신, 하나의 API를 호출하고 요청에서 원하는 모델을 선택하면 됩니다. 이를 통해 실험, 비용 관리 및 운영 통합이 간소화됩니다.

은혜:

- 모델 선택: 동일한 코드 경로를 사용하는 여러 공급업체/모델을 시도해 보세요.

- 토큰 풀링/무료 할당량: 많은 통합 게이트웨이는 실험을 위한 크레딧/티어를 제공합니다.

- 더 간단한 인프라: 하나의 인증 시스템과 하나의 기본 URL을 관리합니다.

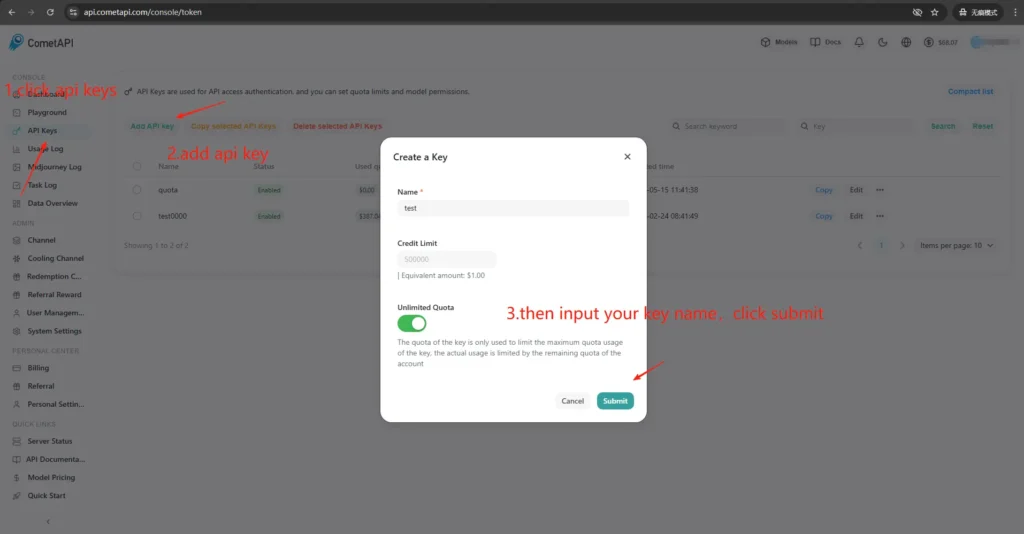

CometAPI 액세스 및 키는 어떻게 얻을 수 있나요?

- 가입하기 CometAPI 사이트(또는 공급업체 대시보드)에서 확인할 수 있습니다. 대부분의 게이트웨이는 무료 체험판을 제공합니다.

- API 키 받기 CometAPI 대시보드에서 긴 비밀 문자열을 생성합니다. 문서에서 어디에 배치하라고 하는지 확인하세요(CometAPI는 Bearer 인증을 사용합니다).

https://api.cometapi.com/v1). - API 문서를 읽어보세요 사용하려는 엔드포인트(채팅 완성, 이미지, 임베딩)에 대해 CometAPI는 다음과 같은 엔드포인트를 문서화합니다.

/v1/chat/completions및/v1/images/generations.

n8n과 CometAPI의 본딩(통합)이 중요한 이유는 무엇입니까?

여기서 "본딩"이란 자동화 러너(n8n)와 모델 게이트웨이 간의 안정적이고 안전한 통합 경로를 의미합니다. 적절한 본딩은 다음과 같은 이유로 중요합니다.

- 그것은 보존한다 문맥 통화(대화 기록, 임베딩)

- 중앙집중화합니다 신임장 더 안전한 교환을 위해 비밀이 한곳에 모여 있습니다.

- 예측 가능한 엔드포인트와 표준 요청 형식을 사용하여 대기 시간과 오류 표면을 줄입니다.

- 그것은 가능하게한다 관찰 성 문제 해결 - 어떤 모델, 프롬프트, 대응이 결과를 가져왔는지 아는 것.

간단히 말해서, 좋은 본딩은 운영상의 위험을 낮추고 반복작업을 빠르게 진행시킵니다.

n8n을 로컬에 배포하려면 어떻게 해야 하나요(빠른 실용 가이드)?

로컬로 n8n을 실행할 수 있습니다. npm 또는 Docker를 사용할 수 있습니다. Docker Compose는 대부분의 셀프 호스팅 시나리오에 권장되는 접근 방식입니다(재현 가능하고 종속성을 격리합니다). 아래는 Docker Compose의 최소 예시와 주요 참고 사항입니다.

Docker로 n8n을 셀프 호스팅하려면 어떻게 해야 하나요?

Docker(및 Docker Compose)는 n8n을 프로덕션 환경에서 실행하는 가장 강력하고 반복 가능한 방법입니다. 앱을 분리하고, 업그레이드를 간소화하며, 역방향 프록시 및 오케스트레이터(Docker Swarm, Kubernetes)와 잘 연동됩니다. n8n 공식 문서에는 Docker Compose 참조 자료가 포함되어 있으며, 여기에서는 이 자료를 참고하여 수정하겠습니다.

생산을 위해서는 일반적으로 다음으로 구성된 스택을 실행합니다.

- n8n 서비스(공식 이미지:

docker.n8n.io/n8nio/n8norn8nio/n8n(태그에 따라 다름). - PostgreSQL(또는 지원되는 다른 DB).

- Redis(큐 모드를 사용할 계획인 경우).

- TLS, 호스트 라우팅 및 속도 제한 규칙을 위한 역방향 프록시(Traefik, Caddy 또는 nginx)

이 아키텍처는 DB 지속성, 큐잉, 웹 프록시 등의 문제를 명확하게 분리하고 확장 및 백업을 간편하게 만듭니다. 공식 n8n 문서에서는 Docker Compose 패턴과 환경 변수 참조를 제공합니다.

단계별 가이드입니다.

- 폴더를 만들고

docker-compose.yml정식 n8n 서비스를 사용합니다. 아래는 일반적인 운영 환경 요구 사항(외부 Postgres, Redis(대기열/실행 모드), 영구 볼륨, TLS를 처리하는 Nginx 역방향 프록시)을 모두 포함하는 실용적인 docker-compose 예제입니다.

```yaml

version: "3.8"

services:

n8n:

image: n8nio/n8n:latest

restart: unless-stopped

environment:

- DB_TYPE=postgresdb

- DB_POSTGRESDB_HOST=postgres

- DB_POSTGRESDB_PORT=5432

- DB_POSTGRESDB_DATABASE=n8n

- DB_POSTGRESDB_USER=n8n

- DB_POSTGRESDB_PASSWORD=supersecretpassword

- N8N_BASIC_AUTH_ACTIVE=true

- N8N_BASIC_AUTH_USER=admin

- N8N_BASIC_AUTH_PASSWORD=anothersecret

- WEBHOOK_TUNNEL_URL=https://n8n.example.com

- EXECUTIONS_MODE=queue

- QUEUE_BULL_REDIS_HOST=redis

ports:

- "5678:5678"

volumes:

- n8n_data:/home/node/.n8n

depends_on:

- postgres

- redis

postgres:

image: postgres:15

environment:

POSTGRES_DB: n8n

POSTGRES_USER: n8n

POSTGRES_PASSWORD: supersecretpassword

volumes:

- pgdata:/var/lib/postgresql/data

redis:

image: redis:7

volumes:

- redisdata:/data

volumes:

n8n_data:

pgdata:

redisdata:

2. 시작

docker compose up -d

3. 방문 `http://localhost:5678` 관리자 사용자를 생성하세요. 운영 환경에서는 Postgres, SSL, 그리고 적절한 환경 변수가 필요합니다. Docker Compose 공식 문서를 참조하세요.

**참고사항 및 강화:**

- Do **지원** 비밀을 평문으로 저장 `docker-compose.yml`; 프로덕션에서는 환경 파일, Docker 비밀 또는 외부 비밀 관리자를 사용합니다.

- 교체 `WEBHOOK_URL` 실제 공개 URL을 사용하여 역방향 프록시를 구성하여 라우팅합니다. `n8n.example.com` n8n 컨테이너로.

- `EXECUTIONS_MODE=queue` 강력한 백그라운드 처리를 위해서는 큐 워커와 Redis가 필요합니다.

## npm/Node.js를 사용하여 n8n을 셀프 호스팅하려면 어떻게 해야 하나요?

npm(또는 pnpm)을 통해 설치하면 호스트에서 n8n이 직접 실행됩니다. 이 방식은 컨테이너 계층이 없어 더 가볍고, 단일 사용자, 설치 복잡도가 낮은 환경 또는 개발자용 컴퓨터에 유용할 수 있습니다. 하지만 종속성 관리, 격리 및 서비스 감독에 대한 책임이 관리자에게 더 많이 부여됩니다. 공식 n8n 문서에는 npm 설치 가이드와 주의사항이 포함되어 있습니다.

### 필요한 OS 패키지 및 Node 버전:

- 안정적인 LTS Node.js(Node 18 또는 Node 20+, n8n 릴리스 요구 사항과 일치)를 사용하세요.

- 설치 `build-essential`, `git`, 그리고 프로세스 관리자(systemd가 권장됨).

- 프로덕션 환경에서는 PostgreSQL과 Redis를 외부 서비스로 계속 사용합니다(Docker와 동일한 이유).

### npm을 통해 n8n을 설치하고 실행하는 방법은 무엇인가요?(단계별)

1. Node.js 설치 (권장: nvm)

Install nvm

curl -o- https://raw.githubusercontent.com/nvm-sh/nvm/v0.39.7/install.sh | bash

Reload your shell (adjust to your shell startup file if needed)

source ~/.bashrc # or ~/.zshrc

Install and use the latest LTS (usually 18 or 20)

nvm install --lts

nvm use --lts

Verify

node -v

npm -v

나중에 "n8n: 명령을 찾을 수 없습니다"라는 메시지가 표시되면 터미널을 다시 시작하거나 nvm에서 관리하는 npm 글로벌 bin 경로가 PATH에 있는지 확인하세요.

---

2. n8n 설치 및 시작(로컬)

npm install -g n8n

n8n -v # verify version

3. 전경에서 시작:

n8n start

기본 URL: <http://localhost:5678/> 포트가 사용 중인 경우:

export N8N_PORT=5679

n8n start

선택 사항: 백그라운드에서 계속 실행(여전히 로컬)합니다.

npm install -g pm2

pm2 start "n8n" --name n8n

pm2 save

pm2 status

4. 첫 접속 및 로그인:

- 브라우저에서 http://localhost:5678/을 엽니다.

- 처음 실행할 때 마법사를 따라 소유자 계정(이메일 + 비밀번호)을 만들고 로그인하세요.

## n8n에서 CometAPI 커뮤니티 노드를 설치하거나 구성하려면 어떻게 해야 하나요?

n8n은 자체 호스팅 시 검증된 커뮤니티 노드(GUI 설치)와 npm을 통한 수동 설치를 모두 지원합니다. CometAPI를 n8n에 통합하는 방법은 두 가지가 있습니다.

### 옵션 A - CometAPI 커뮤니티 노드 사용(노드 패널에서 사용 가능한 경우)

1. n8n에서 노드 패널을 엽니다(누름 `+` or `Tab`).

2. CometAPI는 검증된 커뮤니티 노드이며, "커뮤니티에서 더 보기"에 표시됩니다. 클릭하여 설치하세요.

3. 설치 후 메시지가 표시되면 n8n을 다시 시작하세요. 새 파일을 만드세요. **신임장** 설정 → 자격 증명(노드에서 CometAPI 자격 증명 유형을 제공하는 경우 선택)으로 가서 CometAPI 토큰을 붙여넣습니다.

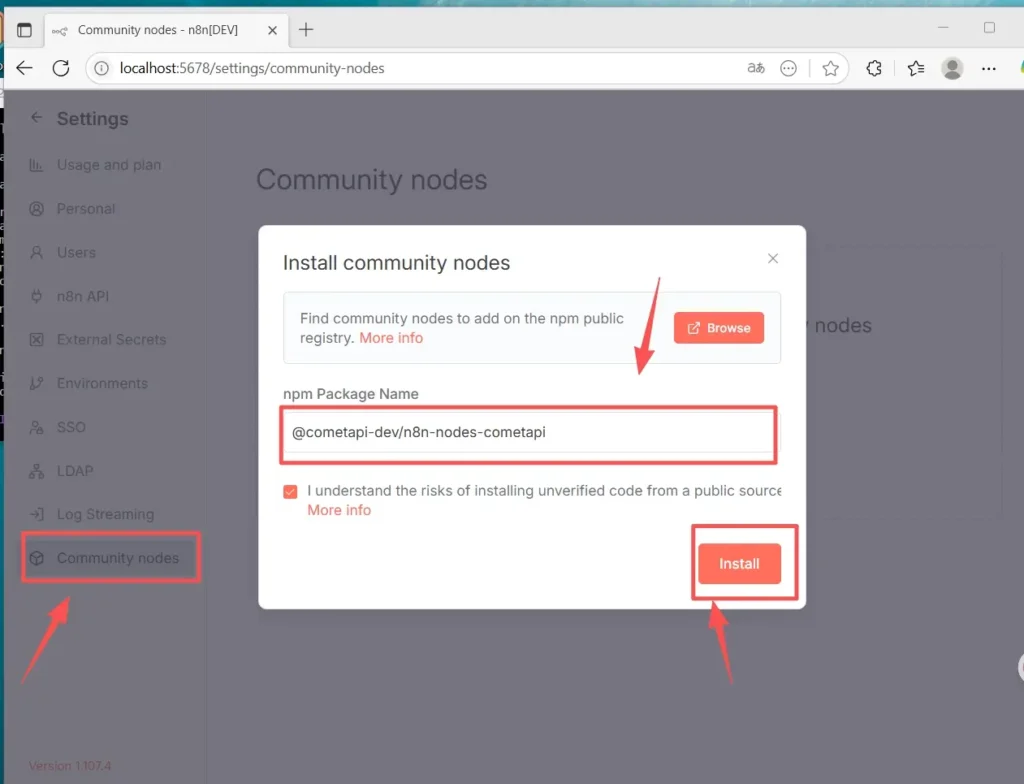

### 옵션 B - 수동 설치(GUI 설치가 불가능한 경우)

1. n8n 호스트/컨테이너에 SSH로 접속합니다.

2. 글로벌 n8n에 패키지를 설치합니다. `node_modules` 또는 사용자 정의 폴더:

- 설정(왼쪽 하단) > 커뮤니티 노드로 이동하세요.

- 커뮤니티 노드 설치”

- "npm 패키지 이름"에 다음을 입력합니다. `@cometapi-dev/n8n-nodes-cometapi`위험 확인 상자를 체크하세요.

- 설치” 설치 후 노드 패널에서 “CometAPI”를 검색할 수 있습니다.

3. n8n을 다시 시작하세요. 인스턴스가 큐 모드로 실행되는 경우, 설명서에 설명된 수동 설치 방법을 따라야 합니다.

### 노드가 설치되었는지 확인하는 방법

- 재시작 후 노드 패널을 열고 "CometAPI" 또는 "Comet"을 검색하세요. 해당 노드가 커뮤니티 패키지로 표시됩니다.

- 노드가 보이지 않으면 인스턴스 소유자 계정이 사용되었는지 확인하세요(인스턴스 소유자만 설치할 수 있음). 또는 컨테이너/이미지 로그에 노드 패키지가 오류 없이 설치되었는지 확인하세요.

## 워크플로를 생성하고 API를 구성하는 방법

### 1. 새 워크플로 만들기

- n8n 인스턴스(셀프 호스팅)에 로그인합니다.

- **"워크플로 추가"** 새로운 자동화 캔버스를 시작합니다.

### 2. 노드 추가

- 트리거 노드를 추가하려면 "수동 트리거" 또는 "'워크플로 실행'을 클릭할 때"를 검색하세요.

- 캔버스 오른쪽에 있는 "+"를 클릭하고 "CometAPI"를 검색하여 노드를 추가합니다.

- 왼쪽 노드 목록에서 "CometAPI"를 검색하여 캔버스로 끌어다 놓을 수도 있습니다.

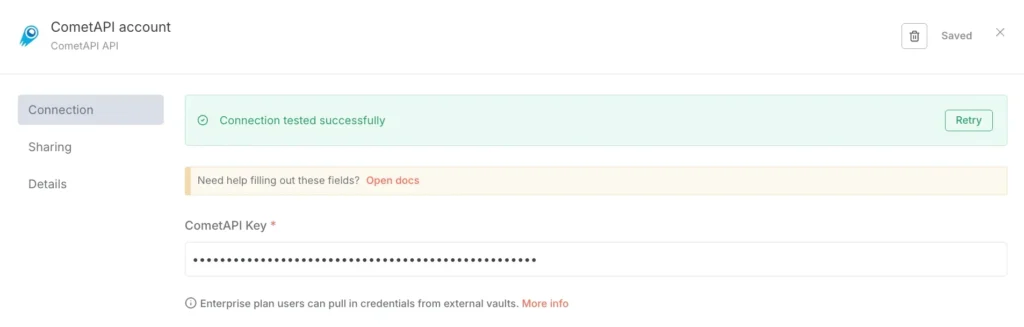

### 3. 자격 증명 구성(처음에만 해당):

- CometAPI 노드의 "연결할 자격 증명"에서 "새로 만들기"를 선택합니다.

- CometAPI 콘솔에서 생성한 토큰을 "CometAPI Key"에 붙여넣습니다.

- 저장합니다. 기본 URL은 기본적으로 https://api.cometapi.com으로 설정되며 일반적으로 변경할 필요가 없습니다.

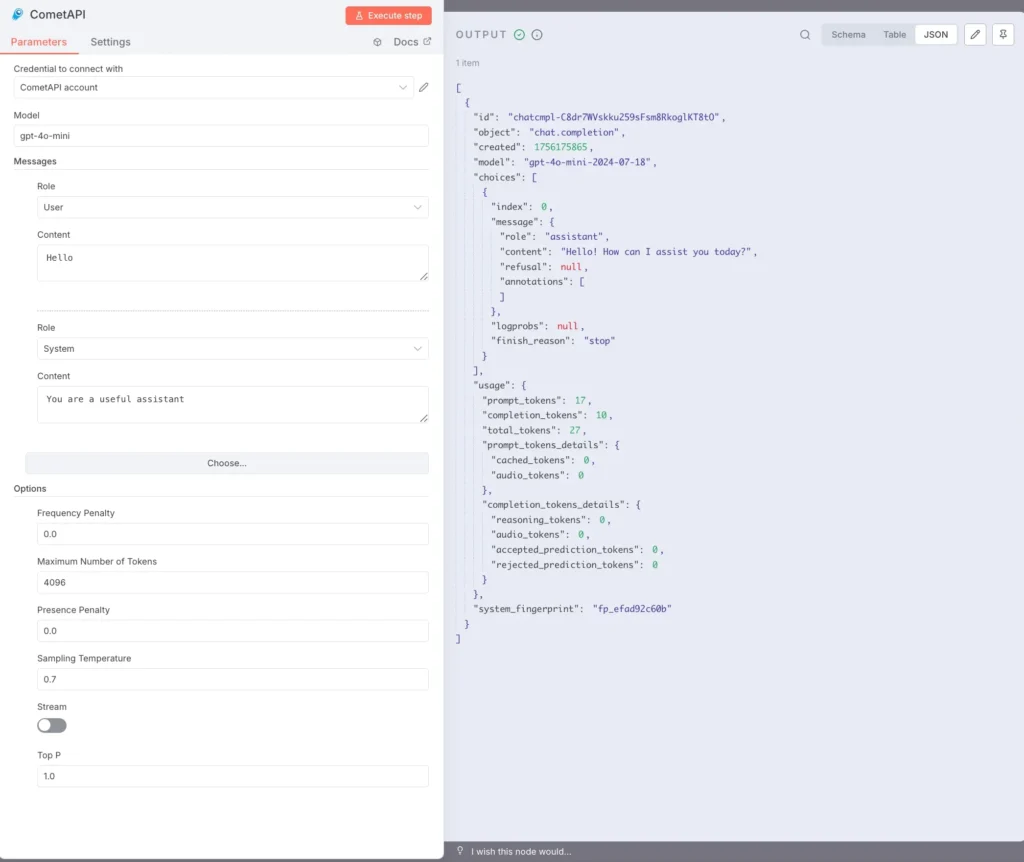

### 4. 모델 및 메시지 구성:

모델: 지원되는 모델을 입력하세요. 예: `gpt-4o` or `gpt-4o-mini`.

메시지: 역할과 컨텍스트를 입력해야 하며 역할에 대해 사용자 또는 시스템을 선택할 수 있습니다.

필요에 따라 선택 가능한 매개변수는 다음과 같습니다. 최대 토큰 수(예: 4096), 샘플링 온도(예: 0.7), PenaltyStream(스트리밍 활성화/비활성화). 특정 매개변수 설명서 및 설명은 다음을 참조하십시오. [CometAPI 문서](https://api.cometapi.com/doc).

### 5. 텍스트 실행:

CometAPI 노드를 선택하고 "단계 실행"을 클릭하거나 하단의 "워크플로 실행"을 클릭합니다.

오른쪽의 OUTPUT 패널에는 JSON 응답(선택, 사용법 등 포함)이 표시됩니다.

이제 npm을 통해 Linux에 n8n(권장)을 로컬로 설치하고 CometAPI 커뮤니티 노드를 설치 및 구성했으며, gpt-4o와 같은 모델을 호출하여 응답을 수신하는 워크플로를 실행할 수 있습니다.

## 일반적인 문제는 무엇이고, 어떻게 해결하나요?

### 1) “401 인증되지 않음” 또는 “잘못된 API 키”

- CometAPI 대시보드에서 정확한 토큰 문자열을 확인하세요(비슷한 이름의 토큰이 있을 수 있습니다). n8n 자격 증명에 복사하여 붙여넣고 필요한 경우 노드를 다시 시작하세요.

- 권한 헤더 형식이 다음과 같은지 확인하세요. `Bearer sk-xxxxx`.

### 2) 커뮤니티 노드가 설치되지 않음 / "대기 모드"

- n8n이 실행되면 **대기 모드**GUI 설치를 비활성화할 수 있습니다. 수동 설치 문서에 따라 npm을 통해 커뮤니티 노드를 설치하거나 노드를 포함하는 사용자 지정 이미지를 빌드하세요. 설치 후 n8n을 다시 시작하세요.

### 3) 설치 후 팔레트에서 노드를 찾을 수 없음

- n8n을 다시 시작합니다.

- 올바른 컨텍스트(컨테이너 이미지 내부 또는)에 패키지를 설치했는지 확인하십시오. `.n8n/custom` (해당 패턴을 사용하는 경우 경로).

- 모듈 확인 오류에 대한 컨테이너 로그를 확인하세요.

### 4) 요금 제한 또는 할당량 문제

- 사용량과 할당량을 확인하려면 CometAPI 대시보드를 확인하세요.

- 제한 경고나 HTTP 429가 감지되면 지수 백오프를 구현하고 더 저렴한 모델로 대체합니다.

## 커뮤니티 노드를 이용할 수 없거나 더 많은 유연성이 필요한 경우 대안이 있습니까?

네 - 항상 사용할 수 있습니다. **HTTP 요청** 노드 직접(전체 제어) 또는 [기본 URL이 있는 OpenAI 노드](https://apidoc.cometapi.com/n8n-965890m0) 리디렉션(실용적인 단축법). 원시 HTTP를 사용하면 새로운 CometAPI 엔드포인트(예: 이미지/비디오 엔드포인트)가 출시될 때마다 이를 쉽게 채택할 수 있습니다. [안내서](https://apidoc.cometapi.com/n8n-965890m0).

**도 참조** [CometAPI와 함께 n8n을 사용하는 방법](https://www.cometapi.com/ko/how-to-use-n8n-with-cometapi/?utm_source=chatgpt.com)

## 결론 :

CometAPI는 모델 선택과 운영 편의성을 제공하며, n8n은 시각적 오케스트레이션과 확장성을 제공합니다. OpenAI 자격 증명 트릭을 사용하여 빠른 채팅/완료 통합을 구현하고, 신뢰할 수 있는 커뮤니티 노드를 활용하세요. 모든 워크플로를 비용, 지연 시간, 보안을 고려하여 설계하고, 중요한 의사 결정에는 사람이 개입하는 방식을 선호하며, AI 공급업체 환경의 급변하는 변화에 유연하게 대응할 수 있도록 모델 선택을 동적으로 유지하세요. n8n과 CometAPI의 조합은 강력하지만, 모든 강력한 도구와 마찬가지로 관찰, 테스트, 반복이라는 가드레일이 필요합니다.