DeepSeek-V3.1은 DeepSeek의 최신 하이브리드 추론 모델로, 빠른 "비사고" 채팅 모드와 더욱 신중한 "사고/추론" 모드를 모두 지원합니다. 최대 128KB의 긴 컨텍스트, 구조화된 출력 및 함수 호출을 제공하며, DeepSeek의 OpenAI 호환 API, Anthropic 호환 엔드포인트 또는 CometAPI를 통해 직접 액세스할 수 있습니다. 아래에서는 모델 소개, 벤치마크 및 비용 주요 내용, 고급 기능(함수 호출, JSON 출력, 추론 모드)을 살펴보고, 구체적인 엔드투엔드 코드 샘플을 제공합니다. DeepSeek REST 직접 호출(curl/Node/Python), Anthropic 클라이언트 사용, CometAPI를 통한 호출 등이 포함됩니다.

DeepSeek-V3.1은 무엇이고 이번 릴리스의 새로운 기능은 무엇입니까?

DeepSeek-V3.1은 DeepSeek V3 제품군의 최신 릴리스입니다. 대용량, 전문가 혼합 대규모 언어 모델 라인으로 다음을 제공합니다. 하이브리드 추론 설계 두 가지 작동 "모드" - 빠른 생각 없는 채팅 모드와 사고하는 사람 / 추론하는 사람 더 어려운 추론 작업과 에이전트/도구 사용을 위해 사고의 사슬 스타일 추적을 노출할 수 있는 모드입니다. 이 릴리스는 더 빠른 "사고" 지연 시간, 향상된 도구/에이전트 기능, 그리고 문서 규모 워크플로우를 위한 더 긴 컨텍스트 처리를 강조합니다.

주요 실용적인 정보:

- 두 가지 작동 모드:

deepseek-chat처리량과 비용에 대해deepseek-reasoner(추론 모델) 사고의 연속적 추적이나 더 높은 추론 충실도가 필요할 때. - 긴 문서에 대한 에이전트/도구 처리가 업그레이드되었고 토크나이저/컨텍스트가 개선되었습니다.

- 컨텍스트 길이: 최대 ~128K 토큰(긴 문서, 코드베이스, 로그 사용 가능).

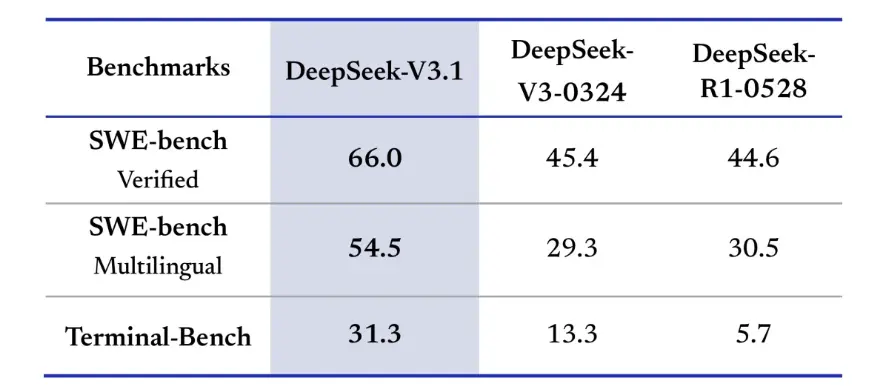

벤치마크 혁신

DeepSeek-V3.1은 실제 코딩 과제에서 상당한 개선을 보였습니다. 모델이 단위 테스트 통과를 위해 GitHub 이슈를 얼마나 자주 수정하는지 측정하는 SWE-bench Verified 평가에서 V3.1은 66%의 성공률을 달성했으며, 이는 V45-3와 R0324의 1%보다 높은 수치입니다. 다국어 버전에서 V3.1은 54.5%의 이슈를 해결하여 다른 버전의 약 30% 성공률의 거의 두 배에 달했습니다. 모델이 라이브 Linux 환경에서 작업을 성공적으로 완료할 수 있는지 테스트하는 Terminal-Bench 평가에서 DeepSeek-V3.1은 31%의 작업에서 성공했으며, 이는 다른 버전의 각각 13%와 6%보다 높은 수치입니다. 이러한 개선 사항은 DeepSeek-V3.1이 실제 도구 환경에서 코드 실행 및 운영 측면에서 더욱 안정적임을 보여줍니다.

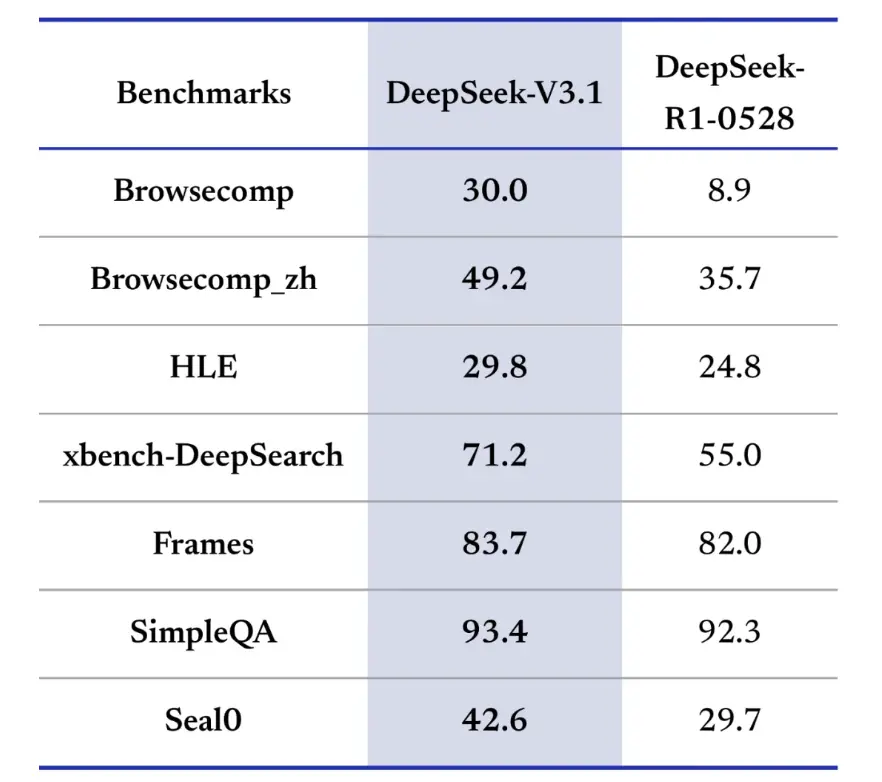

정보 검색 벤치마크는 또한 탐색, 검색 및 질의응답에서 DeepSeek-V3.1을 선호합니다.웹페이지에서 탐색하고 답변을 추출해야 하는 BrowseComp 평가에서 V3.1은 질문의 30%에 올바르게 답한 반면 R9은 1%였습니다.중국어 버전에서 DeepSeek-V3.1은 49%의 정확도를 달성한 반면 R36은 1%였습니다.HLE(Hard Language Exam)에서 V3.1은 각각 1%~30%의 정확도를 달성하여 R25보다 약간 우수한 성능을 보였습니다.소스 전반에 걸쳐 정보를 종합해야 하는 xbench-DeepSearch와 같은 심층 검색 작업에서 V3.1은 71%를 기록한 반면 R1은 55%를 기록했습니다.DeepSeek-V3.1은 또한 (구조적 추론), SimpleQA(사실 기반 질의응답), Seal0(도메인별 질의응답)과 같은 벤치마크에서 작지만 일관된 우위를 보였습니다. 전반적으로 V3.1은 정보 검색과 가벼운 질의 응답 측면에서 R1보다 상당히 우수한 성능을 보였습니다.

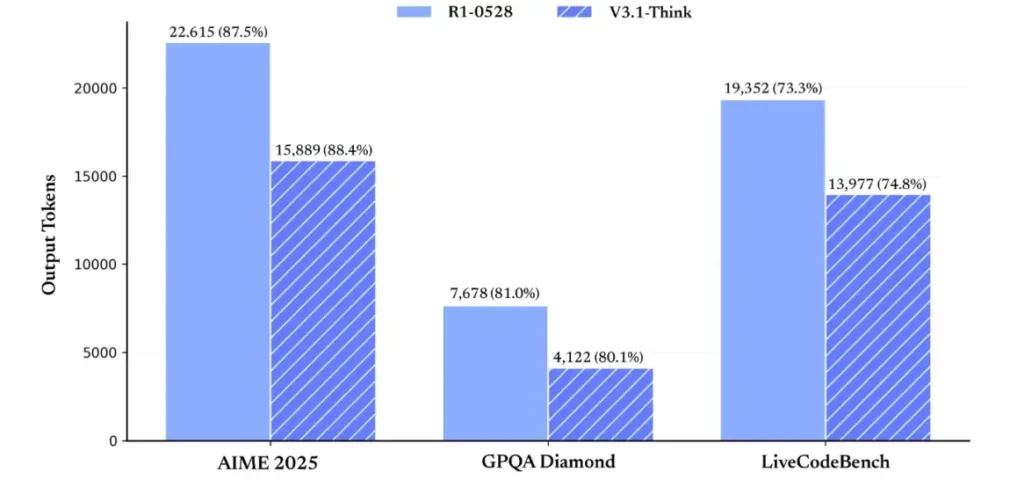

추론 효율성 측면에서 토큰 사용 결과는 그 효과를 입증합니다. AIME 2025(난이도 수학 시험)에서 V3.1-Think는 R1과 유사하거나 약간 더 높은 정확도(88.4% 대 87.5%)를 달성했지만, 토큰 사용량은 R30보다 약 80.1% 적었습니다. GPQA Diamond(다중 도메인 대학원 시험)에서는 두 모델의 정확도가 거의 비슷했지만(81.0% 대 3.1%), V1은 R3.1의 거의 절반에 해당하는 토큰을 사용했습니다. 코드 추론을 평가하는 LiveCodeBench 벤치마크에서 V74.8은 더 정확했을 뿐만 아니라(73.3% 대 3.1%), 더 간결했습니다. 이는 VXNUMX-Think가 장황함을 피하면서도 상세한 추론을 제공할 수 있음을 보여줍니다.

전반적으로 V3.1은 V3-0324에 비해 상당한 세대적 도약을 보여줍니다. R1과 비교했을 때 V3.1은 거의 모든 벤치마크에서 더 높은 정확도를 달성했으며, 복잡한 추론 작업에서도 더 효과적이었습니다. R1과 동일한 성능을 보인 유일한 벤치마크는 GPQA였지만, 비용은 거의 두 배에 달했습니다.

API 키를 얻고 개발 계정을 설정하려면 어떻게 해야 하나요?

1단계: 가입 및 계정 만들기

- DeepSeek 개발자 포털(DeepSeek 문서/콘솔)을 방문하세요. 이메일 주소나 SSO 제공업체를 통해 계정을 생성하세요.

- 포털에서 요구하는 신원 확인이나 청구 설정을 완료하세요.

2단계: API 키 생성

- 대시보드에서 다음으로 이동하세요. API 키 → 키 생성. 키 이름을 지정하세요(예:

dev-local-01). - 키를 복사하여 안전한 비밀 관리자에 저장합니다(아래의 프로덕션 모범 사례 참조).

팁: 일부 게이트웨이 및 타사 라우터(예: CometAPI)를 사용하면 단일 게이트웨이 키를 사용하여 이를 통해 DeepSeek 모델에 액세스할 수 있습니다. 이는 다중 공급자 중복성에 유용합니다(참조). 딥시크 V3.1 API 섹션).

개발 환경(Linux/macOS/Windows)을 어떻게 설정하나요?

이는 DeepSeek(OpenAI 호환 엔드포인트), CometAPI 및 Anthropic에서 작동하는 Python 및 Node.js를 위한 간단하고 재현 가능한 설정입니다.

사전 조건

- Python 3.10+ (권장), pip, virtualenv.

- Node.js 18+ 및 npm/yarn.

- curl(빠른 테스트를 위해).

Python 환경(단계별)

- 프로젝트 디렉토리를 생성하세요:

mkdir deepseek-demo && cd deepseek-demo

python -m venv .venv

source .venv/bin/activate # macOS / Linux

# .venv\Scripts\activate # Windows PowerShell

- 최소 패키지를 설치하세요:

pip install --upgrade pip

pip install requests

# Optional: install an OpenAI-compatible client if you prefer one:

pip install openai

- API 키를 환경 변수에 저장합니다(커밋하지 마세요):

export DEEPSEEK_KEY="sk_live_xxx"

export CometAPI_KEY="or_xxx"

export ANTHROPIC_KEY="anthropic_xxx"

(Windows PowerShell 사용 $env:DEEPSEEK_KEY = "…")

노드 환경(단계별)

- 초기화:

mkdir deepseek-node && cd deepseek-node

npm init -y

npm install node-fetch dotenv

- 만들기

.env파일 :

DEEPSEEK_KEY=sk_live_xxx

CometAPI_KEY=or_xxx

ANTHROPIC_KEY=anthropic_xxx

DeepSeek-V3.1을 직접 호출하려면 어떻게 해야 하나요? 단계별 코드 예시를 참조하세요.

DeepSeek의 API는 OpenAI와 호환됩니다. 아래는 복사 - 붙여 넣기 예: curl, Python(요청 및 openai SDK 스타일), Node.js.

1단계: 간단한 컬 예제

curl https://api.deepseek.com/v1/chat/completions \

-H "Authorization: Bearer $DEEPSEEK_KEY" \

-H "Content-Type: application/json" \

-d '{

"model": "deepseek-chat-v3.1",

"messages": [

{"role":"system","content":"You are a concise engineering assistant."},

{"role":"user","content":"Give a 5-step secure deployment checklist for a Django app."}

],

"max_tokens": 400,

"temperature": 0.0,

"reasoning_enabled": true

}'

배송 시 요청 사항: reasoning_enabled Think 모드(공급업체 플래그)를 전환합니다. 정확한 플래그 이름은 공급업체마다 다를 수 있으므로 모델 문서를 확인하세요.

2단계: 간단한 원격 측정을 통한 Python(요청)

import os, requests, time, json

API_KEY = os.environ

URL = "https://api.deepseek.com/v1/chat/completions"

payload = {

"model": "deepseek-chat-v3.1",

"messages": [

{"role": "system", "content": "You are a helpful coding assistant."},

{"role": "user", "content": "Refactor this Flask function to be testable: ..."}

],

"max_tokens": 600,

"temperature": 0.1,

"reasoning_enabled": True

}

start = time.time()

r = requests.post(URL, headers={

"Authorization": f"Bearer {API_KEY}",

"Content-Type": "application/json"

}, json=payload, timeout=60)

elapsed = time.time() - start

print("Status:", r.status_code, "Elapsed:", elapsed)

data = r.json()

print(json.dumps(data, indent=2))

CometAPI: DeepSeek V3.1에 대한 완전 무료 액세스

등록 없이 바로 이용하고 싶은 개발자를 위해 CometAPI는 DeepSeek V3.1(모델명: deepseek-v3-1-250821; deepseek-v3.1)에 대한 매력적인 대안을 제공합니다. 이 게이트웨이 서비스는 통합 API를 통해 여러 AI 모델을 통합하여 DeepSeek에 대한 접근을 제공하고 자동 장애 조치, 사용량 분석, 간소화된 공급업체 간 과금 등의 다양한 이점을 제공합니다.

먼저 CometAPI 계정을 만드세요. https://www.cometapi.com/—전체 과정은 단 20분밖에 걸리지 않으며 이메일 주소 확인만 필요합니다. 로그인 후 "API 키" 섹션에서 새 키를 생성하세요. https://www.cometapi.com/에서는 신규 계정에 무료 크레딧을 제공하고 공식 API 가격에서 XNUMX% 할인을 제공합니다.

기술 구현에는 최소한의 코드 변경만 필요합니다. API 엔드포인트를 DeepSeek 직접 URL에서 CometAPI 게이트웨이로 변경하기만 하면 됩니다.

참고: API는 스트리밍을 지원합니다(

stream: true),max_tokens, 온도, 정지 시퀀스, 다른 OpenAI 호환 API와 유사한 함수 호출 기능.

Anthropic SDK를 사용하여 DeepSeek를 호출하려면 어떻게 해야 하나요?

DeepSeek는 Anthropic과 호환되는 엔드포인트를 제공하므로 SDK를 가리키면 Anthropic SDK 또는 Claude Code 툴링을 재사용할 수 있습니다. https://api.deepseek.com/anthropic 그리고 모델 이름을 설정하세요 deepseek-chat (또는 deepseek-reasoner (지원되는 경우).

Anthropic API를 통해 DeepSeek 모델 호출

Anthropic SDK를 설치하세요: pip install anthropic. 환경을 구성하세요:

export ANTHROPIC_BASE_URL=https://api.deepseek.com/anthropic

export ANTHROPIC_API_KEY=YOUR_DEEPSEEK_KEY

메시지를 작성하세요:

import anthropic

client = anthropic.Anthropic()

message = client.messages.create(

model="deepseek-chat",

max_tokens=1000,

system="You are a helpful assistant.",

messages=[

{

"role": "user",

"content": [

{

"type": "text",

"text": "Hi, how are you?"

}

]

}

]

)

print(message.content)

Claude Code에서 DeepSeek 사용

설치: npm install -g @anthropic-ai/claude-code. 환경 구성:

export ANTHROPIC_BASE_URL=https://api.deepseek.com/anthropic

export ANTHROPIC_AUTH_TOKEN=${YOUR_API_KEY}

export ANTHROPIC_MODEL=deepseek-chat

export ANTHROPIC_SMALL_FAST_MODEL=deepseek-chat

프로젝트 디렉토리에 들어가서 Claude Code를 실행하세요.

cd my-project

claude

CometAPI를 통해 Claude Code에서 DeepSeek 사용

CometAPI는 Claude Code를 지원합니다. 설치 후 환경 설정 시, 기본 URL을 https://api.cometapi.com으로, 키를 CometAPI의 Key로 변경하면 Claude Code에서 CometAPI의 DeepSeek 모델을 사용할 수 있습니다.

# Navigate to your project folder cd your-project-folder

# Set environment variables (replace sk-... with your actual token)

export ANTHROPIC_AUTH_TOKEN=sk-...

export ANTHROPIC_BASE_URL=https://www.cometapi.com/console/

# Start Claude Code

claude

배송 시 요청 사항:

- DeepSeek는 지원되지 않는 Anthropic 모델 이름을 매핑합니다.

deepseek-chat. - Anthropic 호환성 레이어는 다음을 지원합니다.

system,messages,temperature, 스트리밍, 정지 시퀀스, 사고 배열.

구체적인 생산 모범 사례(보안, 비용, 안정성)는 무엇입니까?

DeepSeek 또는 대용량 LLM 사용에 적용되는 권장 생산 패턴은 다음과 같습니다.

비밀과 정체성

- API 키를 비밀 관리자에 저장하세요(사용하지 마세요)

.env(prod에서) 키를 정기적으로 교체하고 최소한의 권한으로 서비스별 키를 생성합니다. - 개발/스테이징/프로덕션별로 별도의 프로젝트/계정을 사용하세요.

속도 제한 및 재시도

- 구현 지수 백오프 HTTP 429/5xx에서 지터가 발생합니다. 재시도 횟수를 제한합니다(예: 3회 시도).

- 반복될 수 있는 요청에는 멱등성 키를 사용하세요.

Python 예제 - 백오프로 재시도

import time, random, requests

def post_with_retries(url, headers, payload, attempts=3):

for i in range(attempts):

r = requests.post(url, json=payload, headers=headers, timeout=60)

if r.status_code == 200:

return r.json()

if r.status_code in (429, 502, 503, 504):

backoff = (2 ** i) + random.random()

time.sleep(backoff)

continue

r.raise_for_status()

raise RuntimeError("Retries exhausted")

원가 관리

- 한도

max_tokens실수로 엄청난 양의 출력을 요청하는 것을 방지하세요. - 캐시 모델 응답 적절한 경우(특히 반복되는 프롬프트의 경우). DeepSeek은 가격 책정 시 캐시 적중률과 캐시 미스를 명확하게 구분합니다. 캐싱을 통해 비용을 절감할 수 있습니다.

deepseek-chat일상적인 작은 답변의 경우 예약하세요.deepseek-reasoner실제로 CoT가 필요한 경우(비용이 더 많이 듭니다).

관찰성 및 로깅

- 요청에 대한 메타데이터(프롬프트 해시, 토큰 수, 지연 시간)만 일반 텍스트로 로깅합니다. 전체 사용자 데이터나 민감한 콘텐츠는 로깅하지 마세요. 지원 및 청구 조정을 위해 요청/응답 ID를 저장합니다.

- 요청별로 토큰 사용량을 추적하고 비용에 대한 예산/알림을 공개합니다.

안전 및 환각 제어

- 도구 출력 및 결정론적 검증기 안전이 중요한 모든 것(재정, 법률, 의료)에 대해.

- 구조화된 출력의 경우 다음을 사용하세요.

response_format+JSON 스키마를 적용하고 되돌릴 수 없는 작업을 수행하기 전에 출력을 검증합니다.

배포 패턴

- 전담 작업자 프로세스에서 모델 호출을 실행하여 동시성과 대기열을 제어합니다.

- 무거운 작업을 비동기 작업자(Celery, Fargate 작업, Cloud Run 작업)에게 오프로드하고 진행률 표시기를 통해 사용자에게 응답합니다.

- 극심한 지연 시간/처리량이 필요한 경우 공급자 SLA를 고려하고 자체 호스팅을 할지, 공급자 가속기를 사용할지 고려하세요.

결산 메모

DeepSeek-V3.1은 빠른 채팅과 복잡한 에이전트 작업 모두를 위해 설계된 실용적인 하이브리드 모델입니다. OpenAI와 호환되는 API 구조 덕분에 많은 프로젝트에서 마이그레이션이 간편하며, Anthropic 및 CometAPI 호환 레이어 덕분에 기존 생태계에서도 유연하게 사용할 수 있습니다. 벤치마크와 커뮤니티 보고서는 비용 대비 성능 측면에서 유망한 트레이드오프를 보여주지만, 다른 새로운 모델과 마찬가지로 전체 프로덕션 출시 전에 실제 워크로드(프롬프트, 함수 호출, 안전 검사, 지연 시간)에서 검증하는 것이 좋습니다.

CometAPI에서는 OpenAI 호환 API 또는 사용자 친화적인 API를 통해 안전하게 실행하고 상호 작용할 수 있습니다. 운동장, 요금 제한 없음.

👉 지금 CometAPI에 DeepSeek-V3.1을 배포하세요!

CometAPI를 사용하는 이유는 무엇인가요?

- 공급자 멀티플렉싱: 코드를 다시 작성하지 않고도 공급업체를 전환합니다.

- 통합 청구/측정항목: CometAPI를 통해 여러 모델을 라우팅하면 단일 통합 표면을 얻게 됩니다.

- 모델 메타데이터: 모델 변형별 뷰 컨텍스트 길이 및 활성 매개변수.