Qwen3-Max-Preview는 알리바바의 Qwen3 제품군 최신 플래그십 프리뷰 모델로, 262조 개 이상의 매개변수를 사용하는 전문가 혼합(MoE) 방식 모델로, XNUMX만 XNUMX천 개의 토큰 컨텍스트 윈도우를 매우 길게 제공하며, 기업/클라우드 사용을 위한 프리뷰로 출시되었습니다. 대상은 *심층적 추론, 긴 문서 이해, 코딩 및 에이전트 워크플로.

기본 정보 및 헤드라인 기능

- 이름/레이블:

qwen3-max-preview(지시하다). - 규모 : 1조개 이상의 매개변수 (조 단위 매개변수 플래그십). 이는 이번 출시의 핵심 마케팅/통계적 이정표입니다.

- 컨텍스트 창: 262,144 토큰 (매우 긴 입력과 다중 파일 대본을 지원합니다).

- 모드: 지원이 포함된 지침 조정 "Instruct" 변형 생각 (의도적인 생각의 사슬) 그리고 생각하지 않는 Qwen3 제품군의 빠른 모드.

- 운영시간: 미리보기 액세스를 통해 웬 채팅, 알리바바 클라우드 모델 스튜디오 (OpenAI 호환 또는 DashScope 엔드포인트) 및 라우팅 공급자와 같은 코멧API.

기술 세부 사항(아키텍처 및 모드)

- 건축물: Qwen3-Max는 혼합된 Qwen3 디자인 계통을 따릅니다. 고밀도 + 전문가 혼합(MoE) 더 큰 변형의 구성 요소와 매우 많은 매개변수 수에 대한 추론 효율성을 최적화하기 위한 엔지니어링 선택이 가능합니다.

- 사고 모드 vs. 비사고 모드: Qwen3 시리즈가 출시되었습니다. 사고 모드 (다단계 사고 사슬 스타일 출력의 경우) 및 무사고 모드 더 빠르고 간결한 답변을 위해 플랫폼은 이러한 동작을 전환하는 매개변수를 제공합니다.

- 컨텍스트 캐싱/성능 기능: 모델 스튜디오 목록 컨텍스트 캐시 반복되는 입력 비용을 줄이고 반복되는 컨텍스트에서 처리량을 향상시키기 위한 대규모 요청 지원.

벤치마크 성능

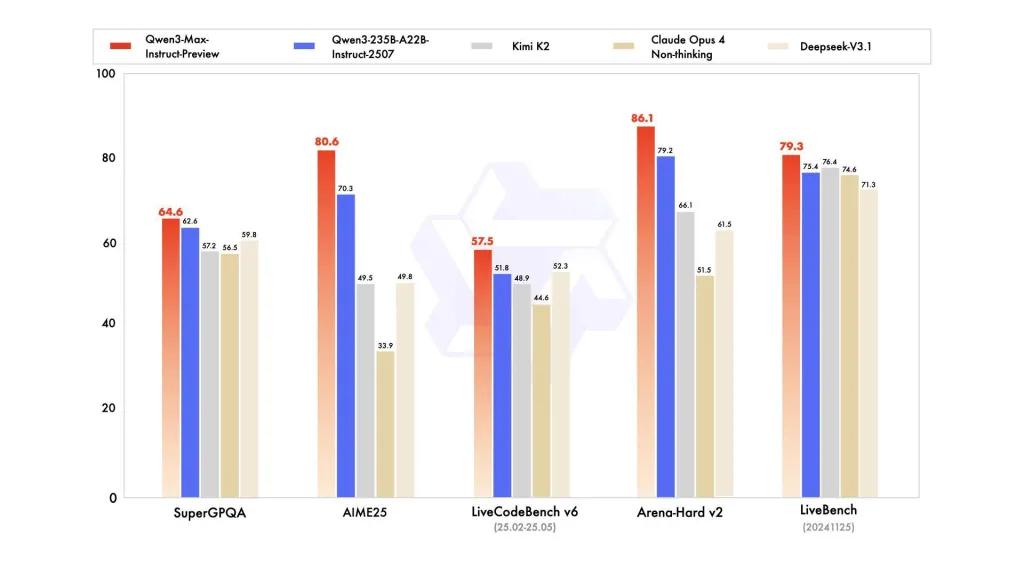

보고서는 Qwen25-Max가 경쟁력이 있거나 앞서 나가는 것으로 보이는 SuperGPQA, LiveCodeBench 변형, AIME3 및 기타 콘테스트/벤치마크 모음을 참조합니다.

제한 사항 및 위험(실용 및 안전 참고 사항)

- 전체 훈련 레시피/무게에 대한 불투명도: 미리보기로, 전체 훈련/데이터/가중치 릴리스 및 재현성 자료는 이전의 공개 가중치 Qwen3 릴리스에 비해 제한될 수 있습니다. 일부 Qwen3 제품군 모델은 공개 가중치로 릴리스되었지만, Qwen3-Max는 클라우드 액세스를 위한 통제된 미리보기로 제공됩니다. 재현성을 감소시킨다 독립적인 연구자들을 위해.

- 환각과 사실성: 공급업체 보고서는 환각 감소를 주장하지만, 실제 사용에서는 여전히 사실 오류와 과신 주장이 발견될 수 있습니다. 이는 표준 LLM 경고가 적용됩니다. 고위험 배포 전에는 독립적인 평가가 필수적입니다.

- 규모에 따른 비용: 거대한 컨텍스트 창과 높은 기능을 갖춘 토큰 비용 매우 긴 프롬프트나 프로덕션 처리량에는 상당한 비용이 발생할 수 있습니다. 캐싱, 청킹 및 예산 제어를 활용하세요.

- 규제 및 데이터 주권 고려 사항: 기업 사용자는 민감한 정보를 처리하기 전에 Alibaba Cloud 지역, 데이터 상주 및 규정 준수에 미치는 영향을 확인해야 합니다. (Model Studio 설명서에는 지역별 엔드포인트와 참고 사항이 포함되어 있습니다.)

사용 사례

- 대규모 문서 이해/요약: 법률 요약, 기술 사양 및 다중 파일 지식 기반(이점: 262K 토큰 창문).

- 긴 컨텍스트 코드 추론 및 저장소 규모 코드 지원: 다중 파일 코드 이해, 대규모 PR 검토, 저장소 수준 리팩토링 제안.

- 복잡한 추론 및 사고의 흐름에 따른 과제: 수학 경연대회, 다단계 계획, "생각"의 흔적이 추적성을 높이는 에이전트적 워크플로.

- 다국어, 기업용 Q&A 및 구조화된 데이터 추출: 대규모 다국어 코퍼스 지원 및 구조화된 출력 기능(JSON/표).

CometAPI에서 Qqwen3-max-preview API를 호출하는 방법

qwen3-max-preview CometAPI의 API 가격 책정, 공식 가격 대비 20% 할인:

| 입력 토큰 | $0.24 |

| 출력 토큰 | $2.42 |

필수 단계

- 에 로그인 코메타피닷컴. 아직 당사 사용자가 아니신 경우 먼저 등록해 주시기 바랍니다.

- 인터페이스의 액세스 자격 증명 API 키를 받으세요. 개인 센터의 API 토큰에서 "토큰 추가"를 클릭하고 토큰 키(sk-xxxxx)를 받아 제출하세요.

- 이 사이트의 url을 받으세요: https://api.cometapi.com/

사용 방법

- API 요청을 전송하고 요청 본문을 설정하려면 "qwen3-max-preview" 엔드포인트를 선택하세요. 요청 메서드와 요청 본문은 웹사이트 API 문서에서 확인할 수 있습니다. 웹사이트에서는 사용자의 편의를 위해 Apifox 테스트도 제공합니다.

- 바꾸다 귀하 계정의 실제 CometAPI 키를 사용합니다.

- 질문이나 요청을 콘텐츠 필드에 입력하세요. 모델이 이에 응답합니다.

- . API 응답을 처리하여 생성된 답변을 얻습니다.

API 호출

CometAPI는 완벽한 호환성을 갖춘 REST API를 제공하여 원활한 마이그레이션을 지원합니다. 주요 세부 정보는 다음과 같습니다. API doc:

- 핵심 매개 변수:

prompt,max_tokens_to_sample,temperature,stop_sequences - 종점 :

https://api.cometapi.com/v1/chat/completions - 모델 매개 변수 : qwen3-max-미리보기

- 입증:

Bearer YOUR_CometAPI_API_KEY - 컨텐츠 타입:

application/json.

교체

CometAPI_API_KEY당신의 열쇠로; 다음을 기록하세요 기본 URL.

Python(요청) — OpenAI 호환

import os, requests

API_KEY = os.getenv("CometAPI_API_KEY")

url = "https://api.cometapi.com/v1/chat/completions"

headers = {"Authorization": f"Bearer {API_KEY}", "Content-Type": "application/json"}

payload = {

"model": "qwen3-max-preview",

"messages": [

{"role":"system","content":"You are a concise assistant."},

{"role":"user","content":"Explain the pros and cons of using an MoE model for summarization."}

],

"max_tokens": 512,

"temperature": 0.1,

"enable_thinking": True

}

resp = requests.post(url, headers=headers, json=payload)

print(resp.status_code, resp.json())

Tip 사용 max_input_tokens, max_output_tokens, 그리고 모델 스튜디오의 컨텍스트 캐시 매우 큰 컨텍스트를 전송할 때 비용과 처리량을 제어하는 기능입니다.

도 참조 Qwen3-코더