Pada Julai 2025, Alibaba melancarkan Qwen3-Pengekod, model AI sumber terbuka yang paling canggih yang direka khusus untuk aliran kerja pengekodan yang kompleks dan tugas pengaturcaraan agen. Panduan profesional ini akan membimbing anda selangkah demi selangkah melalui semua yang anda perlu ketahui—daripada memahami keupayaan teras dan inovasi utamanya, kepada memasang dan menggunakan yang disertakan Kod Qwen Alat CLI untuk pengekodan automatik, gaya ejen. Sepanjang perjalanan, anda akan mempelajari amalan terbaik, petua penyelesaian masalah dan cara mengoptimumkan gesaan dan peruntukan sumber anda untuk memanfaatkan sepenuhnya Qwen3‑Coder.

Apakah Qwen3‑Coder dan mengapa ia penting?

Qwen3‑Coder Alibaba ialah model Campuran Pakar (MoE) 480 bilion parameter dengan 35 bilion parameter aktif, dibina untuk menyokong tugas pengekodan konteks besar—mengendalikan 256 K token secara asli (dan sehingga 1 M dengan kaedah ekstrapolasi). Dikeluarkan pada 23 Julai 2025, ia mewakili lonjakan besar dalam "pengekodan AI agen," di mana model itu bukan sahaja menjana kod tetapi boleh merancang, nyahpepijat dan lelaran secara autonomi melalui cabaran pengaturcaraan yang kompleks tanpa campur tangan manual.

Bagaimanakah Qwen3‑Coder berbeza daripada pendahulunya?

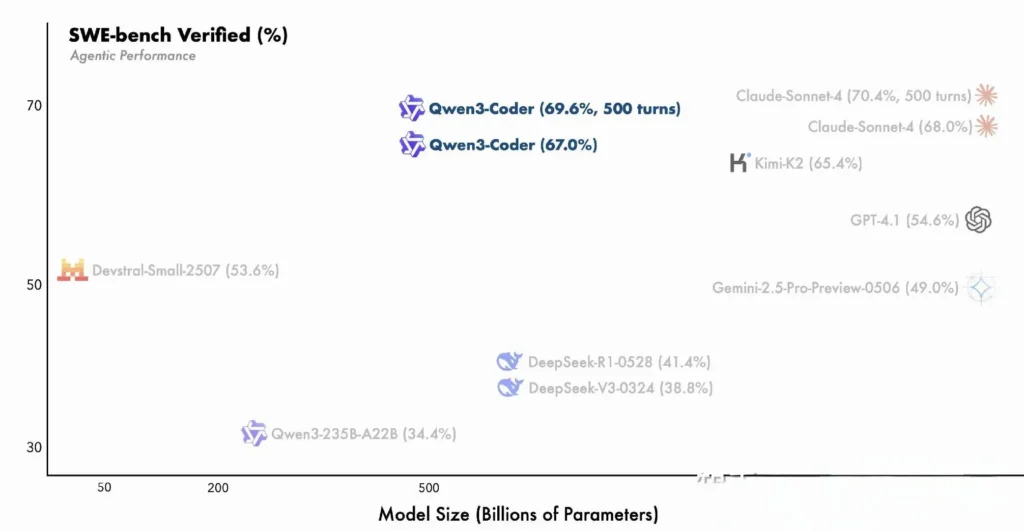

Qwen3‑Coder membina inovasi keluarga Qwen3—menyepadukan kedua-dua “mod berfikir” untuk penaakulan pelbagai langkah dan “mod tidak berfikir” untuk respons pantas—ke dalam rangka kerja tunggal yang bersatu yang menukar mod secara dinamik berdasarkan kerumitan tugas. Tidak seperti Qwen2.5‑Coder, yang padat dan dihadkan pada konteks yang lebih kecil, Qwen3‑Coder menggunakan seni bina Mixture‑of-Experts yang jarang untuk menyampaikan prestasi tercanggih pada penanda aras seperti SWE‑Bench Verified dan penarafan CodeForces ELO's'Auth, padanan model Terbuka atau Claderopic. GPT‑4 dalam metrik pengekodan utama.

ciri utama Qwen3‑Coder:

- Tetingkap Konteks Besar-besaran: 256 K token secara asli, sehingga 1 M melalui ekstrapolasi, membolehkannya memproses keseluruhan pangkalan kod atau dokumentasi panjang dalam satu laluan.

- Keupayaan Agen: "Mod ejen" khusus yang boleh merancang, menjana, menguji dan menyahpepijat secara autonomi, mengurangkan overhed kejuruteraan manual.

- Kapasiti & Kecekapan Tinggi: Reka bentuk Campuran Pakar mengaktifkan hanya 35 bilion parameter setiap inferens, mengimbangi prestasi dengan kos pengiraan.

- Sumber Terbuka & Boleh Diperluas: Dikeluarkan di bawah Apache 2.0, dengan API yang didokumenkan sepenuhnya dan peningkatan didorong komuniti tersedia di GitHub.

- Berbilang Bahasa & Cross-Domain: Dilatih menggunakan 7.5 trilion token (70% kod) merentas berpuluh-puluh bahasa pengaturcaraan, daripada Python dan JavaScript kepada Go dan Rust.

Bagaimanakah pembangun boleh bermula dengan Qwen3‑Coder?

Di manakah saya boleh memuat turun dan memasang Qwen3‑Coder?

Anda boleh mendapatkan berat model dan imej Docker daripada:

- GitHub: https://github.com/QwenLM/Qwen3-Coder

- Muka Memeluk: https://huggingface.co/QwenLM/Qwen3-Coder-480B-A35B-Instruct

- Skop Model: Repositori rasmi Alibaba

Hanya klon repo dan tarik bekas Docker terbina:

git clone https://github.com/QwenLM/Qwen3-Coder.git

cd Qwen3-Coder

docker pull qwenlm/qwen3-coder:latest

Memuatkan Model dengan Transformer

from transformers import AutoModelForCausalLM, AutoTokenizer

model_name = "Qwen/Qwen3-Coder-480B-A35B-Instruct"

model = AutoModelForCausalLM.from_pretrained(

model_name,

torch_dtype="auto",

device_map="auto"

)

tokenizer = AutoTokenizer.from_pretrained(model_name)

Kod ini memulakan model dan tokenizer, mengedarkan lapisan secara automatik ke seluruh GPU yang tersedia .

Bagaimanakah saya mengkonfigurasi persekitaran saya?

- Keperluan Perkakasan:

- GPU NVIDIA dengan ≥ 48 GB VRAM (A100 80 GB disyorkan)

- RAM sistem 128–256 GB

-

Kebergantungan:

pip install -r requirements.txt # PyTorch, CUDA, tokenizers, etc. -

Kunci API (Pilihan):

Untuk inferens dihoskan awan, tetapkan andaALIYUN_ACCESS_KEYandALIYUN_SECRET_KEYsebagai pembolehubah persekitaran.

Bagaimanakah anda menggunakan Kod Qwen untuk pengekodan agen?

Berikut ialah panduan langkah demi langkah untuk bangun dan berlari dengannya Qwen3‑Pengekod melalui Kod Qwen CLI (dipanggil hanya sebagai qwen):

1. Prasyarat

- Node.js 20+ (anda boleh memasang melalui pemasang rasmi atau melalui skrip di bawah)

- npm, yang disertakan bersama Node.js

# (Linux/macOS)

curl -qL https://www.npmjs.com/install.sh | sh

2. Pasang Kod Qwen CLI

npm install -g @qwen-code/qwen-code

Sebagai alternatif, untuk memasang dari sumber:

git clone https://github.com/QwenLM/qwen-code.git

cd qwen-code

npm install

npm install -g

3. Konfigurasikan Persekitaran Anda

Kod Qwen menggunakan Serasi OpenAI Antara muka API di bawah hud. Tetapkan pembolehubah persekitaran berikut:

export OPENAI_API_KEY="your_api_key_here"

export OPENAI_BASE_URL="https://dashscope-intl.aliyuncs.com/compatible-mode/v1"

export OPENAI_MODEL="qwen3-coder-plus"

OPENAI_MODEL boleh ditetapkan kepada salah satu daripada:

qwen3-coder-plus(dinamakan kepada Qwen3‑Coder-480B-A35B-Instruct)- atau mana-mana varian Qwen3‑Coder lain yang telah anda gunakan.

4. Penggunaan Asas

- Mulakan REPL Pengekodan Interaktif:

qwen

Ini membawa anda ke sesi pengekodan agen yang dikuasakan oleh Qwen3‑Coder.

- Gesaan sekali sahaja daripada Shell, Untuk meminta coretan kod atau melengkapkan fungsi:

qwen code complete \

--model qwen3-coder-plus \

--prompt "Write a Python function that reverses a linked list."

- Penyiapan Kod Berasaskan Fail, Mengisi atau memfaktorkan semula fail sedia ada secara automatik:

qwen code file-complete \

--model qwen3-coder-plus \

--file ./src/utils.js

- Interaksi gaya sembang, Gunakan Qwen dalam mod "sembang", sesuai untuk dialog pengekodan berbilang giliran:

qwen chat \

--model qwen3-coder-plus \

--system "You are a helpful coding assistant." \

--user "Generate a REST API endpoint in Express.js for user authentication."

Bagaimana Anda Menggunakan Qwen3-Coder melalui API CometAPI?

CometAPI ialah platform API bersatu yang mengagregatkan lebih 500 model AI daripada pembekal terkemuka—seperti siri GPT OpenAI, Google Gemini, Anthropic's Claude, Midjourney, Suno dan banyak lagi—menjadi satu antara muka mesra pembangun. Dengan menawarkan pengesahan yang konsisten, pemformatan permintaan dan pengendalian respons, CometAPI secara dramatik memudahkan penyepaduan keupayaan AI ke dalam aplikasi anda. Sama ada anda sedang membina chatbots, penjana imej, komposer muzik atau saluran paip analitik terdorong data, CometAPI membolehkan anda mengulangi dengan lebih pantas, mengawal kos dan kekal sebagai vendor-agnostik—semuanya sambil memanfaatkan penemuan terkini merentas ekosistem AI.

Jika anda pengguna cometAPI, anda boleh log masuk ke cometapi untuk mendapatkan kunci dan url asas dan log masuk ke cometapi untuk mendapatkan kunci dan url asas,rujuk API Qwen3-Coder.Untuk bermula, terokai keupayaan model dalam Taman Permainan dan berunding dengan Panduan API untuk arahan terperinci.

Untuk memanggil Qwen3‑Coder melalui CometAPI, anda menggunakan titik akhir serasi OpenAI yang sama seperti mana-mana model lain—hanya halakan pelanggan anda ke URL asas CometAPI, tunjukkan kunci CometAPI anda sebagai token Pembawa, dan nyatakan sama ada qwen3-coder-plus or qwen3-coder-480b-a35b-instruct model.

1. Prasyarat

- Daftar at https://cometapi.com dan tambah/jana token API dalam papan pemuka anda.

- Perhatikan anda Kunci API (bermula dengan

sk-…). - Kebiasaan dengan protokol OpenAI Chat API (peranan + mesej).

2. URL asas & Pengesahan

URL asas:

arduinohttps://api.cometapi.com/v1

Titik akhir:

bashPOST https://api.cometapi.com/v1/chat/completions

3. CURL / REHAT Contoh

curl https://api.cometapi.com/v1/chat/completions \

-H "Authorization: Bearer sk-xxxxxxxxxxxx" \

-H "Content-Type: application/json" \

-d '{

"model": "qwen3-coder-plus",

"messages": [

{ "role": "system", "content": "You are a helpful coder." },

{ "role": "user", "content": "Generate a SQL query to find duplicate emails." }

],

"temperature": 0.7,

"max_tokens": 512

}'

- Tindak balas: JSON dengan

choices.message.contentmengandungi kod yang dihasilkan.

Bagaimanakah anda memanfaatkan keupayaan agen Qwen3-Coder?

Ciri agen Qwen3-Coder mendayakan penggunaan alat dinamik dan aliran kerja berbilang langkah autonomi, membolehkan model memanggil fungsi luaran atau API semasa penjanaan kod.

Seruan alat dan alat tersuai

Tentukan alatan tersuai—seperti linter, pelari ujian atau pemformat—dalam pangkalan kod anda dan dedahkannya kepada model melalui skema fungsi. Contohnya:

tools = [

{"name":"run_tests","description":"Execute the test suite and return results","parameters":{}},

{"name":"format_code","description":"Apply black formatter to the code","parameters":{}}

]

response = client.chat.completions.create(

messages=,

functions=tools,

function_call="auto"

)

Qwen3-Coder kemudiannya boleh menjana, memformat dan mengesahkan kod secara autonomi dalam satu sesi, mengurangkan overhed penyepaduan manual ().

Menggunakan Qwen Code CLI

. qwen-code alat baris arahan menawarkan REPL interaktif untuk pengekodan agen:

qwen-code --model qwen3-coder-480b-a35b-instruct

> generate: "Create a REST API in Node.js with JWT authentication."

> tool: install_package(express)

> tool: create_file(app.js)

> tool: run_tests

CLI ini mengatur aliran kerja yang kompleks dengan log telus, menjadikannya sesuai untuk prototaip penerokaan atau menyepadukan ke dalam saluran paip CI/CD.

Adakah Qwen3-Coder Sesuai untuk Pangkalan Kod Besar?

Terima kasih kepada tetingkap konteks lanjutannya, Qwen3-Coder boleh menelan keseluruhan repositori—sehingga ratusan ribu baris kod—sebelum menghasilkan tampalan atau pemfaktoran semula. Keupayaan ini membolehkan refactor global, analitik silang modul dan cadangan seni bina yang model konteks yang lebih kecil tidak boleh dipadankan.

Apakah Amalan Terbaik untuk Memaksimumkan Utiliti Qwen3-Coder?

Mengguna pakai Qwen3-Coder dengan berkesan memerlukan konfigurasi dan penyepaduan yang bijak ke dalam saluran paip CI/CD anda.

Bagaimana Anda Harus Menala Tetapan Pensampelan dan Rasuk?

- suhu: 0.6–0.8 untuk kreativiti seimbang; lebih rendah (0.2–0.4) untuk tugas pemfaktoran semula deterministik.

- atas‑p: 0.7–0.9 untuk memfokuskan pada sambungan yang paling berkemungkinan sambil membenarkan cadangan novel sekali-sekala.

- Atas‑k: 20–50 untuk kegunaan standard; kurangkan kepada 5–10 apabila mencari output yang sangat fokus.

- Penalti Ulangan: 1.05–1.1 untuk tidak menggalakkan model daripada mengulangi corak plat dandang.

Mengeksperimen dengan parameter ini selaras dengan toleransi projek anda terhadap variasi boleh menghasilkan keuntungan produktiviti yang ketara .

Apakah amalan terbaik untuk menggunakan Qwen3-Coder dengan berkesan?

Kejuruteraan Pantas untuk Kualiti Kod

- Menjadi spesifik: Tentukan bahasa, garis panduan gaya dan kerumitan yang diingini dalam gesaan anda.

- Penapisan berulang: Gunakan keupayaan agen model untuk menyahpepijat secara berulang dan mengoptimumkan kod yang dijana.

- Penalaan Suhu: Turunkan suhu penjanaan (cth,

temperature=0.2) untuk keluaran yang lebih deterministik dalam konteks pengeluaran.

Menguruskan Penggunaan Sumber

- Varian Model: Mulakan dengan varian Qwen3-Coder yang lebih kecil untuk prototaip, kemudian naikkan mengikut keperluan.

- Kuantiti Dinamik: Eksperimen dengan pusat pemeriksaan terkuantiti FP8 dan GGUF untuk mengurangkan jejak memori GPU tanpa penurunan prestasi yang ketara.

- Penjanaan Asynchronous: Muat turun penjanaan kod yang telah lama berjalan ke pekerja latar belakang untuk mengekalkan responsif.

Mematuhi garis panduan ini memastikan anda memaksimumkan ROI untuk menyepadukan Qwen3-Coder ke dalam kitaran hayat pembangunan perisian anda.

Dengan mengikuti panduan di atas—memahami seni binanya, memasang dan mengkonfigurasi kedua-dua model dan Qwen Code CLI, serta memanfaatkan amalan terbaik—anda akan dilengkapi dengan baik untuk memanfaatkan potensi penuh Qwen3‑Coder untuk apa-apa sahaja daripada coretan kod ringkas kepada ejen pengaturcaraan autonomi sepenuhnya.