Pelancaran GLM-5, yang didedahkan minggu ini oleh Zhipu AI dari China (dibrandkan secara umum sebagai Z.AI / zai-org di banyak saluran pembangun), menandakan satu lagi langkah dalam rentak pelancaran model besar yang semakin pantas. Model baharu ini diposisikan sebagai produk utama Zhipu: berskala lebih besar, ditala untuk tugasan agentik jangka panjang, dan dibina dengan pilihan kejuruteraan yang bertujuan mengurangkan kos inferens sambil mengekalkan konteks panjang. Laporan awal industri dan nota pembangun praktikal menunjukkan peningkatan bermakna dalam pengkodan, penaakulan berbilang langkah dan orkestrasi agen berbanding iterasi GLM sebelumnya — dan dalam sesetengah ujian ia malah mencabar Claude 4.5.

Apakah GLM-5 dan siapa yang membinanya?

GLM-5 ialah keluaran utama terkini dalam keluarga GLM: model asas berskala besar sumber terbuka yang dibangunkan dan diterbitkan oleh Z.ai (pasukan di sebalik siri GLM). Diumumkan pada awal Februari 2026, GLM-5 dibentangkan sebagai model generasi seterusnya yang khusus ditala untuk tugasan “agentik” — iaitu aliran kerja berbilang langkah dan berjulat panjang di mana model perlu merancang, memanggil alat, melaksanakan, dan mengekalkan konteks bagi perbualan panjang atau agen automatik. Keluaran ini menonjol bukan sahaja pada reka bentuk model tetapi juga pada cara dan tempat ia dilatih: Z.ai menggunakan gabungan perkakasan dan rantaian alat domestik China sebagai sebahagian daripada dorongan ke arah berdikari.

Angka seni bina dan latihan yang dilaporkan termasuk:

- Penskalaan parameter: GLM-5 menskala sehingga kira-kira 744B parameter (dengan kiraan pakar “aktif” yang lebih kecil disebut dalam beberapa nota teknikal, cth., 40B aktif), berbanding saiz keluarga GLM-4 terdahulu sekitar 355B/32B aktif.

- Data pra-latihan: Saiz korpus latihan dilaporkan meningkat daripada ~23 trilion token (generasi GLM-4) kepada ~28.5 trilion token untuk GLM-5.

- Perhatian jarang / DeepSeek Sparse Attention (DSA): Skema perhatian jarang untuk mengekalkan konteks panjang sambil mengurangkan kos pengiraan semasa inferens.

- Penekanan reka bentuk: pilihan kejuruteraan yang memfokuskan pada orkestrasi agen, penaakulan konteks panjang, dan inferens kos efektif.

Asal-usul dan pemposisian

GLM-5 dibina berasaskan rangkaian yang merangkumi GLM-4.5 (dikeluarkan pada pertengahan 2025) dan beberapa kemas kini berulang seperti 4.7. Z.ai memposisikan GLM-5 sebagai lonjakan daripada "vibe coding" (keluaran kod pantas satu langkah) ke arah “kejuruteraan agentik”: penaakulan berterusan, orkestrasi pelbagai alat, dan sintesis sistem merentasi tetingkap konteks panjang. Bahan awam menekankan bahawa GLM-5 direka untuk menangani tugasan kejuruteraan sistem yang kompleks — membina, menyelaras, dan mengekalkan tingkah laku agen berbilang langkah dan bukannya sekadar menjawab pertanyaan terpencil.

Apakah ciri baharu dalam GLM-5?

Perubahan seni bina utama

- Penskalaan jarang berskala besar (MoE): GLM-5 beralih kepada seni bina Mixture-of-Experts jarang yang jauh lebih besar. Angka awam daripada halaman pembangun dan penulisan bebas menyenaraikan model ini sekitar 744B jumlah parameter dengan ~40B aktif per token — satu lonjakan ketara daripada konfigurasi GLM-4.5 ~355B / 32B aktif. Penskalaan jarang ini membolehkan model menampilkan kapasiti keseluruhan yang sangat besar sambil mengekalkan pengiraan per token yang terkawal.

- DeepSeek Sparse Attention (DSA): Untuk mengekalkan keupayaan konteks panjang tanpa menskala kos inferens secara linear, GLM-5 mengintegrasikan mekanisme perhatian jarang (berjenama DeepSeek) bagi mengekalkan pergantungan jarak jauh yang penting pada skala sambil memangkas kos perhatian ke atas konteks ultra-panjang.

Kejuruteraan agentik sebagai matlamat reka bentuk asas

Salah satu tajuk utama GLM-5 ialah ia direka secara eksplisit untuk kejuruteraan agentik — bermakna model ini bertujuan digunakan bukan sekadar untuk sembang satu pusingan atau tugasan ringkasan tetapi sebagai “otak” kepada agen berbilang langkah yang boleh merancang, membuat panggilan alat, mengurus keadaan, dan menaakul merentasi konteks panjang. Z.ai memposisikan GLM-5 untuk berkhidmat dalam gelung orkestrasi: memecahkan masalah kompleks, memanggil alat/API luaran, dan menjejak tugasan panjang merentasi banyak pusingan.

Mengapa reka bentuk agentik penting

Aliran kerja agentik adalah teras kepada automasi dunia sebenar: pembantu penyelidikan automatik, jurutera perisian autonomi, orkestrasi operasi, dan kawalan simulasi. Model yang dibina untuk dunia ini memerlukan perancangan yang kukuh, tingkah laku panggilan alat yang stabil, dan ketahanan merentasi ribuan token konteks.

Penambahbaikan pengkodan, penaakulan dan tingkah laku “jangka panjang”

GLM-5 menekankan penjanaan kod dan penaakulan yang dipertingkat. Z.ai mendakwa peningkatan disasarkan pada keupayaan model untuk menulis, merombak, dan menyahpepijat kod, serta penaakulan berbilang langkah yang lebih konsisten merentas interaksi panjang. Laporan akses awal bebas dan penilaian rakan kongsi mendapati model ini jauh lebih kuat untuk tugasan berorientasikan pembangun daripada generasi GLM sebelumnya.

Ciri praktikal untuk pembangun

- Tetingkap konteks yang lebih besar untuk memuatkan dokumentasi, pangkalan kod, dan keadaan perbualan.

- Primitif alat untuk jemputan alat yang selamat dan pengendalian hasil.

- Prestasi few-shot dan chain-of-thought yang lebih baik untuk menghuraikan dan melaksanakan tugasan kompleks.

- Ciri agentik dan panggilan alat: GLM-5 menekankan sokongan asli untuk agen: panggilan fungsi/alat, sesi berkeadaan, dan pengurusan dialog panjang serta jujukan penggunaan alat yang lebih baik. Ini memudahkan pembinaan agen yang mengintegrasikan carian web, pangkalan data atau automasi tugasan.

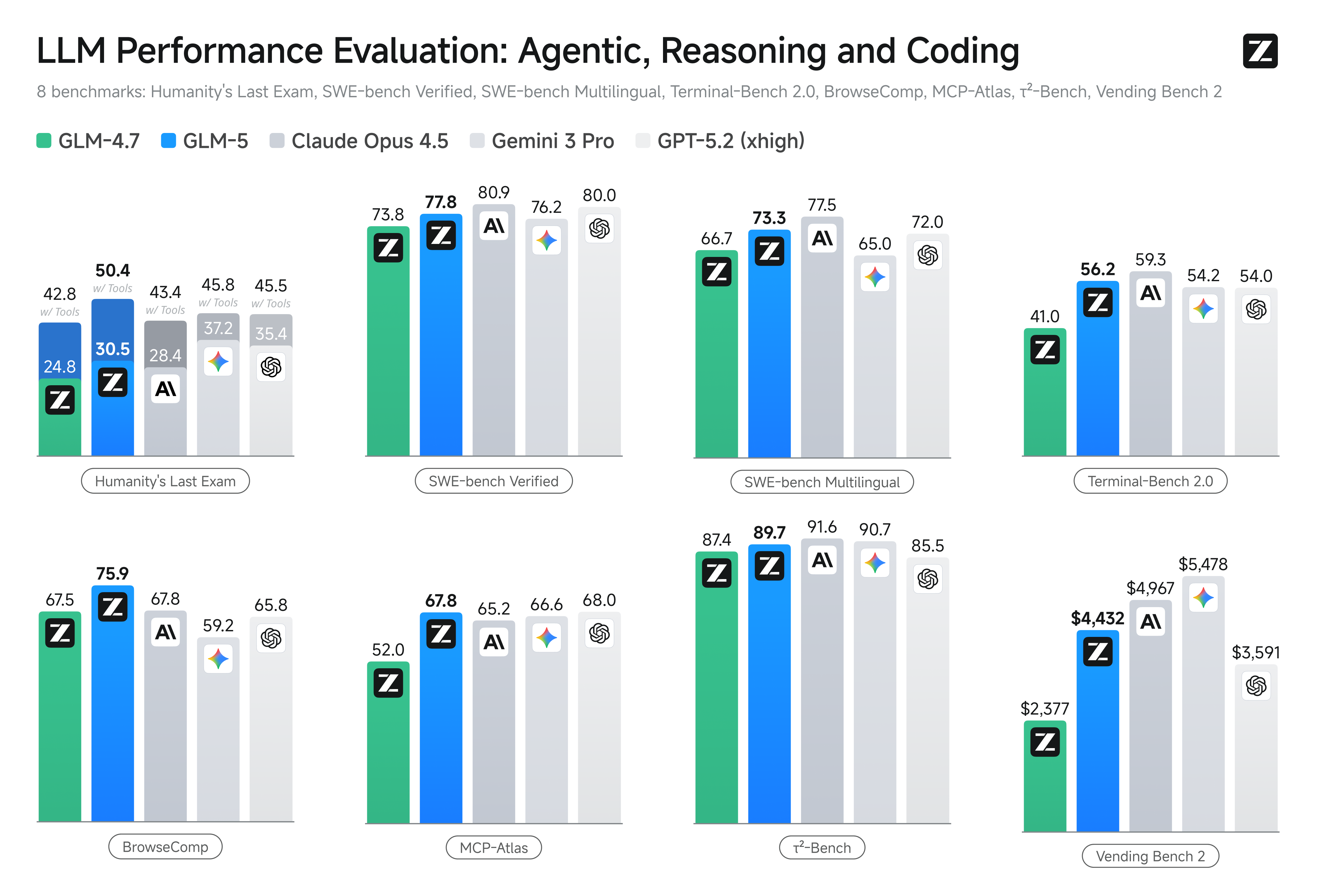

Bagaimana GLM-5 berprestasi pada penanda aras?

Sorotan penanda aras khusus

- Penanda aras pengkodan: GLM-5 menghampiri (dan dalam beberapa kes, menyamai) prestasi pengkodan model proprietari yang dioptimumkan tinggi seperti Claude Opus 4.5 dari Anthropic pada tugasan pengkodan tertentu. Keputusan ini bergantung kepada tugasan (ujian unit, pengkodan algoritma, penggunaan API), tetapi ia menandakan peningkatan jelas berbanding GLM-4.5.

- Ujian penaakulan dan agentik: Pada set penilaian penaakulan berbilang langkah dan agentik (cth., perancangan berbilang pusingan, penanda aras penghuraian tugasan), GLM-5 mencapai keputusan terbaik dalam kelas untuk model sumber terbuka dan pada sesetengah metrik mengatasi model tertutup yang bersaing pada tugasan yang disasarkan.

Bagaimana saya mengakses dan mencuba GLM-5?

GLM-5 ialah model bahasa besar generasi kelima daripada Zhipu AI (Z.ai), dibina dengan seni bina Mixture-of-Experts (~745 B jumlah, ~44 B aktif) dan disasarkan kepada penaakulan, pengkodan, dan aliran kerja agentik yang kukuh. Ia dilancarkan secara rasmi sekitar 12 Feb 2026.

Pada masa ini terdapat dua cara utama untuk mengaksesnya:

A) Akses API Rasmi (Z.ai atau Pengagregat)

Zhipu AI sendiri menawarkan API untuk modelnya, dan anda boleh memanggil GLM-5 melalui API tersebut.

Langkah biasa:

- Daftar akaun API Z.ai/Open BigModel.

- Dapatkan kunci API daripada papan pemuka.

- Gunakan titik akhir OpenAPI atau REST dengan nama model (cth.,

glm-5).

(Sama seperti cara anda memanggil model GPT daripada OpenAI). - Tetapkan prom dan hantar permintaan HTTP.

👉 Halaman harga Z.ai menunjukkan harga token rasmi GLM-5 seperti:

- ~$1.0 bagi setiap sejuta token input

- ~$3.2 bagi setiap sejuta token output

B) Pembalut API Pihak Ketiga ——CometAPI

API seperti CometAPI atau WaveSpeed membalut pelbagai model AI (OpenAI, Claude, Z.ai dll.) di sebalik antara muka bersatu.

- Dengan perkhidmatan seperti CometAPI anda boleh memanggil model GLM dengan menukar ID model.

(CometAPI kini menyokong GLM-5/GLM-4.7.) - glm-5 CometAPI berharga pada 20% daripada harga rasmi.

| Jenis penggunaan | Harga |

|---|---|

| Token input | ~$0.8 setiap 1M token |

| Token output | ~$2.56 setiap 1M token |

Mengapa ini penting: Anda mengekalkan kod klien serasi OpenAI sedia ada dan hanya menukar URL asas/ID model.

C) Hos Sendiri melalui Hugging Face / Weights

Terdapat repositori pemberat GLM-5 yang tidak rasmi (cth., versi bernama glm-5/glm-5-fp8) yang kelihatan dalam senarai model Hugging Face.

Dengan itu anda boleh:

- Muat turun pemberat model.

- Gunakan alat seperti vLLM, SGLang, xLLM, atau Transformers untuk melayan secara tempatan atau pada armada GPU awan anda.

Kelebihan: kawalan maksimum, tiada kos API berterusan.

Kekurangan: keperluan pengiraan yang sangat besar — berkemungkinan berbilang GPU berprestasi tinggi dan memori (beberapa ratus GB), menjadikannya tidak praktikal pada sistem kecil.

Jadi — adakah GLM-5 berbaloi, dan patutkah anda kekalkan GLM-4.7?

Jawapan ringkas (ringkasan eksekutif)

- Jika kerja anda memerlukan tingkah laku agentik berbilang langkah yang mantap, penjanaan kod gred produksi, atau automasi peringkat sistem: GLM-5 berbaloi untuk dinilai serta-merta. Seni bina, skala dan talaannya memprioritaskan hasil ini.

- Jika anda perlukan mikroservis berkapasiti tinggi yang kos efektif (sembang pendek, pengelasan, prom ringan): GLM-4.7 berkemungkinan kekal sebagai pilihan paling ekonomik. GLM-4.7 mengekalkan set keupayaan yang kukuh pada kos per token yang jauh lebih rendah dalam banyak senarai penyedia dan telah terbukti di lapangan.

Jawapan lebih panjang (cadangan praktikal)

Guna strategi model bertingkat: gunakan GLM-4.7 untuk interaksi harian berjumlah tinggi dan simpan GLM-5 untuk masalah kejuruteraan bernilai tinggi dan orkestrasi agentik. Rintis GLM-5 pada sebahagian kecil produk yang menguji konteks panjang, integrasi peralatan dan ketepatan kod; ukur masa kejuruteraan yang dijimatkan dan kos model tambahan. Dari masa ke masa, anda akan tahu sama ada lonjakan keupayaan GLM-5 membenarkan migrasi yang lebih meluas.

Dengan CometAPI, anda boleh bertukar antara GLM-4.7 dan GLM-5 pada bila-bila masa.

Kes penggunaan dunia sebenar di mana GLM-5 menonjol

1. Orkestrasi agen yang kompleks

Fokus reka bentuk GLM-5 pada perancangan berbilang langkah dan panggilan alat menjadikannya sesuai untuk sistem yang mesti menyelaras carian, panggilan API, dan pelaksanaan program (contohnya: pembantu penyelidikan automatik, penjana kod iteratif, atau agen khidmat pelanggan berbilang langkah yang mesti merujuk pangkalan data dan API luaran).

2. Kejuruteraan bentuk panjang & penaakulan pangkalan kod

Apabila anda memerlukan model untuk menganalisis, merombak, atau mensintesis merentasi banyak fail atau pangkalan kod besar, konteks lanjutan GLM-5 dan perhatian jarangnya memberikan kelebihan langsung — kurang mod kegagalan akibat konteks terpotong dan konsistensi rentang panjang yang lebih baik.

3. Sintesis berintensif pengetahuan

Penganalisis dan pasukan produk yang menjana laporan kompleks — ringkas penyelidikan berbilang seksyen, ringkasan undang-undang, atau pemfailan peraturan — boleh mendapat manfaat daripada penambahbaikan model dalam penaakulan berbilang langkah yang stabil dan pengurangan halusinasi dalam ujian yang dilaporkan vendor.

4. Automasi agentik untuk aliran kerja

Pasukan yang membina automasi yang mesti mengorkestrasi pelbagai sistem (cth., perancangan + tiket + saluran penyebaran) boleh menggunakan GLM-5 sebagai perancang dan pelaksana pusat, disokong oleh rangka kerja panggilan alat dan pembungkus keselamatan.

Kesimpulan

GLM-5 ialah keluaran penting dalam landskap model barisan hadapan yang berkembang pesat. Penekanan pada kejuruteraan agentik, pengkodan dan penaakulan yang dipertingkat, serta ketersediaan pemberat terbuka menjadikannya menarik untuk pasukan yang membina sistem AI berdaya alat dan berjulat panjang. Terdapat keuntungan nyata pada tugasan terpilih dan pertukaran kos/prestasi yang memberangsangkan — namun pembeli harus menilai GLM-5 terhadap tugasan khusus mereka dan menjalankan penanda aras terkawal sendiri sebelum komited ke produksi.

Pembangun boleh mengakses GLM-5 melalui CometAPI sekarang.Untuk memulakan, terokai keupayaan model dalam Playground dan rujuk panduan API untuk arahan terperinci. Sebelum mengakses, pastikan anda telah log masuk ke CometAPI dan memperoleh kunci API. CometAPI menawarkan harga yang jauh lebih rendah daripada harga rasmi untuk membantu anda mengintegrasi.

Sedia untuk bermula?→ Daftar untuk glm-5 hari ini !

Jika anda mahu mengetahui lebih banyak tip, panduan dan berita tentang AI ikuti kami di VK, X dan Discord!