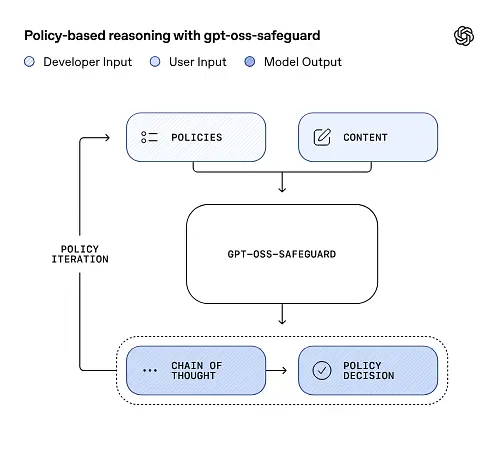

OpenAI menerbitkan pratonton penyelidikan gpt-oss-safeguard, keluarga model inferens berat terbuka yang direkayasa untuk membolehkan pembangun menguatkuasakan mereka sendiri dasar keselamatan pada masa inferens. Daripada menghantar pengelas tetap atau enjin penyederhanaan kotak hitam, model baharu ini diperhalusi sebab daripada dasar yang disediakan oleh pemaju, mengeluarkan rantaian pemikiran (CoT) yang menerangkan alasan mereka, dan menghasilkan output klasifikasi berstruktur. Diumumkan sebagai pratonton penyelidikan, gpt-oss-safeguard dibentangkan sebagai sepasang model penaakulan—gpt-oss-safeguard-120b and gpt-oss-safeguard-20b—ditala halus daripada keluarga gpt-oss dan direka bentuk secara eksplisit untuk melaksanakan klasifikasi keselamatan dan tugas penguatkuasaan dasar semasa inferens.

Apakah gpt-oss-safeguard?

gpt-oss-safeguard ialah sepasang model penaakulan berwajaran terbuka, teks sahaja yang telah dilatih selepas daripada keluarga gpt-oss kepada mentafsir dasar yang ditulis dalam bahasa semula jadi dan melabelkan teks mengikut dasar tersebut. Ciri yang membezakannya ialah dasar itu disediakan pada masa inferens (dasar-sebagai-input), tidak dimasukkan ke dalam pemberat pengelas statik. Model ini direka bentuk terutamanya untuk tugas klasifikasi keselamatan—cth, penyederhanaan berbilang dasar, klasifikasi kandungan merentas berbilang rejim kawal selia atau semakan pematuhan dasar.

Mengapa ini penting

Sistem penyederhanaan tradisional biasanya bergantung pada (a) set peraturan tetap yang dipetakan kepada pengelas yang dilatih pada contoh berlabel, atau (b) heuristik / regeks untuk pengesanan kata kunci. gpt-oss-safeguard cuba mengubah paradigma: bukannya melatih semula pengelas setiap kali dasar berubah, anda membekalkan teks dasar (contohnya, dasar penggunaan boleh diterima syarikat anda, TOS platform atau garis panduan pengawal selia) dan alasan model tentang sama ada bahagian kandungan tertentu melanggar dasar tersebut. Ini menjanjikan ketangkasan (perubahan dasar tanpa latihan semula) dan kebolehtafsiran (model mengeluarkan rantaian penaakulannya).

Inilah falsafah terasnya—"Menggantikan hafalan dengan penaakulan, dan meneka dengan penjelasan."

Ini mewakili peringkat baharu dalam keselamatan kandungan, beralih daripada "peraturan belajar secara pasif" kepada "memahami peraturan secara aktif."

gpt-oss-safeguard boleh membaca terus dasar keselamatan yang ditakrifkan oleh pembangun dan mengikut dasar tersebut untuk membuat pertimbangan semasa inferens.

Bagaimanakah gpt-oss-safeguard berfungsi?

Penaakulan dasar sebagai input

Pada masa inferens, anda menyediakan dua perkara: yang teks dasar dan juga kandungan calon untuk dilabelkan. Model ini menganggap dasar sebagai arahan utama dan kemudian melakukan penaakulan langkah demi langkah untuk menentukan sama ada kandungan dibenarkan, tidak dibenarkan atau memerlukan langkah penyederhanaan tambahan. Pada inferens model:

- menghasilkan output berstruktur yang merangkumi kesimpulan (label, kategori, keyakinan) dan jejak penaakulan yang boleh dibaca manusia menjelaskan mengapa kesimpulan itu dicapai.

- mengambil dasar dan kandungan yang akan diklasifikasikan,

- membuat alasan dalaman melalui klausa dasar menggunakan langkah seperti rantaian pemikiran, dan

Sebagai contoh:

Policy: Content that encourages violence, hate speech, pornography, or fraud is not allowed.

Content: This text describes a fighting game.

Ia akan bertindak balas:

Classification: Safe

Reasoning: The content only describes the game mechanics and does not encourage real violence.

Chain-of-Thought (CoT) dan output berstruktur

gpt-oss-safeguard boleh mengeluarkan jejak CoT penuh sebagai sebahagian daripada setiap inferens. CoT bertujuan untuk diperiksa—pasukan pematuhan boleh membaca sebab model itu mencapai kesimpulan, dan jurutera boleh menggunakan jejak itu untuk mendiagnosis kekaburan dasar atau mod kegagalan model. Model juga menyokong keluaran berstruktur—contohnya, JSON yang mengandungi keputusan, bahagian dasar yang dilanggar, skor keterukan dan tindakan pemulihan yang dicadangkan—menjadikan ia mudah untuk disepadukan ke dalam saluran paip penyederhanaan.

Tahap "usaha penaakulan" yang boleh dilaraskan

Untuk mengimbangi kependaman, kos dan ketelitian, model menyokong usaha penaakulan yang boleh dikonfigurasikan: rendah / sederhana / tinggi. Usaha yang lebih tinggi meningkatkan kedalaman rantaian pemikiran dan secara amnya menghasilkan inferens yang lebih teguh, tetapi lebih perlahan dan lebih mahal. Ini membolehkan pembangun mencuba beban kerja—menggunakan usaha rendah untuk kandungan rutin dan usaha tinggi untuk kes tepi atau kandungan berisiko tinggi.

Apakah struktur model dan apakah versi yang wujud?

Model keluarga dan keturunan

gpt-oss-safeguard adalah lepas terlatih varian OpenAI sebelum ini gpt-oss model terbuka. Keluarga perlindungan pada masa ini termasuk dua saiz yang dikeluarkan:

- gpt-oss-safeguard-120b — model parameter 120 bilion yang bertujuan untuk tugas penaakulan ketepatan tinggi yang masih berjalan pada satu GPU 80GB dalam masa jalan yang dioptimumkan.

- gpt-oss-safeguard-20b — model parameter 20-bilion yang dioptimumkan untuk inferens kos rendah dan persekitaran tepi atau di-prem (boleh dijalankan pada peranti VRAM 16GB dalam beberapa konfigurasi).

Nota seni bina dan ciri masa jalan (apa yang diharapkan)

- Parameter aktif setiap token: Seni bina gpt-oss asas menggunakan teknik yang mengurangkan bilangan parameter yang diaktifkan setiap token (campuran reka bentuk gaya perhatian padat dan jarang / campuran pakar dalam gpt-oss induk).

- boleh dikatakan, kelas 120B sesuai dengan pemecut besar tunggal dan kelas 20B direka bentuk untuk beroperasi pada persediaan VRAM 16GB dalam masa jalan yang dioptimumkan.

Model perlindungan adalah tidak dilatih dengan data biologi atau keselamatan siber tambahan, dan analisis senario penyalahgunaan kes terburuk yang dilakukan untuk keluaran gpt-oss secara kasar digunakan pada varian perlindungan. Model ini bertujuan untuk pengelasan dan bukannya penjanaan kandungan untuk pengguna akhir.

Apakah matlamat gpt-oss-safeguard

Anda

- Fleksibiliti dasar: benarkan pembangun mentakrifkan sebarang dasar dalam bahasa semula jadi dan minta model itu menggunakannya tanpa pengumpulan label tersuai.

- Kebolehjelasan: dedahkan penaakulan supaya keputusan boleh diaudit dan dasar diulang.

- Kebolehcapaian: menyediakan alternatif berwajaran terbuka supaya organisasi boleh menjalankan penaakulan keselamatan secara tempatan dan memeriksa dalaman model.

Perbandingan dengan pengelas klasik

Pengelas kebaikan berbanding tradisional

- Tiada latihan semula untuk perubahan dasar: Jika dasar penyederhanaan anda berubah, kemas kini dokumen dasar dan bukannya mengumpul label dan melatih semula pengelas.

- Penaakulan yang lebih kaya: Output CoT boleh mendedahkan interaksi dasar yang halus dan memberikan justifikasi naratif yang berguna kepada penyemak manusia.

- Kebolehubahsuaian: Model tunggal boleh menggunakan banyak dasar berbeza secara serentak semasa inferens.

Keburukan berbanding pengelas tradisional

- Siling prestasi untuk beberapa tugas: Penilaian OpenAI menyatakan bahawa pengelas berkualiti tinggi yang dilatih pada puluhan ribu contoh berlabel boleh mengatasi prestasi gpt-oss-safeguard pada tugas klasifikasi khusus. Apabila objektifnya ialah ketepatan pengelasan mentah dan anda telah melabelkan data, pengelas khusus yang dilatih mengenai pengedaran itu boleh menjadi lebih baik.

- Latensi dan kos: Penaakulan dengan CoT adalah intensif pengiraan dan lebih perlahan daripada pengelas ringan; ini boleh menjadikan saluran paip berasaskan perlindungan semata-mata mahal pada skala.

Pendek kata: gpt-oss-safeguard paling sesuai digunakan di mana ketangkasan dan kebolehauditan dasar adalah keutamaan atau apabila data berlabel adalah terhad — dan sebagai komponen pelengkap dalam saluran paip hibrid, tidak semestinya sebagai pengganti drop-in untuk pengelas yang dioptimumkan skala.

Bagaimanakah prestasi gpt-oss-safeguard dalam penilaian OpenAI?

OpenAI menerbitkan keputusan asas dalam laporan teknikal 10 halaman yang meringkaskan penilaian dalaman dan luaran. Pengambilan utama (metrik yang dipilih, menanggung beban):

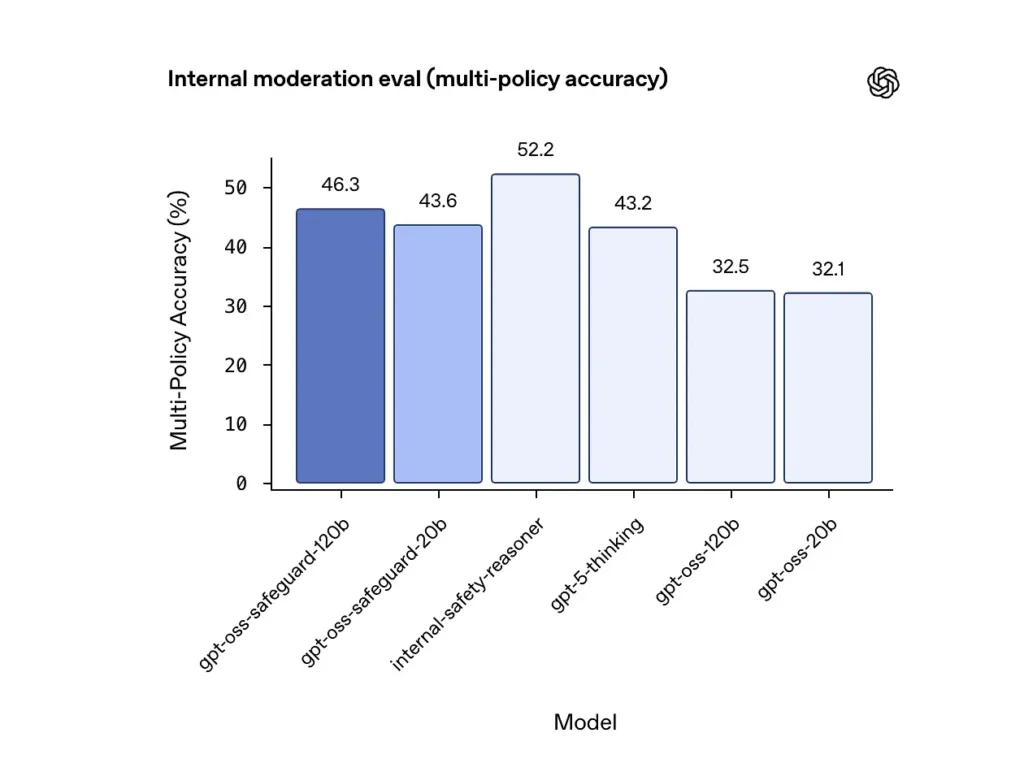

Ketepatan pelbagai dasar (penilaian dalaman)

OpenAI menilai ketepatan pelbagai dasar dengan memberikan model pelbagai dasar serentak dan mengira ramalan sebagai betul hanya jika ia sepadan dengan label emas di seluruh semua dasar. Keputusan:

- gpt-oss-safeguard-120b: 46.3% ketepatan pelbagai dasar

- gpt-oss-safeguard-20b: 43.6%

- Sebagai perbandingan: gpt-5-berfikir: 43.2%; gpt-oss-120b: 32.5%; gpt-oss-20b: 32.1%.

Ensembel dalaman "penalaran keselamatan" OpenAI mendapat markah 52.2% dalam ujian yang sama. Angka-angka ini menunjukkan model perlindungan mengatasi model asas gpt-oss mereka dengan ketara dalam tugas berbilang dasar, malah ia melebihi garis dasar pemikiran gpt-5 yang lebih besar dalam metrik berbilang dasar dalaman.

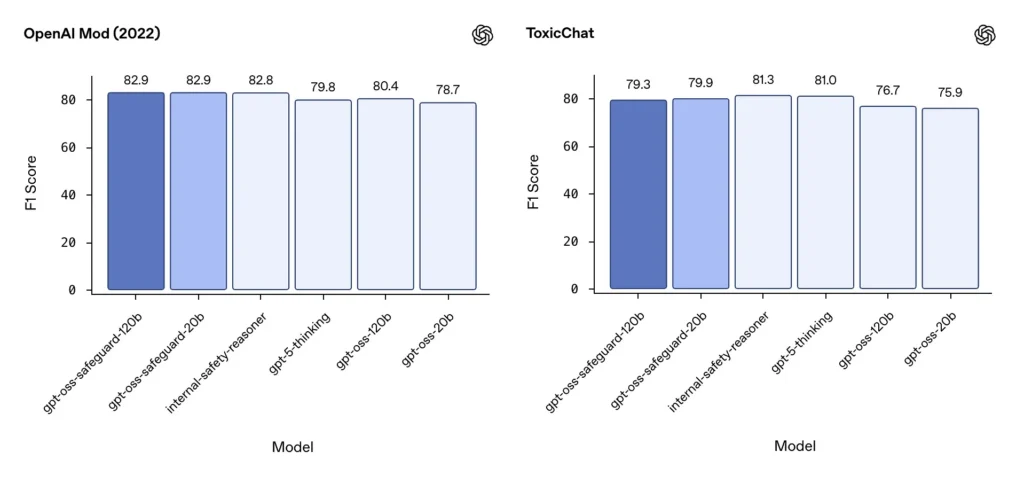

Kesederhanaan F1 (penanda aras luaran)

Pada set data penyederhanaan OpenAI 2022 dan penanda aras ToxicChat awam, model gpt-oss-safeguard mencapai skor F1 yang kukuh:

- Mod OpenAI (2022) F1: gpt-oss-safeguard-120b = 82.9% , gpt-oss-safeguard-20b = 82.9%

- ToxicChat F1: gpt-oss-safeguard-120b = 79.3% , gpt-oss-safeguard-20b = 79.9%

Markah ini meletakkan gpt-oss-safeguard berhampiran atau sedikit di belakang sistem dalaman OpenAI khusus pada beberapa penanda aras, dan secara amnya mendahului rakan sejawat gpt-oss yang tidak ditala.

Batasan yang diperhatikan

OpenAI menandakan dua batasan praktikal:

- Pengelas yang dilatih pada set data berlabel yang besar dan khusus tugasan masih boleh mengatasi model perlindungan apabila ketepatan klasifikasi adalah satu-satunya objektif.

- Kos pengiraan dan kependaman: Penaakulan CoT meningkatkan masa inferens dan penggunaan pengiraan, yang merumitkan penskalaan kepada trafik peringkat platform melainkan dipasangkan dengan pengelas triage dan saluran paip tak segerak.

Pariti berbilang bahasa

gpt-oss-safeguard berprestasi pada pariti dengan model gpt-oss yang mendasari merentas banyak bahasa dalam ujian gaya MMMLU, menunjukkan varian perlindungan yang diperhalusi mengekalkan keupayaan penaakulan yang luas.

Bagaimanakah pasukan boleh mengakses dan menggunakan gpt-oss-safeguard?

OpenAI menyediakan pemberat di bawah Apache 2.0 dan memautkan model untuk dimuat turun (Hugging Face). Oleh kerana gpt-oss-safeguard ialah model berat terbuka, penempatan setempat dan terurus sendiri (disyorkan untuk privasi dan penyesuaian)

- Muat turun berat model (dari OpenAI / Hugging Face) dan hoskannya pada pelayan atau VM awan anda sendiri. Apache 2.0 membenarkan pengubahsuaian dan penggunaan komersial.

- Runtime: Gunakan masa jalan inferens standard yang menyokong model pengubah besar (ONNX Runtime, Triton atau waktu jalan vendor yang dioptimumkan). Waktu tayangan komuniti seperti Ollama dan LM Studio sudah pun menambah sokongan untuk keluarga gpt-oss.

- perkakasan: 120B biasanya memerlukan GPU memori tinggi (cth, 80GB A100 / H100 atau multi-GPU sharding), manakala 20B boleh dijalankan dengan lebih murah dan mempunyai pilihan yang dioptimumkan untuk persediaan VRAM 16GB. Rancang kapasiti untuk pengeluaran puncak dan kos penilaian pelbagai dasar.

Masa jalan terurus dan pihak ketiga

Jika menjalankan perkakasan anda sendiri tidak praktikal, CometAPI sedang menambah sokongan untuk model gpt-oss dengan pantas. Platform ini mungkin menyediakan penskalaan yang lebih mudah tetapi memperkenalkan semula pertukaran pendedahan data pihak ketiga. Nilai privasi, SLA dan kawalan akses sebelum memilih masa jalan terurus.

Strategi penyederhanaan yang berkesan dengan gpt-oss-safeguard

1) Gunakan saluran paip hibrid (triage → reason → adjudicate)

- Lapisan triage: pengelas (atau peraturan) yang kecil dan pantas menapis kes remeh. Ini mengurangkan beban pada model perlindungan yang mahal.

- Lapisan perlindungan: jalankan gpt-oss-safeguard untuk semakan samar-samar, berisiko tinggi atau berbilang dasar di mana nuansa dasar penting.

- Penghakiman manusia: meningkatkan kes dan rayuan tepi, menyimpan CoT sebagai bukti untuk ketelusan. Reka bentuk hibrid ini mengimbangi pemprosesan dan ketepatan.

2) Kejuruteraan dasar (bukan kejuruteraan segera)

- Anggap dasar sebagai artifak perisian: versikannya, ujinya terhadap set data dan pastikan ia jelas dan hierarki.

- Tulis dasar dengan contoh dan contoh balas. Apabila boleh, sertakan arahan nyahkekaburan (cth, "Jika niat pengguna jelas penerokaan dan sejarah, labelkan sebagai X; jika niat beroperasi dan masa nyata, labelkan sebagai Y").

3) Konfigurasikan usaha penaakulan secara dinamik

- Penggunaan usaha yang rendah untuk pemprosesan pukal dan usaha yang tinggi untuk kandungan yang dibenderakan, rayuan atau menegak berimpak tinggi (undang-undang, perubatan, kewangan).

- Sesuaikan ambang dengan maklum balas semakan manusia untuk mencari titik manis kos/kualiti.

4) Sahkan CoT dan perhatikan penaakulan halusinasi

CoT adalah berharga, tetapi ia boleh berhalusinasi: jejak itu adalah rasional yang dijana model, bukan kebenaran asas. Audit output CoT secara rutin; pengesan instrumen untuk petikan halusinasi atau penaakulan yang tidak sepadan. OpenAI mendokumentasikan rantaian pemikiran halusinasi sebagai cabaran yang diperhatikan dan mencadangkan strategi mitigasi.

5) Bina set data daripada operasi sistem

Log keputusan model dan pembetulan manusia untuk mencipta set data berlabel yang boleh meningkatkan pengelas triage atau memaklumkan penulisan semula dasar. Dari masa ke masa, set data berlabel yang kecil dan berkualiti tinggi serta pengelas yang cekap selalunya mengurangkan pergantungan pada inferens CoT penuh untuk kandungan rutin.

6) Pantau pengiraan & kos; menggunakan aliran tak segerak

Untuk aplikasi kependaman rendah yang dihadapi pengguna, pertimbangkan semakan keselamatan tak segerak dengan UX konservatif jangka pendek (cth, menyembunyikan kandungan sementara menunggu semakan) dan bukannya melaksanakan CoT usaha tinggi secara serentak. OpenAI mencatatkan Safety Reasoner menggunakan aliran tak segerak secara dalaman untuk mengurus kependaman bagi perkhidmatan pengeluaran.

7) Pertimbangkan privasi dan lokasi penempatan

Oleh kerana pemberat terbuka, anda boleh menjalankan inferens sepenuhnya di premis untuk mematuhi tadbir urus data yang ketat atau mengurangkan pendedahan kepada API pihak ketiga—bernilai untuk industri terkawal.

Kesimpulan:

gpt-oss-safeguard ialah alat yang praktikal, telus dan fleksibel untuk alasan keselamatan yang didorong oleh dasar. Ia bersinar apabila anda perlukan keputusan yang boleh diaudit terikat dengan dasar yang jelas, apabila dasar anda kerap berubah atau apabila anda ingin memastikan pemeriksaan keselamatan di premis. Ia adalah tidak peluru perak yang akan menggantikan pengelas volum tinggi yang khusus secara automatik—penilaian OpenAI sendiri menunjukkan bahawa pengelas khusus yang dilatih pada korpora berlabel besar boleh mengatasi model ini pada ketepatan mentah untuk tugasan yang sempit. Sebaliknya, layan gpt-oss-safeguard sebagai komponen strategik: enjin penaakulan yang boleh dijelaskan di tengah-tengah seni bina keselamatan berlapis (triage pantas → alasan boleh dijelaskan → pengawasan manusia).

Bermula

CometAPI ialah platform API bersatu yang mengagregatkan lebih 500 model AI daripada pembekal terkemuka—seperti siri GPT OpenAI, Google Gemini, Anthropic's Claude, Midjourney, Suno dan banyak lagi—menjadi satu antara muka mesra pembangun. Dengan menawarkan pengesahan yang konsisten, pemformatan permintaan dan pengendalian respons, CometAPI secara dramatik memudahkan penyepaduan keupayaan AI ke dalam aplikasi anda. Sama ada anda sedang membina chatbots, penjana imej, komposer muzik atau saluran paip analitik terdorong data, CometAPI membolehkan anda mengulangi dengan lebih pantas, mengawal kos dan kekal sebagai vendor-agnostik—semuanya sambil memanfaatkan penemuan terkini merentas ekosistem AI.

Penyepaduan terbaharu gpt-oss-safeguard tidak lama lagi akan muncul di CometAPI, jadi nantikan! Sementara kami memuktamadkan muat naik Model gpt-oss-safeguard, pembangun boleh mengakses API GPT-OSS-20B and API GPT-OSS-120B melalui CometAPI, versi model terkini sentiasa dikemas kini dengan laman web rasmi. Untuk memulakan, terokai keupayaan model dalam Taman Permainan dan berunding dengan Panduan API untuk arahan terperinci. Sebelum mengakses, sila pastikan anda telah log masuk ke CometAPI dan memperoleh kunci API. CometAPI menawarkan harga yang jauh lebih rendah daripada harga rasmi untuk membantu anda menyepadukan.

Bersedia untuk Pergi?→ Daftar untuk CometAPI hari ini !

Jika anda ingin mengetahui lebih banyak petua, panduan dan berita tentang AI, ikuti kami VK, X and Perpecahan!