Kemajuan terbaru Alibaba dalam kecerdasan buatan, Qwen3-Pengekod, menandakan satu peristiwa penting dalam landskap pembangunan perisian dipacu AI yang berkembang pesat. Dilancarkan pada 23 Julai 2025, Qwen3-Coder ialah model pengekodan agen sumber terbuka yang direka untuk menangani tugas pengaturcaraan yang kompleks secara autonomi, daripada menjana kod boilerplate kepada nyahpepijat merentas keseluruhan pangkalan kod. Dibina pada seni bina campuran pakar (KPM) yang canggih dan mempunyai 480 bilion parameter dengan 35 bilion diaktifkan setiap token, model ini mencapai keseimbangan optimum antara prestasi dan kecekapan pengiraan. Dalam artikel ini, kami meneroka perkara yang membezakan Qwen3‑Coder, memeriksa prestasi penanda arasnya, membongkar inovasi teknikalnya, membimbing pembangun melalui penggunaan optimum dan mempertimbangkan penerimaan model dan prospek masa depan.

Apakah Qwen3‑Coder?

Qwen3‑Coder ialah model pengekodan agen terbaharu daripada keluarga Qwen, diumumkan secara rasmi pada 22 Julai 2025. Direka bentuk sebagai "model kod paling agenik setakat ini", varian utamanya, Qwen3‑Coder‑480B‑A35B‑Instruct, menampilkan 480 bilion parameter reka bentuk Ex-per-campuran (MoE) keseluruhan 35 bilion parameter setiap token. Ia secara asli menyokong tetingkap konteks sehingga 256K token dan menskalakan kepada satu juta token melalui teknik ekstrapolasi, menangani permintaan untuk pemahaman dan penjanaan kod skala repo.

Sumber terbuka di bawah Apache 2.0

Selaras dengan komitmen Alibaba terhadap pembangunan yang didorong oleh komuniti, Qwen3‑Coder dikeluarkan di bawah lesen Apache 2.0. Ketersediaan sumber terbuka ini memastikan ketelusan, memupuk sumbangan pihak ketiga dan mempercepatkan penerimaan dalam kedua-dua akademik dan industri. Penyelidik dan jurutera boleh mengakses pemberat yang telah dilatih dan memperhalusi model untuk domain khusus, daripada teknologi kewangan kepada pengkomputeran saintifik.

Evolusi daripada Qwen2.5

Membina kejayaan Qwen2.5‑Coder, yang menawarkan model antara 0.5B hingga 32B parameter dan mencapai keputusan SOTA merentas penanda aras penjanaan kod, Qwen3‑Coder memperluaskan keupayaan pendahulunya melalui skala yang lebih besar, saluran paip data yang dipertingkatkan dan rejim latihan baharu. Qwen2.5‑Coder telah dilatih mengenai lebih 5.5 trilion token dengan pembersihan data yang teliti dan penjanaan data sintetik; Qwen3‑Coder memajukan ini dengan menelan 7.5 trilion token dengan nisbah kod 70%, memanfaatkan model terdahulu untuk menapis dan menulis semula input yang bising untuk kualiti data yang unggul.

Apakah inovasi utama yang membezakan Qwen3-Coder?

Beberapa inovasi utama membezakan Qwen3-Coder:

- Orkestrasi Tugas Agen: Daripada hanya menjana coretan, Qwen3-Coder boleh merangkai secara autonomi berbilang operasi—membaca dokumentasi, menggunakan utiliti dan mengesahkan output—tanpa campur tangan manusia.

- Belanjawan Pemikiran Dipertingkatkan: Pembangun boleh mengkonfigurasi jumlah pengiraan yang dikhaskan untuk setiap langkah penaakulan, membolehkan pertukaran disesuaikan antara kelajuan dan ketelitian, yang penting untuk sintesis kod berskala besar.

- Penyepaduan Alat Lancar: Antara muka baris arahan Qwen3-Coder, “Kod Qwen,” menyesuaikan protokol panggilan fungsi dan gesaan tersuai untuk disepadukan dengan alatan pembangun yang popular, menjadikannya mudah untuk dibenamkan dalam saluran paip CI/CD dan IDE sedia ada.

Bagaimanakah prestasi Qwen3‑Coder berbanding pesaing?

Perlawanan penanda aras

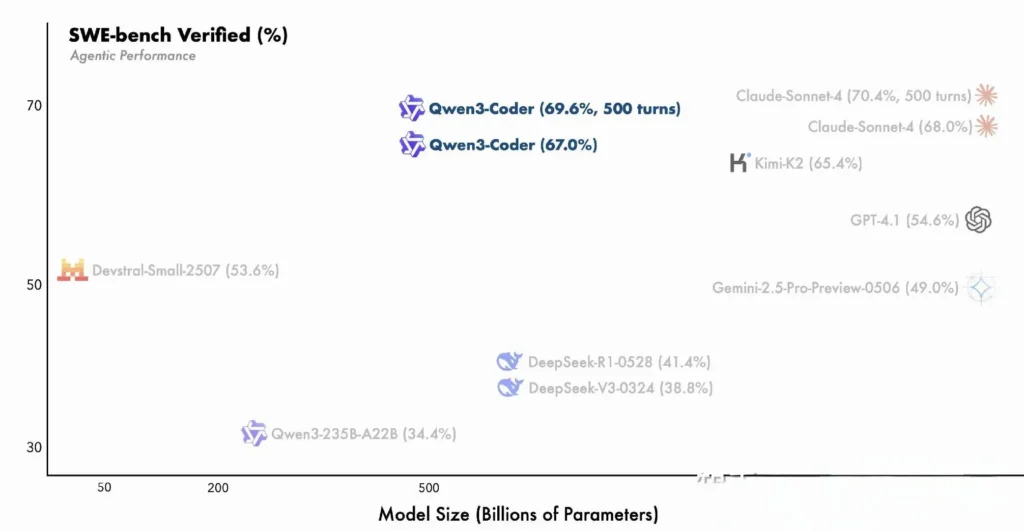

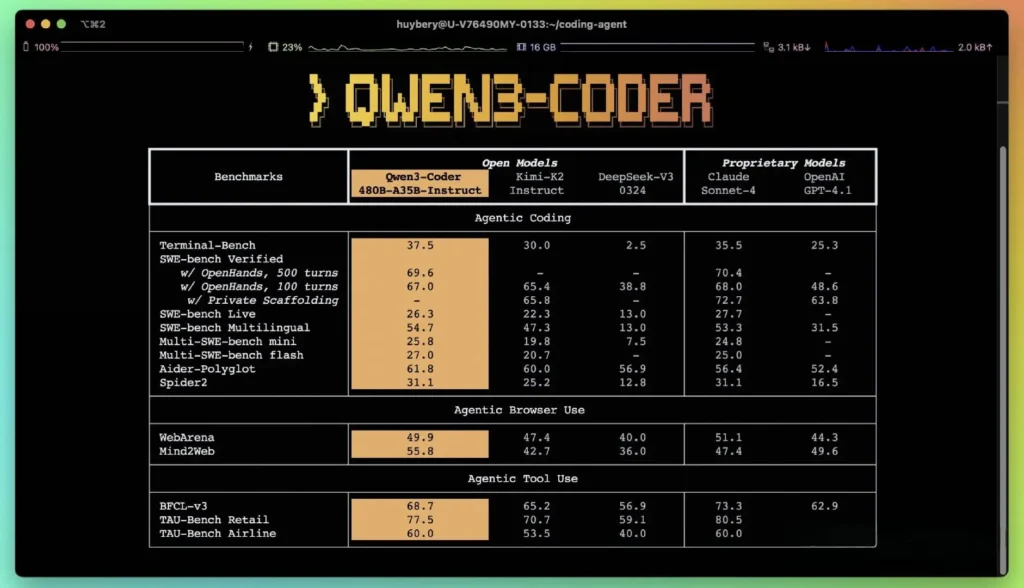

Menurut metrik prestasi Alibaba yang diterbitkan, Qwen3-Coder mengatasi alternatif domestik terkemuka—seperti model gaya codex DeepSeek dan K2 Moonshot AI—dan sepadan atau melebihi keupayaan pengekodan tawaran AS teratas, merentas beberapa penanda aras . Dalam penilaian pihak ketiga:

- Poliglot Pembantu: Qwen3-Coder-480B mencapai markah 61.8% , menggambarkan penjanaan kod berbilang bahasa yang kuat dan penaakulan.

- MBPP dan HumanEval: Ujian bebas melaporkan bahawa Qwen3-Coder-480B-A35B mengatasi GPT-4.1 pada kedua-dua ketepatan fungsian dan pengendalian segera yang kompleks, terutamanya dalam cabaran pengekodan berbilang langkah.

- Varian parameter 480B mencapai lebih 85% kejayaan pelaksanaan pada Bangku SWE Suite yang disahkan—melepasi kedua-dua model teratas DeepSeek (78%) dan Moonshot's K2 (82%), dan hampir sama dengan Claude Sonnet 4 pada 86%.

Perbandingan dengan Model Proprietari

Alibaba mendakwa bahawa keupayaan agen Qwen3‑Coder sejajar dengan Claude Anthropic dan GPT‑4 OpenAI dalam aliran kerja pengekodan hujung-ke-hujung, satu pencapaian yang luar biasa untuk model sumber terbuka. Penguji awal melaporkan bahawa perancangan berbilang pusingan, penggunaan alat dinamik dan pembetulan ralat automatik boleh mengendalikan tugas yang rumit—seperti membina aplikasi web tindanan penuh atau menyepadukan saluran paip CI/CD—dengan gesaan manusia yang minimum. Keupayaan ini disokong oleh kapasiti model untuk mengesahkan sendiri melalui pelaksanaan kod, ciri yang kurang jelas dalam LLM generatif semata-mata.

Apakah inovasi teknikal di sebalik Qwen3‑Coder?

Seni bina Campuran Pakar (KPM).

Di tengah-tengah Qwen3‑Coder terletak reka bentuk MoE yang canggih. Tidak seperti model padat yang mengaktifkan semua parameter untuk setiap token, seni bina MoE secara selektif melibatkan sub-rangkaian khusus (pakar) yang disesuaikan dengan jenis atau tugas token tertentu. Dalam Qwen3‑Coder, 480 bilion jumlah parameter diedarkan merentas berbilang pakar, dengan hanya 35 bilion parameter aktif bagi setiap token. Pendekatan ini mengurangkan kos inferens sebanyak lebih 60% berbanding model padat yang setara sambil mengekalkan kesetiaan tinggi dalam sintesis kod dan nyahpepijat .

Mod berfikir dan mod tidak berfikir

Meminjam daripada inovasi keluarga Qwen3 yang lebih luas, Qwen3‑Coder menyepadukan inferens dwi-mod rangka kerja:

- Mod Berfikir memperuntukkan "belanjawan pemikiran" yang lebih besar untuk tugas penaakulan berbilang langkah yang kompleks seperti reka bentuk algoritma atau pemfaktoran semula silang fail.

- Mod Tidak Berfikir menyediakan respons pantas, didorong konteks yang sesuai untuk pelengkapan kod mudah dan coretan penggunaan API.

Penukaran mod bersatu ini menghapuskan keperluan untuk mengimbangi model berasingan untuk tugasan yang dioptimumkan sembang berbanding dengan penaakulan, memperkemas aliran kerja pembangun .

Pembelajaran Pengukuhan dengan Sintesis Kes Ujian Automatik

Inovasi yang menonjol ialah tetingkap konteks token 3K asli Qwen256‑Coder—dua kali ganda kapasiti tipikal model terbuka terkemuka—dan menyokong sehingga satu juta token melalui kaedah ekstrapolasi (cth, YaRN). Ini membolehkan model memproses keseluruhan repositori, set dokumentasi atau projek berbilang fail dalam satu laluan, mengekalkan kebergantungan silang fail dan mengurangkan gesaan berulang. Ujian empirikal menunjukkan pengembangan tetingkap konteks menghasilkan keuntungan yang semakin berkurangan tetapi masih bermakna dalam prestasi tugas ufuk panjang, terutamanya dalam senario pembelajaran pengukuhan yang didorong oleh persekitaran.

Bagaimanakah pembangun boleh mengakses dan menggunakan Qwen3‑Coder?

Strategi keluaran untuk Qwen3-Coder menekankan keterbukaan dan kemudahan diterima pakai:

- Wajaran Model Sumber Terbuka: Semua pusat pemeriksaan model tersedia di GitHub di bawah Apache 2.0, membolehkan ketelusan penuh dan peningkatan didorong komuniti.

- Antara Muka Baris Perintah (Kod Qwen): Bercabang daripada Kod Google Gemini, CLI menyokong gesaan tersuai, panggilan fungsi dan seni bina pemalam untuk disepadukan dengan lancar dengan sistem binaan dan IDE sedia ada.

- Penggunaan Awan dan Di Prem: Imej Docker yang telah dikonfigurasikan dan carta Kubernetes Helm memudahkan penggunaan berskala dalam persekitaran awan, manakala resipi pengkuantitian tempatan (kuantisasi dinamik 2–8 bit) mendayakan inferens pada premis yang cekap, walaupun pada GPU komoditi.

- Akses API melalui CometAPI: Pembangun juga boleh berinteraksi dengan Qwen3-Coder melalui titik akhir yang dihoskan pada platform seperti CometAPI, yang menawarkan sumber terbuka(

qwen3-coder-480b-a35b-instruct) dan versi komersial(qwen3-coder-plus; qwen3-coder-plus-2025-07-22)pada harga yang sama.Versi komersial adalah 1M panjang. - Memeluk Muka:Alibaba telah menjadikan pemberat Qwen3‑Coder dan perpustakaan yang disertakan tersedia secara percuma pada kedua-dua Hugging Face dan GitHub, yang dibungkus di bawah lesen Apache 2.0 yang membenarkan penggunaan akademik dan komersial tanpa royalti.

Penyepaduan API dan SDK melalui CometAPI

CometAPI ialah platform API bersatu yang mengagregatkan lebih 500 model AI daripada pembekal terkemuka—seperti siri GPT OpenAI, Google Gemini, Anthropic's Claude, Midjourney, Suno dan banyak lagi—menjadi satu antara muka mesra pembangun. Dengan menawarkan pengesahan yang konsisten, pemformatan permintaan dan pengendalian respons, CometAPI secara dramatik memudahkan penyepaduan keupayaan AI ke dalam aplikasi anda. Sama ada anda sedang membina chatbots, penjana imej, komposer muzik atau saluran paip analitik terdorong data, CometAPI membolehkan anda mengulangi dengan lebih pantas, mengawal kos dan kekal sebagai vendor-agnostik—semuanya sambil memanfaatkan penemuan terkini merentas ekosistem AI.

Pembangun boleh berinteraksi dengan Qwen3-Pengekod melalui API gaya OpenAI yang serasi, tersedia melalui CometAPI . CometAPI, yang menawarkan sumber terbuka(qwen3-coder-480b-a35b-instruct) dan versi komersial(qwen3-coder-plus; qwen3-coder-plus-2025-07-22)pada harga yang sama.Versi komersial adalah 1M panjang. Contoh kod untuk Python (menggunakan klien yang serasi OpenAI) dengan amalan terbaik mengesyorkan tetapan pensampelan suhu = 0.7, top_p = 0.8, top_k = 20 dan repetition_penalty = 1.05. Panjang output boleh memanjangkan sehingga 65,536 token, menjadikannya sesuai untuk tugas penjanaan kod yang besar.

Untuk bermula, terokai keupayaan model dalam Taman Permainan dan berunding dengan Panduan API untuk arahan terperinci. Sebelum mengakses, sila pastikan anda telah log masuk ke CometAPI dan memperoleh kunci API.

Mulakan Pantas pada Wajah Memeluk dan Awan Alibaba

Pembangun tidak sabar-sabar untuk bereksperimen dengan Qwen3‑Coder boleh mencari model pada Wajah Memeluk di bawah repositori Qwen/Qwen3‑Coder‑480B‑A35B‑Arahan. Integrasi diperkemas melalui transformers perpustakaan (versi ≥ 4.51.0 untuk mengelakkan KeyError: 'qwen3_moe') dan klien Python serasi OpenAI. Contoh minimum:

from transformers import AutoModelForCausalLM, AutoTokenizer

model = AutoModelForCausalLM.from_pretrained("Qwen/Qwen3-480B-A35B-Instruct")

tokenizer = AutoTokenizer.from_pretrained("Qwen/Qwen3-480B-A35B-Instruct")

input_ids = tokenizer("def fibonacci(n):", return_tensors="pt").input_ids

output = model.generate(input_ids, max_length=200, temperature=0.7, top_p=0.8, top_k=20, repetition_penalty=1.05)

print(tokenizer.decode(output))

Menentukan alatan tersuai dan aliran kerja agen

Salah satu ciri menonjol Qwen3‑Coder ialah doa alat dinamik. Pembangun boleh mendaftar utiliti luaran—linter, pemformat, pelari ujian—dan membenarkan model memanggilnya secara autonomi semasa sesi pengekodan. Keupayaan ini mengubah Qwen3‑Coder daripada pembantu kod pasif kepada ejen pengekodan aktif, mampu menjalankan ujian, melaraskan gaya kod dan juga menggunakan perkhidmatan mikro berdasarkan niat perbualan.

Apakah aplikasi berpotensi dan arah masa hadapan yang didayakan oleh Qwen3‑Coder?

Dengan menggabungkan kebebasan sumber terbuka dengan prestasi gred perusahaan, Qwen3‑Coder membuka jalan bagi alat pembangunan dipacu AI generasi baharu. Daripada audit kod automatik dan semakan pematuhan keselamatan kepada perkhidmatan pemfaktoran semula berterusan dan pembantu pembangun yang dikuasakan AI, kepelbagaian model sudah memberi inspirasi kepada syarikat pemula dan pasukan inovasi dalaman.

Aliran Kerja Pembangunan Perisian

Pengguna awal melaporkan pengurangan 30–50 peratus dalam masa yang dibelanjakan untuk pengekodan boilerplate, pengurusan kebergantungan dan perancah awal, membolehkan jurutera menumpukan pada tugasan reka bentuk dan seni bina bernilai tinggi. Suite penyepaduan berterusan boleh memanfaatkan Qwen3‑Coder untuk menjana ujian secara automatik, mengesan regresi dan juga mencadangkan pengoptimuman prestasi berdasarkan analisis kod masa nyata.

Enterprises Play

Memandangkan syarikat merentasi kewangan, penjagaan kesihatan dan e-dagang mengintegrasikan Qwen3‑Coder ke dalam sistem kritikal misi, gelung maklum balas antara pasukan pengguna dan R&D Alibaba akan mempercepatkan penambahbaikan—seperti penalaan khusus domain, protokol keselamatan yang dipertingkatkan dan pemalam IDE yang lebih ketat. Selain itu, strategi sumber terbuka Alibaba menggalakkan sumbangan daripada komuniti global, memupuk ekosistem lanjutan, penanda aras dan perpustakaan amalan terbaik yang bertenaga.

Kesimpulan

Ringkasnya, Qwen3‑Coder mewakili mercu tanda dalam AI sumber terbuka untuk kejuruteraan perisian: model agen yang berkuasa yang bukan sahaja menulis kod, tetapi mengatur keseluruhan saluran pembangunan dengan pengawasan manusia yang minimum. Dengan menjadikan teknologi itu tersedia secara bebas dan mudah untuk disepadukan, Alibaba sedang mendemokrasikan akses kepada perkakas AI termaju dan menetapkan peringkat untuk era di mana penciptaan perisian menjadi semakin kolaboratif, cekap dan pintar.

Soalan Lazim

Apakah yang menjadikan Qwen3‑Coder “agentik”?

AI Agentik merujuk kepada model yang boleh merancang dan melaksanakan tugas berbilang langkah secara autonomi. Keupayaan Qwen3‑Coder untuk menggunakan alat luaran, menjalankan ujian dan mengurus pangkalan kod tanpa campur tangan manusia menunjukkan paradigma ini.

Adakah Qwen3‑Coder sesuai untuk kegunaan pengeluaran?

Walaupun Qwen3‑Coder menunjukkan prestasi kukuh pada penanda aras dan ujian dunia sebenar, perusahaan harus menjalankan penilaian khusus domain dan melaksanakan pagar (cth, saluran paip pengesahan output) sebelum menyepadukannya ke dalam aliran kerja pengeluaran kritikal.

Bagaimanakah seni bina Mixture-of-Experts memberi manfaat kepada pembangun?

MoE mengurangkan kos inferens dengan mengaktifkan sub-rangkaian yang berkaitan sahaja bagi setiap token, membolehkan penjanaan lebih pantas dan perbelanjaan pengiraan yang lebih rendah. Kecekapan ini adalah penting untuk menskalakan pembantu pengekodan AI dalam persekitaran awan.