Pada 19–20 November 2025 OpenAI mengeluarkan dua peningkatan yang berkaitan tetapi berbeza: GPT-5.1-Codex-Max, model pengekodan agenik baharu untuk Codex yang menekankan pengekodan ufuk panjang, kecekapan token dan "pemadatan" untuk mengekalkan sesi berbilang tetingkap; dan GPT-5.1 Pro, model Pro-tier ChatGPT dikemas kini yang ditala untuk jawapan yang lebih jelas dan berkebolehan dalam kerja profesional yang kompleks.

Apakah GPT-5.1-Codex-Max dan apakah masalah yang cuba diselesaikan?

GPT-5.1-Codex-Max ialah model Codex khusus daripada OpenAI yang ditala untuk aliran kerja pengekodan yang memerlukan penaakulan dan pelaksanaan jangka panjang yang berterusan. Apabila model biasa boleh tersandung oleh konteks yang sangat panjang — contohnya, refactor berbilang fail, gelung ejen yang kompleks atau tugas CI/CD yang berterusan — Codex-Max direka untuk padat dan uruskan keadaan sesi secara automatik merentas berbilang tetingkap konteks, membolehkannya terus berfungsi secara koheren kerana satu projek merangkumi beribu-ribu (atau lebih) token. OpenAI meletakkan Codex-Max sebagai langkah seterusnya dalam menjadikan ejen berkemampuan kod benar-benar berguna untuk kerja kejuruteraan lanjutan.

Apakah GPT-5.1-Codex-Max dan apakah masalah yang cuba diselesaikan?

GPT-5.1-Codex-Max ialah model Codex khusus daripada OpenAI yang ditala untuk aliran kerja pengekodan yang memerlukan penaakulan dan pelaksanaan jangka panjang yang berterusan. Apabila model biasa boleh tersandung oleh konteks yang sangat panjang — contohnya, refactor berbilang fail, gelung ejen yang kompleks atau tugas CI/CD yang berterusan — Codex-Max direka untuk padat dan uruskan keadaan sesi secara automatik merentas berbilang tetingkap konteks, membolehkannya terus berfungsi secara koheren kerana satu projek merangkumi beribu-ribu (atau lebih) token.

Ia diterangkan oleh OpenAI sebagai "lebih pantas, lebih pintar dan lebih cekap token pada setiap peringkat kitaran pembangunan," dan secara eksplisit bertujuan untuk menggantikan GPT-5.1-Codex sebagai model lalai dalam permukaan Codex.

petikan ciri

- Pemadatan untuk kesinambungan berbilang tetingkap: prun dan mengekalkan konteks kritikal untuk berfungsi secara koheren sepanjang berjuta-juta token dan jam. 0

- Kecekapan token yang dipertingkatkan berbanding dengan GPT-5.1-Codex: sehingga ~30% kurang token pemikiran untuk usaha penaakulan yang serupa pada beberapa penanda aras kod.

- Ketahanan agen ufuk panjang: diperhatikan secara dalaman untuk mengekalkan gelung ejen berbilang jam/berbilang hari (OpenAI didokumenkan > larian dalaman 24 jam).

- Penyepaduan platform: tersedia hari ini dalam Codex CLI, sambungan IDE, awan dan alat semakan kod; Akses API akan datang.

- Sokongan persekitaran Windows: OpenAI secara khusus menyatakan Windows disokong buat kali pertama dalam aliran kerja Codex, mengembangkan jangkauan pembangun dunia sebenar.

Bagaimanakah ia dibandingkan dengan produk pesaing (cth, GitHub Copilot, AI pengekodan lain)?

GPT-5.1-Codex-Max ditonjolkan sebagai kolaborator jangka panjang yang lebih autonomi berbanding dengan alatan penyiapan setiap permintaan. Walaupun Copilot dan pembantu serupa cemerlang dalam penyiapan jangka pendek dalam editor, kekuatan Codex-Max adalah dalam mengatur tugas berbilang langkah, mengekalkan keadaan koheren merentas sesi dan mengendalikan aliran kerja yang memerlukan perancangan, ujian dan lelaran. Walau bagaimanapun, pendekatan terbaik dalam kebanyakan pasukan adalah hibrid: gunakan Codex-Max untuk automasi yang kompleks dan tugas ejen yang berterusan dan gunakan pembantu yang lebih ringan untuk penyiapan peringkat talian.

Bagaimanakah GPT-5.1-Codex-Max berfungsi?

Apakah "pemadatan" dan bagaimana ia membolehkan kerja jangka panjang?

Kemajuan teknikal pusat ialah pemadatan—mekanisme dalaman yang memangkas sejarah sesi sambil mengekalkan bahagian penting konteks supaya model dapat meneruskan kerja yang koheren merentasi pelbagai tingkap konteks. Secara praktikalnya, ini bermakna sesi Codex yang menghampiri had konteksnya akan dipadatkan (token yang lebih lama atau nilai lebih rendah diringkaskan/dikekalkan) supaya ejen mempunyai tetingkap baharu dan boleh meneruskan berulang berulang kali sehingga tugasan selesai. OpenAI melaporkan larian dalaman di mana model menjalankan tugas secara berterusan selama lebih daripada 24 jam.

Penaakulan adaptif dan kecekapan token

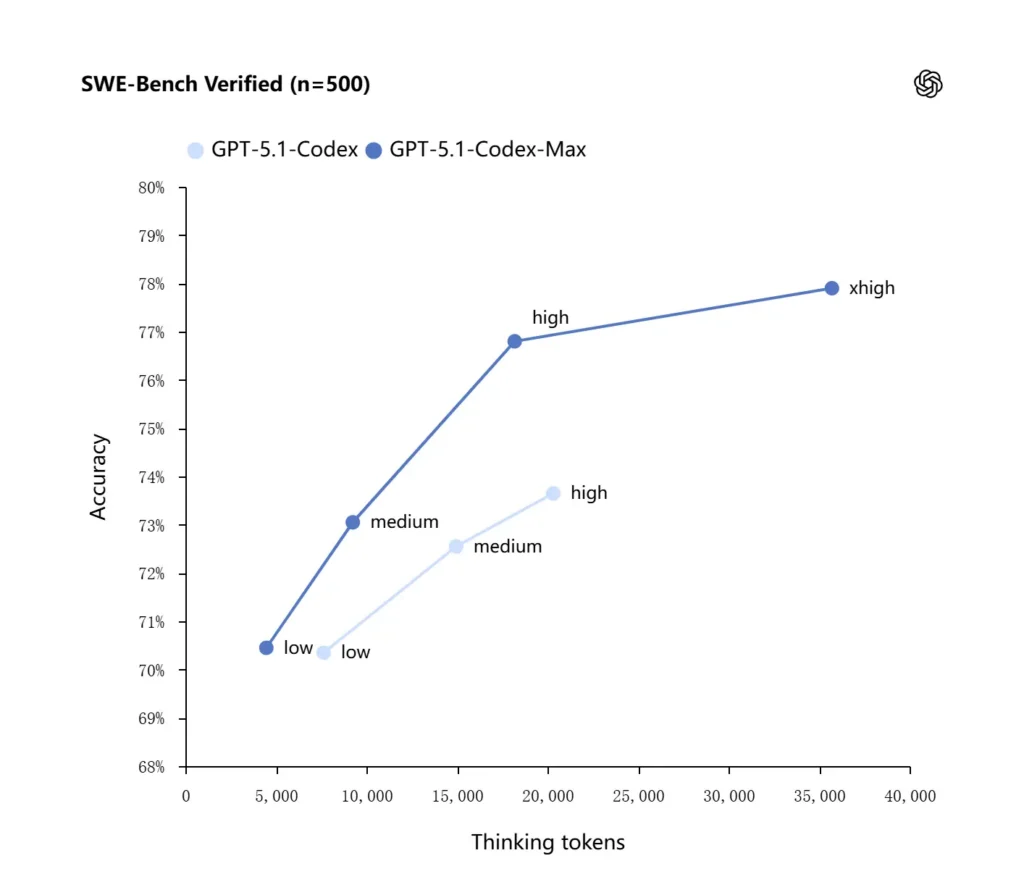

GPT-5.1-Codex-Max menggunakan strategi penaakulan yang dipertingkatkan yang menjadikannya lebih cekap token: dalam penanda aras dalaman OpenAI yang dilaporkan, model Max mencapai prestasi yang serupa atau lebih baik daripada GPT-5.1-Codex sambil menggunakan token "berfikir" yang jauh lebih sedikit—OpenAI memetik secara kasar 30% lebih sedikit token pemikiran pada SWE-bench Disahkan apabila berjalan pada usaha penaakulan yang sama. Model ini juga memperkenalkan mod usaha penaakulan "Extra High (xhigh)" untuk tugasan tidak sensitif kependaman yang membolehkannya membelanjakan lebih banyak penaakulan dalaman untuk mendapatkan output berkualiti tinggi.

Penyepaduan sistem dan perkakas agen

Codex-Max sedang diedarkan dalam aliran kerja Codex (CLI, sambungan IDE, awan dan permukaan semakan kod) supaya ia boleh berinteraksi dengan rantai alat pembangun sebenar. Penyepaduan awal termasuk ejen Codex CLI dan IDE (Kod VS, JetBrains, dll.), dengan akses API dirancang untuk diikuti. Matlamat reka bentuk bukan sahaja sintesis kod yang lebih pintar tetapi AI yang boleh menjalankan aliran kerja berbilang langkah: membuka fail, menjalankan ujian, membetulkan kegagalan, memfaktorkan semula dan menjalankan semula.

Bagaimanakah prestasi GPT-5.1-Codex-Max pada penanda aras dan kerja sebenar?

Penaakulan yang berterusan dan tugas jangka panjang

Penilaian menunjukkan penambahbaikan yang boleh diukur dalam penaakulan yang berterusan dan tugas jangka panjang:

- Penilaian dalaman OpenAI: Codex-Max boleh menjalankan tugas selama "lebih daripada 24 jam" dalam percubaan dalaman dan menyepadukan Codex dengan alatan pembangun meningkatkan metrik produktiviti kejuruteraan dalaman (cth, penggunaan dan daya pemprosesan permintaan). Ini adalah tuntutan dalaman OpenAI dan menunjukkan peningkatan tahap tugas dalam produktiviti dunia sebenar.

- Penilaian bebas (METR): Laporan bebas METR mengukur diperhatikan 50% ufuk masa (statistik yang mewakili masa median model boleh mengekalkan tugas yang panjang secara koheren) untuk GPT-5.1-Codex-Max pada kira-kira 2 jam 40 minit (dengan selang keyakinan yang luas), meningkat daripada 2 jam 17 minit GPT-5 dalam ukuran yang setanding — peningkatan dalam arah aliran yang bermakna dalam koheren yang berterusan. Metodologi METR dan CI menekankan kebolehubahan, tetapi hasilnya menyokong naratif bahawa Codex-Max meningkatkan prestasi praktikal jangka panjang.

Penanda Aras Kod

OpenAI melaporkan hasil yang lebih baik pada penilaian pengekodan sempadan, terutamanya SWE-bench Verified di mana GPT-5.1-Codex-Max mengatasi GPT-5.1-Codex dengan kecekapan token yang lebih baik. Syarikat itu menekankan bahawa untuk usaha penaakulan "sederhana" yang sama, model Max menghasilkan hasil yang lebih baik sambil menggunakan kira-kira 30% lebih sedikit token pemikiran; bagi pengguna yang membenarkan penaakulan dalaman yang lebih panjang, mod xhigh boleh meningkatkan lagi jawapan pada kos kependaman.

| GPT‑5.1-Codex (tinggi) | GPT‑5.1-Codex-Max (xtinggi) | |

| SWE-bench Disahkan (n=500) | 73.7% | 77.9% |

| SWE-Lancer IC SWE | 66.3% | 79.9% |

| Bangku Terminal 2.0 | 52.8% | 58.1% |

Bagaimanakah GPT-5.1-Codex-Max dibandingkan dengan GPT-5.1-Codex?

Perbezaan prestasi dan tujuan

- Skop: GPT-5.1-Codex ialah varian pengekodan berprestasi tinggi bagi keluarga GPT-5.1; Codex-Max secara eksplisit adalah pengganti agenik, jangka panjang yang dimaksudkan sebagai lalai yang disyorkan untuk persekitaran seperti Codex dan Codex.

- Kecekapan token: Codex-Max menunjukkan peningkatan kecekapan token bahan (Tuntutan token pemikiran OpenAI ~30% lebih sedikit) pada bangku SWE dan dalam penggunaan dalaman.

- Pengurusan konteks: Codex-Max memperkenalkan pemadatan dan pengendalian berbilang tetingkap asli untuk mengekalkan tugasan yang melebihi satu tetingkap konteks; Codex tidak menyediakan keupayaan ini secara asli pada skala yang sama.

- Kesediaan alatan: Codex-Max dihantar sebagai model Codex lalai merentasi permukaan semakan CLI, IDE dan kod, menandakan penghijrahan untuk aliran kerja pembangun pengeluaran.

Bila nak guna model yang mana?

- Gunakan GPT-5.1-Codex untuk bantuan pengekodan interaktif, pengeditan pantas, refactor kecil dan kes penggunaan kependaman rendah di mana keseluruhan konteks yang berkaitan mudah dimuatkan dalam satu tetingkap.

- Gunakan GPT-5.1-Codex-Max untuk refactor berbilang fail, tugas agenik automatik yang memerlukan banyak kitaran lelaran, aliran kerja seperti CI/CD atau apabila anda memerlukan model untuk memegang perspektif peringkat projek merentas banyak interaksi.

Corak segera yang praktikal dan contoh untuk hasil terbaik?

Corak dorongan yang berfungsi dengan baik

- Jelas tentang matlamat dan kekangan: "Refactor X, pelihara API awam, simpan nama fungsi dan pastikan ujian A,B,C lulus."

- Sediakan konteks minimum yang boleh diterbitkan semula: pautan kepada ujian yang gagal, sertakan surih tindanan dan coretan fail yang berkaitan daripada membuang keseluruhan repositori. Codex-Max akan memadatkan sejarah seperti yang diperlukan.

- Gunakan arahan langkah demi langkah untuk tugasan yang rumit: pecahkan kerja yang besar kepada urutan subtugas, dan biarkan Codex-Max melelang melaluinya (cth, "1) menjalankan ujian 2) membetulkan 3 ujian yang gagal teratas 3) menjalankan linter 4) meringkaskan perubahan").

- Minta penjelasan dan perbezaan: minta kedua-dua tampung dan rasional pendek supaya pengulas manusia boleh menilai keselamatan dan niat dengan cepat.

Contoh templat gesaan

Tugas refactor

“Refactor the

payment/modul untuk mengekstrak pemprosesan pembayaran ke dalampayment/processor.py. Pastikan tandatangan fungsi awam stabil untuk pemanggil sedia ada. Buat ujian unit untukprocess_payment()yang meliputi kejayaan, kegagalan rangkaian dan kad tidak sah. Jalankan suite ujian dan kembalikan ujian yang gagal dan tampalan dalam format perbezaan bersatu."

Pembetulan pepijat + ujian

“Ujian

tests/test_user_auth.py::test_token_refreshgagal dengan jejak balik . Siasat punca, cadangkan pembetulan dengan perubahan yang minimum dan tambahkan ujian unit untuk mengelakkan regresi. Gunakan ujian tampalan dan jalankan.”

Penjanaan PR berulang

“Laksanakan ciri X: tambah titik akhir

POST /api/exportyang menstrim hasil eksport dan disahkan. Buat titik akhir, tambah dokumen, buat ujian dan buka PR dengan ringkasan dan senarai semak item manual."

Untuk kebanyakan ini, mulakan dengan sederhana usaha; bertukar kepada xtinggi apabila anda memerlukan model untuk melakukan penaakulan mendalam merentas banyak fail dan berbilang lelaran ujian.

Bagaimanakah anda mengakses GPT-5.1-Codex-Max

Di mana ia tersedia hari ini

OpenAI telah menyepadukan GPT-5.1-Codex-Max ke dalam Alat Codex hari ini: Codex CLI, sambungan IDE, awan dan aliran semakan kod menggunakan Codex-Max secara lalai (anda boleh memilih Codex-Mini). Ketersediaan API perlu disediakan; GitHub Copilot mempunyai pratonton awam yang termasuk model siri GPT-5.1 dan Codex.

Pembangun boleh mengakses GPT-5.1-Codex-Max dan API GPT-5.1-Codex melalui CometAPI. Untuk memulakan, terokai keupayaan model bagiCometAPI dalam Taman Permainan dan rujuk panduan API untuk arahan terperinci. Sebelum mengakses, sila pastikan anda telah log masuk ke CometAPI dan memperoleh kunci API. cometAPI menawarkan harga yang jauh lebih rendah daripada harga rasmi untuk membantu anda menyepadukan.

Bersedia untuk Pergi?→ Daftar untuk CometAPI hari ini !

Jika anda ingin mengetahui lebih banyak petua, panduan dan berita tentang AI, ikuti kami VK, X and Perpecahan!

Permulaan pantas (praktikal langkah demi langkah)

- Pastikan anda mempunyai akses: sahkan pelan produk ChatGPT/Codex anda (Plus, Pro, Business, Edu, Enterprise) atau pelan API pembangun anda menyokong model keluarga GPT-5.1/Codex.

- Pasang sambungan Codex CLI atau IDE: jika anda ingin menjalankan tugas kod secara tempatan, pasangkan Codex CLI atau sambungan IDE Codex untuk VS Code / JetBrains / Xcode yang berkenaan. Perkakas akan lalai kepada GPT-5.1-Codex-Max dalam persediaan yang disokong.

- Pilih usaha penaakulan: bermula dengan sederhana usaha untuk kebanyakan tugas. Untuk penyahpepijatan mendalam, faktor semula yang kompleks atau apabila anda mahu model berfikir lebih keras dan anda tidak mengambil berat tentang kependaman respons, tukar kepada tinggi or xtinggi mod. Untuk pembaikan kecil yang cepat, rendah berpatutan.

- Sediakan konteks repositori: berikan model titik permulaan yang jelas — URL repo atau satu set fail dan arahan ringkas (cth, "memfaktorkan semula modul pembayaran untuk menggunakan I/O tak segerak dan menambah ujian unit, mengekalkan kontrak peringkat fungsi"). Codex-Max akan memampatkan sejarah apabila menghampiri had konteks dan meneruskan kerja.

- Ulang dengan ujian: selepas model menghasilkan tampalan, jalankan suite ujian dan suapan semula kegagalan sebagai sebahagian daripada sesi yang sedang berjalan. Pemadatan dan kesinambungan berbilang tetingkap membolehkan Codex-Max mengekalkan konteks ujian gagal yang penting dan berulang.

Kesimpulan:

GPT-5.1-Codex-Max mewakili satu langkah besar ke arah pembantu pengekodan agen yang boleh mengekalkan tugas kejuruteraan yang kompleks dan berjalan lama dengan kecekapan dan penaakulan yang lebih baik. Kemajuan teknikal (pemadatan, mod usaha penaakulan, latihan persekitaran Windows) menjadikannya sangat sesuai untuk organisasi kejuruteraan moden — dengan syarat pasukan menggandingkan model dengan kawalan operasi konservatif, dasar manusia-dalam-gelung yang jelas dan pemantauan yang mantap. Bagi pasukan yang mengguna pakainya dengan berhati-hati, Codex-Max berpotensi mengubah cara perisian direka, diuji dan diselenggara — menukar kerja rungutan kejuruteraan yang berulang kepada kerjasama bernilai lebih tinggi antara manusia dan model.